Проверка статистических гипотез

- Понятие о статистической гипотезе

- Уровень значимости при проверке гипотезы

- Критическая область

- Простая гипотеза и критерии согласия

- Критерий согласия (X^2) Пирсона

- Примеры

п.1. Понятие о статистической гипотезе

Статистическая гипотеза – это предположение о виде распределения и свойствах случайной величины в наблюдаемой выборке данных.

Прежде всего, мы формулируем «рабочую» гипотезу. Желательно это делать не на основе полученных данных, а исходя из природы и свойств исследуемого явления.

Затем формулируется нулевая гипотеза (H_0), отвергающая нашу рабочую гипотезу.

Наша рабочая гипотеза при этом называется альтернативной гипотезой (H_1).

Получаем, что (H_0=overline{H_1}), т.е. нулевая и альтернативная гипотеза вместе составляют полную группу несовместных событий.

Основной принцип проверки гипотезы – доказательство «от противного», т.е. опровергнуть гипотезу (H_0) и тем самым доказать гипотезу (H_1).

В результате проверки гипотезы возможны 4 исхода:

| Верная гипотеза | |||

| (H_0) | (H_1) | ||

| Принятая гипотеза | (H_0) | True Negative (H_0) принята верно |

False Negative (H_0) принята неверно Ошибка 2-го рода |

| (H_1) | False Positive (H_0) отвергнута неверно (H_1) принята неверно Ошибка 1-го рода |

True Positive (H_0) отвергнута верно (H_1) принята верно |

Ошибка 1-го рода – «ложная тревога».

Ошибка 2-го рода – «пропуск события».

Например:

К врачу обращается человек с некоторой жалобой.

Гипотеза (H_1) — человек болен, гипотеза (H_0) — человек здоров.

True Negative – здорового человека признают здоровым

True Positive – больного человека признают больным

False Positive – здорового человека признают больным – «ложная тревога»

False Negative – больного человека признают здоровым – «пропуск события»

Уровень значимости при проверке гипотезы

Статистический тест (статистический критерий) – это строгое математическое правило, по которому гипотеза принимается или отвергается.

В статистике разработано множество критериев: критерии согласия, критерии нормальности, критерии сдвига, критерии выбросов и т.д.

Уровень значимости – это пороговая (критическая) вероятность ошибки 1-го рода, т.е. непринятия гипотезы (H_0), когда она верна («ложная тревога»).

Требуемый уровень значимости α задает критическое значение для статистического теста.

Например:

Уровень значимости α=0,05 означает, что допускается не более чем 5%-ая вероятность ошибки.

В результате статистического теста на конкретных данных получают эмпирический уровень значимости p. Чем меньше значение p, тем сильнее аргументы против гипотезы (H_0).

Обобщив практический опыт, можно сформулировать следующие рекомендации для оценки p и выбора критического значения α:

| Уровень значимости (p) |

Решение о гипотезе (H_0) | Вывод для гипотезы (H_1) |

| (pgt 0,1) | (H_0) не может быть отклонена | Статистически достоверные доказательства не обнаружены |

| (0,5lt pleq 0,1) | Истинность (H_0) сомнительна, неопределенность | Доказательства обнаружены на уровне статистической тенденции |

| (0,01lt pleq 0,05) | Отклонение (H_0), значимость | Обнаружены статистически достоверные (значимые) доказательства |

| (pleq 0,01) | Отклонение (H_0), высокая значимость | Доказательства обнаружены на высоком уровне значимости |

Здесь под «доказательствами» мы понимаем результаты наблюдений, свидетельствующие в пользу гипотезы (H_1).

Традиционно уровень значимости α=0,05 выбирается для небольших выборок, в которых велика вероятность ошибки 2-го рода. Для выборок с (ngeq 100) критический уровень снижают до α=0,01.

п.3. Критическая область

Критическая область – область выборочного пространства, при попадании в которую нулевая гипотеза отклоняется.

Требуемый уровень значимости α, который задается исследователем, определяет границу попадания в критическую область при верной нулевой гипотезе.

Различают 3 вида критических областей

Критическая область на чертежах заштрихована.

(K_{кр}=chi_{f(alpha)}) определяют границы критической области в зависимости от α.

Если эмпирическое значение критерия попадает в критическую область, гипотезу (H_0) отклоняют.

Пусть (K*) — эмпирическое значение критерия. Тогда:

(|K|gt K_{кр}) – гипотеза (H_0) отклоняется

(|K|leq K_{кр}) – гипотеза (H_0) не отклоняется

п.4. Простая гипотеза и критерии согласия

Пусть (x=left{x_1,x_2,…,x_nright}) – случайная выборка n объектов из множества (X), соответствующая неизвестной функции распределения (F(t)).

Простая гипотеза состоит в предположении, что неизвестная функция (F(t)) является совершенно конкретным вероятностным распределением на множестве (X).

Например:

Глядя на полученные данные эксперимента (синие точки), можно выдвинуть следующую простую гипотезу:

(H_0): данные являются выборкой из равномерного распределения на отрезке [-1;1]

Критерий согласия проверяет, согласуется ли заданная выборка с заданным распределением или с другой выборкой.

К критериям согласия относятся:

- Критерий Колмогорова-Смирнова;

- Критерий (X^2) Пирсона;

- Критерий (omega^2) Смирнова-Крамера-фон Мизеса

п.5. Критерий согласия (X^2) Пирсона

Пусть (left{t_1,t_2,…,t_nright}) — независимые случайные величины, подчиняющиеся стандартному нормальному распределению N(0;1) (см. §63 данного справочника)

Тогда сумма квадратов этих величин: $$ x=t_1^2+t_2^2+⋯+t_n^2 $$ является случайной величиной, которая имеет распределение (X^2) с n степенями свободы.

График плотности распределения (X^2) при разных n имеет вид:

С увеличением n распределение (X^2) стремится к нормальному (согласно центральной предельной теореме – см. §64 данного справочника).

Если мы:

1) выдвигаем простую гипотезу (H_0) о том, что полученные данные являются выборкой из некоторого закона распределения (f(x));

2) выбираем в качестве теста проверки гипотезы (H_0) критерий Пирсона, —

тогда определение критической области будет основано на распределении (X^2).

Заметим, что выдвижение основной гипотезы в качестве (H_0) при проведении этого теста исторически сложилось.

В этом случае критическая область правосторонняя.

Мы задаем уровень значимости α и находим критическое значение

(X_{кр}^2=X^2(alpha,k-r-1)), где k — число вариант в исследуемом ряду, r – число параметров предполагаемого распределения.

Для этого есть специальные таблицы.

Или используем функцию ХИ2ОБР(α,k-r-1) в MS Excel (она сразу считает нужный нам правый хвост). Например, при r=0 (для равномерного распределения):

Пусть нам дан вариационный ряд с экспериментальными частотами (f_i, i=overline{1,k}).

Пусть наша гипотеза (H_0) –данные являются выборкой из закона распределения с известной плотностью распределения (p(x)).

Тогда соответствующие «теоретические частоты» (m_i=Ap(x_i)), где (x_i) – значения вариант данного ряда, A – коэффициент, который в общем случае зависит от ряда (дискретный или непрерывный).

Находим значение статистического теста: $$ X_e^2=sum_{j=1}^kfrac{(f_i-m_i)^2}{m_i} $$ Если эмпирическое значение (X_e^2) окажется в критической области, гипотеза (H_0) отвергается.

(X_e^2geq X_{кр}^2) — закон распределения не подходит (гипотеза (H_0) не принимается)

(X_e^2lt X_{кр}^2) — закон распределения подходит (гипотеза (H_0) принимается)

Например:

В эксперименте 60 раз подбрасывают игральный кубик и получают следующие результаты:

| Очки, (x_i) | 1 | 2 | 3 | 4 | 5 | 6 |

| Частота, (f_i) | 8 | 12 | 13 | 7 | 12 | 8 |

Не является ли кубик фальшивым?

Если кубик не фальшивый, то справедлива гипотеза (H_0) — частота выпадений очков подчиняется равномерному распределению: $$ p_i=frac16, i=overline{1,6} $$ При N=60 экспериментах каждая сторона теоретически должна выпасть: $$ m_i=p_icdot N=frac16cdot 60=10 $$ по 10 раз.

Строим расчетную таблицу:

| (x_i) | 1 | 2 | 3 | 4 | 5 | 6 | ∑ |

| (f_i) | 8 | 12 | 13 | 7 | 12 | 8 | 60 |

| (m_i) | 10 | 10 | 10 | 10 | 10 | 10 | 60 |

| (f_i-m_i) | -2 | 2 | 3 | -3 | 2 | -2 | — |

| (frac{(f_i-m_i)^2}{m_i}) | 0,4 | 0,4 | 0,9 | 0,9 | 0,4 | 0,4 | 3,4 |

Значение теста: $$ X_e^2=3,4 $$ Для уровня значимости α=0,05, k=6 и r=0 находим критическое значение:

Значит, с вероятностью 95% кубик не фальшивый.

п.6. Примеры

Пример 1. В эксперименте 72 раза подбрасывают игральный кубик и получают следующие результаты:

| Очки, (x_i) | 1 | 2 | 3 | 4 | 5 | 6 |

| Частота, (f_i) | 8 | 12 | 13 | 7 | 10 | 22 |

Не является ли кубик фальшивым?

Если кубик не фальшивый, то справедлива гипотеза (H_0) — частота выпадений очков подчиняется равномерному распределению: $$ p_i=frac16, i=overline{1,6} $$ При N=72 экспериментах каждая сторона теоретически должна выпасть: $$ m_i=p_icdot N=frac16cdot 72=12 $$ по 12 раз.

Строим расчетную таблицу:

| (x_i) | 1 | 2 | 3 | 4 | 5 | 6 | ∑ |

| (f_i) | 8 | 12 | 13 | 7 | 10 | 22 | 72 |

| (m_i) | 12 | 12 | 12 | 12 | 12 | 12 | 72 |

| (f_i-m_i) | -4 | 0 | 1 | -5 | -2 | 10 | — |

| (frac{(f_i-m_i)^2}{m_i}) | 1,333 | 0,000 | 0,083 | 2,083 | 0,333 | 8,333 | 12,167 |

Значение теста: $$ X_e^2=12,167 $$ Для уровня значимости α=0,05, k=6 и r=0 находим критическое значение:

Значит, с вероятностью 95% кубик фальшивый.

Пример 2. Во время Второй мировой войны Лондон подвергался частым бомбардировкам. Чтобы улучшить организацию обороны, город разделили на 576 прямоугольных участков, 24 ряда по 24 прямоугольника.

В течение некоторого времени были получены следующие данные по количеству попаданий на участки:

| Число попаданий, (x_i) | 0 | 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| Количество участков, (f_i) | 229 | 211 | 93 | 35 | 7 | 0 | 0 | 1 |

Проверялась гипотеза (H_0) — стрельба случайна.

Если стрельба случайна, то попадание на участок должно иметь распределение, подчиняющееся «закону редких событий» — закону Пуассона с плотностью вероятности: $$ p(k)=frac{lambda^k}{k!}e^{-lambda} $$ где (k) — число попаданий. Чтобы получить значение (lambda), нужно посчитать математическое ожидание данного распределения.

Составим расчетную таблицу:

| (x_i) | 0 | 1 | 2 | 3 | 4 | 5 | 6 | 7 | ∑ |

| (f_i) | 229 | 211 | 93 | 35 | 7 | 0 | 0 | 1 | 576 |

| (x_if_i) | 0 | 211 | 186 | 105 | 28 | 0 | 0 | 7 | 537 |

$$ lambdaapprox M(x)=frac{sum x_if_i}{N}=frac{537}{576}approx 0,932 $$ Тогда теоретические частоты будут равны: $$ m_i=Ncdot p(k) $$ Получаем:

| (x_i) | 0 | 1 | 2 | 3 | 4 | 5 | 6 | 7 | ∑ |

| (f_i) | 229 | 211 | 93 | 35 | 7 | 0 | 0 | 1 | 576 |

| (p_i) | 0,39365 | 0,36700 | 0,17107 | 0,05316 | 0,01239 | 0,00231 | 0,00036 | 0,00005 | 0,99999 |

| (m_i) | 226,7 | 211,4 | 98,5 | 30,6 | 7,1 | 1,3 | 0,2 | 0,0 | 576,0 |

| (f_i-m_i) | 2,3 | -0,4 | -5,5 | 4,4 | -0,1 | -1,3 | -0,2 | 1,0 | — |

| (frac{(f_i-m_i)^2}{m_i}) (результат) | 0,02 | 0,00 | 0,31 | 0,63 | 0,00 | 1,33 | 0,21 | 34,34 | 36,84 |

Значение теста: (X_e^2=36,84)

Поскольку в ходе исследования мы нашли оценку для λ через подсчет выборочной средней, нужно уменьшить число степеней свободы на r=1, и критическое значение статистики искать для (X_{кр}^2=X^2(alpha,k-2)).

Для уровня значимости α=0,05 и k=8, r=1 находим:

(X_{кр}^2approx 12,59)

Получается, что: (X_e^2gt X_{кр}^2)

Гипотеза (H_0) не принимается.

Стрельба не случайна.

Пример 3. В предыдущем примере объединили события x={4;5;6;7} с редким числом попаданий:

| Число попаданий, (x_i) | 0 | 1 | 2 | 3 | 4-7 |

| Количество участков, (f_i) | 229 | 211 | 93 | 35 | 8 |

Проверялась гипотеза (H_0) — стрельба случайна.

Для последней объединенной варианты находим среднюю взвешенную: $$ x_5=frac{4cdot 7+5cdot 0+6cdot 0+7cdot 1}{7+1}=4,375 $$ Найдем оценку λ.

| (x_i) | 0 | 1 | 2 | 3 | 4,375 | ∑ |

| (f_i) | 229 | 211 | 93 | 35 | 8 | 576 |

| (x_if_i) | 0 | 211 | 186 | 105 | 35 | 537 |

$$ lambdaapprox M(x)=frac{sum x_if_i}{N}=frac{537}{576}approx 0,932 $$ Оценка не изменилась, что указывает на правильное определение средней для (x_5).

Строим расчетную таблицу для подсчета статистики:

| (x_i) | 0 | 1 | 2 | 3 | 4,375 | ∑ |

| (f_i) | 229 | 211 | 93 | 35 | 8 | 576 |

| (p_i) | 0,3937 | 0,3670 | 0,1711 | 0,0532 | 0,0121 | 0,9970 |

| (m_i) | 226,7 | 211,4 | 98,5 | 30,6 | 7,0 | 574,2 |

| (f_i-m_i) | 2,3 | -0,4 | -5,5 | 4,4 | 1,0 | — |

| (frac{(f_i-m_i)^2}{m_i}) | 0,02 | 0,00 | 0,31 | 0,63 | 0,16 | 1,12 |

Значение теста: (X_e^2=1,12)

Критическое значение статистики ищем в виде (X_{кр}^2=X^2(alpha,k-2)), где α=0,05 и k=5, r=1

(X_{кр}^2approx 7,81)

Получается, что: (X_e^2lt X_{кр}^2)

Гипотеза (H_0) принимается.

Стрельба случайна.

И какой же ответ верный? Полученный в Примере 2 или в Примере 3?

Если посмотреть в расчетную таблицу для статистики (X_e^2) в Примере 2, основной вклад внесло слагаемое для (x_i=7). Оно равно 34,34 и поэтому сумма (X_e^2=36,84) в итоге велика. А в расчетной таблице Примера 3 такого выброса нет. Для объединенной варианты (x_i=4,375) слагаемое статистики равно 0,16 и сумма (X_e^2=1,12) в итоге мала.

Правильный ответ – в Примере 3.

Стрельба случайна.

-

Простые и сложные гипотезы. Статистический критерий различения гипотез. Уровень значимости и мощность критерия. Ошибки первого и второго рода.

Статистической

гипотезой называют гипотезу о виде

неизвестного распределения генеральной

совокупности или о параметрах известных

распределений. Нулевой (основной) называют

выдвинутую гипотезу Н0. Конкурирую-щей

(альтернативной) называют

гипотезу Н1, которая противоречит

нулевой. Простой называют гипотезу,

содержащую только одно предположение,сложной –

гипотезу, состоящую из конечного или

бесконечного числа простых гипотез.

В

результате проверки правильности

выдвинутой нулевой гипотезы ( такая

проверка называется статистической,

так как производится с применением

методов математичес-кой статистики)

возможны ошибки двух видов: ошибка

первого рода,

состоящая в том, что будет отвергнута

правильная нулевая гипотеза, и ошибка

второго рода,

заключаю-щаяся в том, что будет принята

неверная гипотеза.

Замечание. Какая

из ошибок является на практике более

опасной, зависит от конкретной задачи.

Например, если проверяется правильность

выбора метода лечения больного, то

ошибка первого рода означает отказ от

правильной методики, что может замедлить

лече-ние, а ошибка второго рода (применение

неправильной методики) чревата ухудшением

состояния больного и является более

опасной.

Вероятность

ошибки первого рода называется уровнем

значимости α.

Основной

прием проверки статистических гипотез

заключается в том, что по имеющейся

выборке вычисляется значение некоторой

случайной величины, имеющей известный

закон распределения.

Статистическим

критерием называется

случайная величина К с

известным законом распределения,

служащая для проверки нулевой гипотезы.

Мощностью

критерия называют

вероятность попадания критерия в

критическую область при условии, что

верна конкурирующая гипотеза.

Если

обозначить вероятность ошибки второго

рода (принятия неправильной нулевой

гипотезы) β, то мощность критерия равна

1 – β. Следовательно, чем больше мощность

критерия, тем меньше вероятность

совершить ошибку второго рода. Поэтому

после выбора уровня значимости следует

строить критическую область так, чтобы

мощность критерия была максимальной.

-

Числовые характеристики случайных процессов (определение, свойства). Корреляционная теория случайных процессов.

Каждая

случайная величина полностью определяется

своей функцией распределения.

В

то же время при решении практических

задач достаточно знать несколько

числовых параметров, которые позволяют

представить основные особенности

случайной величины в сжатой форме. К

таким величинам относятся в первую

очередь математическое ожидание и

дисперсия.

-

Характеристики

положения

-

Математическое

ожидание случайной величины

Математическое

ожидание — число,

вокруг которого сосредоточены значения

случайной величины. Математическое

ожидание случайной величины обозначается M .

Математическое

ожидание дискретной случайной

величины ,

имеющей распределение

|

x1 |

x2 |

… |

xn |

|

p1 |

p2 |

… |

pn |

называется

величина

,

если число значений случайной величины

конечно.

Если

число значений случайной величины

счетно, то

.

При этом, если ряд в правой части

равенства расходится, то говорят, что

случайная величина не имеет

математического ожидания.

Математическое

ожидание непрерывной случайной

величины с

плотностью вероятностей p(x)

вычисляется по формуле

.

При этом, если интеграл в правой части

равенства расходится, то говорят, что

случайная величина не имеет

математического ожидания.

Если

случайная величина является

функцией случайной величины , =

f(x),

то

.

Аналогичные

формулы справедливы для функций

дискретной случайной величины:

,

.

Основные

свойства математического ожидания:

-математическое

ожидание константы равно этой

константе, Mc=c ;

-математическое

ожидание — линейный функционал на

пространстве случайных величин, т.е.

для любых двух случайных величин , и

произвольных постоянных a и bсправедливо: M(a + b )

= a M( )+ b M( );

-математическое

ожидание произведения двух независимых случайных

величин равно произведению их

математических ожиданий, т.е. M( )

= M( )M( ).

Если

математическое ожидание случайной

величины не существует, то в качестве

характеристики положения случайной

величины применяют моду или медиану.

-

Мода

Модой

случайной величины X

называется такое значение x, при котором

плотность распределения вероятностей

случайной величины f(x)

принимает максимальное значение.

Из определения следует, что мода

определяется только для непрерывных

случайных величин. Аналогом моды для

дискретной случайной величины является

её наивероятнейшее значение. Мода

обозначается через Modx.

-

Медиана

Медианой

случайной величины X

называется такое значение x, которое

разбивает всю область возможных значений

случайной величины на две равновероятные

части, т. е. P|X < x} = P|X > x} = 0,5. Из

определения следует, что медиана, как

и мода, точно может быть определена

только для непрерывных случайных

величин. Медиана обычно обозначается

через Mеdx.

-

Характеристики

разброса

-

Дисперсия

случайной величины

Дисперсия

случайной величины характеризует меру

разброса случайной величины около ее

математического ожидания.

Если

случайная величина имеет

математическое ожидание M ,

то дисперсией случайной

величины называется

величина D = M( — M )2.

Легко

показать, что D = M( — M )2= M 2 — M( )2.

Эта

универсальная формула одинаково хорошо

применима как для дискретных случайных

величин, так и для непрерывных.

Величина M 2 >для

дискретных и непрерывных случайных

величин соответственно вычисляется

по формулам

,

.

-

Для

определения меры разброса значений

случайной величины часто используется

среднеквадратичное

отклонение

, связанное

с дисперсией соотношением

.

Основные

свойства дисперсии:

-дисперсия

любой случайной величины

неотрицательна, D

0;

-дисперсия

константы равна нулю, Dc=0;

-для

произвольной константы D(c )

= c2D( );

-дисперсия

суммы двух независимых случайных

величин равна

сумме их дисперсий: D( )

= D( )

+ D ( ).

-

Моменты

распределения

В

теории вероятностей и математической

статистике, помимо математического

ожидания и дисперсии, используются и

другие числовые характеристики случайных

величин. В первую очередь

это начальные и центральные моменты.

Начальным

моментом k-го порядка случайной

величины называется математическое

ожидание k-й

степени случайной величины ,

т.е. k = M k.

Центральным

моментом k-го порядка случайной

величины называется величина k,

определяемая формулой k = M( — M )k.

Заметим,

что математическое ожидание случайной

величины — начальный момент первого

порядка, 1 = M ,

а дисперсия — центральный момент второго

порядка,

2 = M 2 = M( — M )2 = D .

Существуют

формулы, позволяющие выразить центральные

моменты случайной величины через ее

начальные моменты, например:

2= 2- 12, 3 = 3 — 3 2 1 + 2 13.

Если

плотность распределения вероятностей

непрерывной случайной величины

симметрична относительно прямой x

= M ,

то все ее центральные моменты нечетного

порядка равны нулю.

-

Асимметрия

В

теории вероятностей и в математической

статистике в качестве меры асимметрии

распределения является коэффициент

асимметрии, который определяется

формулой

,

где 3 —

центральный момент третьего порядка,

—

среднеквадратичное отклонение.

-

Эксцесс

Нормальное

распределение наиболее часто используется

в теории вероятностей и в математической

статистике, поэтому график плотности

вероятностей нормального распределения

стал своего рода эталоном, с которым

сравнивают другие распределения. Одним

из параметров, определяющих отличие

распределения случайной величины ,

от нормального распределения, является

эксцесс.

Эксцесс случайной

величины определяется

равенством

.

У

нормального распределения,

естественно, = 0.

Если ( ) > 0, то это означает,

что график плотности вероятностей p (x)

сильнее “заострен”, чем у нормального

распределения, если же ( ) <

0, то “заостренность” графика p (x)

меньше, чем у нормального распределения.

КОРРЕЛЯЦИОННАЯ

ТЕОРИЯ

Корреляционная

теория случайных функций — описание

случайных ф-ций

при

помощи статистич. моментов 1-го и 2-го

порядка:

.

Аргумент случайной ф-ции x может

иметь любую размерность. Если

—

гауссова случайная ф-ция, полностью

определяемая первым и вторым моментами,

то К. т. даёт её полное описание. Обычно

К. т. применяют для таких физ. задач,

к-рые описываются линейными ур-ниями

вида

= F(x), где

—

нек-рый линейный оператор, F

(х) — случайная

ф-ция. В этом случае можно получить

ур-ния и для статистич. моментов

,

.

Для нелинейных

задач

К. т. обычно имеет приближённый характер.

К. т. наиб. приспособлена для описания

однородных (стационарных) случайных

ф-ций, для к-рых справедлива Винера-Хинчина

теорема. К.

т. используют в большинстве физ.

приложений случайных ф-ций, напр. в

теории флуктуации и

теории когерентности.

Дисциплина:

ТВ и МС Билет № 6

Соседние файлы в предмете [НЕСОРТИРОВАННОЕ]

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

27.05.201527.69 Mб12Э. Стиллмен, Дж. Грин — Изучаем C#.pdf

Ошибки первого и второго рода

Выдвинутая гипотеза

может быть правильной или неправильной,

поэтому возникает необходимость её

проверки. Поскольку проверку производят

статистическими методами, её называют

статистической. В итоге статистической

проверки гипотезы в двух случаях может

быть принято неправильное решение, т.

е. могут быть допущены ошибки двух родов.

Ошибка первого

рода состоит в том, что будет отвергнута

правильная гипотеза.

Ошибка второго

рода состоит в том, что будет принята

неправильная гипотеза.

Подчеркнём, что

последствия этих ошибок могут оказаться

весьма различными. Например, если

отвергнуто правильное решение «продолжать

строительство жилого дома», то эта

ошибка первого рода повлечёт материальный

ущерб: если же принято неправильное

решение «продолжать строительство»,

несмотря на опасность обвала стройки,

то эта ошибка второго рода может повлечь

гибель людей. Можно привести примеры,

когда ошибка первого рода влечёт более

тяжёлые последствия, чем ошибка второго

рода.

Замечание 1.

Правильное решение может быть принято

также в двух случаях:

-

гипотеза принимается,

причём и в действительности она

правильная; -

гипотеза отвергается,

причём и в действительности она неверна.

Замечание 2.

Вероятность совершить ошибку первого

рода принято обозначать через

;

её называют уровнем значимости. Наиболее

часто уровень значимости принимают

равным 0,05 или 0,01. Если, например, принят

уровень значимости, равный 0,05, то это

означает, что в пяти случаях из ста

имеется риск допустить ошибку первого

рода (отвергнуть правильную гипотезу).

Статистический

критерий проверки нулевой гипотезы.

Наблюдаемое значение критерия

Для проверки

нулевой гипотезы используют специально

подобранную случайную величину, точное

или приближённое распределение которой

известно. Обозначим эту величину в целях

общности через

.

Статистическим

критерием

(или просто критерием) называют случайную

величину

,

которая служит для проверки нулевой

гипотезы.

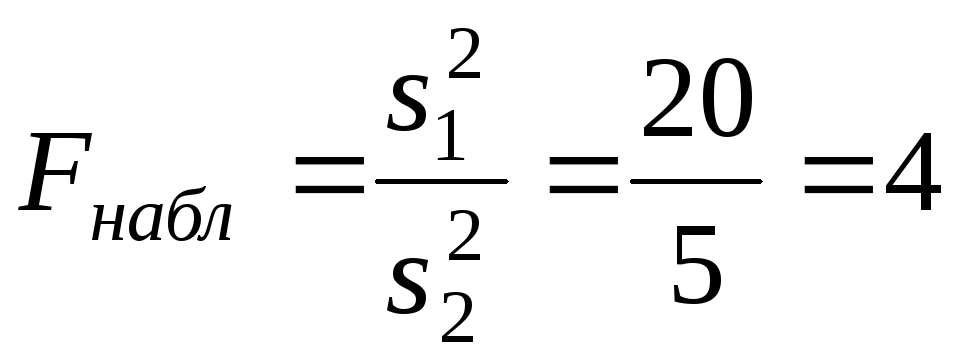

Например, если

проверяют гипотезу о равенстве дисперсий

двух нормальных генеральных совокупностей,

то в качестве критерия

принимают отношение исправленных

выборочных дисперсий:

Эта величина

случайная, потому что в различных опытах

дисперсии принимают различные, наперёд

неизвестные значения, и распределена

по закону Фишера – Снедекора.

Для проверки

гипотезы по данным выборок вычисляют

частные значения входящих в критерий

величин и таким образом получают частное

(наблюдаемое) значение критерия.

Наблюдаемым

значением

называют значение критерия, вычисленное

по выборкам. Например, если по двум

выборкам найдены исправленные выборочные

дисперсиии

,

то наблюдаемое значение критерия

Критическая

область. Область принятия гипотезы.

Критические точки

После выбора

определённого критерия множество всех

его возможных значений разбивают на

два непересекающихся подмножества:

одно из них содержит значения критерия,

при которых нулевая гипотеза отвергается,

а другая – при которых она принимается.

Критической

областью называют совокупность значений

критерия, при которых нулевую гипотезу

отвергают.

Областью принятия

гипотезы (областью допустимых значений)

называют совокупность значений критерия,

при которых гипотезу принимают.

Основной принцип

проверки статистических гипотез можно

сформулировать так: если наблюдаемое

значение критерия принадлежит критической

области – гипотезу отвергают, если

наблюдаемое значение критерия принадлежит

области принятия гипотезы – гипотезу

принимают.

Поскольку критерий

— одномерная случайная величина, все её

возможные значения принадлежат некоторому

интервалу. Поэтому критическая область

и область принятия гипотезы также

являются интервалами и, следовательно,

существуют точки, которые их разделяют.

Критическими

точками (границами)

называют точки, отделяющие критическую

область от области принятия гипотезы.

Различают

одностороннюю (правостороннюю или

левостороннюю) и двустороннюю критические

области.

Правосторонней

называют критическую область, определяемую

неравенством

>

,

где— положительное число.

Левосторонней

называют критическую область, определяемую

неравенством

<

,

где— отрицательное число.

Односторонней

называют правостороннюю или левостороннюю

критическую область.

Двусторонней

называют критическую область, определяемую

неравенствами

где

.

В частности, если

критические точки симметричны относительно

нуля, двусторонняя критическая область

определяется неравенствами ( в

предположении, что

>0):

,

или равносильным неравенством

.

Отыскание

правосторонней критической области

Как найти критическую

область? Обоснованный ответ на этот

вопрос требует привлечения довольно

сложной теории. Ограничимся её элементами.

Для определённости начнём с нахождения

правосторонней критической области,

которая определяется неравенством

>

,

где>0.

Видим, что для отыскания правосторонней

критической области достаточно найти

критическую точку. Следовательно,

возникает новый вопрос: как её найти?

Для её нахождения

задаются достаточной малой вероятностью

– уровнем значимости

.

Затем ищут критическую точку,

исходя из требования, чтобы при условии

справедливости нулевой гипотезы

вероятность того, критерийпримет значение, большее

,

была равна принятому уровню значимости:

Р(>

)=

.

Для каждого критерия

имеются соответствующие таблицы, по

которым и находят критическую точку,

удовлетворяющую этому требованию.

Замечание 1.

Когда

критическая точка уже найдена, вычисляют

по данным выборок наблюдаемое значение

критерия и, если окажется, что

>

,

то нулевую гипотезу отвергают; если же<

,

то нет оснований, чтобы отвергнуть

нулевую гипотезу.

Пояснение. Почему

правосторонняя критическая область

была определена, исходя из требования,

чтобы при справедливости нулевой

гипотезы выполнялось соотношение

Р(>

)=

?

(*)

Поскольку вероятность

события

>

мала (

— малая вероятность), такое событие при

справедливости нулевой гипотезы, в силу

принципа практической невозможности

маловероятных событий, в единичном

испытании не должно наступить. Если всё

же оно произошло, т.е. наблюдаемое

значение критерия оказалось больше,

то это можно объяснить тем, что нулевая

гипотеза ложна и, следовательно, должна

быть отвергнута. Таким образом, требование

(*) определяет такие значения критерия,

при которых нулевая гипотеза отвергается,

а они и составляют правостороннюю

критическую область.

Замечание 2.

Наблюдаемое значение критерия может

оказаться большим

не потому, что нулевая гипотеза ложна,

а по другим причинам (малый объём выборки,

недостатки методики эксперимента и

др.). В этом случае, отвергнув правильную

нулевую гипотезу, совершают ошибку

первого рода. Вероятность этой ошибки

равна уровню значимости.

Итак, пользуясь требованием (*), мы с

вероятностьюрискуем совершить ошибку первого рода.

Замечание 3. Пусть

нулевая гипотеза принята; ошибочно

думать, что тем самым она доказана.

Действительно, известно, что один пример,

подтверждающий справедливость некоторого

общего утверждения, ещё не доказывает

его. Поэтому более правильно говорить,

«данные наблюдений согласуются с нулевой

гипотезой и, следовательно, не дают

оснований её отвергнуть».

На практике для

большей уверенности принятия гипотезы

её проверяют другими способами или

повторяют эксперимент, увеличив объём

выборки.

Отвергают гипотезу

более категорично, чем принимают.

Действительно, известно, что достаточно

привести один пример, противоречащий

некоторому общему утверждению, чтобы

это утверждение отвергнуть. Если

оказалось, что наблюдаемое значение

критерия принадлежит критической

области, то этот факт и служит примером,

противоречащим нулевой гипотезе, что

позволяет её отклонить.

Отыскание

левосторонней и двусторонней критических

областей***

Отыскание

левосторонней и двусторонней критических

областей сводится (так же, как и для

правосторонней) к нахождению соответствующих

критических точек. Левосторонняя

критическая область определяется

неравенством

<

(

<0).

Критическую точку находят, исходя из

требования, чтобы при справедливости

нулевой гипотезы вероятность того, что

критерий примет значение, меньшее,

была равна принятому уровню значимости:

Р(<

)=

.

Двусторонняя

критическая область определяется

неравенствами

Критические

точки находят, исходя из требования,

чтобы при справедливости нулевой

гипотезы сумма вероятностей того, что

критерий примет значение, меньшееили большее

,

была равна принятому уровню значимости:

.

(*)

Ясно, что критические

точки могут быть выбраны бесчисленным

множеством способов. Если же распределение

критерия симметрично относительно нуля

и имеются основания (например, для

увеличения мощности) выбрать симметричные

относительно нуля точки (-

)и

(

>0),

то

Учитывая (*), получим

.

Это соотношение

и служит для отыскания критических

точек двусторонней критической области.

Критические точки находят по соответствующим

таблицам.

Дополнительные

сведения о выборе критической области.

Мощность критерия

Мы строили

критическую область, исходя из требования,

чтобы вероятность попадания в неё

критерия была равна

при условии, что нулевая гипотеза

справедлива. Оказывается целесообразным

ввести в рассмотрение вероятность

попадания критерия в критическую область

при условии, что нулевая гипотеза неверна

и, следовательно, справедлива конкурирующая.

Мощностью критерия

называют вероятность попадания критерия

в критическую область при условии, что

справедлива конкурирующая гипотеза.

Другими словами, мощность критерия есть

вероятность того, что нулевая гипотеза

будет отвергнута, если верна конкурирующая

гипотеза.

Пусть для проверки

гипотезы принят определённый уровень

значимости и выборка имеет фиксированный

объём. Остаётся произвол в выборе

критической области. Покажем, что её

целесообразно построить так, чтобы

мощность критерия была максимальной.

Предварительно убедимся, что если

вероятность ошибки второго рода (принять

неправильную гипотезу) равна

,

то мощность равна 1-.

Действительно, если— вероятность ошибки второго рода, т.е.

события «принята нулевая гипотеза,

причём справедливо конкурирующая», то

мощность критерия равна 1 —.

Пусть мощность 1

—

возрастает; следовательно, уменьшается

вероятностьсовершить ошибку второго рода. Таким

образом, чем мощность больше, тем

вероятность ошибки второго рода меньше.

Итак, если уровень

значимости уже выбран, то критическую

область следует строить так, чтобы

мощность критерия была максимальной.

Выполнение этого требования должно

обеспечить минимальную ошибку второго

рода, что, конечно, желательно.

Замечание 1.

Поскольку вероятность события «ошибка

второго рода допущена» равна

,

то вероятность противоположного события

«ошибка второго рода не допущена» равна

1 —,

т.е. мощности критерия. Отсюда следует,

что мощность критерия есть вероятность

того, что не будет допущена ошибка

второго рода.

Замечание 2. Ясно,

что чем меньше вероятности ошибок

первого и второго рода, тем критическая

область «лучше». Однако при заданном

объёме выборки уменьшить одновременно

и

невозможно; если уменьшить

,

тобудет возрастать. Например, если принять

=0,

то будут приниматься все гипотезы, в

том числе и неправильные, т.е. возрастает

вероятностьошибки второго рода.

Как же выбрать

наиболее целесообразно? Ответ на этот

вопрос зависит от «тяжести последствий»

ошибок для каждой конкретной задачи.

Например, если ошибка первого рода

повлечёт большие потери, а второго рода

– малые, то следует принять возможно

меньшее.

Если

уже выбрано, то, пользуясь теоремой Ю.

Неймана и Э.Пирсона, можно построить

критическую область, для которойбудет минимальным и, следовательно,

мощность критерия максимальной.

Замечание 3.

Единственный способ одновременного

уменьшения вероятностей ошибок первого

и второго рода состоит в увеличении

объёма выборок.

Материал из MachineLearning.

Перейти к: навигация, поиск

Содержание

- 1 Стандартная методика проверки статистических гипотез

- 2 Вычисление пи-величины

- 3 Вычисление ROC-кривой

- 4 Литература

- 5 См. также

- 6 Ссылки

Уровень значимости статистического теста — допустимая для данной задачи вероятность ошибки первого рода (ложноположительного решения, false positive), то есть вероятность отклонить нулевую гипотезу, когда на самом деле она верна.

Другая интерпретация:

уровень значимости — это такое (достаточно малое) значение вероятности события, при котором событие уже можно считать неслучайным.

Уровень значимости обычно обозначают греческой буквой (альфа).

Стандартная методика проверки статистических гипотез

В стандартной методике проверки статистических гипотез уровень значимости фиксируется заранее, до того, как становится известной выборка

.

Чрезмерное уменьшение уровня значимости (вероятности ошибки первого рода) может привести к увеличению вероятности ошибки второго рода, то есть вероятности принять нулевую гипотезу, когда на самом деле она не верна (это называется ложноотрицательным решением, false negative).

Вероятность ошибки второго рода связана с мощностью критерия

простым соотношением

.

Выбор уровня значимости требует компромисса между значимостью и мощностью или

(что то же самое, но другими словами)

между вероятностями ошибок первого и второго рода.

Обычно рекомендуется выбирать уровень значимости из априорных соображений.

Однако на практике не вполне ясно, какими именно соображениями надо руководствоваться,

и выбор часто сводится к назначению одного из популярных вариантов

.

В докомпьютерную эпоху эта стандартизация позволяла сократить объём справочных статистических таблиц.

Теперь нет никаких специальных причин для выбора именно этих значений.

Существует две альтернативные методики, не требующие априорного назначения .

Вычисление пи-величины

Достигаемый уровень значимости или пи-величина (p-value) — это наименьшая величина уровня значимости,

при которой нулевая гипотеза отвергается для данного значения статистики критерия .

где

— критическая область критерия.

Другая интерпретация:

достигаемый уровень значимости или пи-величина — это вероятность, с которой (при условии истинности нулевой гипотезы) могла бы реализоваться наблюдаемая выборка, или любая другая выборка с ещё менее вероятным значением статистики

.

Случайная величина имеет равномерное распределение.

Фактически, функция приводит значение статистики критерия

к шкале вероятности.

Маловероятным значениям (хвостам распределения) статистики соотвествуют значения

, близкие к нулю или к единице.

Вычислив значение на заданной выборке

,

статистик имеет возможность решить,

является ли это значение достаточно малым, чтобы отвергнуть нулевую гипотезу.

Данная методика является более гибкой, чем стандартная.

В частности, она допускает «нестандартное решение» — продолжить наблюдения, увеличивая объём выборки, если оценка вероятности ошибки первого рода попадает в зону неуверенности, скажем, в отрезок .

Вычисление ROC-кривой

ROC-кривая (receiver operating characteristic) — это зависимость мощности от уровня значимости

.

Методика предполагает, что статистик укажет подходящую точку на ROC-кривой, которая соответствует компромиссу между вероятностями ошибок I и II рода.

Литература

- Кобзарь А. И. Прикладная математическая статистика. Справочник для инженеров и научных работников. — М.: Физматлит, 2006.

- Цейтлин Н. А. Из опыта аналитического статистика. — М.: Солар, 2006. — 905 с.

- Алимов Ю. И. Альтернатива методу математической статистики. — М.: Знание, 1980.

См. также

- Проверка статистических гипотез — о стандартной методике проверки статистических гипотез.

- Достигаемый уровень значимости, синонимы: пи-величина, p-Value.

Ссылки

- P-value — статья в англоязычной Википедии.

- ROC curve — статья в англоязычной Википедии.

Критерии проверки статистических гипотез

Понятие статистической гипотезы

Статистической гипотезой (гипотезой) называется любое утверждение об изучаемом законе распределения или характеристиках случайных величин.

Пример статистических гипотез:

- Генеральная совокупность распределена по нормальному закону.

- Дисперсии двух нормально распределенных совокупностей равны между собой.

Нулевая гипотеза (Н0) — предположение о том, что между параметрами генеральных совокупностей нет различий, то есть эти различия носят не систематический, а случайный характер.

Пример1. Нулевая гипотеза записывается следующим образом:

H0: µ1=µ2 (нулевая гипотеза заключается в том, что генеральное среднее одной совокупности равно генеральному среднему другой совокупности).

Альтернативная гипотеза (Н1) – предположение о том, что между параметрами генеральных совокупностей есть достоверные различия.

Пример 2. Альтернативные гипотезы записываются следующим образом:

- H1: µ1≠µ2 (нулевая гипотеза заключается в том, что генеральное среднее одной совокупности не равно генеральному среднему другой совокупности).

- H1: µ1>µ2 (нулевая гипотеза заключается в том, что генеральное среднее одной совокупности больше генерального среднего другой совокупности).

- H1: µ1<µ2 (нулевая гипотеза заключается в том, что генеральное среднее одной совокупности меньше генерального среднего другой совокупности).

Ошибки при проверке гипотез

Ошибки, допускаемые при проверке статистических гипотез, делятся на два типа:

- ошибки первого рода;

- ошибки второго рода.

Ошибка первого рода – отклонение гипотезы Н0, когда она верна. Вероятность ошибки первого рода обозначается α и называется уровнем значимости.

Ошибка второго рода – принятие гипотезы Н0, когда верна альтернативная гипотеза. Вероятность ошибки второго рода обозначается β.

Классификация критериев значимости (критериев проверки статистических гипотез)

Для проверки правдоподобия статистической гипотезы используют критерий значимости – метод проверки статистической гипотезы.

Необходимо отметить, что до получения исследователем экспериментальных данных необходимо сформулировать статистическую гипотезу и задать уровень значимости α. При выборе уровня значимости исследователь должен исходить из практических соображений, отвечая на вопрос: какую вероятность ошибки он считает допустимой. В области физической культуры и спорта чаще всего задают уровень значимости α=0,05.

Критерии проверки статистических гипотез (критерии значимости) можно разделить на три большие группы:

- Критерии согласия;

- Параметрические критерии;

- Непараметрические критерии.

Критерии согласия называются критерии значимости, применяемые для проверки гипотезы о законе распределения генеральной совокупности, из которой взята выборка. Для проверки статистической гипотезы чаще всего используются следующие критерии согласия: критерий Шапиро-Уилки, критерий хи-квадрат, критерий Колмогорова-Смирнова.

Параметрические критерии – критерии значимости, которые служат для проверки гипотез о параметрах распределений (чаще всего нормального). Такими критериями являются: t-критерий Стьюдента (независимые выборки), t-критерий Стьюдента (связанные выборки), F-критерий Фишера (независимые выборки).

Непараметрические критерии – критерии значимости, которые для проверки статистических гипотез не использует предположений о распределении генеральной совокупности. В качестве примера таких критериев можно назвать критерий Манна-Уитни и критерий Вилкоксона.

Литература

- Высшая математика и математическая статистика: учебное пособие для вузов / Под общ. ред. Г. И. Попова. – М. Физическая культура, 2007.– 368 с.

- Катранов А.Г. Компьютерная обработка данных экспериментальных исследований: Учебное пособие/ А. Г. Катранов, А. В. Самсонова; СПб ГУФК им. П.Ф. Лесгафта. – СПб.: изд-во СПб ГУФК им. П.Ф. Лесгафта, 2005. – 131 с.

- Основы математической статистики: Учебное пособие для ин-тов физ. культ / Под ред. В.С. Иванова.– М.: Физкультура и спорт, 1990. 176 с.