Copyright © 2023 Synology Inc. Все права защищены.

Положения и условия

|

Конфиденциальность

|

Настройки файлов cookie

|

Россия — Русский

Уважаемый Igr_ua

Благодарю за терпение и потраченное на меня время.

Пожалуйста

Теперь к вопросам…

(пока собирался, на часть вопросов ответы уже дали)

Прежде всего внимательно изучаем содержимое файла /etc/fstab и содержимое файла /proc/mdstat. Если нужно, то записываем на листик исходные данные.

Из этих файлов вы узнаете много нужного в дальнейшем (пример содержимого файлов здесь

Проверка RAID разделов NAS на ошибки файловой системы

1. Останавливаем все сервисы

Как? Тупо из web интерфейса? Или есть какие-нибудь волшебные команды?

Да. Тупо из интерфейса.

2. Проверяем под каким номером RAID

mdadm -D /dev/md0 (md1, md2 и т.д.)

это мы уже узнали из файлов /etc/fstab и /proc/mdstat, но можно и проверить

2. Отмонтируем раздел

umount /volume1

Как определить правильно какую циферку ставить после volume? Если у меня в менеджере хранение написано «раздел 1» то и в этой команде тоже должно быть volume1?

Это тоже видно из тех же файлов.

Иногда может возникнуть ситуация, что раздел не захочет размонтироваться. Вроде бы и все сервисы остановили, пакеты отключили, но….

Тогда, заходим в терминал (через putty или кому как удобней) и смотрим активные процессы.

Это можно сделать с помощью команды Top либо ps.

после этого останавливаем процесс:

killall имя_процесса

3. Останавливаем RAID

mdadm -S /dev/md0

4. Проверяем раздел

e2fsck -f /dev/md0

если e2fsck отработала и вернула код «0» — значит все в порядке.

Запуск проверки раздела с автоматическим исправлением ошибок

e2fsck -p /dev/md0

да.

5. Монтируем раздел обратно

mount /dev/md0 /volume1

не получится, т.к. перед этим необходимо собрать массив

Create — создание RAID-массива из нескольких дисков (с суперблоком на каждом устройстве).

Assemble — сборка (ранее созданного) массива и его активация. Диски из которых собирается массив могут указываться явно или будет выполнен их автоматический поиск. mdadm проверяет, образуют ли компоненты корректный массив.

Пример:

mdadm —assemble -R —force /dev/md3 /dev/sdc3 /dev/sdd3

mdadm -Cf /dev/md2 -R -n 3 —level=linear /dev/sda3 /dev/sdb3 /dev/sdc3 /dev/sdd3 (это пример… не повторять буквально!!!!)

пример для массива JBOD — здесь — пункты 7-12

Вот после этого, когда собрали массив, монтируем его в систему.

6. Запустить все службы и программы на NAS

Как? И нужно ли? Может просто перезагрузить NAS?

Это зависит от того, какие цели вы преследуете.

Когда мне надо было вытаскивать данные, то я коробку не перегружал.

Если вам работать как обычно — лучше перегрузить (мало ли какие процессы вы пришибли вручную в п.2)

7. Перезагрузить NAS.

где-то так….

з.ы. про mdadm — тут

Осталось в заключении добавить, что все что вы делаете с собственным массивом, вы делаете на собственный страх и риск…

Всем привет!!!

Сегодня я расскажу как запускать тестирование SMART на жёстких дисках и чем отличается быстрый тест от расширенного.

S.M.A.R.T. (от англ. self-monitoring, analysis and reporting technology — технология самоконтроля, анализа и отчётности) — технология оценки состояния жёсткого диска встроенной аппаратурой самодиагностики, а также механизм предсказания времени выхода его из строя. Технология S.M.A.R.T. является частью протоколов ATA и SATA.

S.M.A.R.T. — Википедия (wikipedia.org)

Я в этой статье не буду рассказывать про параметры SMART, что они означают и что делать, если что-то не так. На этот счет в интернете много всяких статей и авторов, которые разбираются в этом точно лучше меня. Я расскажу и акцентирую внимание на тестах SMART, которыми большая часть людей пренебрегает и как оказалось напрасно.

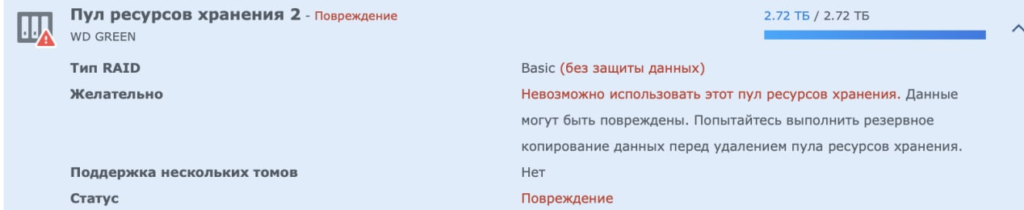

Давайте рассмотрим страшный сон любого владельца NAS сервера, это когда у вас сдыхает диск без резервирования. Ну например на нем система фиксирует битые сектора.

Что делать в этой ситуации понятно, пытаться копировать с диска уцелевшие данные и менять на новый. Да, наверняка есть возможность как-то проигнорировать или даже исправить повреждение, но во первых это только начало диск уже начал сыпаться, а во вторых в этой статья я выбрал другую тему.

И тут возникает вопрос, почему мониторинг SMART этого не показал заранее, что бы более безболезненно заранее исправить проблему. А все дело в том, как работает этот мониторинг. Во время работы диска информация считывается и записывается и если данные попадают на битый сектор, то в дело вступает смарт. Сначала блок помечается как битый и переносится в область SMART, а если эта область заканчивается, то просто помечается как битый. Естественно в этих случаях мы увидим в мониторинге SMART рост количества битых секторов.

А что если обращения к битому сектору не было? А ничего и не будет, никто не узнает, что он битый и этой информации по понятным причинам не будет в мониторинге SMART. Вот так, смарт чистый, а сектора битые есть. Но разработчики SMART не глупые люди, они предусмотрели такой вариант. Для таких ситуаций придуманы тесты SMART:

- Короткий (Short) – Проверяет электрические и механические параметры, а также производительность на чтение. Тест, как правило, длится около двух минут.

- Длинный/расширенный (Long/extended) – Тест проверяет всю поверхность диска и не имеет ограничения по времени. В среднем занимает около двух-трёх часов.

- Тест транспортировки (Conveyance) – Быстрый тест, предназначенный для оценки состояния диска после транспортировки диска от производителя к поставщику.

- Выборочный (Selective) – Некоторые диски позволяют проверить определённую часть поверхности.

Получается, что бы найти битый сектор на диске нужно выполнить проверку поверхности диска, а это расширенный тест SMART.

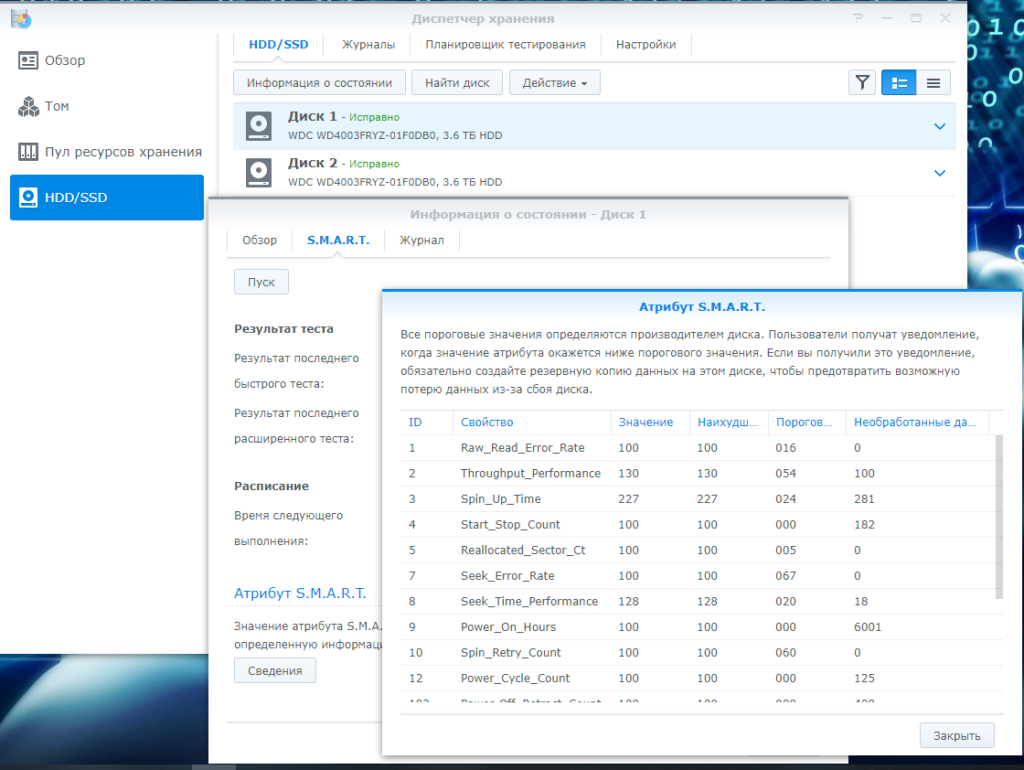

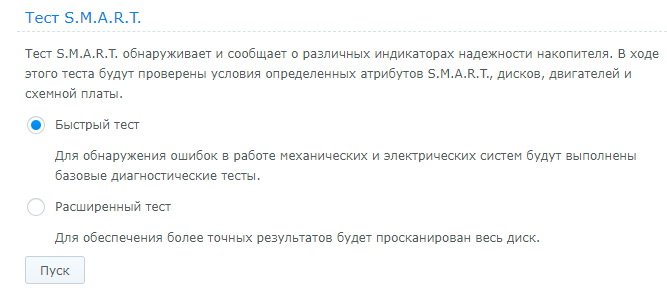

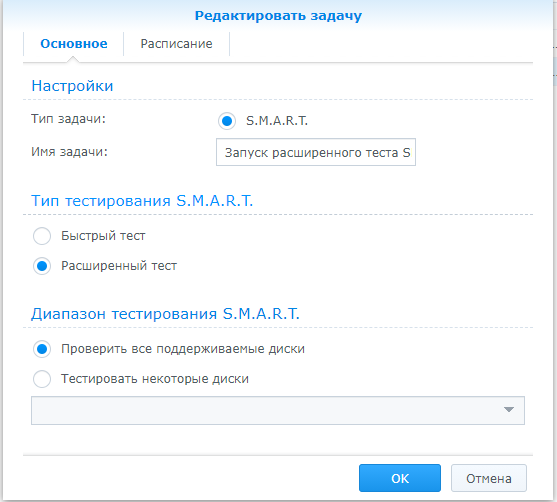

В Synology нам доступно два теста SMART называются они быстрый и расширенный:

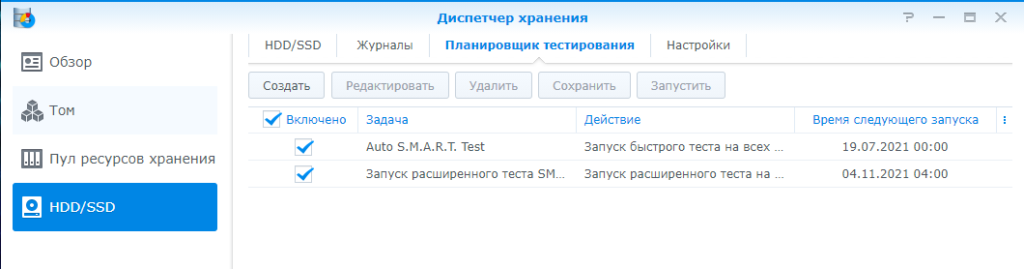

В общем говоря всегда можно зайти и запустить эти тесты вручную. Но Synology продумали и этот вариант. Эти тесты можно запускать по расписанию

По умолчанию включен только быстрый тест, а расширенный нужно настроить самому

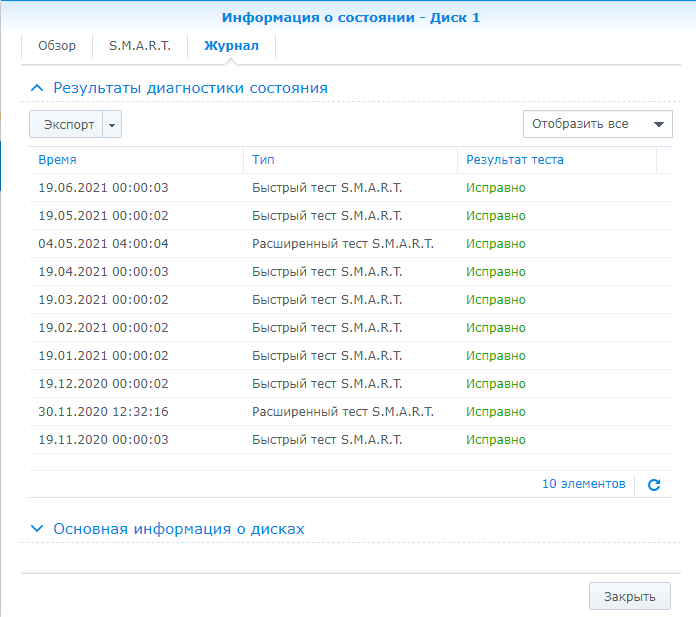

Ну как и везде есть не только плюсы, но и минусы. Если быстрый тест делается 2-3 минуты, то расширенный тест у меня на 4Т диске длился 4-6 часов, я просто сбился с подсчета времени, может и все 8, так это долго было. Но минус не в этом, а в том, что во время расширенного теста очень сильно падает производительность диска и все тормозит жутко. По этой причине расширенный тест лучше запускать на ночь или на выходные, когда NAS загружен минимум.

Что касается частоты запуска этих тестов, то тут вопрос щепетильный, ответ на который может дать только сам администратор NAS. Как часто и какой тест делать решаете только вы сами, так как факторов очень много. Я для себя для дома выбрал такую стратегию: раз в месяц я делаю быстрый тест SMART, а раз в полгода расширенный.

Берегите свои данные, настраивайте тестирование SMART по расписанию и делайте своевременно резервные копии и все будет хорошо!!!! Желаю всем удачи!!!!

Ну и в на последок хотел поделиться справкой, как можно заставить работать диск игнорируя предупреждения:

Изменение состояния предупреждения о проблемах на диске

Система непрерывно отслеживает состояние дисков и выдает предупреждения при обнаружении проблем. Некоторые проблемы могут быть серьезнее других. При возникновении определенных проблем, которые приводят к состоянию Предупреждение (выберите диск и нажмите Информация о состоянии > Обзор), можно изменить настройки отображения предупреждения. Для этого выполните следующие действия.

- Обратите внимание, что предупреждение о диске указывает на возникновение проблем с диском. Игнорирование такого предупреждения может привести к потере данных.

- Перейдите на страницу HDD/SSD и выберите диск в состоянии предупреждения.

- Нажмите Предупреждение об изменении диска.

- Нажмите пункт Скрытие предупреждения или Отключение предупреждения (в зависимости от типа проблемы могут отображаться два параметра):

- Скрытие предупреждения. Отслеживание поля с проблемными показателями продолжит выполняться, однако предупреждения будут инициироваться только в случае ухудшения показателей.

- Отключение предупреждения. Отслеживание поля S.M.A.R.T. будет навсегда отключено.

Примечание.

- Рекомендуется скрывать и отключать предупреждение о диске, только если вы понимаете, что рискуете потерять данные.

- Изменение состояния предупреждения о проблемах на диске не устраняет возникшие на диске проблемы, а также не исключает возможность их повторного возникновения в будущем, поэтому данное действие не должно рассматриваться как долгосрочное решение.

- Некоторые поля S.M.A.R.T. изначально являются критически важными и не могут быть скрыты или отключены.

- Для определенных атрибутов S.M.A.R.T. предупреждение отображается при снижении значения атрибута S.M.A.R.T. ниже наименьшего значения, заданного производителем диска. В раскрывающемся меню Скрыть предупреждение о диске эти атрибуты представлены в виде сообщения «Ранее произошел сбой атрибута S.M.A.R.T. (#ID)».

HDD/SSD | DSM – Центр знаний Synology

Уважаемый Igr_ua

Благодарю за терпение и потраченное на меня время.

Пожалуйста

Теперь к вопросам…

(пока собирался, на часть вопросов ответы уже дали)

Прежде всего внимательно изучаем содержимое файла /etc/fstab и содержимое файла /proc/mdstat. Если нужно, то записываем на листик исходные данные.

Из этих файлов вы узнаете много нужного в дальнейшем (пример содержимого файлов здесь

Проверка RAID разделов NAS на ошибки файловой системы

1. Останавливаем все сервисы

Как? Тупо из web интерфейса? Или есть какие-нибудь волшебные команды?

Да. Тупо из интерфейса.

2. Проверяем под каким номером RAID

mdadm -D /dev/md0 (md1, md2 и т.д.)

это мы уже узнали из файлов /etc/fstab и /proc/mdstat, но можно и проверить

2. Отмонтируем раздел

umount /volume1

Как определить правильно какую циферку ставить после volume? Если у меня в менеджере хранение написано «раздел 1» то и в этой команде тоже должно быть volume1?

Это тоже видно из тех же файлов.

Иногда может возникнуть ситуация, что раздел не захочет размонтироваться. Вроде бы и все сервисы остановили, пакеты отключили, но….

Тогда, заходим в терминал (через putty или кому как удобней) и смотрим активные процессы.

Это можно сделать с помощью команды Top либо ps.

после этого останавливаем процесс:

killall имя_процесса

3. Останавливаем RAID

mdadm -S /dev/md0

4. Проверяем раздел

e2fsck -f /dev/md0

если e2fsck отработала и вернула код «0» — значит все в порядке.

Запуск проверки раздела с автоматическим исправлением ошибок

e2fsck -p /dev/md0

да.

5. Монтируем раздел обратно

mount /dev/md0 /volume1

не получится, т.к. перед этим необходимо собрать массив

Create — создание RAID-массива из нескольких дисков (с суперблоком на каждом устройстве).

Assemble — сборка (ранее созданного) массива и его активация. Диски из которых собирается массив могут указываться явно или будет выполнен их автоматический поиск. mdadm проверяет, образуют ли компоненты корректный массив.

Пример:

mdadm —assemble -R —force /dev/md3 /dev/sdc3 /dev/sdd3

mdadm -Cf /dev/md2 -R -n 3 —level=linear /dev/sda3 /dev/sdb3 /dev/sdc3 /dev/sdd3 (это пример… не повторять буквально!!!!)

пример для массива JBOD — здесь — пункты 7-12

Вот после этого, когда собрали массив, монтируем его в систему.

6. Запустить все службы и программы на NAS

Как? И нужно ли? Может просто перезагрузить NAS?

Это зависит от того, какие цели вы преследуете.

Когда мне надо было вытаскивать данные, то я коробку не перегружал.

Если вам работать как обычно — лучше перегрузить (мало ли какие процессы вы пришибли вручную в п.2)

7. Перезагрузить NAS.

где-то так….

з.ы. про mdadm — тут

Осталось в заключении добавить, что все что вы делаете с собственным массивом, вы делаете на собственный страх и риск…

Как сказал Daxlerod, вам следует использовать инструменты SMART, однако вам также необходимо выполнить то, что называется очисткой данных.

Если вы еще этого не сделали, создайте группу дисков. Чтобы очистка данных была доступна, вам нужно как минимум 3 диска, по крайней мере, 1 резервный диск и как минимум 2 диска с данными. Подождите, пока группа дисков полностью синхронизируется, затем выполните очистку данных.

Начиная с версии Synology OS v4.2, очистка данных доступна из

Storage Manager -> Disk Group -> Manage -> Start data scrubbing

Это займет часы, поскольку он читает все сектора всех дисков и выполняет некоторые математические операции, чтобы увидеть, правильно ли складываются данные контрольной суммы. Вы можете использовать NAS, пока это происходит, но это будет немного медленнее. Многие люди запускают очистку данных раз в месяц. Лично я выполняю очистку данных один раз в неделю, а рабочую — в выходные, а домашнюю — в течение недели, пока я на работе.

Есть хорошая статья под названием Scrub Synology RAID-диски, в которой также рассказывается, как запустить средство проверки файловой системы, называемое fsck, даже если в веб-интерфейсе для этого нет опции.

Изменить: вышеуказанная страница, кажется, ушел, но в основном сказал

Команды для выполнения автономного fsck:

syno_poweroff_task fsck.ext4 -pvf /dev/vg[x]/volume_[y]Задача отключения питания выполняет некоторые размонтирования (том 1 и т.д.). Затем вы выполняете обычный Linux fsck.

Однако, читая еще несколько страниц, таких как https://forum.synology.com/enu/viewtopic.php?f=39&t=83186 и http://www.cyberciti.biz/faq/synology-complete-fsck-file-system- check-command/ кажется, что они изменились в DSM 5+. Кто-то предлагает использовать опцию -d (отладка) в задаче выключения, например

syno_poweroff_task -d

В то время как сайт киберцити предлагает использовать lsof, чтобы найти то, что использует том, используйте сценарии отключения службы в /usr/syno/etc/rc.d/ перед использованием команды umount .

Обратите внимание, что все это требует, чтобы вы вошли в окно NAS, если вам не нравится командная строка linux, а затем, возможно, сделайте запрос в Synology, чтобы добавить кнопку fsck в веб-интерфейс.

Руководство пользователя Synology NAS

Под управлением DSM 6.2

32 Глава 5: Управление объемом хранения

SSD TRIM

Если том состоит только из SSD (твердотельных накопителей), рекомендуется включить SSD TRIM.

Данная функция позволяет повысить скорость чтения и записи томов, созданных на SSD, что позволит

повысить эффективность и срок службы SSD.

Перед настройкой SSD TRIM ознакомьтесь с подробными инструкциями и дополнительными

ограничениями в

Справке DSM

.

Примечание.

Функция SSD TRIM доступна только на некоторых моделях Synology NAS и типах RAID.

Некоторые модели SSD не поддерживают выполнение SSD TRIM на томах RAID 5 и RAID 6. См. список

совместимости на веб-сайте

www.synology.com

.

Управление жесткими дисками

На вкладке

HDD/SSD

можно отслеживать состояние жестких дисков, установленных в Synology NAS, а

также организовывать и анализировать производительность и состояние дисков. Чтобы открыть эту

вкладку, выберите

Диспетчер хранения

и нажмите

HDD/SSD

. Для получения дополнительных

инструкций см.

Справку DSM

.

Включение поддержки записи в кэш

Включение поддержки записи в кэш повышает производительность Synology NAS. Эта функция

поддерживается только для некоторых моделей жестких дисков. Для обеспечения защиты данных при

поддержке записи в кэш настоятельно рекомендуется использовать устройство ИБП. Также

рекомендуется правильно выключать систему после каждого использования. Отключение записи в кэш

уменьшит вероятность потери данных при сбое питания, но сократит производительность.

Запуск тестов S.M.A.R.T.

Тесты S.M.A.R.T. для дисков изучают жесткий диск и сообщают о его состоянии, предупреждая о

возможных сбоях диска. При обнаружении ошибок рекомендуется сразу заменить диск. Также можно

запланировать автоматическое выполнение тестов S.M.A.R.T., создав задачи.

Проверка информации о диске

В разделе

Диспетчер хранения

>

HDD/SSD

>

HDD/SSD

нажмите стрелку вниз рядом с именем жесткого

диска, чтобы просмотреть название модели, серийный номер, версию микропрограммы и общий размер

жесткого диска.

Кэш SSD

Диски с кэшем SSD

1

можно установить и монтировать в конфигурации только для чтения (RAID 0) или

чтения-записи (RAID 1, RAID 5, RAID 6), чтобы увеличить скорость чтения и записи для тома. В разделе

Диспетчер хранения

>

Кэш SSD

можно создать кэш и просмотреть информацию о нем.

Сведения об установке SSD см. в Руководстве по установке оборудования для вашей модели Synology

NAS. Для получения дополнительных сведений об управлении SSD см.

Справку DSM

или

Техническую

документацию по кэшу SSD Synology

.

———

1

Кэш SSD поддерживается только в некоторых моделях. Для получения дополнительной информации посетите

страницу

www.synology.com

.

How to properly do a filesystem check (fsck or e2fck) on Synology DSM 6.0 e.g. DS414

I tried a lot of instructions and tutorials to do a file system check on a Synology DSM 6 device e.g the DS414.

The first step involves unmounting the partition you want to check e.g. the /volumes/ path before you can file system check it.

All the instructions I found are inaccurate, too old (most are for DSM 4 or 5), do not work or a dangerous. I just could not get the unmounting to work!

Presteps are install ipckg using instructions found here: https://github.com/basmussen/ds414-boostrap-dsm5

then install the packages less, lsof, mlocate

E.g. the common advice:

shuts down all services including telnet and the web interface etc. but it also shutsdown my ssh server and the webserver making the box completely inaccessible while still powered on -> you need to hard reset the box

the other common advice to just do a

and then kill the PID of the processes using the volume. Problem with this is that most services are watched by the system so if you kill them, they just restart again after a sec.

Here is my solution:

Get the list of services associated with your volume you want to fs check:

Or make the list more clear with:

lsof /volume1/ | sed 1d | cut -d" " -f1 | sort | uniq

e.g.

anvil

ash

cnid_dbd

cut

dovecot

img_backu

log

master

php56-fpm

pickup

postgres

qmgr

s2s_daemo

sed

sh

sort

syno_mail

afpd

cnid

If you are a bit into Linux you can spot/group these services into categories:

php5/httpd/apache2/nginx = searchterms httpd,nginx

postgres = searchterms postgres

dovecot/syno_mail = searchterm mail

...

to generally find services by name use the following syntax

find /usr/syno/etc.defaults/rc.sysv/ | grep -i <service name>

synoservicecfg --status | grep enable | grep -i <service name>

e.g.

find /usr/syno/etc.defaults/rc.sysv/ | grep -i postgres

synoservicecfg --status | grep enable | grep -i nginx

So my approach was to spot a service which sounds promising, stop it and then run

lsof /volume1/ | sed 1d | cut -d" " -f1 | sort | uniq to see if this service vanishes from the list.

So all in all I found the following services which I had to stop.

shutdown postgres — postgesql

/usr/syno/etc.defaults/rc.sysv/pgsql.sh stop

stop php5

synoservicecfg --stop pkgctl-PHP5.6

shutdown Mailserver

synoservicecfg --stop pkgctl-MailServer

shutdown backups (img_backu)

synoservicecfg --stop synobackupd

synoservicecfg --stop pkgctl-HyperBackupVault

synoservicecfg --stop pkgctl-synobackupd

synoservicecfg --stop pkgctl-HyperBackup

synoservicecfg --stop pkgctl-HyperBackupVault

synoservicecfg --stop pkgctl-TimeBackup

shutdown s2sdaemon

synoservicecfg --stop s2s_daemon

others: afp and cnid_dbd

Since I could not find any service definition file for those I simply killed the processes using good old kill command, which did not restart luckily within a minute or so.

disconnect the system user

now the last thing what was still in the list were some user cwd processes connected, as the /home folder was part of the /volumes1 folder:

sh 8480 Oli cwd DIR 253,1 4096 154796037 /volume1/homes/Oli

sudo 9104 root cwd DIR 253,1 4096 154796037 /volume1/homes/Oli

ash 9105 root cwd DIR 253,1 4096 154796037 /volume1/homes/Oli

lsof 9209 root cwd DIR 253,1 4096 154796037 /volume1/homes/Oli

lsof 9209 root txt REG 253,1 125544 369233175 /opt/sbin/lsof

lsof 9210 root cwd DIR 253,1 4096 154796037 /volume1/homes/Oli

lsof 9210 root txt REG 253,1 125544 369233175 /opt/sbin/lsof

Solution here was to logout your user and login the true root user using sshthen you can finally umount those beasts:

umount /opt

umount /volume1

then finally run your fsck diagnostic etc.

fsck.ext4 -fv /dev/mapper/vol1-origin

done!

Как сказал Daxlerod, вам следует использовать инструменты SMART, однако вам также необходимо выполнить то, что называется очисткой данных.

Если вы еще этого не сделали, создайте группу дисков. Чтобы очистка данных была доступна, вам нужно как минимум 3 диска, по крайней мере, 1 резервный диск и как минимум 2 диска с данными. Подождите, пока группа дисков полностью синхронизируется, затем выполните очистку данных.

Начиная с версии Synology OS v4.2, очистка данных доступна из

Storage Manager -> Disk Group -> Manage -> Start data scrubbing

Это займет часы, поскольку он читает все сектора всех дисков и выполняет некоторые математические операции, чтобы увидеть, правильно ли складываются данные контрольной суммы. Вы можете использовать NAS, пока это происходит, но это будет немного медленнее. Многие люди запускают очистку данных раз в месяц. Лично я выполняю очистку данных один раз в неделю, а рабочую — в выходные, а домашнюю — в течение недели, пока я на работе.

Есть хорошая статья под названием Scrub Synology RAID-диски, в которой также рассказывается, как запустить средство проверки файловой системы, называемое fsck, даже если в веб-интерфейсе для этого нет опции.

Изменить: вышеуказанная страница, кажется, ушел, но в основном сказал

Команды для выполнения автономного fsck:

syno_poweroff_task fsck.ext4 -pvf /dev/vg[x]/volume_[y]Задача отключения питания выполняет некоторые размонтирования (том 1 и т.д.). Затем вы выполняете обычный Linux fsck.

Однако, читая еще несколько страниц, таких как https://forum.synology.com/enu/viewtopic.php?f=39&t=83186 и http://www.cyberciti.biz/faq/synology-complete-fsck-file-system- check-command/ кажется, что они изменились в DSM 5+. Кто-то предлагает использовать опцию -d (отладка) в задаче выключения, например

syno_poweroff_task -d

В то время как сайт киберцити предлагает использовать lsof, чтобы найти то, что использует том, используйте сценарии отключения службы в /usr/syno/etc/rc.d/ перед использованием команды umount .

Обратите внимание, что все это требует, чтобы вы вошли в окно NAS, если вам не нравится командная строка linux, а затем, возможно, сделайте запрос в Synology, чтобы добавить кнопку fsck в веб-интерфейс.

As Daxlerod has stated you should use the SMART tools, however you also need to perform what is called data scrubbing.

If you haven’t already, create a disk group. For data scrubbing to be available you need at least 3 disks, with at least 1 redundant drive and at least 2 data drives. Wait for the disk group to fully synchronise, then perform a data scrub.

As of Synology OS v4.2 data scrubbing can be accessed from

Storage Manager -> Disk Group -> Manage -> Start data scrubbing

This will take hours as it reads all sectors of all of the disks and performs some math to see if the checksum data adds up properly. You can use you NAS while this is going but it will be a bit slower. Many people run a data scrub once a month. Personally, I do data scrubbing once a week, with work scrubbing on the weekend and home scrubbing during the week while I’m at work.

There is a good article called Scrub Synology RAID disks that also tells you how to run the file system check tool called fsck even though there is no option in the web interface for it.

Edit: The above page seems to be gone but it basically said

Commands for performing an offline fsck:

syno_poweroff_task fsck.ext4 -pvf /dev/vg[x]/volume_[y]The poweroff task performs some unmounts (volume 1 etc.). Then you perform the usual

Linux fsck.

However reading some more pages like https://forum.synology.com/enu/viewtopic.php?f=39&t=83186 and http://www.cyberciti.biz/faq/synology-complete-fsck-file-system-check-command/ they seem to suggest that things have changed in DSM 5+. Someone suggests using the -d (debug) option on the shutdown task such as

syno_poweroff_task -d

While the cyberciti site suggests using lsof to find what is using the volume then using the service shutdown scripts in /usr/syno/etc/rc.d/ before using the umount command.

Note that all of these requires that you ssh in to the NAS box, if you aren’t comfortable with the linux command line then perhaps make a request to Synology to put in an fsck button in the web interface.

Время на прочтение

3 мин

Количество просмотров 67K

Добрый день!

Не так давно пользователь olekl попросил нас рассказать о RAID 1 в Synology, а именно

— raid 1, отказ одного диска, процедура диагностики и горячей замены

— raid 1 из двух дисков разных производителей

— raid 1, отказ самого устройства, спасение данных с диска средствами ОС

Спрашивали? Отвечаем!

Итак, 2-х дисковые накопители все чаще востребованы в среде домашних пользователей и небольших компаний, где требуется небольшой объем хранения и обеспечение отказоустойчивости. В линейке продукции Synology представлено аж 7 (семь) 2-х дисковых NAS накопителей. Это модели:

Диагностика и горячая замена

Для диагностики неисправностей жестких дисков в Synology применяется 2 процедуры: проверка поверхности диска, запускаемая при создании нового массива и в дальнейшем по расписанию (по желанию пользователя) и получение данных S.M.A.R.T. в реальном времени. Использование этих процедур позволяет отследить и вовремя предупредить выход из строя одновременно двух дисков.

Зачастую, при неправильном выборе жесткого диска происходит его вылет из системы. Причем состояние поверхности диска и его смарт остаются в порядке. Причина таких вылетов — задумчивость диска и его неотклик в течении 7 секунд (время ожидания контроллера). Поэтому лучше выбирать диски NAS или Enterprise серий.

Если по результатам диагностики Synology выдал предупреждение, что жесткий диск неисправен — его рекомендуется заменить. Для этого, в зависимости от модели устройства, придется выключить (DS213air, DS213j, DS214se) или просто, на «горячую» извлечь диск. После установки нового диска (а в модели DS214play для этого даже не нужно откручивать винты — салазки для дисков безвинтовые) нужно открыть веб интерфейс Synology, авторизоваться и открыть Диспетчер хранения. Здесь мы в первую очередь отключаем звуковой сигнал соответствующей кнопкой на панели задач, а затем кнопкой управление запускаем процедуру восстановления раздела.

В зависимости от размера диска она может длиться от нескольких часов до 1 дня.

RAID 1 из двух дисков разных производителей.

Здесь все просто: работаем по меньшему/медленному диску.

Поскольку RAID 1 подразумевает одновременную запись на оба диска, то при установке медленного и быстрого накопителя в один раздел быстрый будет постоянно дожидаться, пока допишет его медленный товарищ. Такие конфигурации жизнеспособны, но

не рекомендуются для использования

.

Отказ устройства Synology, восстановление данных с дисков.

Крайне маловероятно, но все же Synology может выйти из строя: неправильное выключение (по питанию), физическое воздействие или просто несчастный случай. В такой момент пользователю необходимо в первую очередь удостовериться, что с данными все в порядке. Итак, что же на дисках? Все предельно просто:

Раздел 1 — Сама ОС DSM, объединяется в RAID 1, независимо от количества отсеков в устройстве.

Раздел 2 — swap, свойственный всем linux-овым ОС

Раздел 3 — Пользовательские данные. Самый главный для Вас и для NAS раздел:)

При использовании RAID 1 на диске создается обычный ext4 раздел, куда попадают данные. Монтируется в системе он как /volume1

Подключив диск из Synology к ПК под Linux мы увидим все 3 раздела и сможем спокойно вытащить данные.

Если с Linuxом Вы не знакомы, то подключаем диск к ПК под Windows, качаем и запускаем UFS Explorer Professional Recovery и читаем свои данные (увы, писать данная программа на ext4 не умеет).

Так же свежее решение — возможность построения кластера High Availability из двух одинаковых устройств. Из двухдисковых это только DS713+.

По факту, при построении данного кластера мы получаем почти RAID 1 из двух устройств («почти» потому что время перехода от активного к пассивному составляет около 40 секунд). Подробнее читайте на сайте synology.com

Ну и напоследок: установив жесткие диски со своего старого Synology в новый вы сможете прочитать все данные, хранящиеся на этих дисках. В некоторых случаях потребуется произвести миграцию.

На сайте thg.ru публикуется цикл статей, рассказывающий о NAS Synology и их настройке. По ссылке — урок 4, Все об использовании RAID.

Надеюсь, все донес понятно и просто. Если возникнут вопросы — с радостью отвечу на них в комментариях или по телефонам службы поддержки Synology:

+7 (499) 704-4539 для Москвы

8 (804) 333-4601 для регионов России (звонок бесплатный)

How to properly do a filesystem check (fsck or e2fck) on Synology DSM 6.0 e.g. DS414

I tried a lot of instructions and tutorials to do a file system check on a Synology DSM 6 device e.g the DS414.

The first step involves unmounting the partition you want to check e.g. the /volumes/ path before you can file system check it.

All the instructions I found are inaccurate, too old (most are for DSM 4 or 5), do not work or a dangerous. I just could not get the unmounting to work!

Presteps are install ipckg using instructions found here: https://github.com/basmussen/ds414-boostrap-dsm5

then install the packages less, lsof, mlocate

E.g. the common advice:

syno_poweroff_task -d

shuts down all services including telnet and the web interface etc. but it also shutsdown my ssh server and the webserver making the box completely inaccessible while still powered on -> you need to hard reset the box

the other common advice to just do a

lsof /volumes/

and then kill the PID of the processes using the volume. Problem with this is that most services are watched by the system so if you kill them, they just restart again after a sec.

Here is my solution:

Get the list of services associated with your volume you want to fs check:

lsof /volumes

Or make the list more clear with:

lsof /volume1/ | sed 1d | cut -d" " -f1 | sort | uniq

e.g.

anvil

ash

cnid_dbd

cut

dovecot

img_backu

log

master

php56-fpm

pickup

postgres

qmgr

s2s_daemo

sed

sh

sort

syno_mail

afpd

cnid

If you are a bit into Linux you can spot/group these services into categories:

php5/httpd/apache2/nginx = searchterms httpd,nginx

postgres = searchterms postgres

dovecot/syno_mail = searchterm mail

...

to generally find services by name use the following syntax

find /usr/syno/etc.defaults/rc.sysv/ | grep -i <service name>

synoservicecfg --status | grep enable | grep -i <service name>

e.g.

find /usr/syno/etc.defaults/rc.sysv/ | grep -i postgres

synoservicecfg --status | grep enable | grep -i nginx

So my approach was to spot a service which sounds promising, stop it and then run

lsof /volume1/ | sed 1d | cut -d" " -f1 | sort | uniq to see if this service vanishes from the list.

So all in all I found the following services which I had to stop.

shutdown postgres — postgesql

/usr/syno/etc.defaults/rc.sysv/pgsql.sh stop

stop php5

synoservicecfg --stop pkgctl-PHP5.6

shutdown Mailserver

synoservicecfg --stop pkgctl-MailServer

shutdown backups (img_backu)

synoservicecfg --stop synobackupd

synoservicecfg --stop pkgctl-HyperBackupVault

synoservicecfg --stop pkgctl-synobackupd

synoservicecfg --stop pkgctl-HyperBackup

synoservicecfg --stop pkgctl-HyperBackupVault

synoservicecfg --stop pkgctl-TimeBackup

shutdown s2sdaemon

synoservicecfg --stop s2s_daemon

others: afp and cnid_dbd

Since I could not find any service definition file for those I simply killed the processes using good old kill command, which did not restart luckily within a minute or so.

disconnect the system user

now the last thing what was still in the list were some user cwd processes connected, as the /home folder was part of the /volumes1 folder:

sh 8480 Oli cwd DIR 253,1 4096 154796037 /volume1/homes/Oli

sudo 9104 root cwd DIR 253,1 4096 154796037 /volume1/homes/Oli

ash 9105 root cwd DIR 253,1 4096 154796037 /volume1/homes/Oli

lsof 9209 root cwd DIR 253,1 4096 154796037 /volume1/homes/Oli

lsof 9209 root txt REG 253,1 125544 369233175 /opt/sbin/lsof

lsof 9210 root cwd DIR 253,1 4096 154796037 /volume1/homes/Oli

lsof 9210 root txt REG 253,1 125544 369233175 /opt/sbin/lsof

Solution here was to logout your user and login the true root user using sshthen you can finally umount those beasts:

umount /opt

umount /volume1

then finally run your fsck diagnostic etc.

fsck.ext4 -fv /dev/mapper/vol1-origin

done!

via https://github.com/OliPelz/how-to-fsck-on-synology-dsm6

I can show you, how you can get more and better information about your HDD/SSD and iSCSI drives operated in your NASes by useful tool called HD Sentinel:

Note:

— don’t by dissuaded by UI from maybe 2005

— in right hands it’s more useful tool than all exist Syno packages for the disks monitoring/tests/maintenance

— clients sw is running on Win, Linux based OSs, or there are portable versions

— Central (Pro ver) console on Win based OSs

Background:

— no need an installation, it’s standalone tool, just download, unzip and use (except console)

— to get a single point of view about all possible disk health, lifespan information based on excelent smartmontools + additional useful tools integrated into one package

— surface tests (deep range)

— customized thresholds for each disk independently (SSD warning temp is different from HDD and each drive has own treshold)

— a report availability:

a) by CLI

b) by single source file — for an external monitoring based on tools like Grafana

c) by browser

d) by central console of HD Sentinel (paid Pro version), that can help you also in process of rescue of your data in your NAS and also all possible disk drives ( in your laptop, desktop, external, USB, SATA, NVMe M.2 SSD, SD card, …)

Legend:

Part n. 1: Preparation of the hdsentinel tool into your NAS

Part n. 2: Task scheduler in your NAS

Part n. 3: Report view

Part n. 4: HD Sentinel Pro console (for Win OS operation)

—————

Part n. 1: Preparation of the hdsentinel tool into your NAS

Installation is really easy

Open your CLI to NAS

Create folder in one f your Shared folders structure to save the tool and report

for such resource I will use:

mkdir /volume1/SharedFolderName/hdsentinel

cd /volume1/SharedFolderName/hdsentinel

now you need download and unzip the tool from a source:

make sure that «hdsentinel-018c-x64» is the last Linux version propagated at the source:

you can copy and paste highlighted (red) link of the last possible source from this section of the web page:

rename the executable file (for simple CLI feature usage):

mv hdsentinel-018c-x64 hdsentinel

then you need just create an executable permission for the tool:

Part n.1 is DONE!

Part n. 2: Task scheduler in your NAS

DSM/Control panel/Task scheduler:

2.1. Create Scheduled Task by User-defined script

2.2. then define name of the task, e.g. HardDiskSentinel SMART

and keep «root» … when you change root to diff user (administrators group) you will see the report in HTML but some details will see just root (based on DSM setup)

2.3. Setup of Scheduler:

Note: 5 minutes of frequency is appropriate for my operation

2.4. Setup of the custom script:

/volume1/SharedFolderName/hdsentinel/hdsentinel -r /volume1/SharedFolderName/hdsentinel/hdsreport.html -html

don’t forget to change correct path to the hdsentinel (defined in the Part n.1) in both part of the script

Note:

— you can also use MHT file format (then you need change specification in end of the command from -html to -mht)

— same for XML format

— same for stdout format (the you have to use -dump)

… or you can use multiple formats

Part n.2 is DONE!

Part n. 3: Report view

3.1. Browser part:

file://yourNASip/SharedFolderName/hdsentinel/hdsreport.html

you will get the extended Report:

3.2. CLI part:

Note:

you can get Power on Time value simple by smartctl command:

smartctl —all /dev/sda | grep Power_On_Hours | cut -d «-» -f2 | tr -d «[:blank:]»

you will get value in hours, e.g. 49718 hours what is not good readable format

or

you can use also CLI feature of hdsentinel:

./hdsentinel -dev /dev/sda | grep Power

you will get:

what is quite better readable

or for all:

./hdsentinel | grep Power

there is useful list of possible commands for hdsentinel, e.g. check of temperature your drives:

./hdsentinel -solid | awk ‘{print $2, $1, $5}’ | grep -v «^?» | sort -n

Part n. 3 is DONE!

Part n. 4: HD Sentinel Pro console (Win OS only)

How to not just monitor all your storage devices in single places from each NASes, better than in Grafana, because you can active control of the devices.

This is a screenshot from my Win OS HD Sentinel Pro console:

— you can see part of the console with simple attached all operated disks in my NASes, include integration into OS tray notification

4.1. What you need for the console?

Win OS

download and install last version from:

last version: Hard Disk Sentinel Professional Setup v5.61, Cost: 33,60EUR incl VAT, lifetime e-licence

there is also Family pack for the Pro version = 5 computers for EUR 49.95 / USD 53.00 (lifetime license) … my choice

the installation process is very simple, no need a guide

Then you need register your NAS/NASes report/s prepared in the Part n.1.

Follow these steps (within the Pro console only):

Open from menu File/Configure NAS Disk Monitoring

when you have permanently mounted your Shared folder where is the hdsentinel report stored, then use button Browse and find the exact report file.

That’s it! Done! Just confirm it by OK button or repeat this step for each single NAS.

How to use all features of the Pro console? This is up to you or my free time.

— one of the useful is SMART values output in chart — you can find there a degradation behavior or similar important information

— second, that you can independently setup a Custom temperature threshold for each single disk (yelow-warning, red-overheating)

Edit:

… and there is also Disk menu for an initial disk repairing jobs — there you can setup Custom SMART test, include all possible Surface test for single or bunch of disks. To be sure: you need switch off the NAS, take of the disk from NAS connect it by SATA/USB to your computer. It’s necessary to do it by this way, because you need unmounted volume.

… include an interesting knowledge base (also about disks and support).

Part n. 4 is DONE!

Useful notes:

here you can find a detailed comparison of the Hard Disk Sentinel licenses:

Hard Disk Sentinel store

Comparison of Hard Disk Sentinel versions. Software store, purchase, buy now and registration

www.hdsentinel.com

here you van find revision history of the all hdsentinel versions:

Have a great experiences with your storage medias!