Ошибки в каналах

связи появляются в результате воздействия

различного рода случайных помех. Поэтому

последовательность ошибок является

случайной последовательностью, а ее

характеристики — случайными величинами.

Основной метод изучения последовательности

ошибок – статистический метод.

Сущность данного

метода заключается в том, что с помощью

специальных приборов производятся

исследования каналов различного типа.

В процессе исследований выявляются и

накапливаются последовательности

ошибок за длительный промежуток времени.

Обработка и обобщение полученных

статистических данных позволяют

установить и изучить закономерности

появления ошибок в каналах связи. Знание

этих закономерностей, в свою очередь,

позволяет научно обоснованно определять

наиболее эффективные меры борьбы с

ошибками.

Для получения

достоверных статистических результатов

объемы выборок последовательности

ошибок должны быть такими, чтобы они

охватывали все характерные состояния

канала. Опытным путем установлено, что

для получения достоверных статистических

данных каналы, образованные проводными,

радиорелейными и тропосферными линиями

связи, должны испытываться в течение

нескольких суток непрерывно, а

коротковолновые радиоканалы — по

нескольку суток в различное время года.

При этих условиях объем выборки может

достигать

и более элементов по каждому каналу.

Испытаниям подвергаются действующие

каналы в обычных условиях эксплуатации.

Первичные характеристики каналов должны

соответствовать установленным нормам

и периодически контролироваться в

процессе испытания.

Сущность общепринятого

метода выявления последовательности

ошибок в дискретном канале заключается

в следующем. На вход канала подается

испытательная двоичная последовательность

(испытательный текст). На выходе

дискретного канала из принятой

последовательности

поэлементно

вычитается

,

в результате чего образуется

последовательность ошибок

.

В том случае, когда необходимо выявить

лишь последовательность модулей ошибок

Е, на выходе дискретного канала

достаточно произвести поэлементное

сложение по модулю 2 последовательностей

и

:

+

=

Е.

Статистическая

структура испытательной последовательности

должна быть достаточно близка к структуре

передаваемой информации. Этому условию

удовлетворяют двоичные последовательности,

вырабатываемые генераторами

последовательности максимальной длины

( ГПМД). Благодаря этому, а также вследствие

простоты реализации ГПМД получили

наибольшее распространение в качестве

генераторов испытательной последовательности

.

В зависимости от

задач статистических измерений ошибки

могут непосредственно подсчитываться

с помощью счетчиков или записываться

на долговременный носитель для последующей

обработки.

3.4.3 Основные закономерности распределения ошибок в реальных каналах связи

A.

Характер распределения ошибок в реальных

каналах

Одним из основных

параметров последовательности ошибок

является частота появления ошибок pL.

Частость появления ошибок (или просто

частость ошибок) определяется как

отношение числа ошибок Мош =

,

появившихся за определенный отрезок

времени t , к общему числу переданных

символов L:

При

достаточно большом L частость ошибок

сходится с вероятностью появления

ошибки (вероятность ошибки) p. Значения

p для различных типов каналов приведены

в таблице 3.1.

В

течение длительного времени, когда

отсутствовали статистические данные

реальных каналов связи, предполагалось,

что ошибки в каналах связи появляются

независимо. При таком распределении

ошибок значение i-го элемента

последовательности ошибок Е не зависит

от того, какое значение принимает любой

другой j-й элемент данной последовательности.

Пусть

Р{ei=1}=p, P{(ei=1)/(ej=1)} —

вероятность приема i-го элемента с

ошибкой (ei=1) при условии, что ошибка

произошла на j-м месте (ej=1), а

Р{(ei=1)/(ej=0)} — вероятность

приема i-го элемента с ошибкой при

условии, что j-й элемент принят правильно.

Ошибки появляются независимо, если

выполняется условие:

Р{(ei=1)/(ej=1)}=Р{(ei=1)/(ej=0)}=Р{ei=1}=p

В

противном случае появление ошибок

является зависимым событием.

При

независимых ошибках достаточно знать

значение единственного параметра р,

чтобы определить распределение любой

случайной величины. Для этого достаточно

воспользоваться схемой Бернулли. В

частности, вероятность появления в

n-элементной комбинации ровно i ошибок

P(i,n) определяется биномиальным

распределением:

( 0 ≤ i ≤ n

).

Вероятность

приема комбинации без ошибки P(0,n)=(1 —

p)n = qn . Следовательно,

вероятность появления искаженной

комбинации, т.е. комбинации, содержащей

хотя бы одну ошибку,

,

при np « 1, P(≥1,n) ≈ np.

Вероятность

появления m и более ошибок в комбинации

длины n:

.

Иногда

(при m<n/2) для вычисления P(≥m,n) удобнее

пользоваться формулой, полученной из

условия, что

:

.

Многочисленные

исследования реальных каналов связи

не подтвердили гипотезу о независимом

характере появления ошибок.

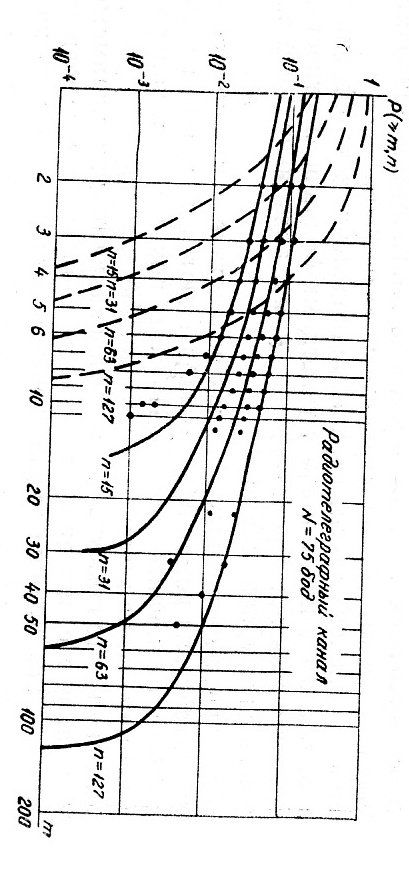

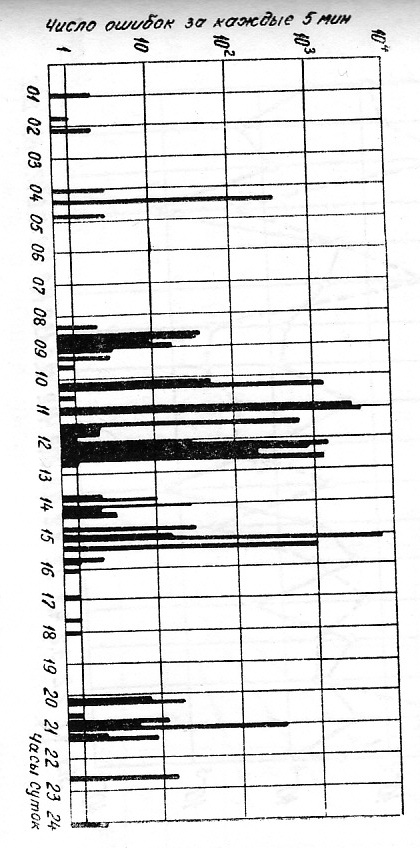

Рис.3.1

Данные исследования

показали, что ошибки появляются группами

(пачками). Частость ошибок во время

появления группы ошибок возрастает и

становится значительно больше вероятности

р. На рисунке 3.1 в

качестве примера, иллюстрирующего

групповой характер появления ошибок,

приведено абсолютное число ошибок,

появляющихся за каждые пять минут суток

в кабельном телефонном канале связи.

Это число определялось по результатам

испытания канала в течение шести суток.

Ошибки, как показано на рисунке 3.1

группируются в определенные промежутки

времени. В ночное время число ошибок в

подавляющем большинстве пятиминутных

сеансов равно нулю или меньше десяти.

В первой половине дня число ошибок за

пятиминутные интервалы редко бывает

равно нулю, а в большинстве превышает

сотни и тысячи ошибок. Испытания

проводились на скорости телеграфирования

N=1200 бод, поэтому L=5·60·1200=3.6·105

элементов. Частость ошибок pL в

ночное время колеблется в пределах

0÷3·10-5, а в дневное время — 0÷10-2.

Таким

образом, появление ошибок в реальных

каналах является зависимым событием,

поэтому схема Бернулли не применима.

Расчеты по формулам, полученным на

основе данной схемы, приводят к

значительным, а во многих важных для

практики случаях и недопустимым

погрешностям. Групповой характер

появления ошибок проявляется во всех

статистических характеристиках

последовательности ошибок. Поэтому для

математического описания этой

последовательности недостаточно знать

один параметр р, а необходимо определить

дополнительные параметры, учитывающие

степень зависимости появления ошибок

в реальных каналах.

Б.Зависимость вероятности появления

искаженной комбинации от длины

Статистическая

вероятность появления искаженной

комбинации определяется как отношение

числа искаженных комбинаций Bош(n)

к общему числу комбинаций B0(n),

т.е.

.

Вероятность Р(≥1,n)

является неубывающей функцией n. При

n=1 Р(≥1,n)=р, а при n→∞ вероятность P(≥1,n)

с ростом n зависит от характера

распределения ошибок.

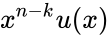

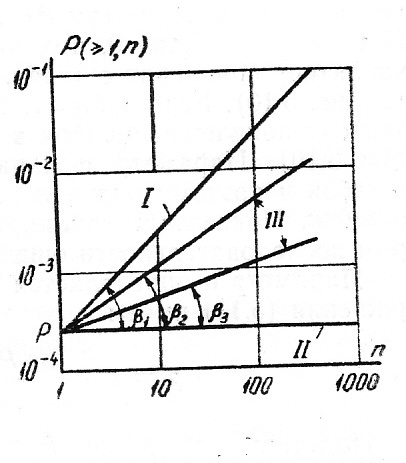

На рис. 3.2 показана

функция P(≥1,n) в логарифмическом масштабе,

т.е. log P(≥1,n)=log

p + log n.

Это выражение является уравнением

прямой, пересекающейся с осью y

точке y=p

под углом β1. Так как угловой

коэффициент tgβ1=1,

то β1=π/4.

Для

гипотетического канала, у которого

часть последовательности ошибок e1=

e2=…= e

Мош=1,

а остальная часть eМош+1=

eМош+2=…= eL=0,

на интервале 1≤i≤Mош

частость ошибок рL1

= Mош / Mош

= 1, а на участке i > Mош

частость ошибок рL2=0.

Так как число искаженных комбинаций

длины n Bош(n)=Мош

/ n, а общее число

комбинаций B0 = L

/ n, то вероятность появления

искаженной комбинации:

.

Таким образом, для

канала, у которого ошибки появляются

плотной группой на одном из

временных

и

Рис.

3.2

нтервалов, вероятность появления

искаженной комбинации не зависит от

n и log

Р(≥1,n)=log p.

Это выражение представляет собой

уравнение прямой линии, параллельной

оси абсцисс, так как tg β

= 0 и β = 0 (прямая II

на рис.3.2). Эта прямая пересекается с

осью y в точке с ординатой,

равной р. Прямые I и II

на рис.3.2 являются границами (пределами)

зависимости Р(≥1,n) = f(n),

т.е. p ≤ Р(≥1,n) ≤ np.

Исследования

каналов показали, что для реальных

каналов зависимости log

Р(≥1,n) = f(log

n) достаточно хорошо

аппроксимируются прямыми линиями при

числе элементов в комбинации от 1 до

500. Прямые, соответствующие этим

зависимостям, находятся между указанными

выше границами и имеют угол наклона β

< β1 (прямые III на

рис.3.2 с углами наклона β2 и β3).

Такой характер зависимости Р(≥1,n) = f

(n) является следствием

группового характера появления ошибок

в реальных каналах. Для описания

зависимости Р(≥1,n) = f (n)

достаточно определить значение двух

параметров: вероятности ошибки р и

углового коэффициента tg

β. Обозначим tg

β = 1 – α, тогда

log

Р(≥1,n)

= log p + (1 — α) log n

или

Р(≥1,n) = n1-α

p .

Если α=0, то tg

β = 1, что соответствует независимому

появлению ошибок. При этом Р(≥1,n) = np

(прямая I на рис.3.16). Если

α = 1, то tg β = 0, что

соответствует предельно групповому

характеру появления ошибок в реальных

каналах (прямые III на

рис.3.2). Параметр α характеризует степень

группирования ошибок и поэтому получил

название показателя группирования

ошибок. Показатель группирования

является важным параметром последовательности

ошибок.

Параметр α

определяется по статистическим данным.

Из выражения для log Р(≥1,n)

имеем:

.

Подставив исходные

значения Р(≥1,n), после преобразования

получим:

.

Для

вычисления параметра α по статистическим

данным последовательность ошибок

разбивают на подпоследовательности

длиной n, определяют число

искаженных комбинаций Вош(n)

и вычисляют значение α. Однако вычисление

параметра α при одном значении n

может дать значительную погрешность,

так как значения Вош(n)

на конечной выборке могут иметь случайные

выбросы. Для более точного вычисления

параметра α вычисляют ρ значений α при

ρ значениях n. По полученным

значениям αi

определяют параметр α как среднее

значение αi, т.е.

Значения

n берутся из интервала,

где np«1.

При

ρ=5÷10 погрешность вычисления параметра

α становится несущественной.

Значения

параметра α для различных каналов связи

приведены в табл. 3.1

Таблица

3.1

|

Тип |

Значение ρ |

Значение |

||

|

макс. |

мин. |

макс. |

мин. |

|

|

Кабельные |

10-4 |

10-6 |

0.7 |

0.5 |

|

Радиорелейные |

10-3 |

10-4 |

0.5 |

0.3 |

|

КВ радиотелеграфные |

10-1 |

10-3 |

0.4 |

0.3 |

Наибольшее

значение α принимает для телефонных

кабельных каналов, потому что

кратковременные прерывания в различных

промежуточных пунктах кабельной

магистрали приводят к появлению групп

с большой плотностью ошибок.

Меньшее

значение α имеет для радиорелейных

телефонных каналов, так как в них, наряду

с участками большой плотности, наблюдаются

участки с редкими ошибками, появляющимися

за счет повышения уровня шумов.

В

КВ радиотелеграфных каналах вследствие

замирания сигнала и воздействия помех

обычно наблюдаются не только пачки

ошибок, но и одиночные ошибки. Поэтому

показатель группирования принимает,

как правило, наименьшие значения.

Для

каналов тонального телеграфирования

обычно параметр α имеет такое же значение,

что и для кабельных телефонных каналов,

так как причины возникновения ошибок

одни и те же.

В. Распределение

ошибок в комбинациях различной длины

При оценке

эффективности блоковых корректирующих

кодов интерес представляет не только

вероятность появления n-элементных

искаженных комбинаций P(≥1,n),

но и вероятности появления комбинаций

с одной P(1,n),

двумя P(2,n)

и m ошибками P(m,n).

Под

вероятностью появления комбинаций

длины n c m

ошибками будем понимать

.

Очевидно, что:

.

Кроме того, для

оценки эффективности некоторых

корректирующих кодов необходимо знать

суммарную (накопленную) вероятность

появления искаженных комбинаций с m

и более ошибками:

.

Статистическая

вероятность появления n-элементных

комбинаций с m и более

ошибками определяется как отношение

числа комбинаций с m и

боле ошибками к общему числу комбинаций:

,

где В(i,n)

– число n-элементных

комбинаций, содержащих i

ошибок; В0(n) =

— общее число переданных n-элементных

комбинаций.

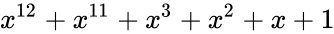

Рис.3.3

На рис. 3.3 в

логарифмическом масштабе показаны

графики Р(≥m,n) для

радиотелеграфного канала с параметрами

р = 1,37 · 10-2 и α = 0,4. Точками на этом

рисунке нанесены экспериментальные

значения Р(≥m,n), которые

на участке 1≤m≤n/3

достаточно хорошо аппроксимируются

прямыми линиями (сплошные линии).

Исследования зависимости Р(≥m,n)

= f(m) на

реальных каналах показали, что на участке

m<n/3 значения

Р(≥m,n) с ростом m

убывают медленно, что свидетельствует

о наличии искаженных комбинаций с

большим числом ошибок и является

следствием группового характера

появления ошибок в реальных. Скорость

убывания вероятности Р(≥m,n)

с ростом m различна для

различных каналов и определяется

степенью группирования ошибок. Достаточно

хорошая аппроксимация начальной части

зависимости log Р(≥m,n)

= f (log m)

прямыми линиями позволяет получить

приближенную формулу для вычисления

Р(≥m,n) при m<n/3

с использованием параметров p

и α:

На рис. 3.3 для

сравнения пунктирными линиями приведены

зависимости Р(≥m,n) =

f (m),

вычисленные для случая независимых

ошибок при том же значении р = 1.37

·10-2. В этом случае с увеличением

m вероятности Р(≥m,n)

уменьшаются значительно быстрее, чем

те же вероятности, полученные

экспериментально. Данный пример

показывает, что групповой характер

появления ошибок существенно влияет

на распределение их внутри комбинаций.

Соседние файлы в предмете [НЕСОРТИРОВАННОЕ]

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

Корректирующие коды «на пальцах»

Время на прочтение

11 мин

Количество просмотров 63K

Как нетрудно догадаться, ко всему этому причастны корректирующие коды. Собственно, ECC так и расшифровывается — «error-correcting code», то есть «код, исправляющий ошибки». А CRC — это один из алгоритмов, обнаруживающих ошибки в данных. Исправить он их не может, но часто это и не требуется.

Давайте же разберёмся, что это такое.

Для понимания статьи не нужны никакие специальные знания. Достаточно лишь понимать, что такое вектор и матрица, как они перемножаются и как с их помощью записать систему линейных уравнений.

Внимание! Много текста и мало картинок. Я постарался всё объяснить, но без карандаша и бумаги текст может показаться немного запутанным.

Каналы с ошибкой

Разберёмся сперва, откуда вообще берутся ошибки, которые мы собираемся исправлять. Перед нами стоит следующая задача. Нужно передать несколько блоков данных, каждый из которых кодируется цепочкой двоичных цифр. Получившаяся последовательность нулей и единиц передаётся через канал связи. Но так сложилось, что реальные каналы связи часто подвержены ошибкам. Вообще говоря, ошибки могут быть разных видов — может появиться лишняя цифра или какая-то пропасть. Но мы будем рассматривать только ситуации, когда в канале возможны лишь замены нуля на единицу и наоборот. Причём опять же для простоты будем считать такие замены равновероятными.

Ошибка — это маловероятное событие (а иначе зачем нам такой канал вообще, где одни ошибки?), а значит, вероятность двух ошибок меньше, а трёх уже совсем мала. Мы можем выбрать для себя некоторую приемлемую величину вероятности, очертив границу «это уж точно невозможно». Это позволит нам сказать, что в канале возможно не более, чем ошибок. Это будет характеристикой канала связи.

Для простоты введём следующие обозначения. Пусть данные, которые мы хотим передавать, — это двоичные последовательности фиксированной длины. Чтобы не запутаться в нулях и единицах, будем иногда обозначать их заглавными латинскими буквами (,

,

, …). Что именно передавать, в общем-то неважно, просто с буквами в первое время будет проще работать.

Кодирование и декодирование будем обозначать прямой стрелкой (), а передачу по каналу связи — волнистой стрелкой (

). Ошибки при передаче будем подчёркивать.

Например, пусть мы хотим передавать только сообщения и

. В простейшем случае их можно закодировать нулём и единицей (сюрприз!):

Передача по каналу, в котором возникла ошибка будет записана так:

Цепочки нулей и единиц, которыми мы кодируем буквы, будем называть кодовыми словами. В данном простом случае кодовые слова — это и

.

Код с утроением

Давайте попробуем построить какой-то корректирующий код. Что мы обычно делаем, когда кто-то нас не расслышал? Повторяем дважды:

Правда, это нам не очень поможет. В самом деле, рассмотрим канал с одной возможной ошибкой:

Какие выводы мы можем сделать, когда получили ? Понятно, что раз у нас не две одинаковые цифры, то была ошибка, но вот в каком разряде? Может, в первом, и была передана буква

. А может, во втором, и была передана

.

То есть, получившийся код обнаруживает, но не исправляет ошибки. Ну, тоже неплохо, в общем-то. Но мы пойдём дальше и будем теперь утраивать цифры.

Проверим в деле:

Получили . Тут у нас есть две возможности: либо это

и было две ошибки (в крайних цифрах), либо это

и была одна ошибка. Вообще, вероятность одной ошибки выше вероятности двух ошибок, так что самым правдоподобным будет предположение о том, что передавалась именно буква

. Хотя правдоподобное — не значит истинное, поэтому рядом и стоит вопросительный знак.

Если в канале связи возможна максимум одна ошибка, то первое предположение о двух ошибках становится невозможным и остаётся только один вариант — передавалась буква .

Про такой код говорят, что он исправляет одну ошибку. Две он тоже обнаружит, но исправит уже неверно.

Это, конечно, самый простой код. Кодировать легко, да и декодировать тоже. Ноликов больше — значит передавался ноль, единичек — значит единица.

Если немного подумать, то можно предложить код исправляющий две ошибки. Это будет код, в котором мы повторяем одиночный бит 5 раз.

Расстояния между кодами

Рассмотрим поподробнее код с утроением. Итак, мы получили работающий код, который исправляет одиночную ошибку. Но за всё хорошее надо платить: он кодирует один бит тремя. Не очень-то и эффективно.

И вообще, почему этот код работает? Почему нужно именно утраивать для устранения одной ошибки? Наверняка это всё неспроста.

Давайте подумаем, как этот код работает. Интуитивно всё понятно. Нолики и единички — это две непохожие последовательности. Так как они достаточно длинные, то одиночная ошибка не сильно портит их вид.

Пусть мы передавали , а получили

. Видно, что эта цепочка больше похожа на исходные

, чем на

. А так как других кодовых слов у нас нет, то и выбор очевиден.

Но что значит «больше похоже»? А всё просто! Чем больше символов у двух цепочек совпадает, тем больше их схожесть. Если почти все символы отличаются, то цепочки «далеки» друг от друга.

Можно ввести некоторую величину , равную количеству различающихся цифр в соответствующих разрядах цепочек

и

. Эту величину называют расстоянием Хэмминга. Чем больше это расстояние, тем меньше похожи две цепочки.

Например, , так как все цифры в соответствующих позициях равны, а вот

.

Расстояние Хэмминга называют расстоянием неспроста. Ведь в самом деле, что такое расстояние? Это какая-то характеристика, указывающая на близость двух точек, и для которой верны утверждения:

- Расстояние между точками неотрицательно и равно нулю только, если точки совпадают.

- Расстояние в обе стороны одинаково.

- Путь через третью точку не короче, чем прямой путь.

Достаточно разумные требования.

Математически это можно записать так (нам это не пригодится, просто ради интереса посмотрим):

.

Предлагаю читателю самому убедиться, что для расстояния Хэмминга эти свойства выполняются.

Окрестности

Таким образом, разные цепочки мы считаем точками в каком-то воображаемом пространстве, и теперь мы умеем находить расстояния между ними. Правда, если попытаться сколько нибудь длинные цепочки расставить на листе бумаги так, чтобы расстояния Хэмминга совпадали с расстояниями на плоскости, мы можем потерпеть неудачу. Но не нужно переживать. Всё же это особое пространство со своими законами. А слова вроде «расстояния» лишь помогают нам рассуждать.

Пойдём дальше. Раз мы заговорили о расстоянии, то можно ввести такое понятие как окрестность. Как известно, окрестность какой-то точки — это шар определённого радиуса с центром в ней. Шар? Какие ещё шары! Мы же о кодах говорим.

Но всё просто. Ведь что такое шар? Это множество всех точек, которые находятся от данной не дальше, чем некоторое расстояние, называемое радиусом. Точки у нас есть, расстояние у нас есть, теперь есть и шары.

Так, скажем, окрестность кодового слова радиуса 1 — это все коды, находящиеся на расстоянии не больше, чем 1 от него, то есть отличающиеся не больше, чем в одном разряде. То есть это коды:

Да, вот так странно выглядят шары в пространстве кодов.

А теперь посмотрите. Это же все возможные коды, которые мы получим в канале в одной ошибкой, если отправим ! Это следует прямо из определения окрестности. Ведь каждая ошибка заставляет цепочку измениться только в одном разряде, а значит удаляет её на расстояние 1 от исходного сообщения.

Аналогично, если в канале возможны две ошибки, то отправив некоторое сообщение , мы получим один из кодов, который принадлежит окрестности

радиусом 2.

Тогда всю нашу систему декодирования можно построить так. Мы получаем какую-то цепочку нулей и единиц (точку в нашей новой терминологии) и смотрим, в окрестность какого кодового слова она попадает.

Сколько ошибок может исправить код?

Чтобы код мог исправлять больше ошибок, окрестности должны быть как можно шире. С другой стороны, они не должны пересекаться. Иначе если точка попадёт в область пересечения, непонятно будет, к какой окрестности её отнести.

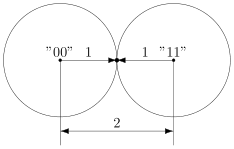

В коде с удвоением между кодовыми словами и

расстояние равно 2 (оба разряда различаются). А значит, если мы построим вокруг них шары радиуса 1, то они будут касаться. Это значит, точка касания будет принадлежать обоим шарам и непонятно будет, к какому из них её отнести.

Именно это мы и получали. Мы видели, что есть ошибка, но не могли её исправить.

Что интересно, точек касания в нашем странном пространстве у шаров две — это коды и

. Расстояния от них до центров равны единице. Конечно же, в обычно геометрии такое невозможно, поэтому рисунки — это просто условность для более удобного рассуждения.

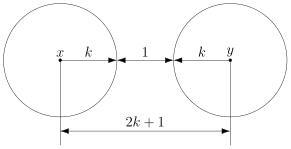

В случае кода с утроением, между шарами будет зазор.

Минимальный зазор между шарами равен 1, так как у нас расстояния всегда целые (ну не могут же две цепочки отличаться в полутора разрядах).

В общем случае получаем следующее.

Этот очевидный результат на самом деле очень важен. Он означает, что код с минимальным кодовым расстоянием будет успешно работать в канале с

ошибками, если выполняется соотношение

Полученное равенство позволяет легко определить, сколько ошибок будет исправлять тот или иной код. А сколько код ошибок может обнаружить? Рассуждения такие же. Код обнаруживает ошибок, если в результате не получится другое кодовое слово. То есть, кодовые слова не должны находиться в окрестностях радиуса

других кодовых слов. Математически это записывается так:

Рассмотрим пример. Пусть мы кодируем 4 буквы следующим образом.

Чтобы найти минимальное расстояние между различными кодовыми словами, построим таблицу попарных расстояний.

| A | B | C | D | |

|---|---|---|---|---|

| A | — | 3 | 3 | 4 |

| B | 3 | — | 4 | 3 |

| C | 3 | 4 | — | 3 |

| D | 4 | 3 | 3 | — |

Минимальное расстояние , а значит

, откуда получаем, что такой код может исправить до

ошибок. Обнаруживает же он две ошибки.

Рассмотрим пример:

Чтобы декодировать полученное сообщение, посмотрим, к какому символу оно ближе всего.

Минимальное расстояние получилось для символа , значит вероятнее всего передавался именно он:

Итак, этот код исправляет одну ошибку, как и код с утроением. Но он более эффективен, так как в отличие от кода с утроением здесь кодируется уже 4 символа.

Таким образом, основная проблема при построении такого рода кодов — так расположить кодовые слова, чтобы они были как можно дальше друг от друга, и их было побольше.

Для декодирования можно было бы использовать таблицу, в которой указывались бы все возможные принимаемые сообщения, и кодовые слова, которым они соответствуют. Но такая таблица получилась бы очень большой. Даже для нашего маленького кода, который выдаёт 5 двоичных цифр, получилось бы варианта возможных принимаемых сообщений. Для более сложных кодов таблица будет значительно больше.

Попробуем придумать способ коррекции сообщения без таблиц. Мы всегда сможем найти полезное применение освободившейся памяти.

Интерлюдия: поле GF(2)

Для изложения дальнейшего материала нам потребуются матрицы. А при умножении матриц, как известно мы складываем и перемножаем числа. И тут есть проблема. Если с умножением всё более-менее хорошо, то как быть со сложением? Из-за того, что мы работаем только с одиночными двоичными цифрами, непонятно, как сложить 1 и 1, чтобы снова получилась одна двоичная цифра. Значит вместо классического сложения нужно использовать какое-то другое.

Введём операцию сложения как сложение по модулю 2 (хорошо известный программистам XOR):

Умножение будем выполнять как обычно. Эти операции на самом деле введены не абы как, а чтобы получилась система, которая в математике называется полем. Поле — это просто множество (в нашем случае из 0 и 1), на котором так определены сложение и умножение, чтобы основные алгебраические законы сохранялись. Например, чтобы основные идеи, касающиеся матриц и систем уравнений по-прежнему были верны. А вычитание и деление мы можем ввести как обратные операции.

Множество из двух элементов с операциями, введёнными так, как мы это сделали, называется полем Галуа GF(2). GF — это Galois field, а 2 — количество элементов.

У сложения есть несколько очень полезных свойств, которыми мы будем пользоваться в дальнейшем.

Это свойство прямо следует из определения.

А в этом можно убедиться, прибавив к обеим частям равенства. Это свойство, в частности означает, что мы можем переносить в уравнении слагаемые в другую сторону без смены знака.

Проверяем корректность

Вернёмся к коду с утроением.

Для начала просто решим задачу проверки, были ли вообще ошибки при передаче. Как видно, из самого кода, принятое сообщение будет кодовым словом только тогда, когда все три цифры равны между собой.

Пусть мы приняли вектор-строку из трёх цифр. (Стрелочки над векторами рисовать не будем, так как у нас почти всё — это вектора или матрицы.)

Математически равенство всех трёх цифр можно записать как систему:

Или, если воспользоваться свойствами сложения в GF(2), получаем

Или

В матричном виде эта система будет иметь вид

где

Транспонирование здесь нужно потому, что — это вектор-строка, а не вектор-столбец. Иначе мы не могли бы умножать его справа на матрицу.

Будем называть матрицу проверочной матрицей. Если полученное сообщение — это корректное кодовое слово (то есть, ошибки при передаче не было), то произведение проверочной матрицы на это сообщение будет равно нулевому вектору.

Умножение на матрицу — это гораздо более эффективно, чем поиск в таблице, но у нас на самом деле есть ещё одна таблица — это таблица кодирования. Попробуем от неё избавиться.

Кодирование

Итак, у нас есть система для проверки

Её решения — это кодовые слова. Собственно, мы систему и строили на основе кодовых слов. Попробуем теперь решить обратную задачу. По системе (или, что то же самое, по матрице ) найдём кодовые слова.

Правда, для нашей системы мы уже знаем ответ, поэтому, чтобы было интересно, возьмём другую матрицу:

Соответствующая система имеет вид:

Чтобы найти кодовые слова соответствующего кода нужно её решить.

В силу линейности сумма двух решений системы тоже будет решением системы. Это легко доказать. Если и

— решения системы, то для их суммы верно

что означает, что она тоже — решение.

Поэтому если мы найдём все линейно независимые решения, то с их помощью можно получить вообще все решения системы. Для этого просто нужно найти их всевозможные суммы.

Выразим сперва все зависимые слагаемые. Их столько же, сколько и уравнений. Выражать надо так, чтобы справа были только независимые. Проще всего выразить .

Если бы нам не так повезло с системой, то нужно было бы складывая уравнения между собой получить такую систему, чтобы какие-то три переменные встречались по одному разу. Ну, или воспользоваться методом Гаусса. Для GF(2) он тоже работает.

Итак, получаем:

Чтобы получить все линейно независимые решения, приравниваем каждую из зависимых переменных к единице по очереди.

Всевозможные суммы этих независимых решений (а именно они и будут кодовыми векторами) можно получить так:

где равны либо нулю или единице. Так как таких коэффициентов два, то всего возможно

сочетания.

Но посмотрите! Формула, которую мы только что получили — это же снова умножение матрицы на вектор.

Строчки здесь — линейно независимые решения, которые мы получили. Матрица называется порождающей. Теперь вместо того, чтобы сами составлять таблицу кодирования, мы можем получать кодовые слова простым умножением на матрицу:

Найдём кодовые слова для этого кода. (Не забываем, что длина исходных сообщений должна быть равна 2 — это количество найденных решений.)

Итак, у нас есть готовый код, обнаруживающий ошибки. Проверим его в деле. Пусть мы хотим отправить 01 и у нас произошла ошибка при передаче. Обнаружит ли её код?

А раз в результате не нулевой вектор, значит код заподозрил неладное. Провести его не удалось. Ура, код работает!

Для кода с утроением, кстати, порождающая матрица выглядит очень просто:

Подобные коды, которые можно порождать и проверять матрицей называются линейными (бывают и нелинейные), и они очень широко применяются на практике. Реализовать их довольно легко, так как тут требуется только умножение на константную матрицу.

Ошибка по синдрому

Ну хорошо, мы построили код обнаруживающий ошибки. Но мы же хотим их исправлять!

Для начала введём такое понятие, как вектор ошибки. Это вектор, на который отличается принятое сообщение от кодового слова. Пусть мы получили сообщение , а было отправлено кодовое слово

. Тогда вектор ошибки по определению

Но в странном мире GF(2), где сложение и вычитание одинаковы, будут верны и соотношения:

В силу особенностей сложения, как читатель сам может легко убедиться, в векторе ошибки на позициях, где произошла ошибка будет единица, а на остальных ноль.

Как мы уже говорили раньше, если мы получили сообщение с ошибкой, то

. Но ведь векторов, не равных нулю много! Быть может то, какой именно ненулевой вектор мы получили, подскажет нам характер ошибки?

Назовём результат умножения на проверочную матрицу синдромом:

И заметим следующее

Это означает, что для ошибки синдром будет таким же, как и для полученного сообщения.

Разложим все возможные сообщения, которые мы можем получить из канала связи, по кучкам в зависимости от синдрома. Тогда из последнего соотношения следует, что в каждой кучке будут вектора с одной и той же ошибкой. Причём вектор этой ошибки тоже будет в кучке. Вот только как его узнать?

А очень просто! Помните, мы говорили, что у нескольких ошибок вероятность ниже, чем у одной ошибки? Руководствуясь этим соображением, наиболее правдоподобным будет считать вектором ошибки тот вектор, у которого меньше всего единиц. Будем называть его лидером.

Давайте посмотрим, какие синдромы дают всевозможные 5-элементные векторы. Сразу сгруппируем их и подчеркнём лидеров — векторы с наименьшим числом единиц.

В принципе, для корректирования ошибки достаточно было бы хранить таблицу соответствия синдрома лидеру.

Обратите внимание, что в некоторых строчках два лидера. Это значит для для данного синдрома два паттерна ошибки равновероятны. Иными словами, код обнаружил две ошибки, но исправить их не может.

Лидеры для всех возможных одиночных ошибок находятся в отдельных строках, а значит код может исправить любую одиночную ошибку. Ну, что же… Попробуем в этом убедиться.

Вектор ошибки равен , а значит ошибка в третьем разряде. Как мы и загадали.

Ура, всё работает!

Что же дальше?

Чтобы попрактиковаться, попробуйте повторить рассуждения для разных проверочных матриц. Например, для кода с утроением.

Логическим продолжением изложенного был бы рассказ о циклических кодах — чрезвычайно интересном подклассе линейных кодов, обладающим замечательными свойствами. Но тогда, боюсь, статья уж очень бы разрослась.

Если вас заинтересовали подробности, то можете почитать замечательную книжку Аршинова и Садовского «Коды и математика». Там изложено гораздо больше, чем представлено в этой статье. Если интересует математика кодирования — то поищите «Теория и практика кодов, контролирующих ошибки» Блейхута. А вообще, материалов по этой теме довольно много.

Надеюсь, когда снова будет свободное время, напишу продолжение, в котором расскажу про циклические коды и покажу пример программы для кодирования и декодирования. Если, конечно, почтенной публике это интересно.

Предположим, что в последовательности канала связи возможны случайные искажения отдельных знаков. Всюду далее в настоящей работе искажения в последовательности канала связи будем считать случайными. Целенаправленные искажения рассматривать не будем.

Искаженную последовательность будем обозначать

E’2M = {e’1,e’2,…,e’2M}, (3.3.1)

где

e’i = ei + δi (3.3.2)

В (3.3.2) δi – искажение, вносимое в последовательность канала связи в силу каких-либо внешних случайных причин.

Из искаженной последовательности канала связи (3.3.1) получаем искаженную последовательность открытого текста

B’2M = {b’1,b’2,…,b’2M} (3.3.3)

в которой

b’1 = e’1, b’2 = e’2 — π(e’1), b’i = e’i – (π(e’i-2 + e’i-1) — π(e’i-1)) (3.3.4)

Характерной особенностью закодированной последовательности является расстояние зависимости, означающее, что при раскодировании очередное значение bi раскодированного текста зависит только от трех значений в закодированном тексте: ei, ei-1 и ei-2. Таким образом, в случае наличия ошибки в i-м значении e’i закодированной последовательности эта ошибка при раскодировании может повлиять только на 3 значения при вычислении раскодированной последовательности:

b’i = e’i – (π(ei-2 + ei-1) — π(ei-1))

b’i+1 = ei+1 – (π(ei-1 + e’i) — π(e’i))

b’i+2 = ei+2 – (π(e’i + ei+1) — π(ei+1))

На все последующие значения раскодированного текста, начиная с bi+3, ошибка e’i не влияет.

Всюду далее в настоящей работе фраза «отсутствие иных искажений в пределах расстояния зависимости» для искаженного значения e’k = ek + δk, δk ≠ 0, будет означать, что выполняются два условия

1. e’k-2 = ek-2 и e’k-1 = ek-1,

2. e’k+2 = ek+2 и e’k+1 = ek+1,

т.е. искажений нет за два шага до, и за два шага после искаженного значения.

Пусть k – первое значение, при котором δk ≠ 0. Поскольку в этом случае

e’k-2 = ek-2 и e’k-1 = ek-1,

то из (3.3.4) следует, что в этом случае

b’k ≠ bk,

где bk – значение из декодированной неискаженной последовательности (3.2.5). Предположим, что k ϵ {3,4,…,2M}. Случай, когда k ϵ {1,2}, рассмотрим позже.

Рассмотрим далее способы выявления и исправления некоторых ошибок канала связи. Заметим, что единственным способом выявления ошибок будет наличие ненулевых значений на четных позициях при декодировке.

Следующая страница Предыдущая страница

Канальный уровень должен обнаруживать ошибки передачи данных, связанные с

искажением бит в принятом кадре данных или с потерей кадра, и по возможности их

корректировать.

Большая часть протоколов канального уровня выполняет только первую задачу —

обнаружение ошибок, считая, что корректировать ошибки, то есть повторно

передавать данные, содержавшие искаженную информацию, должны протоколы верхних

уровней. Так работают такие популярные протоколы локальных сетей, как Ethernet,

Token Ring, FDDI и другие. Однако существуют протоколы канального уровня, например

LLC2 или LAP-B, которые самостоятельно решают задачу восстановления искаженных

или потерянных кадров.

Очевидно, что протоколы должны работать наиболее эффективно в типичных

условиях работы сети. Поэтому для сетей, в которых искажения и потери кадров являются

очень редкими событиями, разрабатываются протоколы типа Ethernet, в которых не

предусматриваются процедуры устранения ошибок. Действительно, наличие процедур

восстановления данных потребовало бы от конечных узлов дополнительных

вычислительных затрат, которые в условиях надежной работы сети являлись бы

избыточными.

Напротив, если в сети искажения и потери случаются часто, то желательно уже

на канальном уровне использовать протокол с коррекцией ошибок, а не оставлять

эту работу протоколам верхних уровней. Протоколы верхних уровней, например

транспортного или прикладного, работая с большими тайм-аутами, восстановят

потерянные данные с большой задержкой. В глобальных сетях первых поколений,

например сетях Х.25, которые работали через ненадежные каналы связи, протоколы

канального уровня всегда выполняли процедуры восстановления потерянных и

искаженных кадров.

Поэтому нельзя считать, что один протокол лучше другого потому, что он

восстанавливает ошибочные кадры, а другой протокол — нет. Каждый протокол должен

работать в тех условиях, для которых он разработан.

Методы обнаружения ошибок

Все методы обнаружения ошибок основаны на передаче в составе кадра данных

служебной избыточной информации, по которой можно судить с некоторой степенью

вероятности о достоверности принятых данных. Эту служебную информацию принято

называть контрольной суммой или (последовательностью

контроля кадра — Frame Check Sequence, FCS). Контрольная сумма вычисляется

как функция от основной информации, причем необязательно только путем суммирования.

Принимающая сторона повторно вычисляет контрольную сумму кадра по известному

алгоритму и в случае ее совпадения с контрольной суммой, вычисленной передающей

стороной, делает вывод о том, что данные были переданы через сеть корректно.

Существует несколько распространенных алгоритмов вычисления контрольной

суммы, отличающихся вычислительной сложностью и способностью обнаруживать

ошибки в данных.

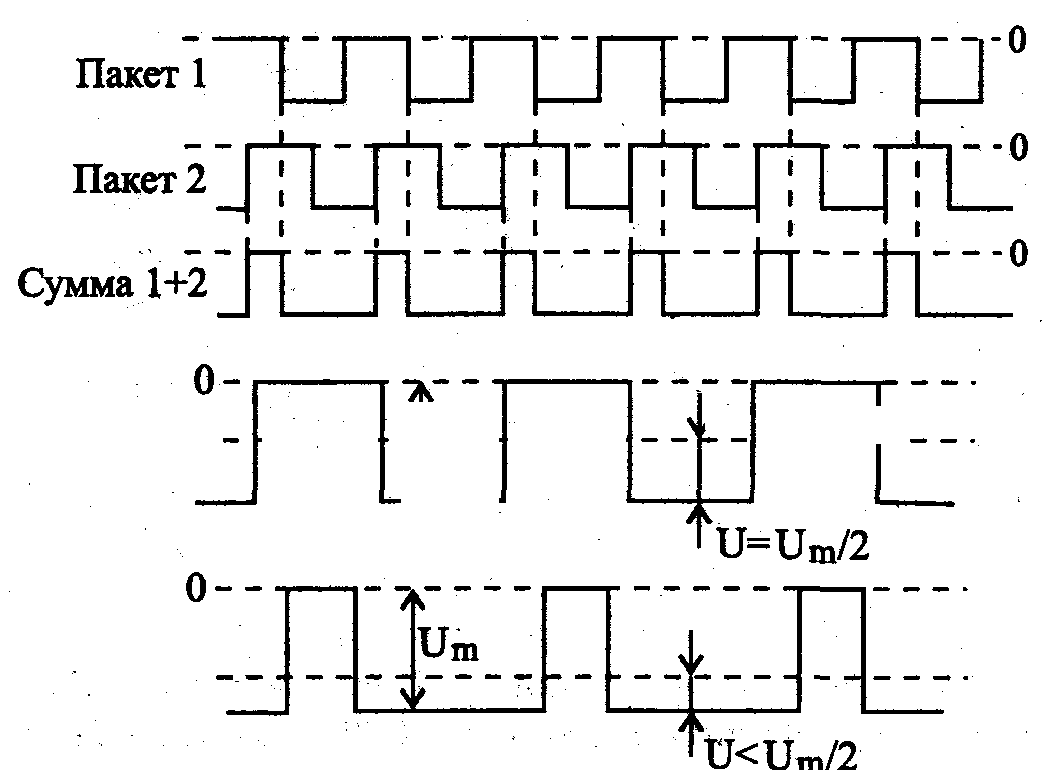

Контроль по паритету представляет собой наиболее простой метод контроля данных. В то же

время это наименее мощный алгоритм контроля, так как с его помощью можно

обнаружить только одиночные ошибки в проверяемых данных. Метод заключается в

суммировании по модулю 2 всех бит контролируемой информации. Например, для

данных 100101011 результатом контрольного суммирования будет значение 1.

Результат суммирования также представляет собой один бит данных, который

пересылается вместе с контролируемой информацией. При искажении при пересылке

любого одного бита исходных данных (или контрольного разряда) результат суммирования

будет отличаться от принятого контрольного разряда, что говорит об ошибке.

Однако двойная ошибка, например 110101010, будет неверно принята за корректные

данные. Поэтому контроль по паритету применяется к небольшим порциям данных,

как правило, к каждому байту, что дает коэффициент избыточности для этого

метода 1/8. Метод редко применяется в вычислительных сетях из-за его большой

избыточности и невысоких диагностических способностей.

Вертикальный и горизонтальный контроль по паритету представляет собой модификацию

описанного выше метода. Его отличие состоит в том, что исходные данные

рассматриваются в виде матрицы, строки которой составляют байты данных.

Контрольный разряд подсчитывается отдельно для каждой строки и для каждого

столбца матрицы. Этот метод обнаруживает большую часть двойных ошибок, однако

обладает еще большей избыточностью. На практике сейчас также почти не

применяется.

Циклический избыточный контроль (Cyclic Redundancy Check, CRC) является в настоящее время наиболее

популярным методом контроля в вычислительных сетях (и не только в сетях,

например, этот метод широко применяется при записи данных на диски и дискеты).

Метод основан на рассмотрении исходных данных в виде одного многоразрядного

двоичного числа. Например, кадр стандарта Ethernet, состоящий из 1024 байт,

будет рассматриваться как одно число, состоящее из 8192 бит. В качестве

контрольной информации рассматривается остаток от деления этого числа на

известный делитель R. Обычно в качестве делителя выбирается семнадцати- или тридцати

трехразрядное число, чтобы остаток от деления имел длину 16 разрядов (2 байт)

или 32 разряда (4 байт). При получении кадра данных снова вычисляется остаток

от деления на тот же делитель R, но при этом к данным кадра добавляется и

содержащаяся в нем контрольная сумма. Если остаток от деления на R равен нулю1 (1 Существуетнесколько

модифицированная процедура вычисления остатка, приводящая к получению в случае

отсутствия ошибок известного ненулевого остатка, что является более надежным

показателем корректности.), то делается вывод об отсутствии ошибок в полученном

кадре, в противном случае кадр считается искаженным.

Этот метод обладает более высокой вычислительной сложностью, но его

диагностические возможности гораздо выше, чем у методов контроля по паритету.

Метод CRC обнаруживает все одиночные ошибки, двойные ошибки и ошибки в нечетном

числе бит. Метод обладает также невысокой степенью избыточности. Например, для

кадра Ethernet размером в 1024 байт контрольная информация длиной в 4 байт

составляет только 0,4 %.

Методы восстановления искаженных и потерянных кадров

Методы коррекции ошибок в вычислительных сетях основаны на повторной

передаче кадра данных в том случае, если кадр теряется и не доходит до адресата

или приемник обнаружил в нем искажение информации. Чтобы убедиться в

необходимости повторной передачи данных, отправитель нумерует отправляемые

кадры и для каждого кадра ожидает от приемника так называемой положительной

квитанции — служебного кадра, извещающего о том, что исходный кадр был

получен и данные в нем оказались корректными. Время этого ожидания ограничено —

при отправке каждого кадра передатчик запускает таймер, и, если по его

истечении положительная квитанция на получена, кадр считается утерянным.

Приемник в случае получения кадра с искаженными данными может отправить отрицательную

квитанцию — явное указание на то, что данный кадр нужно передать

повторно.

Существуют два подхода к организации процесса обмена квитанциями: с

простоями и с организацией «окна».

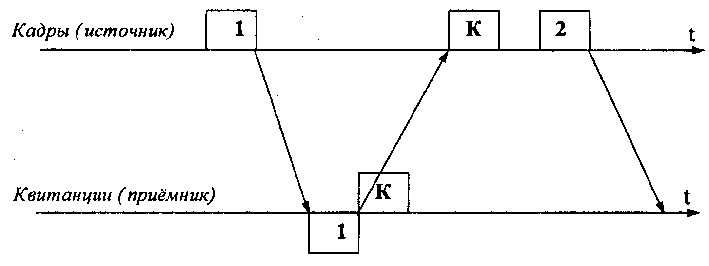

Метод с простоями (Idle Source) требует, чтобы источник, пославший кадр, ожидал получения квитанции

(положительной или отрицательной) от приемника и только после этого посылал

следующий кадр (или повторял искаженный). Если же квитанция не приходит в

течение тайм-аута, то кадр (или квитанция) считается утерянным и его передача

повторяется. На рис. 2.24, а видно, что в этом случае производительность обмена

данными существенно снижается, — хотя передатчик и мог бы послать следующий

кадр сразу же после отправки предыдущего, он обязан ждать прихода квитанции.

Снижение производительности этого метода коррекции особенно заметно на

низкоскоростных каналах связи, то есть в территориальных сетях.

Рис. 2.24. Методы восстановления искаженных и

потерянных кадров

Второй метод называется методом «скользящего окна» (sliding

window). В этом методе для повышения коэффициента использования линии

источнику разрешается передать некоторое количество кадров в непрерывном

режиме, то есть в максимально возможном для источника темпе, без получения на

эти кадры положительных ответных квитанций. (Далее, где это не искажает

существо рассматриваемого вопроса, положительные квитанции для краткости будут

называться просто «квитанциями».) Количество кадров, которые разрешается

передавать таким образом, называется размером окна. Рисунок 2.24, б

иллюстрирует данный метод для окна размером в W кадров.

В начальный момент, когда еще не послано ни одного кадра, окно определяет

диапазон кадров с номерами от 1 до W включительно. Источник начинает передавать

кадры и получать в ответ квитанции. Для простоты предположим, что квитанции

поступают в той же последовательности, что и кадры, которым они соответствуют.

В момент t1 при получении первой квитанции К1 окно сдвигается

на одну позицию, определяя новый диапазон от 2 до (W+1).

Процессы отправки кадров и получения квитанций идут достаточно независимо

друг от друга. Рассмотрим произвольный момент времени tn, когда источник

получил квитанцию на кадр с номером n. Окно сдвинулось вправо и определило

диапазон разрешенных к передаче кадров от (n+1) до (W+n). Все множество кадров,

выходящих из источника, можно разделить на перечисленные ниже группы (рис.

2.24, б).

- Кадры с номерами от 1 доп. уже были отправлены и квитанции на них

получены, то есть они находятся за пределами окна слева. - Кадры, начиная с номера (п+1) и кончая номером

(W+n), находятся в пределах окна и

потому могут быть отправлены не дожидаясь прихода какой-либо квитанции.

Этот диапазон может быть разделен еще на два поддиапазона: - кадры с номерами от (n+1) до

т, которые уже отправлены, но квитанции на них еще не получены; - кадры с номерами от m до

(W+n), которые пока не отправлены, хотя запрета на это нет. - Все кадры с номерами, большими или равными

(W+n+1), находятся за пределами окна

справа и поэтому пока не могут быть отправлены.

Перемещение окна вдоль последовательности номеров кадров показано на рис.

2.24, в. Здесь t0 — исходный момент, t1 и tn —

моменты прихода квитанций на первый и n-й кадр соответственно. Каждый раз,

когда приходит квитанция, окно сдвигается влево, но его размер при этом не

меняется и остается равным W. Заметим, что хотя в данном примере размер окна в

процессе передачи остается постоянным, в реальных протоколах (например, TCP)

можно встретить варианты данного алгоритма с изменяющимся размером окна.

Итак, при отправке кадра с номером n источнику разрешается передать еще W-1

кадров до получения квитанции на кадр n, так что в сеть последним уйдет кадр с

номером (W+n-1). Если же за это время квитанция на кадр n так и не пришла, то

процесс передачи приостанавливается, и по истечении некоторого тайм-аута кадр n

(или квитанция на него) считается утерянным, и он передается снова.

Если же поток квитанций поступает более-менее регулярно, в пределах допуска

в W кадров, то скорость обмена достигает максимально возможной величины для

данного канала и принятого протокола.

Метод скользящего окна более сложен в реализации, чем метод с простоями,

так как передатчик должен хранить в буфере все кадры, на которые пока не

получены положительные квитанции. Кроме того, требуется отслеживать несколько

параметров алгоритма: размер окна W, номер кадра, на который получена

квитанция, номер кадра, который еще можно передать до получения новой

квитанции.

Приемник может не посылать квитанции на каждый принятый корректный кадр.

Если несколько кадров пришли почти одновременно, то приемник может послать

квитанцию только на последний кадр. При этом подразумевается, что все

предыдущие кадры также дошли благополучно.

Некоторые методы используют отрицательные квитанции. Отрицательные

квитанции бывают двух типов — групповые и избирательные. Групповая квитанция

содержит номер кадра, начиная с которого нужно повторить передачу всех кадров,

отправленных передатчиком в сеть. Избирательная отрицательная квитанция требует

повторной передачи только одного кадра.

Метод скользящего окна реализован во многих протоколах: LLC2, LAP-B, X.25,

TCP, Novell NCP Burst Mode.

Метод с простоями является частным случаем метода скользящего окна, когда

размер окна равен единице.

Метод скользящего окна имеет два параметра, которые могут заметно влиять на

эффективность передачи данных между передатчиком и приемником, — размер окна и

величина тайм-аута ожидания квитанции. В надежных сетях, когда кадры искажаются

и теряются редко, для повышения скорости обмена данными размер окна нужно

увеличивать, так как при этом передатчик будет посылать кадры с меньшими

паузами. В ненадежных сетях размер окна следует уменьшать, так как при частых

потерях и искажениях кадров резко возрастает объем вторично передаваемых через

сеть кадров, а значит, пропускная способность сети будет расходоваться во

многом вхолостую — полезная пропускная способность сети будет падать.

Выбор тайм-аута зависит не от надежности сети, а от задержек передачи

кадров сетью.

Во многих реализациях метода скользящего окна величина окна и тайм-аут

выбираются адаптивно, в зависимости от текущего состояния сети.

В предыдущей лекции мы выяснили, что на

физическом уровне происходит

непосредственно передача битов по

проводам. Однако реальная линия связи

состоит не только из кабеля, но еще

включает дополнительное оборудование:

маршрутизаторы, коммутаторы и т.п. Это

оборудование помогает управлять

передачей информации в сети определенной

топологии от компьютера к компьютеру.

Задачей качественного, быстрого и

надежного установления соединения

компьютеров с помощью такого рода

оборудования и занимается канальный

уровень.

Рассматривая

модель OSI, мы выяснили, что канальный

уровень оперирует кадрамиданных,

поскольку работает с компьютерами,

которые не обмениваются информацией

по битно. Кадры образуются определенным

набором бит данных. Они содержат в себе,

как минимум, адрес получателя, и

отправляются узлом-источником для

передачи по кабелю методами физического

уровня, затем оборудование сети, в

зависимости от ее топологии, распознает

— кому эти кадры предназначены, и

отправляет их по кабелю к узлу-приемнику.

Таким образом, канальный уровень — это

по сути логика установки соединений в

сети. С одной стороны он привязан к

физическому уровню, то есть к типам

используемых линий связи и методам

передач физического уровня. Но с другой

стороны он связан с сетевым уровнем,

который уже управляет передачей

информации между локальными сетями.

На

канальном уровне для каждой топологии

сети имеются свои правила работы —

протоколы. Если на физическом уровне

не решаются вопросы какой компьютер и

когда может использовать кабель линии

связи, то на канальном уровне важно

обеспечить качественную доставку кадра

от узла к узлу. Именно на канальном

уровне происходит «борьба за кабель»,за доставку информации к нужному узлу

сети, он занимается проблемами

взаимодействия станций друг с другом,

обеспечением гарантии доставки кадра

информации к станции в любой из

используемой топологии сети.

В этой

лекции мы поговорим в общем плане о

форматах кадров, рассмотрим способы

передачи данных на канальном уровне,

методы управления обменом информации

в сети с определенной топологией и т.д.

6.1. Структура типичного кадра компьютерной

сети.

Информация

в локальных сетях предается отдельными

порциями, называемыми в различных

источниках кадрами, пакетами илиблоками. Использование кадров

связано с тем, что в сети одновременно

может происходить несколько сеансов

связи, т.е. в течении одного и того

интервала времени могут идти два или

больше процессов передачи данных между

абонентами. Кадры (пакеты) собственно

и позволяют разделить во времени сеть

между передающими абонентами и уравнять

в правах доступа всех абонентов и

обеспечить для всех абонентов интегральную

скорость передачи информации. Длина

кадра зависит от типа сети и составляет

от 10 байт – до 10 Кбайт. Важно делить

информацию на кадры и для контроля

правильности передачи информации. Кадры

имеют преимущества пред побайтовой

(8бит) или пословной (16 бит и 32 бита)

передачей, т.к. при этом уменьшается

количество служебной информации и

увеличивается полезная загрузка сети.

Структура

кадра определяется аппаратурными

особенностями данной сети, выбранной

топологией и типом среды передачи

информации, а также существенно зависит

от используемого протокола (порядка

обмена информацией).

Типичный

кадр содержит в себе следующие основные

поля:

-

стартовая

комбинацияили преамбула — обеспечивает

настройку аппаратуры адаптера на прием

и обработку кадров, может отсутствовать

или сводится к одному стартовому биту; -

сетевой

адрес(идентификатор) принимающего

абонента — индивидуальный или групповой

номер, присвоенный принимающему абоненту

в сети, позволяющему приемнику распознать

кадр, адресованный ему лично, группе,

или всем абонентам сети; -

сетевой

адрес(идентификатор) предающего

абонента — индивидуальный или групповой

номер, присвоенный передающему абоненту,

информирует принимающего абонента,

откуда пришел данный кадр, включение

в кадр этого идентификатора необходимо,

если приемнику могут попеременно

приходить кадры от разных передатчиков; -

служебная

информация— указывает на тип кадра,

его номер, размер, формат, маршрут

доставки и т.д.; -

данные— собственно предаваемая информация.

Существуют управляющие кадры (сетевые

команды – начало и конец связи,

подтверждение приема кадра и т.д.), в

которых это поле отсутствует и

информационные – поле данных имеется; -

контрольная

суммакадра — числовой код, формируемый

передатчиком по определенным правилам

и содержащий в свернутом виде информацию

обо всем кадре, используется для проверки

правильности передачи кадра на приемном

конце. Приемник повторяя вычисления

сделанные передатчиком сравнивает

результат с контрольной суммой и делает

вывод о правильности или ошибочности

передачи кадра. -

стоповая

комбинация— информирует принимающего

абонента об окончании кадра, обеспечивает

выход аппаратуры из состояния приема.

Поле может отсутствовать, если

используется самосинхронизирующийся

код, позволяющий детектировать факт

передачи кадра.

Рис. 6.1. Структура пакета

1,2,3,4 —

образуют начальное управляющее поле,

5 — поле данных, 6,7- конечное управляющее

поле.

-

Передача

кадров на канальном уровне

При

передаче кадров данных на канальном

уровне используются как дейтаграммные

процедуры, работающие без становления

соединения(connectionless), так и процедурыс предварительным установлением

логического соединения (connection-oriented).

При дейтаграммной передаче кадр

посылается в сеть «без предупреждения»,

и никакой ответственности за его утерю

протокол не несет. Предполагается, что

сеть всегда готова принять кадр от

конечного узла. Дейтаграммный метод

работает быстро, так как никаких

предварительных действий перед отправкой

данных не выполняется. Однако при таком

методе трудно организовать в рамках

протокола отслеживание факта доставки

кадра узлу назначения. Этот метод не

гарантирует доставку пакета.

Передача с установлением соединения

более надежна, но требует больше времени

для передачи данных и вычислительных

затрат от конечных узлов. В этом случае

узлу-получателю отправляется служебный

кадр специального формата с предложением

установить соединение. Если узел-получатель

согласен с этим, то он посылает в ответ

другой служебный кадр, подтверждающий

установление соединения и предлагающий

для данного логического соединения

некоторые параметры, например идентификатор

соединения,максимальное значение

поля данных кадров, которые будут

использоваться в рамках данного

соединения, и т. п. Узел-инициатор

соединения может завершить процесс

установления соединения отправкой

третьего служебного кадра, в котором

сообщит, что предложенные параметры

ему подходят. На этом логическое

соединение считается установленным, и

в его рамках можно передавать информационные

кадры с пользовательскими данными.

Рис 6.2 Пример обмена кадрами при сеансе

связи

После

передачи некоторого законченного набора

данных, например определенного файла,

узел инициирует разрыв данного логического

соединения, посылая соответствующий

служебный кадр.

Заметим,

что, в отличие от протоколов дейтаграммного

типа, которые поддерживают только один

тип кадра — информационный, протоколы,

работающие по процедуре с установлением

соединения, должны поддерживать несколько

типов кадров — служебные, для установления

(и разрыва) соединения, и информационные,

переносящие собственно пользовательские

данные.

В общем

случае логическое соединение обеспечивает

передачу данных как в одном направлении

— от инициатора соединения, так и в обоих

направлениях.

6.3.Методы гарантии

доставки кадров информации

При

установке соединения не маловажным

вопросом становится обеспечение гарантии

доставки кадра и обнаружение ошибок.

Рассмотрим

общие подходы решению проблемы гарантии

доставки кадров. Для того, чтобы

гарантировать доставку всех кадров,

надо обеспечить такой режим установки

соединения, при котором можно было бы

в любой момент времени повторить

отосланный ранее кадр, в случае обнаружения

его потери или искажения. Чтобы убедиться

в необходимости повторной передачи

данных, отправитель нумерует отправляемые

кадры и для каждого кадра ожидает от

приемника так называемой положительной

квитанции— служебного кадра, извещающего

о том, что исходный кадр был получен и

данные в нем оказались корректными.

Время этого ожидания ограничено — при

отправке каждого кадра передатчик

запускает таймер, и, если по его истечении

положительная квитанция не получена,

кадр считается утерянным.

Приемник

в случае получения кадра с искаженными

данными может отправить отрицательную

квитанцию — явное указание на то, что

данный кадр нужно передать повторно.

В итоге,

путем обмена такого рода квитанциями,

можно определить есть ли утечки информации

в сети, и не просто определить, а обеспечить

ее повторную передачу в случае каких-либо

сбоев. Таким образом, канальный уровень

обеспечивает гарантированную доставку

кадров.

Организацией процесса обмена квитанциями

занимается метод скользящего окна.

Перед тем как рассмотреть этот, сначала

познакомится с частным случаем этого

метода, который называетсяметод с

простоями.

Метод с простоями (Idle Source)требует,

чтобы источник, пославший кадр, ожидал

получения квитанции (положительной или

отрицательной) от приемника и только

после этого посылал следующий кадр (или

повторял искаженный). Если же квитанция

не приходит в течение тайм-аута, то кадр

(или квитанция) считается утерянным и

его передача повторяется.

Рис.

6.3 Обмен кадрами и квитанциями при методе

с простоями

На

рисунке видно, что в этом случае

производительность обмена данными

существенно снижается, — хотя передатчик

и мог бы послать следующий кадр сразу

же после отправки предыдущего, он обязан

ждать прихода квитанции. Иногда

использование такого метода может

привести к тому, что, что время ожидания

квитанции будет существенно превышать

время посылки сообщения. Снижение

производительности этого метода

коррекции особенно заметно на

низкоскоростных каналах связи

Метод скользящего окна (sliding window)

работает гораздо эффективней. Для

повышения коэффициента использования

линии источнику разрешается передать

некоторое количество кадров в непрерывном

режиме, то есть в максимально возможном

для источника темпе, без получения на

эти кадры положительных ответных

квитанций. (Далее, где это не искажает

существо рассматриваемого вопроса,

положительные квитанции для краткости

будут называться просто квитанциями.)

Количество кадров, которые разрешается

передавать в непрерывном режиме,

называется размером окна.

Рис.

6.4 Обмен кадрами квитанциями при методе

скользящего окна

На

рис.6.4. показан метод скользящего окна

для окна размером в W кадров. В начальный

момент, когда еще не послано ни одного

кадра, окно определяет диапазон кадров

с номерами от 1 до W включительно. Источник

начинает передавать кадры и получать

в ответ квитанции. Для простоты

предположим, что квитанции поступают

в той же последовательности, что и кадры,

которым они соответствуют. В определенный

момент t1 при получении первой квитанции

окно сдвигается на одну позицию, определяя

новый диапазон от 2 до (W+1). Процессы

отправки кадров и получения квитанций

идут достаточно независимо друг от

друга. Если допустим, что в произвольный

момент времени tn источник получил

квитанцию на кадр с номером n. Окно

сдвинулось вправо и определило диапазон

разрешенных к передаче кадров от (n+1) до

(W+n). Все множество кадров, выходящих из

источника, можно разделить на перечисленные

ниже группы:

1. Кадры

с номерами от 1 до n — уже были отправлены

и квитанции на них получены, то есть они

находятся за пределами окна слева.

2. Кадры,

начиная с номера (n+1) и кончая номером

(W+n) , находятся в пределах окна и потому

могут быть отправлены не дожидаясь

прихода какой-либо квитанции. Этот

диапазон может быть разделен еще на два

поддиапазона:

кадры с номерами от (n+1) до m, которые уже

отправлены, но квитанции на них еще не

получены;

кадры с номерами от m до (W+n) , которые

пока не отправлены, хотя запрета на это

нет.

3.Все

кадры с номерами, большими или равными

(W+n+1) , находятся за пределами окна справа

и поэтому пока не могут быть отправлены.

Каждый

раз, когда приходит квитанция, окно

сдвигается влево, но его размер при этом

не меняется и остается равным W. Заметим,

что хотя в данном примере размер окна

в процессе передачи остается постоянным,

в реальных протоколах можно встретить

варианты данного алгоритма с изменяющимся

размером окна.

Итак,

при отправке кадра с номером n источнику

разрешается передать еще W-1 кадров до

получения квитанции на кадр n, так что

в сеть последним уйдет кадр с номером

(W+n-1) .

Если

же за это время квитанция на кадр n так

и не пришла, то процесс передачи

приостанавливается, и по истечении

некоторого тайм-аута кадр n (или квитанция

на него) считается утерянным, и он

передается снова.

Если

же поток квитанций поступает более-менее

регулярно, в пределах допуска в W кадров,

то скорость обмена достигает максимально

возможной величины для данного канала

и принятого протокола.

Метод скользящего окна более сложен в

реализации, чем метод с простоями, так

как передатчик должен хранить в буфере

все кадры, на которые пока не получены

положительные квитанции. Кроме того,

требуется отслеживать несколько

параметров алгоритма: размер окна W,

номер кадра, на который получена

квитанция, номер кадра, который еще

можно передать до получения новой

квитанции.

Приемник

может не посылать квитанции на каждый

принятый корректный кадр. Если несколько

кадров пришли почти одновременно, то

приемник может послать квитанцию только

на последний кадр. При этом подразумевается,

что все предыдущие кадры также дошли

благополучно.

Некоторые

методы используют отрицательные

квитанции. Отрицательные квитанции

бывают двух типов — групповые и

избирательные. Групповая квитанция

содержит номер кадра, начиная с которого

нужно повторить передачу всех кадров,

отправленных передатчиком в сеть.

Избирательная отрицательная квитанция

требует повторной передачи только

одного кадра.

Метод скользящего окна имеет два

параметра, которые могут заметно влиять

на эффективность передачи данных между

передатчиком и приемником, — размер окна

и величина тайм-аута ожидания квитанции.

В

надежных сетях, когда кадры искажаются

и теряются редко, для повышения скорости

обмена данными размер окна нужно

увеличивать, так как при этом передатчик

будет посылать кадры с меньшими паузами.

В ненадежных сетях размер окна следует

уменьшать, так как при частых потерях

и искажениях кадров резко возрастает

объем вторично передаваемых через сеть

кадров, а значит, пропускная способность

сети будет расходоваться во многом

вхолостую — полезная пропускная

способность сети будет падать.

Выбор

тайм-аута зависит не от надежности сети,

а от задержек передачи кадров сетью. Во

многих реализациях метода скользящего

окна величина окна и тайм-аут выбираются

адаптивно, в зависимости от текущего

состояния сети.

6.4. Методы обнаружения ошибок на

канальному уровне.

После

того, как мы выяснили, какими средствами

располагает канальный уровень для

коррекции ошибок при передаче, очевидно,

нам нужно познакомится и с его методами

их обнаружения.

Канальный уровень должен обнаруживать

ошибки передачи данных, связанные с

искажением бит в принятом кадре данных

или с потерей кадра, и по возможности

их корректировать.

Большая

часть протоколов канального уровня

выполняет только первую задачу —

обнаружение ошибок, считая, что

корректировать ошибки, то есть повторно

передавать данные, содержавшие искаженную

информацию, должны протоколы верхних

уровней.

Однако

существуют протоколы канального уровня,

которые самостоятельно решают задачу

восстановления искаженных или потерянных

кадров.

Очевидно,

что протоколы должны работать наиболее

эффективно в типичных условиях работы

сети. Поэтому для сетей, в которых

искажения и потери кадров являются

очень редкими событиями, разрабатываются

протоколы, в которых не предусматриваются

процедуры устранения ошибок. Действительно,

наличие процедур восстановления данных

потребовало бы от конечных узлов

дополнительных вычислительных затрат,

которые в условиях надежной работы сети

являлись бы избыточными.

Напротив,

если в сети искажения и потери случаются

часто, то желательно уже на канальном

уровне использовать протокол с коррекцией

ошибок, а не оставлять эту работу

протоколам верхних уровней. Протоколы

верхних уровней, например транспортного

или прикладного, работая с большими

тайм-аутами, восстановят потерянные

данные с большой задержкой.

Поэтому

нельзя считать, что один протокол лучше

другого потому, что он восстанавливает

ошибочные кадры, а другой протокол —

нет. Каждый протокол должен работать в

тех условиях, для которых он разработан.

Все методы обнаружения ошибок на

канальном уровне основаны на передаче

в составе кадра данных служебной

избыточной информации, по которой можно

судить с некоторой степенью вероятности

о достоверности принятых данных. Эту

служебную информацию принято называть

контрольной суммой или (последовательностью

контроля кадра — Frame Check Sequence, FCS).

Контрольная сумма вычисляется как

функция от основной информации, причем

необязательно только путем суммирования.

Принимающая сторона повторно вычисляет

контрольную сумму кадра по известному

алгоритму и в случае ее совпадения с

контрольной суммой, вычисленной

передающей стороной, делает вывод о

том, что данные были переданы через сеть

корректно.

Существует

несколько распространенных алгоритмов

вычисления контрольной суммы, отличающихся

вычислительной сложностью и способностью

обнаруживать ошибки в данных.

Контроль по паритету . Этот метод

представляет собой наиболее простой

метод контроля данных и наименее мощный

алгоритм контроля, так как с его помощью

можно обнаружить только одиночные

ошибки в проверяемых данных. Метод

заключается в суммировании по модулю

2 всех бит контролируемой информации.

Например, для данных 100101011 результатом

контрольного суммирования будет значение

1.

Результат

суммирования также представляет собой

один бит данных, который пересылается

вместе с контролируемой информацией.

При искажении при пересылке любого

одного бита исходных данных (или

контрольного разряда) результат

суммирования будет отличаться от

принятого контрольного разряда, что

говорит об ошибке.

Однако

двойная ошибка, например 110101010, будет

неверно принята за корректные данные.

Поэтому контроль по паритету применяется

к небольшим порциям данных, как правило,

к каждому байту, что дает коэффициент

избыточности для этого метода 1/8. Метод

редко применяется в вычислительных

сетях из-за его большой избыточности и

невысоких диагностических способностей.

Вертикальный и горизонтальный контроль

по паритетупредставляет собой

модификацию описанного выше метода.

Его отличие состоит в том, что исходные

данные рассматриваются в виде матрицы,

строки которой составляют байты данных.

Контрольный разряд подсчитывается

отдельно для каждой строки и для каждого

столбца матрицы.

Рис.

6.5 Метод вертикального и горизонтального

контроля по паритету

Этот

метод обнаруживает большую часть двойных

ошибок, однако обладает еще большей

избыточностью. На практике сейчас также

почти не применяется.

Циклический избыточный контроль

(Cyclic Redundancy Check, CRC) Этот метод является

в настоящее время наиболее популярным

методом контроля в вычислительных сетях

(и не только в сетях, например, этот метод

широко применяется при записи данных

на диски и дискеты). Метод основан на

рассмотрении исходных данных в виде

одного многоразрядного двоичного числа.

Например, кадр, состоящий из 1024 байт,

будет рассматриваться как одно число,

состоящее из 8192 бит. В качестве контрольной

информации рассматривается остаток от

деления этого числа на известный делитель

R. Обычно в качестве делителя выбирается

семнадцати- или тридцати трехразрядное

число, чтобы остаток от деления имел

длину 16 разрядов (2 байт) — CRC16, или 32

разряда (4 байт) — CRC32.

При

получении кадра данных снова вычисляется

остаток от деления на тот же делитель

R, но при этом к данным кадра добавляется

и содержащаяся в нем контрольная сумма.

Если остаток от деления на R равен нулю,

то делается вывод об отсутствии ошибок

в полученном кадре, в противном случае

кадр считается искаженным. Этот метод

обладает более высокой вычислительной

сложностью, но его диагностические

возможности гораздо выше, чем у методов

контроля по паритету. Метод CRC обнаруживает

все одиночные ошибки, двойные ошибки и

ошибки в нечетном числе бит. Метод

обладает также невысокой степенью

избыточности. Например, для кадра

размером в 1024 байт контрольная информация

длиной в 4 байт составляет только 0,4 %.

-

Адресация

пакетов.

Каждый

абонент (узел) локальной сети должен

иметь свой уникальный адрес (идентификатор,

МАС-адрес), чтобы ему можно было адресовать

пакеты.

Существуют

две основные системы присвоения адресам

абонентам:

1.При установке сети каждому абоненту

присваивается аппаратно (с помощью

переключателей на плате адаптера) или

программно. При этом количество разрядов

адреса определяется как 2n>Nmax,

где n — количество разрядов адреса;Nmax– максимально возможное число абонентов

сети (Например, n=8, еслиNmax=255,

один адрес используется для адресации

пакетов всем абонентам сети –

широковещательной передачи). Реализован

вArcnet.Достоинства:

простота и малый объем служебной

информации в пакете, а также простота

аппаратуры адаптера, распознающей адрес

пакета. Недостаток: трудоемкость задания

адресов и возможность ошибки (например,

двум абонентам сети может быть присвоен

один и тот же адрес).

2. Разработан международной организацией

IEEE, используется в

большинстве сетей. Уникальный сетевой

адрес присваивается каждому адаптеру

сети еще на этапе его изготовления. Был

выбран 48-битный формат адреса, что

соответствует примерно 280триллионам различных адресов. Чтобы

распределить возможные диапазоны

адресов между многочисленными

изготовителями сетевых адаптеров, была

предложена следующая структура адреса,

которая представлена на рис 6.6

Рис. 6.6.Структура 48-битного

стандартного адреса

Младшие 24разряда кода

адреса называютсяOUA(OrganizationallyUniqueAddress) —

организационно уникальный адрес.

Именно их присваивает производитель

сетевого адаптера. Всего возможно

свыше 1б миллионов

комбинаций.

Следующие 22разряда кода

называютсяOUI(OrganizationallyUniqueIdentifier)

— организационно уникальный

идентификатор.IEEEприсваивает один или несколько

OUIкаждому производителю сетевых

адаптеров. Это позволяет исключить

совпадения адресов адаптеров от разных

производителей. Всего возможно свыше

4миллионов разных OUI.Вместе OUAи OUIназываютсяUAA(UniversallyAdministeredAddress)

—универсально управляемый

адресили IEEE-адрес.

Два старших разряда адреса являются

управляющими и определяют тип адреса,

способ интерпретации остальных

46 разрядов.

Старший бит I/G

(Individual/Group)определяет, индивидуальный это адрес

или групповой. Если он установлен в

0,то мы имеем дело с индивидуальным

адресом, если установлен в