Очень часто при работе на высоконагруженных Linux серверах могут возникать ошибки “too many open files”. Это означает, что процесс открыл слишком много файлов (читай файловых дескрипторов) и не может открыть новые. В Linux ограничения “max open file limit“ установлены по умолчанию для каждого процесса и пользователя, и они не слишком высокие.

В данной статье мы рассмотрим, как проверить текущие ограничения на количество открытых файлов в Linux, как изменить этот параметр для всего сервера, для отдельных сервисов и для сеанса. Статья применима для большинства современных дистрибутивов Linux (Debian, Ubuntu, CentOS, RHEL, Oracle Linux, Rocky и т.д.)

Содержание:

- Ошибка: Too many open files и лимиты на количество открытых файлов в Linux

- Глобальные ограничения на количество открытых файлов в Linux

- Увеличить лимит открытых файловых дескрипторов для отдельного сервиса

- Увеличить количество открытых файлов для Nginx и Apache

- Лимиты file-max для текущей сессии

Ошибка: Too many open files и лимиты на количество открытых файлов в Linux

Чаще всего ошибку “too many open files“. Чаще всего эта ошибка встречается на серверах с установленным веб-сервером NGINX/httpd, сервером БД (MySQL/MariaDB/PostgreSQL), при чтении большого количества логов. Например, когда веб-серверу Nginx не хватает лимита для открытия файлов, вы получите ошибку:

socket () failed (24: Too many open files) while connecting to upstream

Или:

HTTP: Accept error: accept tcp [::]:<port_number>: accept4: too many open files.

В Python:

OSError: [Errno 24] Too many open files.

Максимально количество файловых дескрипторов, которые могут быть открыты в вашей файловой системе всеми процессами можно узнать так:

# cat /proc/sys/fs/file-max

Чтобы узнать, сколько файлов открыто сейчас, выполните:

$ cat /proc/sys/fs/file-nr

7744 521 92233720

- 7744 — суммарное количество открытых файлов

- 521– число открытых файлов, но которые сейчас не используются

- 92233720– максимальное количество файлов, которое разрешено открывать

В Linux ограничение на максимальное количество открытых файлов можно натсроить на нескольких уровнях:

- Ядра ОС

- Сервиса

- Пользователя

Чтобы вывести текущее ограничение на количество открытых файлов в ядре Linux, выполните:

# sysctl fs.file-max

fs.file-max = 92233720

Выведем ограничение на количество открытых файлов для одного процесса текущего пользователя:

# ulimit -n

По умолчанию количество файлов для одного процесса этого ограничено числом 1024.

Выведем максимальное количество для одного пользователя (max user processes):

# ulimit –u

5041

Умножаем 1024 * 5041 дает нам 5161984 – это максимально количество открытых файлов всеми процессами пользователя.

В Linux есть два типа ограничений на количество открытых файлов: Hard и Soft. Soft ограничения носят рекомендательный характер, при превышении значения пользователь будет получать предупреждения. Если количество открытых файлов превысило hard лимит, пользователь не сможет открыть новые файлы пока не будет закрыты ранее открытые.

Для просмотра текущих лимитов используется команда ulimit с опцией

-S

(soft) или

-H

(hard) и параметром

-n

(the maximum number of open file descriptors).

Для вывода Soft-ограничения:

# ulimit -Sn

Для вывода Hard-ограничения:

# ulimit -Hn

Глобальные ограничения на количество открытых файлов в Linux

Чтобы разрешить всем сервисам открывать большее количество файлов, можно изменить лимиты на уровне всей ОС Linux. Чтобы новые настройки работали постоянно и не сбрасывались при перезапуске сервера или сессии, нужно поправить файл /etc/security/limits.conf. Строки с разрешениями выглядит так:

Имя_пользователя тип_огрничение название_ограничения значение

Например:

apache hard nofile 978160 apache soft nofile 978160

Вместо имени пользователя можно указать

*

. Это означает, что это ограничение будет применяться для всех пользователей Linux:

* hard nofile 97816 * soft nofile 97816

Например, вы получили ошибку too many open files для nginx. Проверьте, сколько файлов разрешено открывать процессу этому пользователю:

$ sudo -u nginx bash -c 'ulimit -n'

1024

Для нагруженного сервера этого недостаточно. Добавьте в /etc/security/limits.conf строки

nginx hard nofile 50000 nginx soft nofile 50000

В старых ядрах Linux значение fs.file-max может быть равно 10000. Поэтому проверьте это значение и увеличьте его, чтобы оно было больше чем ограничение в limits.conf:

# sysctl -w fs.file-max=500000

Это временно увеличит лимит. Чтобы новые настройки стали постоянными, нужно добавить в файл /etc/sysctl.conf строку:

fs.file-max = 500000

Проверьте, что в файле /etc/pam.d/common-session (Debian/Ubuntu или /etc/pam.d/login для CentOS/RedHat/Fedora) есть строчка:

session required pam_limits.so

Если нет, добавьте ее в конец. Она нужна, чтобы ограничения загружались при авторизации пользователя.

После изменений, перезапустите терминал и проверьте значение лимита max_open_files:

# ulimit -n

97816

Увеличить лимит открытых файловых дескрипторов для отдельного сервиса

Вы можете изменить лимит на количество открытых файловых дескрипторов для конкретного сервиса, а не для всей системы. Рассмотрим на примере apache. Чтобы изменить значения, откройте настройки службы через systemctl:

# systemctl edit httpd.service

Добавьте необходимые лимиты, например:

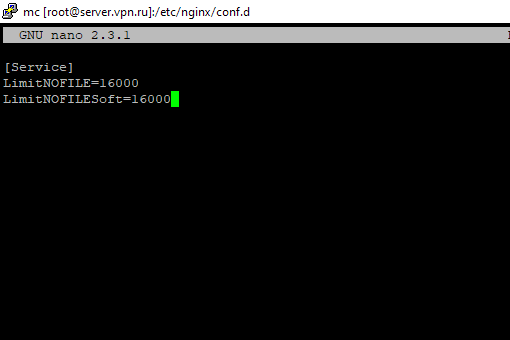

[Service] LimitNOFILE=16000 LimitNOFILESoft=16000

После изменения, нужно обновить конфигурацию сервиса и перезапустить его:

# systemctl daemon-reload

# systemctl restart httpd.service

Чтобы проверить, изменились ли значения, нужно получить PID сервиса:

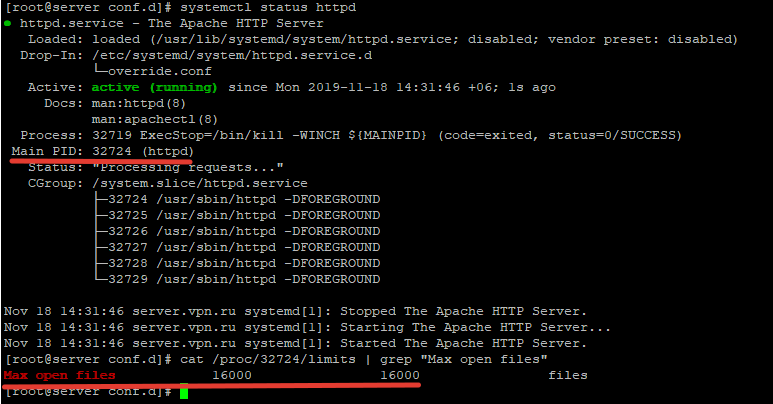

# systemctl status httpd.service

Например, вы определил PID сервиса 32724:

# cat /proc/32724/limits | grep "Max open files”

Значение должно быть 16000.

Так вы изменили значения Max open files для конкретного сервиса.

Увеличить количество открытых файлов для Nginx и Apache

После того, как вы увеличил ограничения на количество открытых файлов для сервера, нужно также поправить конфигурационный файл службы. Например, для веб-сервера Nginx в файле конфигурации /etc/nginx/nginx.conf нужно задать значение в директиве:

worker_rlimit_nofile 16000

Директива worker_rlimit_nofile задает ограничение на количество файлов, открытых в рабочем процессе (

RLIMIT_NOFILE

). В Nginx файловые дескрипторы нужны для возврата статического файла из кэша для каждого подключения клиента. Чем больше пользователей использует ваш сервер и чем больше статических файлов отдает nginx, тем большее количество дескрипторов используется. Сверху максимальное количество дескрипторов ограничивается на уровне ОС и/или сервиса. При превышении количеств открытых файлов nginx появится ошибка

socket() failed (24: Too many open files) while connecting to upstream

.

При настройке Nginx на высоконагруженном 8-ядерном сервере с worker_connections 8192 нужно в worker_rlimit_nofile указать 8192*2*8 (vCPU) = 131072.

После чего выполнить рестарт Nginx:

# nginx -t && service nginx -s reload

Чтобы увидеть чисто открытых файлов для процессов пользователя nginx:

# su nginx

# ulimit –Hn

# for pid in `pidof nginx`; do echo "$(< /proc/$pid/cmdline)"; egrep 'files|Limit' /proc/$pid/limits; echo "Currently open files: $(ls -1 /proc/$pid/fd | wc -l)"; echo; done

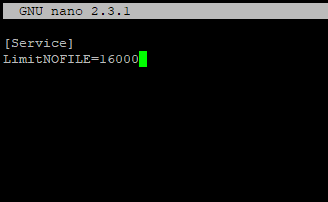

Для apache, нужно создать директорию:

# mkdir /lib/systemd/system/httpd.service.d/

После этого создайте файл limit_nofile.conf:

# nano /lib/systemd/system/httpd.service.d/limit_nofile.conf

И добавьте в него:

[Service] LimitNOFILE=16000

Не забудьте перезапустить сервис httpd.

Лимиты file-max для текущей сессии

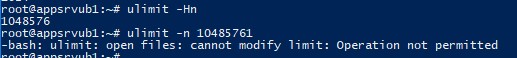

Чтобы изменить лимиты на открытые файлы в рамках текущей сессии пользователя, выполните команду:

# ulimit -n 3000

Если указать здесь значение большее, чем заданное в hard limit, появится ошибка:

-bash: ulimit: open files: cannot modify limit: Operation not permitted

Когда вы завершите текущую сессию терминала и откроете новую, лимиты вернутся к начальным значениям, указанным в файле /etc/security/limits.conf.

В данной статье мы разобрались, как решить проблему с недостаточным лимитом для открытых файловых дескрипторов в Linux и рассмотрели несколько вариантов изменения лимитов на сервере.

[I posted this on the Nginx forums, but had no responses a week later, so trying here]

I am a Linux and Nginx novice, but have learnt enough to get it installed and running and working as a simple reverse proxy for two internal webservers. This has been running fine for months, but I recently started getting 500 errors.

Here is the recent output of /var/log/nginx/error.log

(I have replaced our company name with «companyname.com» and replaced our public WAN IP address with

2020/02/10 15:17:49 [alert] 1069#1069: *1011 socket() failed (24: Too many open files) while connecting to upstream, client: 10.10.10.1, server: web1.companyname.com, request: "GET / HTTP/1.0", upstream: "https://<WANIP>:443/", host: "web1.companyname.com"

2020/02/10 15:21:41 [alert] 1069#1069: *2022 socket() failed (24: Too many open files) while connecting to upstream, client: 10.10.10.1, server: web2.companyname.com, request: "GET / HTTP/1.0", upstream: "https://<WANIP>:443/", host: "web2.companyname.com"

2020/02/10 15:33:28 [alert] 1084#1084: *19987 socket() failed (24: Too many open files) while connecting to upstream, client: 10.10.10.1, server: web2.companyname.com, request: "GET / HTTP/1.0", upstream: "https://<WANIP>:443/", host: "web2.companyname.com"

2020/02/10 15:34:16 [alert] 1084#1084: *39974 socket() failed (24: Too many open files) while connecting to upstream, client: 10.10.10.1, server: web1.companyname.com, request: "GET / HTTP/1.0", upstream: "https://<WANIP>:443/", host: "web1.companyname.com"

2020/02/10 15:50:30 [error] 1086#1086: *1 client intended to send too large body: 4294967295 bytes, client: 176.58.124.134, server: london.companyname.com, request: "GET /msdn.cpp HTTP/1.1", host: "<WANIP>"

2020/02/10 16:32:56 [alert] 1086#1086: *19989 socket() failed (24: Too many open files) while connecting to upstream, client: 10.10.10.1, server: web1.companyname.com, request: "GET / HTTP/1.0", upstream: "https://<WANIP>:443/", host: "web1.companyname.com"

I have added the following to the end of /etc/security/limits.conf

nginx soft nofile 10000

nginx hard nofile 30000

I have added the following to /etc/sysctl.conf

fs.file-max=70000

…And rebooted. However, I’m getting the same problem immediately after a reboot.

Interestingly the IP address that appears in the log «176.58.124.134» I don’t recognise and a quick google search suggests this is an abusive IP address. I can block at the firewall, but I’m not sure that’s the problem.

Any tips, suggestions are grealy appreciated. Thanks.

На одном из серверов в логе ошибок веб-сервера Nginx появились сообщения вида

2017/11/22 08:21:02 [crit] 29098#29098: *174583882 open() "/var/www/public/blackfriday/img/tabs/img4.png" failed (24: Too many open files), client: 176.113.144.142, server: example.com, request: "GET /blackfriday/img/tabs/img4.png HTTP/2.0", host: "example.com"

Давайте разберемся как исправить данную ошибку в операционной системе Centos 7!

Смотрим текущие soft/hard лимиты файловых дескрипторов и открытых файлов для основного (master) процесса Nginx:

cat /proc/$(cat /var/run/nginx.pid)/limits|grep open.files

Max open files 1024 4096 files

и для дочерних (worker) процессов:

ps --ppid $(cat /var/run/nginx.pid) -o %p|sed '1d'|xargs -I{} cat /proc/{}/limits|grep open.files

Max open files 1024 4096 files

Max open files 1024 4096 files

Max open files 1024 4096 files

Открываем на редактирование конфигурационный файл /etc/security/limits.conf и вставляем в него следующие строки:

...

nginx soft nofile 10000

nginx hard nofile 30000

В конфигурациооный файл nginx.conf добавляем следующую строку:

...

worker_rlimit_nofile 30000;

...

Проверим конфигурацию веб-сервера на предмет ошибок и перечитаем конфиг:

nginx -t && nginx -s reload

Проверим новые лимиты, установленные для дочерних процессов веб-сервера Nginx:

ps --ppid $(cat /var/run/nginx.pid) -o %p|sed '1d'|xargs -I{} cat /proc/{}/limits|grep open.files

Max open files 10000 30000 files

Max open files 10000 30000 files

Max open files 10000 30000 files

Новые лимиты могут примениться не ко всем дочерним процессам веб-сервера, в таком случае необходимо перезапустить nginx с помощью команды:

service nginx restart

Our monitoring informed me about a HTTP 500 error from a central reverse proxy running with Nginx. Checking the error logs revealed the following issue:

2019/05/09 08:43:35 [crit] 25655#0: *524505514 open() «/usr/share/nginx/html/50x.html» failed (24: Too many open files)

[…]

2019/05/09 09:04:27 [alert] 28720#0: *59757 socket() failed (24: Too many open files) while connecting to upstream,

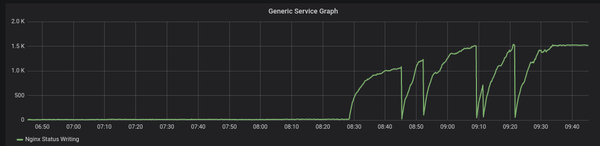

This basically means that the Nginx process had too many files open, which could also be checked on the Nginx status page. Here the graph from check_nginx_status.pl:

The default is set to a limit of 4096 files per (worker) process, which can be seen in /etc/default/nginx:

# cat /etc/default/nginx

# Note: You may want to look at the following page before setting the ULIMIT.

# http://wiki.nginx.org/CoreModule#worker_rlimit_nofile

# Set the ulimit variable if you need defaults to change.

# Example: ULIMIT=»-n 4096″

#ULIMIT=»-n 4096″

However don’t be fooled. Changing this file doesn’t help. Instead this needs to be set in /etc/security/limits.conf:

# tail /etc/security/limits.conf

#@faculty hard nproc 50

#ftp hard nproc 0

#ftp — chroot /ftp

#@student — maxlogins 4

# Added Nginx limits

nginx soft nofile 30000

nginx hard nofile 50000

# End of file

Here a soft limit of 30k and a hard limit of 50k files are defined per nginx process.

Note: I tried this here with www-data first (the user under which Nginx runs), but this didn’t work. Although a user name could be used as a «domain» in this config file…

Additionally Nginx should be told how many files can be opened. In the main config file /etc/nginx/nginx.conf add:

# head /etc/nginx/nginx.conf

user www-data;

worker_processes 4;

pid /run/nginx.pid;

# 2019-05-09 Increase open files

worker_rlimit_nofile 30000;

After a service nginx restart the limits of the worker processes can be checked:

# ps auxf | grep nginx

root 7027 0.0 0.3 103620 13348 ? Ss 09:21 0:00 nginx: master process /usr/sbin/nginx

www-data 7028 8.6 1.0 127900 40724 ? R 09:21 2:37 _ nginx: worker process

www-data 7029 8.9 1.0 127488 40536 ? S 09:21 2:44 _ nginx: worker process

www-data 7031 9.5 1.0 127792 40896 ? S 09:21 2:53 _ nginx: worker process

www-data 7032 8.1 1.0 128472 41244 ? S 09:21 2:29 _ nginx: worker process

# cat /proc/7028/limits | grep «open files»

Max open files 30000 30000 files

The «too many open files» errors disappeared from the Nginx logs after this change.

But what did cause this sudden problem? As you can see in the graph above this Writing (and Waiting) connections suddenly sharply increased. It turned out that an upstream server behind this reverse proxy did not work anymore and this particular virtual host received a lot of traffic, causing general slowness and holding files open while waiting for a timeout from Nginx (504 in this case).

Different solution when using Systemd

Update: February 1st 2021: The above fix was written two years ago and was working fine on a system without Systemd as init system. However when Nginx is started and controlled by Systemd, the limits defined in /etc/security/limits.conf seem to be ignored. Instead Systemd applies its own default limits. See Fredrik Averpil’s blog post for additional info.

This can be nicely verified. An unlimited nofile limit was defined for multiple domains in /etc/security/limits.conf to see which would be applied to Nginx’s processes:

root@nginx:~# cat /etc/security/limits.conf

[…]

# Added Nginx nofile limit

nginx soft nofile 50000

nginx hard nofile 80000

root soft nofile unlimited

root hard nofile unlimited

www-data soft nofile unlimited

www-data hard nofile unlimited

But after setting worker_rlimit_nofile in nginx.conf and a restart of Nginx, the limits still exists:

root@nginx:~# ps auxf

[…]

root 21114 0.0 0.4 64508 18264 ? Ss 09:36 0:00 nginx: master process /usr/sbin/nginx -g daemon on; master_process on;

www-data 21115 40.0 0.6 70340 26880 ? R 09:36 0:01 _ nginx: worker process

www-data 21116 2.3 0.6 68888 25252 ? S 09:36 0:00 _ nginx: worker process

www-data 21117 7.0 0.6 68888 25376 ? S 09:36 0:00 _ nginx: worker process

www-data 21118 16.0 0.6 68888 25196 ? S 09:36 0:00 _ nginx: worker process

www-data 21119 0.0 0.5 68888 21312 ? S 09:36 0:00 _ nginx: cache manager process

www-data 21120 0.0 0.5 68888 20912 ? S 09:36 0:00 _ nginx: cache loader process

[…]

root@nginx:~# cat /proc/21114/limits

Limit Soft Limit Hard Limit Units

Max cpu time unlimited unlimited seconds

Max file size unlimited unlimited bytes

Max data size unlimited unlimited bytes

Max stack size 8388608 unlimited bytes

Max core file size 0 unlimited bytes

Max resident set unlimited unlimited bytes

Max processes 15598 15598 processes

Max open files 1024 4096 files

Max locked memory 16777216 16777216 bytes

Max address space unlimited unlimited bytes

Max file locks unlimited unlimited locks

Max pending signals 15598 15598 signals

Max msgqueue size 819200 819200 bytes

Max nice priority 0 0

Max realtime priority 0 0

Max realtime timeout unlimited unlimited us

Even the nginx master process, executed as root, still has a file limit of 1024 (soft) and 4096 (hard).

This obviously causes errors when Nginx needs to open new sockets or file handlers and the error log can contain events like this:

2021/02/01 09:28:13 [emerg] 28935#28935: open() «/var/log/nginx/example.com.access.log» failed (24: Too many open files)

To solve this, the limits must be changed in the Systemd service unit configuration for Nginx. The quickest way to do this is to copy the original Nginx service unit and add the LimitNOFILE option:

root@nginx:~# cp /lib/systemd/system/nginx.service /etc/systemd/system/

root@nginx:~# cat /etc/systemd/system/nginx.service

# Stop dance for nginx

# =======================

#

# ExecStop sends SIGSTOP (graceful stop) to the nginx process.

# If, after 5s (—retry QUIT/5) nginx is still running, systemd takes control

# and sends SIGTERM (fast shutdown) to the main process.

# After another 5s (TimeoutStopSec=5), and if nginx is alive, systemd sends

# SIGKILL to all the remaining processes in the process group (KillMode=mixed).

#

# nginx signals reference doc:

# http://nginx.org/en/docs/control.html

#

[Unit]

Description=A high performance web server and a reverse proxy server

Documentation=man:nginx(8)

After=network.target

[Service]

Type=forking

PIDFile=/run/nginx.pid

ExecStartPre=/usr/sbin/nginx -t -q -g ‘daemon on; master_process on;’

ExecStart=/usr/sbin/nginx -g ‘daemon on; master_process on;’

ExecReload=/usr/sbin/nginx -g ‘daemon on; master_process on;’ -s reload

ExecStop=-/sbin/start-stop-daemon —quiet —stop —retry QUIT/5 —pidfile /run/nginx.pid

TimeoutStopSec=5

KillMode=mixed

LimitNOFILE=500000

[Install]

WantedBy=multi-user.target

Note: A more proper solution is to create a service sub-directory (/etc/systemd/system/nginx.service.d) and append the LimitNOFILE option into a single config file with a [Service] section.

After another Nginx restart, the new limits can be verified:

root@nginx:~# ps auxf|grep nginx

root 26732 0.0 0.0 14428 1012 pts/0 S+ 10:03 0:00 _ grep —color=auto nginx

root 21636 0.0 0.4 64508 18260 ? Ss 09:37 0:00 nginx: master process /usr/sbin/nginx -g daemon on; master_process on;

www-data 21637 0.1 0.6 68888 25368 ? S 09:37 0:01 _ nginx: worker process

www-data 21638 10.6 0.7 75440 32228 ? R 09:37 2:42 _ nginx: worker process

www-data 21639 1.6 0.6 69608 26276 ? R 09:37 0:24 _ nginx: worker process

www-data 21640 29.0 1.1 87836 44740 ? S 09:37 7:22 _ nginx: worker process

www-data 21641 0.0 0.5 68888 21368 ? S 09:37 0:00 _ nginx: cache manager process

root@nginx:~# cat /proc/21636/limits | grep «open files»

Max open files 500000 500000 files

root@nginx:~# cat /proc/21637/limits |grep «open files»

Max open files 500000 500000 files

The limit, configured in Systemd’s service unit file for Nginx, is applied for both master and worker processes.

Add a comment

Show form to leave a comment

Comments (newest first)

bao from wrote on Mar 6th, 2023:

thanks. It helped me.

moh from wrote on Jun 18th, 2022:

Thanks. This really helped

Sumit from wrote on Aug 11th, 2021:

Thanks for explaining it so well. I was checking all the above locations but unable to locate where the defaults were read from.

mycoolemail@gmail.com from wrote on May 27th, 2021:

Really thank you

vidocq from wrote on Mar 25th, 2021:

Thankyou very much. I was test success on my server with multiple domain higtload.

Abhi from wrote on Mar 12th, 2021:

Thanks a lot man! it really helped

qinnan from wrote on Jul 22nd, 2020:

Thanks. This really helped

Clyde Dsouza from India wrote on Jun 9th, 2020:

Thanks. This really helped

Описание проблемы

Во процессе обслуживания высокого количества соединений (высокая нагрузка), в логе ошибок Вашего сервера могут появляться записи 24: Too Many Open Files. Происходит это потому что сервер nginx пытается открыть больше файловых дескрипторов чем ему позволено. Ограничение может быть наложено конфигурацией nginx сервера или конфигурацией операционной системы. На каждое соединение nginx открывает как минимум два дескриптора, один для соединения, второй для передаваемого файла.

Диагностика

Для выяснение причин проведем короткую диагностику. Прежде всего посмотрим конфигурационный файл nginx, обычно он расположен в

/etc/nginx/nginx.conf

Нас интерисуют следующие строки

user [xxx];

worker_processes [x];

worker_rlimit_nofile [xxx];

events {

worker_connections [xxxx];

}

user — от имени какого пользователя nginx работает в системе, нам необходимо будет проверить лимиты для данного пользователя.

worker_processes — кол-во процессов nginx работающих при запуске демона, так как лимит операционной системы общий для всех процессов, соответственно нам надо будет устанавливать лимиты исходя из кол-ва процессов.worker_rlimit_nofile — максимальное кол-во файловых дескрипторов на один процесс.

worker_connections (может присутствовать только в контексте events) — максимальное кол-во соединений на один процесс.

Далее выясним лимиты установленные операционной системой, для этого перейдем под пользователя nginx

su nginx

Если получаем от OS сообщение вида

This account is currently not available.

Значит в файле /etc/passwd для нашего пользователя указана оболочка запрещающая вход в систему и работу с консолью, например /sbin/nologin

Отредактируем файл /etc/passwd, заменим строку

nginx:x:500:500:nginx user:/var/cache/nginx:/sbin/nologin

на строку

nginx:x:500:500:nginx user:/var/cache/nginx:/bin/bash

и вновь выполним su nginx.

Теперь посмотрим лимиты:

ulimit -Hn ulimit -Sn

-Hn — жесткий лимит максимального кол-ва открытых файловых дискрипторов

-Sn — мягкий лимит максимального кол-ва открытых файловых дискрипторов

Отличие между жестким и мягким лимитами в том, что жесткий может быть установлен только root пользователем, а мягкий может быть установлен пользователем на которого наложен лимит, но не больше чем жесткий лимит.

Теперь мы знаем текущие ограничения OS наложенные на пользователя nginx, можно выйти из под su

exit

Посмотрим глобальное ограничение на количество дескрипторов, для этого выполним команду

sysctl fs.file-max

Итак мы значем все ограничения, теперь попробуем сделать так чтобы наш nginx получил возможность открывать столько дескрипторов, сколько ему нужно.

Решение проблемы

Посчитаем сколько нам нужно дескрипторов для nginx

(worker_connections * 4 * worker_processes) + 100 = примерно нужное кол-во дескрипторов

Соответственно для будущего расширения это значение можно умножить еще на два и задавать лимиты.

Например, (1024 * 4 * 2) + 100 = 8292

Значение не большое, можно его свободно увеличить до 25000

Устанавливаем глобальные лимиты операционной системы, в файле /etc/sysctl.conf прописываем или изменяем строку:

fs.file-max = 203463

Устанавливаем лимиты на пользователя, в файле /etc/security/limits.conf прописываем или изменяем строки:

nginx soft nofile 25000 nginx hard nofile 50000

Применяем установленные лимиты к системе

sysctl -p

Проверяем что все применилось

sysctl fs.file-max su nginx ulimit -Hn ulimit -Sn exit

Устанавливаем лимиты для nginx

worker_rlimit_nofile 12500

Перезагружаем конфигурацию nginx

nginx -s reload

Ошибка более не должна повторяться.

Возвращаем shell для nginx в файле /etc/passwd в исходное состояние

nginx:x:500:500:nginx user:/var/cache/nginx:/sbin/nologin