В самом начале SEO-продвижения сайта специалист обязан «уведомить» поисковые системы о наличии сайта в индексе и оценить, какие проблемы отображает Яндекс или Google по своим стандартам. Сайт добавляется в Вебмастер – сервис Яндекса, в котором содержится панель инструментов для оценки качества индексации сайта. Этот инструмент находится по URL-адресу: https://webmaster.yandex.ru/. Верификация осуществляется тремя способами:

- Добавление соответствующего кода в тег «head».

- Размещение файла Вебмастера сайта в корневой папке проекта.

- Добавление TXT-записи верификации в DNS домена сайта.

Если домен новый и ни разу не проверялся Яндексом, необходимо подождать несколько дней, чтобы сформировался предварительный отчет и на панели можно было обнаружить ошибки. Их необходимо устранять в кратчайшие сроки.

В данной статье рассмотрим самые частые ошибки Вебмастера Яндекса и приведём рекомендации по их устранению.

Содержание:

- Категории проблем

- Фатальные ошибки

- Критичные ошибки

- Возможные ошибки

- Рекомендации

- Вывод

Категории проблем

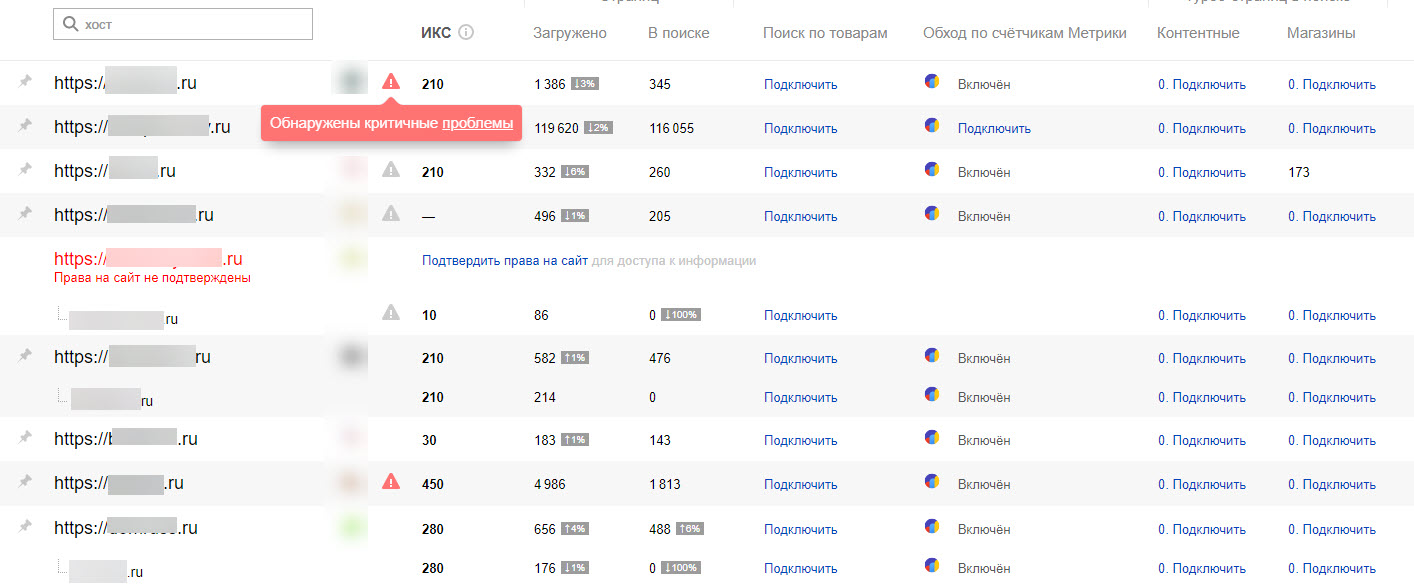

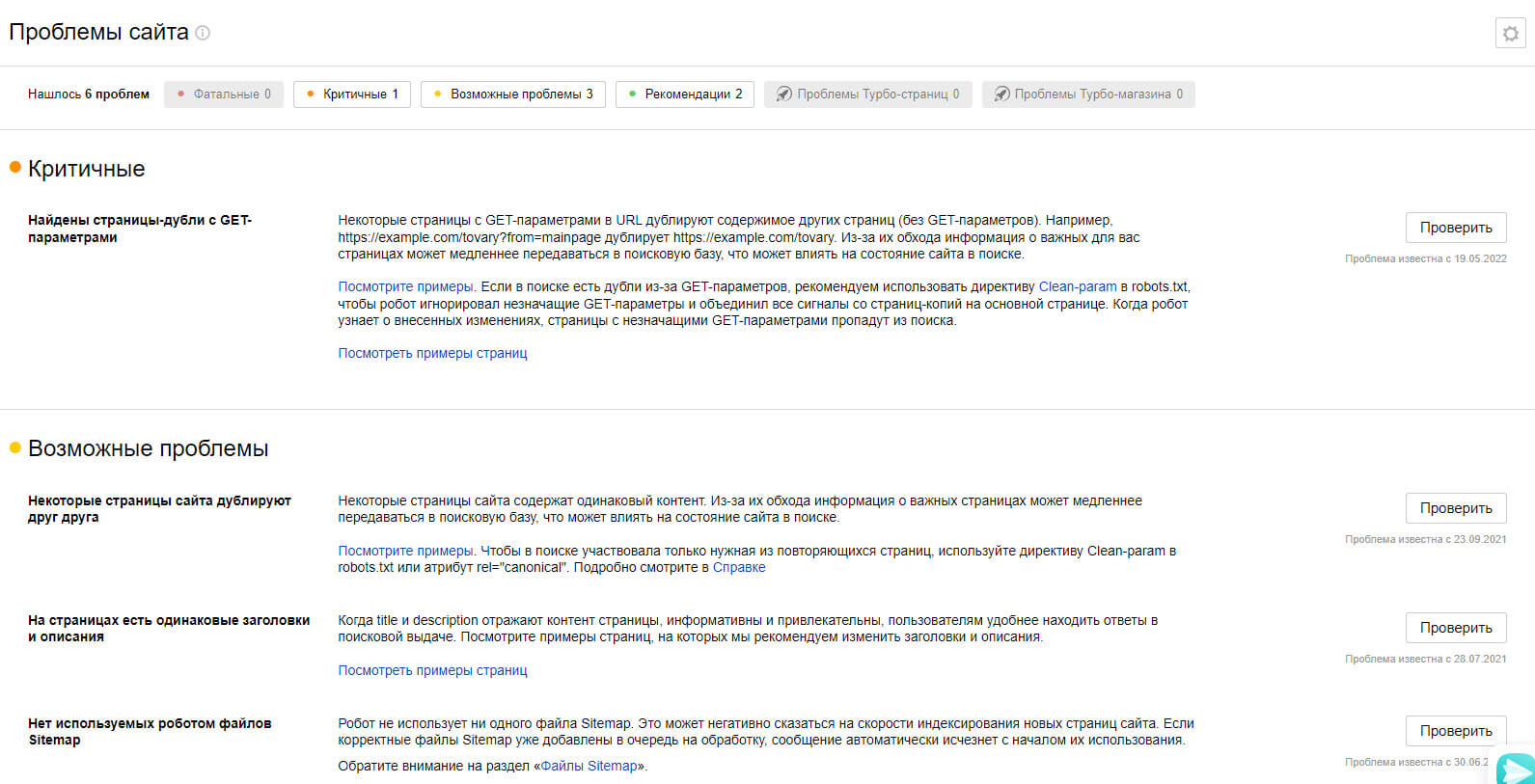

Ошибки проверяемого сайта указаны в разделе «Диагностика сайта». Существует 4 категории ошибок, которые фиксирует Яндекс и сообщает об этом пользователю:

- Фатальные — отображаются возможные проблемы с подключением сайта к серверу, его корректной настройкой, доступностью для последующего индексирования, соблюдением правил безопасности и общих правил поисковой системы.

- Критичные — выдаются проблемы с настройкой SSL-сертификата (он отвечает за безопасное HTTPS-соединение, важный фактор в SEO-оптимизации), ссылками с 404-ошибкой и скоростью ответа сервера на запрос.

- Возможные — потенциальные проблемы, которые влияют на общее качество сайта для потенциальных пользователей и скорость обхода отдельных страниц сайта – правильная настройка XML-карты, наличие файла robots.txt, разрешение на обход внутренних страниц через статистику из Метрики (настройка параллельного отслеживания данных со счетчика статистики), наличие дублирующихся страниц.

- Рекомендации — общая информация для улучшения представления сайта в поиске.

Как правило, все ошибки и рекомендации важно закрывать и исправлять, а при выполнении вовремя уведомлять системы через кнопку «Проверить». Также рекомендуется отправить отредактированные страницы на переобход (раздел «Индексирование», далее – «Переобход страниц»).

Рассмотрим подробнее все варианты и пути для исправления.

Фатальные ошибки

Уведомления о наличии такого рода проблем могут появляться в следующих ситуациях:

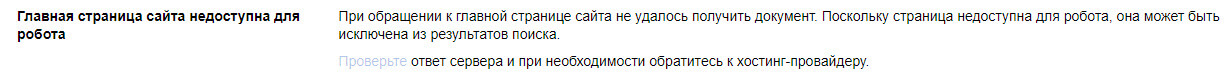

«Главная страница возвращает ошибку»

Проблема отображается, если главная страница не выдает корректный ответ сервера — «200 ОК», это можно проверить в разделе «Инструменты» — «Проверка ответа сервера». Причины могут быть разные — страница закрыта от индексации, произошел сбой в настройке сервера, главная страница перенаправлена на другую страницу (для нее настроен редирект).

Для исправления необходимо проверить файл robots.txt на наличие правила «Disallow» для главной страницы или убрать тег noindex в метатеге robots в коде главной страницы.

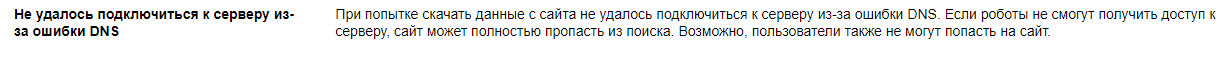

«Не удалось подключиться к серверу из-за ошибки DNS»

Это означает, что при индексировании поисковый робот не смог получить IP-адрес сервера, на котором расположены файлы сайта. Адрес присваивается хостинг-провайдером и указывается в панели управления DNS-записями. При корректной настройке ответ сервера для ресурса – «200 ОК». В случае неполадки следует обращаться к хостинг-провайдеру.

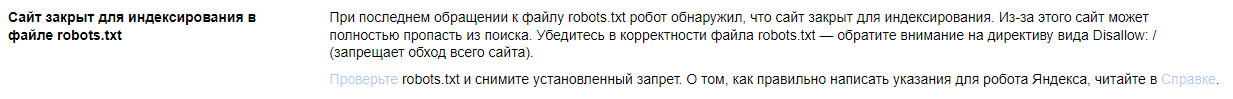

«Сайт закрыт от индексирования в файле robots.txt»

Зачастую такая ошибка возникает после переноса готового проекта с тестового домена (откуда велась разработка) на основной. В файле robots.txt обычно в таких случаях прописывается правило «Disallow: /», означающая закрытие от индексации абсолютно всех страниц сайта. Чтобы устранить эту ошибку, требуется просто удалить эту строку из файла для всех элементов User-Agent.

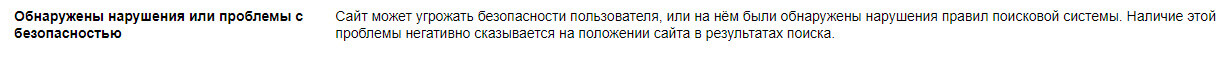

«Обнаружены нарушения или проблемы с безопасностью»

В эту категорию фатальных проблем попадают сайты, замеченные за нарушениями, которые противоречат правилам поисковиков, среди таких нарушений могут быть:

- переспамленные SEO-тексты;

- обман Яндекса с целью манипуляции выдачей в топе поиска;

- чрезмерная закупка SEO-ссылок — наличие большого количества внешних ссылок, закупленных в течение недавнего времени;

- дорвеи — наличие сквозного веб-ресурса, который за счет мощного трафика перенаправляет пользователей на продвигаемый сайт;

- майнинг

- малополезный контент;

- фишинг — сбор конфиденциальной информации, логинов, паролей, данных для связи

- «черные» и «серые» методы продвижения, связанные с манипуляцией поведенческими факторами или большим количеством автоматических переходов (накрутка ботами), применяемая не только некоторыми SEO-оптимизаторами, но и недобросовестными конкурентами.

Чтобы узнать точный ответ, что именно исправлять, необходимо перейти в раздел «Безопасность и нарушения» и нажать на кнопку с вопросительным знаком. Далее от SEO-шника требуется внимательно исправить ошибку, чтобы после устранения проблемы в том же разделе нажать кнопку «Я всё исправил». Проблем должна исчезнуть, в противном случае придется ждать минимум 3 месяца.

Критичные ошибки

Рассматриваемые проблемы могут стать причиной понижения позиций по продвигаемым запросам по отдельным страницам или для всего сайта.

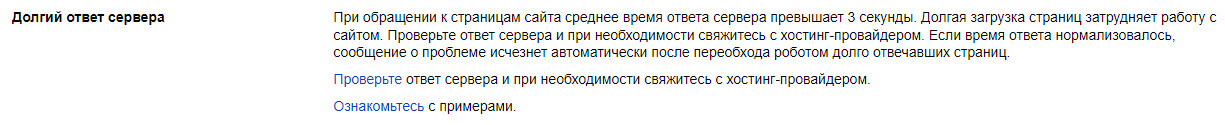

«Долгий ответ сервера»

В данном случае страницы долго отвечают на запросы поискового робота. Для проверки скорости прямо в Вебмастере можно использовать инструмент «Проверка ответа сервера». Оптимальное время для корректной работы — не более 3-х секунд. В противном случае необходимо настроить кэширование ресурса, устранить ошибки и добавить ресурс на хостинге, а также сократить число запросов к базе данных.

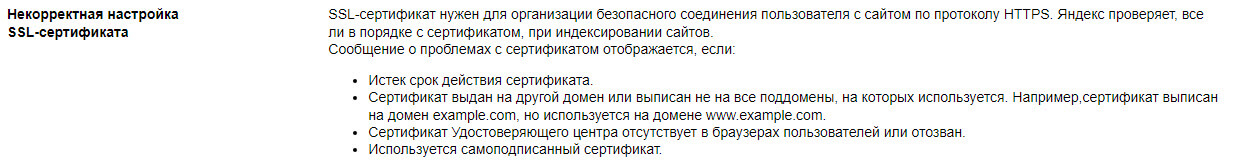

«Некорректная настройка SSL-сертификата»

Для безопасного соединения ресурса с пользователем с возможностью предоставления информации используется SSL-сертификат, обеспечивающий защищенное HTTPS-соединение. Критическая проблема может появиться в следующих случаях:

- Истек срок действия — требуется продление;

- Сертификат был аннулирован по причине проблем в удостоверяющем центре — заменить на корректный и работающий на всех популярных браузерах;

- Сертификат оформлен на дублирующийся домен — заменить на актуальный адрес и заодно настроить перенаправление;

- Использование самописного SSL — заменить на один из популярных и работающих.

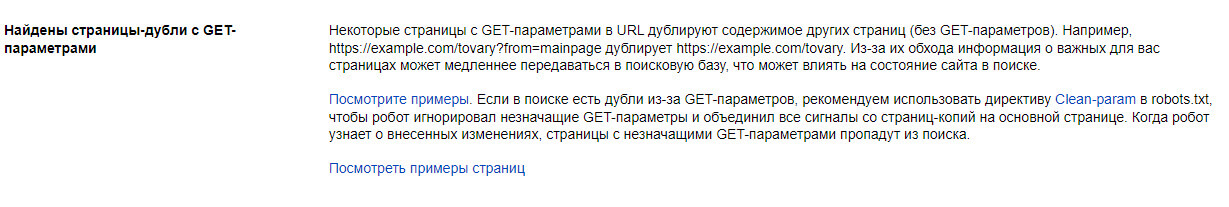

«Найдены страницы-дубли с GET-параметрами»

К проблеме относятся дубли страницы с одинаковым содержимым, но доступные по разным URL-адресам. Это или страницы без перенаправления на правильный адрес или содержащие GET-параметр, связанный с динамической ссылкой для сервера.

Для исправления необходимо добавить правило «Clean-param:» в файл robots.txt или разместить в теге «head» атрибут rel=”canonical” с отображением правильной версии страницы. Проблема «уходит» автоматически через несколько дней.

Возможные ошибки

Самый распространенный вид, к которым относятся небольшие проблемы при SEO-оптимизации.

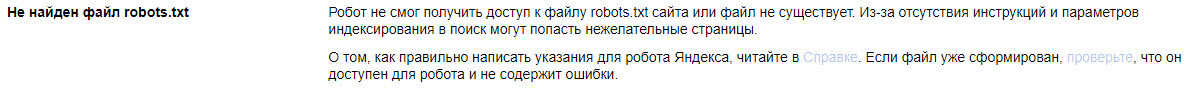

«Не найден файл robots.txt»

Данный файл нужен для определения правил индексирования для поисковых роботов, что можно включать в выдачу, а что — нельзя. Иногда бывает, что Вебмастер может случайно сообщить об ошибке, даже если файл размещен в корневой системе сайта. В таком случае нужно нажать кнопку «Проверить» и в течение 2-3 дней уведомление удалится.

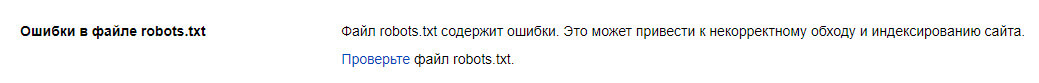

«Обнаружены ошибки в файле robots.txt»

Необходимо через Вебмастер проверить на наличие ошибок файл robots.txt, который закрывает часть страниц от индексирования. Для исправления требуется еще раз проверить документ на правильную настройку директив.

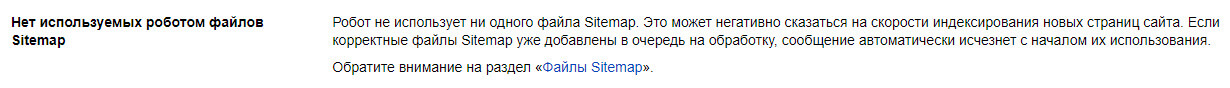

«Нет используемых роботом файлов Sitemap»

Sitemap.xml представляет собой список всех страниц сайта, который считывает поисковая система, загружая в свою базу новые страницы. Для устранения проблемы нужно создать и загрузить на сервере файл (через специальные сервисы, например SiteAnalyzer, а также стандартный SEO-плагин в CMS), указать в панели Вебмастера ссылку на карту («Индексирование» — «Файлы Sitemap»), а также скопировать путь к файлу и отметить в файле robots.txt.

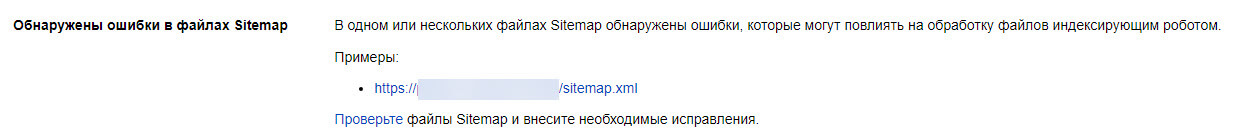

«Обнаружены ошибки в Sitemap»

В Вебмастере есть компонент «Анализ файлов Sitemap», с помощью которого можно проверить все строки файла на ошибки и устранить их. Вносить изменения рекомендуется, даже несмотря на то, что при наличии проблем поисковая система не блокирует весь файл, а игнорирует незнакомые инструкции.

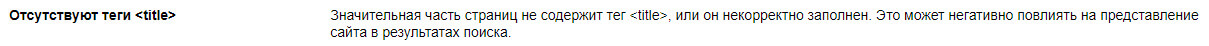

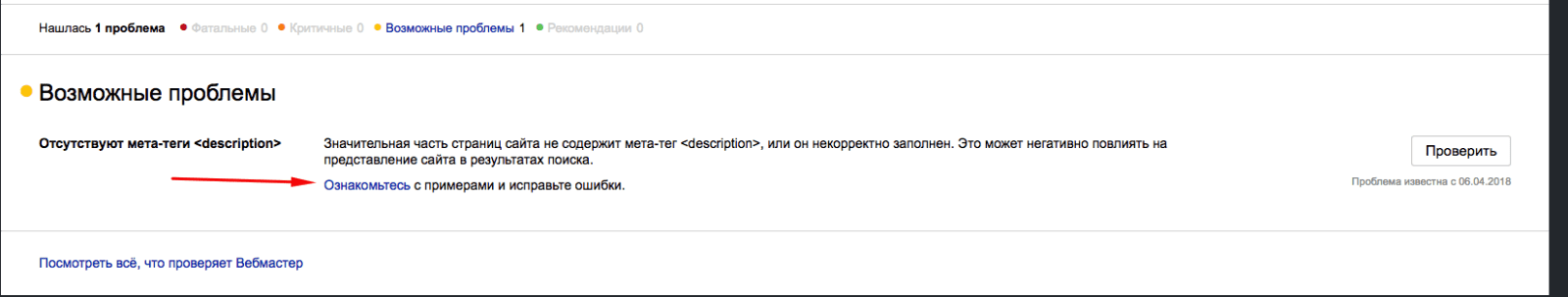

«Отсутствуют элемент title и метатег description»

Теги title и description необходимы для соответствия ресурса запросу пользователя. С их помощью поисковая систем формирует сниппет — краткое описание сайта в выдаче. Метатеги обязательны к заполнению.

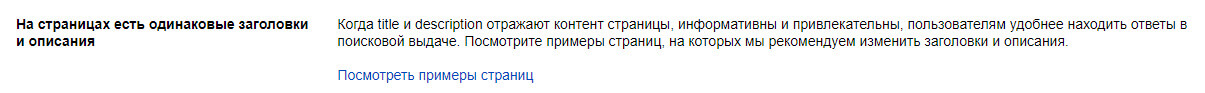

«На страницах имеются одинаковые заголовки и описания»

Метатеги title и description должны быть не только заполнены, но и различимы между собой. Рекомендация исчезнет после изменений и последующей проверки роботом, рекомендуется указать ссылки на измененные страницы в разделе для переобхода.

«Файл favicon недоступен для робота»

В данном случае иконка не всегда показывается в результатах поиска (в зависимости от браузера). Посмотрите причину: ответ сервера не «200 ОК» — проверьте ссылку, причина может быть в неправильном значении данных в параметре type.

Рекомендации

В этой категории отображаются предложения по улучшению позиций сайта.

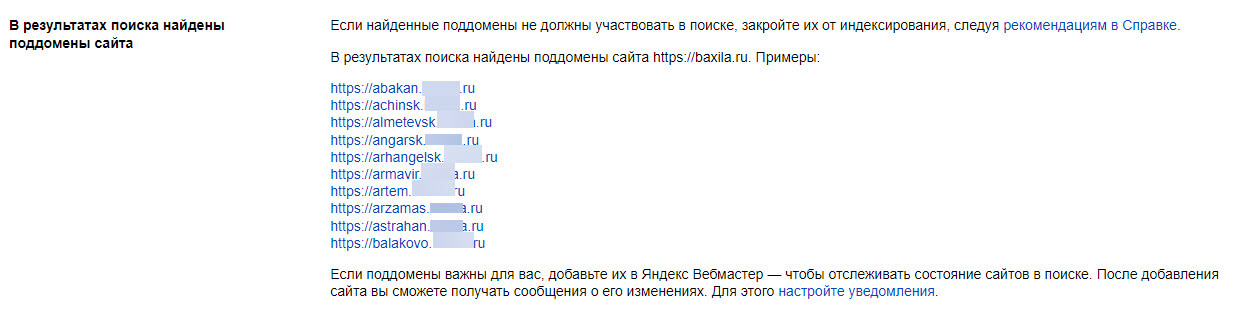

«В результатах поиска найдены поддомены»

Если в проекте имеются региональные поддомены, их также нужно добавлять в Вебмастер в качестве отдельных ресурсов, а в разделе «Региональность» присвоить геопривязку через карточку компании в Яндекс.Бизнес и добавление ссылки на страницу «Контакты», где указан фактический адрес. Для поддоменов дополнительная верификация не требуется – достаточно просто добавить проект на уже подтвержденный аккаунт для основного зеркала сайта.

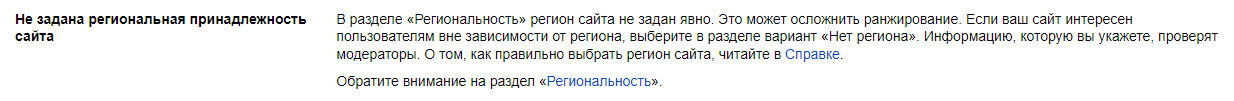

«Не задана региональная принадлежность сайта»

В блоке «Региональность» нужно указать регион (город или субъект), чтобы лучше отображать продвигаемый сайт по геозависимым запросам, когда пользователь ищет товар или услугу, не указывая регион в поисковой строке, а находясь в нем.

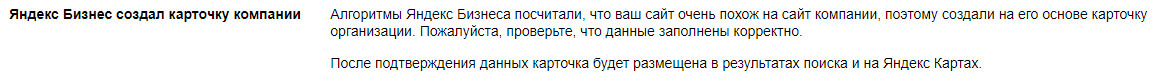

«В Бизнесе подготовлена карточка организации»

Сервис «Яндекс.Бизнес», с помощью которого можно создавать карточки компании для отображения, например, в картах, может автоматически сформировать профиль на основе контента, особенно это относится к новым сайтам. В данном случае необходимо проверить и подтвердить содержимое карточки.

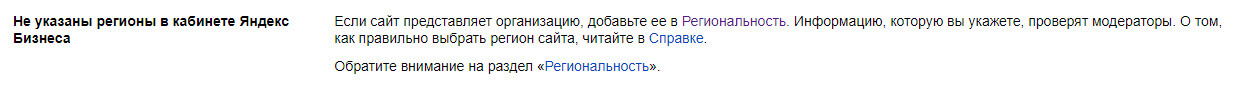

«Не указаны регионы в Яндекс Бизнесе»

Проблема относится к профилю в «Яндекс.Бизнесе». Необходимо выполнить все условия для правильного отображения карточки:

- данные заполнены на 90% и более (получена специальная «галочка» о том, что владелец компании подтвердил все указанные данные);

- указано главное зеркало сайта;

- с момента создания карточки прошло больше 1 недели.

Если все условия выполнены, рекомендация пропадет из раздела диагностики.

«Файл favicon не найден»

В качестве рекомендации может выпасть не только отсутствие favicon, но и его правильный формат – с расширением «.svg» или размером от 120х120 пикселей.

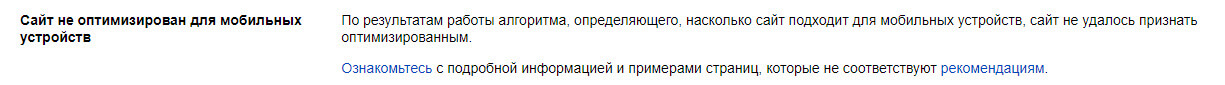

«Сайт не оптимизирован для мобильных устройств»

Чтобы увидеть замечания, необходимо перейти в раздел «Инструменты» — «Проверка мобильных страниц» и ознакомиться с рекомендациями от Яндекса, которые мешают корректному отображению мобильной версии сайта. Если все изменения были сделаны или ошибок не обнаружено, можно нажать кнопку «Проверить» для дополнительного анализа со стороны робота.

Вывод

При обнаружении ошибок в Яндекс.Вебмастере особое внимание уделите фатальным и критическим ошибкам – они напрямую влияют на работоспособность сайта и могут обрушить позиции сайта по продвигаемым запросам на несколько страниц вниз. Для устранения ошибок желательно привлекать технического специалиста (программиста или разработчика). Возможные проблемы относятся больше к компетенции SEO-специалистов и требуют чуть больше времени на исправления — все зависит от размера сайта.

К рекомендациям также следует присматриваться, чтобы успешно конкурировать с сайтами в топе поиска и улучшать коммерческие и поведенческие факторы.

Как Яндекс научил искусственный интеллект находить ошибки в новостях

Время на прочтение

7 мин

Количество просмотров 12K

Мы часто рассказываем о технологиях и библиотеках, которые зародились и сформировались в Яндексе. На самом деле мы ничуть не реже применяем и развиваем сторонние решения.

Сегодня я расскажу сообществу Хабра об одном из таких примеров. Вы узнаете, зачем мы научили нейросеть BERT находить опечатки в заголовках новостей, а не воспользовались готовой моделью, почему нельзя взять и запустить BERT на нескольких видеокартах и как мы использовали ключевую особенность этой технологии — механизм attention.

Задача

Яндекс.Новости — это сервис, собирающий новости подключённых к нам изданий. Это не только наиболее читаемые и цитируемые новости СМИ на главной, но и тематические разделы или даже персональные подборки со всех изданий. В любом случае это тысячи сайтов и миллионы заголовков, из которых машина каждые несколько минут должна сформировать подборку.

Именно машина, потому что мы никогда не вмешиваемся в картину дня: не добавляем туда новости вручную, не удаляем их оттуда (как бы сильно этого ни хотелось), не правим заголовки. Вокруг этого уже было сломано множество копий. У полностью алгоритмического подхода есть и плюсы, и минусы. Что-то мы можем улучшить с помощью технологий, что-то нет. Даже если в заголовках есть орфографические ошибки и опечатки — мы не исправляем их. Мы добавили фавиконки изданий к заголовкам, чтобы было понятно, откуда взяты новости. Отчасти это помогло, но мы не смирились с ошибками и стали искать способ избавиться от них, не внося правки в текст.

Если нельзя исправить ошибку, то можно натренировать машину находить заголовки, которые из-за ошибок не годятся для топа. Тем более что Яндекс специализируется на русской морфологии с тех времён, когда и название-то ему ещё не придумали. Казалось бы, берём нейросеть — и дело в шляпе.

Инструменты

У Яндекса есть технология Спеллер для поиска и исправления ошибок. Благодаря библиотеке машинного обучения CatBoost Спеллер может расшифровывать искажённые до неузнаваемости слова («адникасниеи» → «одноклассники») и учитывать контекст при поиске опечаток («скучать музыку» → «скачать музыку»). Может показаться, что Спеллер идеален для нашей задачи, но нет.

Спеллер (который внутри известен как поисковый опечаточник) уже на уровне архитектуры заточен для решения совершенно другой задачи: помогать пользователям восстановить корректную форму запроса. В Поиске не так важно, верно ли подобран падеж, проставлена заглавная буква или запятая. Там важнее по поисковому запросу «Хамингуэль» догадаться, что человек имел в виду Хемингуэя.

Ошибки в заголовках делают относительно грамотные люди, которые вряд ли напишут «Хамингуэль». А вот неверное согласование («рейс задержалась»), пропущенные слова («молодой человек пытался автомобиль») и лишние заглавные буквы («Президент Банка») — обычное дело. Наконец, бывает формально верное предложение «В Пскове отремонтирую улицу Горького», к которому нормальный опечаточник не придерётся (ну а вдруг это обещание автора?), — но это очевидно испорченный новостной заголовок. Кроме того, в Новостях задача ставилась не такая, как в Поиске: не исправить опечатки и ошибки, а обнаружить их.

У нас были и другие варианты, например модели, основанные на DSSM (если интересно, то об этом подходе мы коротко рассказывали в посте про алгоритм Палех), но и они имели ограничения. Например, не идеально учитывали порядок слов.

В общем, готовые инструменты или не подходили для нашей задачи, или были ограниченными. А значит, надо создавать свой собственный — тренировать свою модель. И это был хороший повод поработать с технологией BERT, которая стала доступна разработчикам в 2018 году и демонстрировала впечатляющие результаты.

Знакомство с BERT

Основная проблема современных задач обработки естественного языка (NLP) — найти достаточно размеченных людьми примеров, чтобы обучить нейросеть. Если вам нужен рост качества, то обучающая выборка должна быть очень большой — миллионы и миллиарды примеров. При этом задач в NLP много и все они разные. Собрать данные в подобных объёмах под каждую задачу долго, дорого, а зачастую невозможно. Даже для крупнейших компаний в мире.

Но есть вариант обойти эту проблему — с помощью обучения в два этапа. Сначала долго и дорого на огромном корпусе в миллиарды слов нейросеть учат структуре языка (это pre-training). Потом сеть быстро и дёшево подкручивают под конкретную задачу — например, для разделения отзывов на плохие и хорошие (это fine-tuning). Хватит каких-нибудь 10 тысяч примеров, размеченных в Толоке.

На этой идее и основана технология BERT (Bidirectional Encoder Representations from Transformers). Сама идея не нова и применялась раньше, но есть существенное отличие. Transformer — это такая архитектура нейросетки, которая позволяет учитывать весь контекст сразу, включая другой конец предложения и причастный оборот где-нибудь в середине. И в этом её отличие от предыдущих модных архитектур, которые учитывали контекст. Например, у нейросети LSTM длина контекста — в лучшем случае десятки слов, а тут все 200.

На GitHub доступен исходный код на TensorFlow и даже предобученная универсальная модель на 102 языка, от русского до волапюка. Бери, казалось бы, решение из коробки — и получай результат немедленно. Но нет.

Оказалось, что универсальная модель на русских текстах показывала существенно меньшее качество, чем английская модель, бьющая рекорды на английских текстах (что, согласитесь, логично). На русских текстах она проигрывала нашим внутренним моделям на DSSM.

Окей, предобучиться можно и самим — к счастью, русских текстов и опыта в машинном обучении у Яндекса хватает. Но есть нюанс. Обучаться надо год!

Дело в том, что BERT заточена под тензорные процессоры Google (TPU), поэтому из коробки умеет работать только с одной видеокарточкой (GPU). И распараллелить в лоб с помощью какого-нибудь horovod нельзя: перебрасывать с карты на карту 400 мегабайт данных на каждом шаге очень дорого, распараллеливание станет бессмысленным. Что делать?

Оптимизация

Начали искать любые идеи и решения, способные значительно ускорить дело. В первую очередь обратили внимание на то, что каждое число в нашей модели занимало 32 бита памяти (стандартный float для чисел в компьютере). Вроде бы мало, но когда у вас 100 миллионов весов, то это критично. Такая точность нам не везде была нужна, поэтому мы решили частично перевести числа в 16-битный формат (это то, что называется mixed precision training).

Попутно с помощью множества напильников и костылей прикрутили XLA-компиляцию, опираясь на тогда ещё сырой коммит NVIDIA. Благодаря этому наши карточки NVIDIA Tesla V100 (небольшой сервер из них стоит как квартира в недорогом районе Москвы) смогли в полной мере раскрыть свой потенциал за счёт 16-битной арифметики на Tensor Cores.

Нас интересовали только русскоязычные заголовки, но мультиязыковая модель, которую мы взяли за основу, обучена на сотне языков, включая даже искусственный волапюк. Слова всех языков, переведённые в векторное пространство, хранились в модели. Причём взять и просто так удалить их оттуда нельзя — пришлось попотеть, чтобы сократить размер словаря.

И ещё кое-что. Если ты учёный и твой компьютер стоит под столом, то ты можешь всё там перенастроить под каждую конкретную задачу. А в реальном вычислительном облаке, где тысячи машин сконфигурированы одинаково, достаточно проблематично, например, пересобирать ядро под каждую новую фичу TensorFlow. Поэтому мы потратили немало усилий на то, чтобы собрать такие версии пакетов, которые и умеют все новомодные фишки, и не требуют радикального обновления и перенастройки видеокарт в облаке.

В общем, выжимали все соки везде, где могли. И у нас получилось. Год превратился в неделю.

Обучение

Собрать правильный датасет — обычно самая трудная часть работы. Сначала мы учили классификатор на трёх миллионах заголовков, размеченных толокерами. Вроде бы много, но только 30 тысяч из них — с опечатками. Где взять ещё примеров?

Мы решили поглядеть, какие заголовки исправляют сами СМИ. Таких за всю историю Яндекс.Новостей набралось больше 2 миллионов. Бинго! Хотя радоваться было рано.

Оказалось, что очень часто СМИ переделывают заголовки не из-за ошибок. Выяснились новые детали — и редактор заменил одну правильную формулировку другой. Поэтому мы ограничились только исправлениями с разницей между версиями до трёх букв (хотя и здесь некоторый шум остался: было «нашли двоих» — стало «нашли троих»). Так мы набрали миллион опечаток. Обучились сначала на этой большой подборке с шумом, а затем на небольшой толокерской разметке без шума.

Качество

В подобных задачах принято измерять точность и полноту. В нашем случае точность — это доля правильных вердиктов среди всех вердиктов об ошибке в заголовке. Полнота — доля заголовков с ошибками, которые мы поймали, среди всех заголовков с ошибками. И то и другое в идеальном мире должно стремиться к 100%. Но в задачах машинного обучения эти показатели, как правило, конфликтуют. То есть чем сильнее выкручиваем точность, тем больше падает полнота. И наоборот.

В нашем предыдущем подходе на базе DSSM мы уже добились точности 95% (то есть 5% ложноположительных вердиктов). Это уже достаточно высокий показатель. Поэтому мы решили сохранить такой же уровень точности и посмотреть, как с помощью новой модели изменится полнота. И она подскочила с 21 до 78%. И это определённо успех.

Здесь можно было бы поставить точку, но я помню про обещание рассказать об attention.

Нейросеть с фломастером

Принято считать, что нейросеть — это такой чёрный ящик. Мы подаём что-то на вход и получаем что-то на выходе. А почему и как — загадка.

Это ограничение призваны обойти интерпретируемые нейронные сети. BERT — одна из них. Её интерпретируемость заключается в механизме attention. Грубо говоря, в каждом слое нейросетки мы повторяем один и тот же приём: смотрим на соседние слова с разным «вниманием» и учитываем взаимодействие с ними. Например, когда нейросеть обрабатывает местоимение «он», то «внимательно смотрит» на существительное, к которому «он» относится.

Картинка ниже показывает разными оттенками красного, на какие слова «смотрит» токен, который накапливает информацию обо всём заголовке для финального слоя-классификатора. Если опечатка в слове — attention подсвечивает его, если слова рассогласованы — то оба (и, возможно, зависимые от них).

В этом месте, кстати, можно разглядеть возможности нейросетей в полный рост. Ни на одном этапе обучения наша модель не знает, где именно находится опечатка в примере: она знает только, что весь заголовок неправильный. И всё равно она выучивает, что «школа на 1224 мест» писать неправильно из-за несогласованного числительного, — и подсвечивает конкретно цифру 4.

На опечатках мы не остановились и начали применять новый подход не только для поиска ошибок, но и для определения устаревших заголовков. Но это уже совсем другая история, с которой мы надеемся вернуться на Хабр в ближайшем будущем.

Полезные ссылки для тех, кто хочет углубиться в тему

- TensorFlow code and pre-trained models for BERT

- Open Sourcing BERT: State-of-the-Art Pre-training for Natural Language Processing

- TPUs vs GPUs for Transformers (BERT)

- The Illustrated Transformer

- NVIDIA Achieves 4X Speedup on BERT Neural Network

Разбираемся, как на сайте найти страницы с ошибкой 404: расширения, плагины, приложения и программы

Один из главнейших факторов, который отталкивает пользователя от сайта ,— это появление страниц с ошибкой 404 Not Found. Появление таких ошибок негативно сказывается на отношении к сайту с точки зрения поисковых систем Яндекса и Google.

Надежная платёжка, низкие комиссии | 100 бесплатных карт на тест

Во-первых, из-за этого внешние ссылки теряют свой вес, что ухудшает ранжированность и всего сайта.

Во-вторых, теряется вес внутренней перелинковки — особенно при круговой перелинковке — что также снижает трастовый вес других, действующих страниц.

Почему появляется ошибка 404

Наиболее частотный случай появления такой ошибки вызван неправильным вводом адреса страницы со стороны пользователя. Однако здесь ничего нельзя поделать — повлиять на них и научить вводить правильные адреса проблематично. Поэтому, очевидно, стоит сосредоточиться на других вариантах — когда появление 404 ошибки вызвано проблемами на стороне сайта.

Таких проблем может быть две:

- Страница по каким-либо причинам была удалена;

- У страницы был изменен URL без настройки редиректа на новый — поэтому абсолютно все внешние ссылки на такую страницу перестали быть рабочими.

Как уже было сказано выше, такие страницы нужно находить и ошибки исправлять. Сделать это можно несколькими способами.

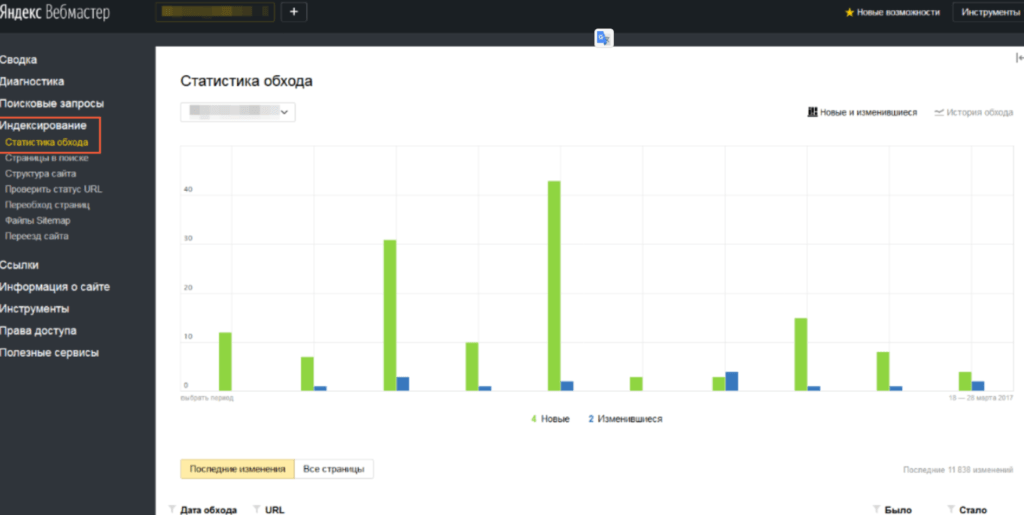

Поиск ошибки 404 через Яндекс Вебмастер

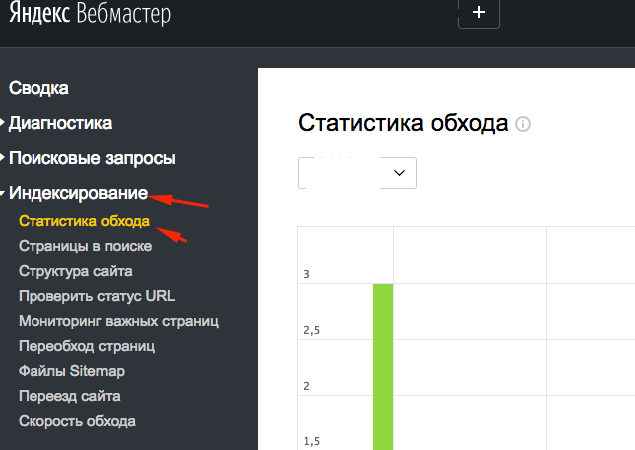

У Вебмастера есть специальный инструмент для поиска ошибок 404. Для этого вам будет достаточно перейти в раздел «Индексирование» → «Статистика обхода»

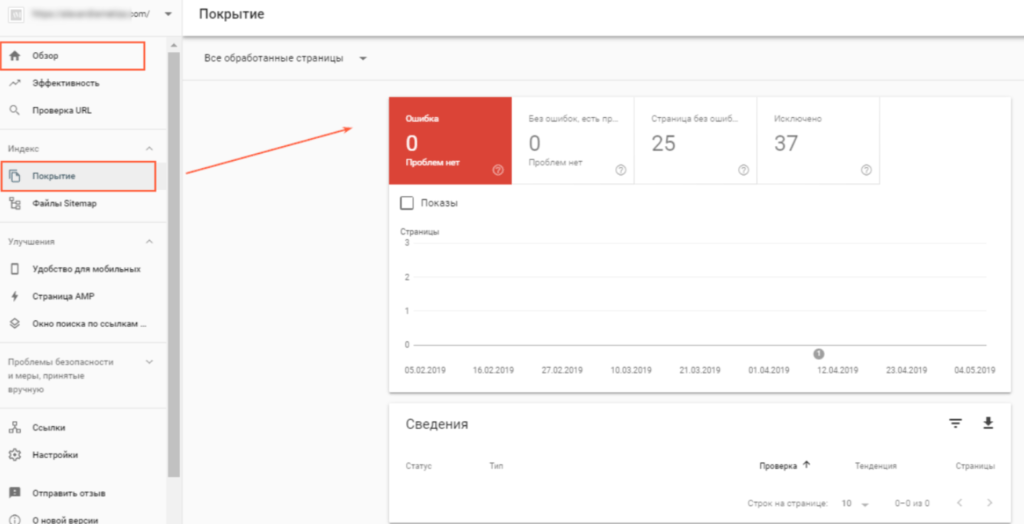

Поиск ошибки 404 в панели вебмастеров Google

Аналогичная возможность поиска 404 ошибки представлена и у Google. Для этого нужно открыть раздел «Обзор» и перейти там во вкладку «Покрытие». Здесь будут сразу представлены все страницы с ошибкой, которые были найдены поисковой системой.

Необходимо отметить, что это достаточно быстрый и удобный способ поиска страниц с ошибкой 404. Однако ни Яндекс, ни Google не находят их все. Поэтому есть смысл попробовать воспользоваться другими способами.

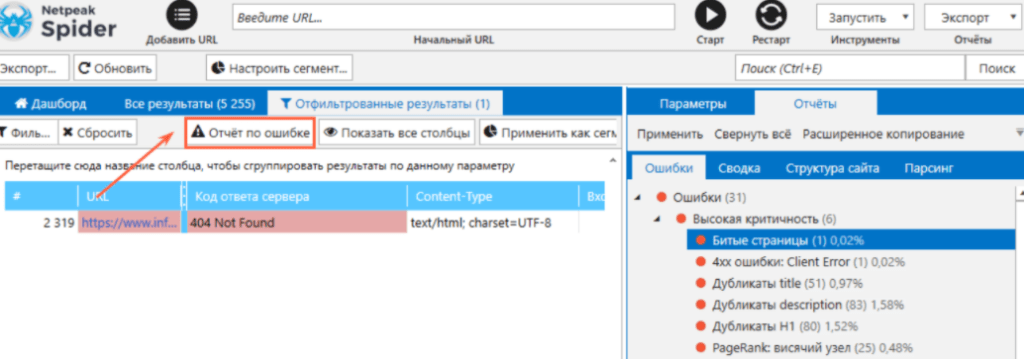

Поиск ошибки 404 с помощью программы Netpeak Spider

Если у вас уже установлен этот сервис, то вы сможете легко найти все ошибки 404 на вашем сайте.

Последовательность действий такая:

- Откройте программу;

- Во вкладке «Параметры» выберите «Минимум», чтобы искать только 404 ошибку;

- Нажмите старт.

В полученном отчете будут указаны два параметра:

Это непосредственно сами страницы с ошибкой 404 и, что очень важно, ссылки, которые ведут на такие страницы.

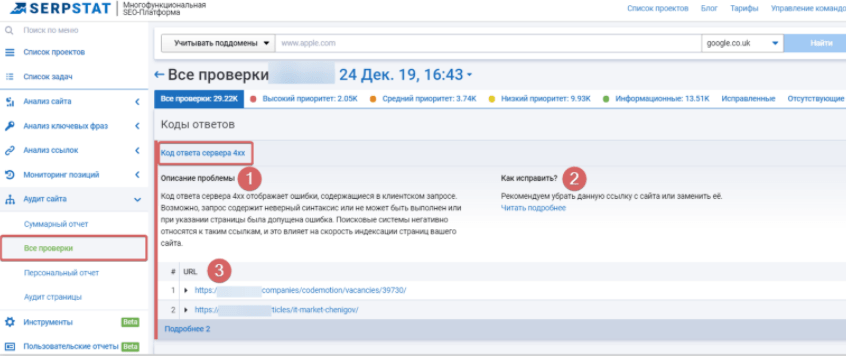

Поиск ошибки 404 с помощью сервиса Serpstat

- Пройдите процесс регистрации и добавьте свой сайт в проект;

- В колонке «Аудит сайта» нажмите «Запустить аудит»;

- Нажмите «Начать анализ».

После завершения обработки откройте отчет «Код ответа: 4xx». Там вы найдете все страницы с ошибкой 404.

Что делать с ошибкой 404

Порядок действий достаточно прост:

- Все ссылки на страницы с 404 ошибкой нужно заменить на рабочие;

- Если ссылку заменить не получится (например, потому что страница была удалена), то и ссылку нужно просто удалить.

Проверьте, не нужно ли удалить страницу с такой битой ссылкой из индекса поисковых систем, чтобы Яндекс и Google перестали приводить к вам пользователей на несуществующую страницу.

Однако полностью избавиться от появления 404 ошибки у вас не получится — ведь довольно часто ошибка появляется по причине того, что сами пользователи неверно вводят URL.

Однако и здесь вы сможете максимально улучшить опыт использования вашего сайта. Для этого достаточно наполнить страницу с 404 ошибкой полезной информацией:

- Дайте ссылку на главную страницу;

- Выложите другую полезную информацию;

- Дайте доступ к возможности поиска по сайту;

- Если это необходимо, оставьте свои контакты для связи.

Благодаря этому пользователю не захочется убежать сразу же с вашего сайта и начать искать информацию где-нибудь ещё.

Заключение

Ошибка 404 может серьезно повлиять на трафик вашего сайта, поэтому так важно вовремя ее «найти и обезвредить». Посему мы советуем вам регулярно проводить подобные «облавы» — то есть проверки на наличие ошибок. Тем самым вы позитивно повлияете на отношение к вашему сайту как с точки зрения поисковиков, так и пользователей.

Как проверить сайт на ошибки и их исправить

21.05.2018

Шутки ради: Тебе не нужно исправлять ошибки на сайте – если у тебя нет сайта.

Содержание:

- Как найти ошибки на сайте через Яндекс Вебмастер

- Поиск мусорных страниц и ошибок

- Продолжаем искать ошибки на сайте

- Исправляем ошибки: дубликаты страниц

- Исправляем ошибки: находим и убираем «битые ссылки»

- Исправляем ошибки: Оптимизация картинок

- Исправляем ошибки: Два заголовка H1

- Исправляем ошибки: Отсутствие заполненных мета тегов

Сайты без ошибок и с быстрой скоростью загрузки могут получить ТОП даже без ссылок. Конечно поисковые системы отдают предпочтения сайтам которые хорошо оптимизированы имеют четкую и понятную структуру для поисковых роботов.

О поисковых роботах

У поисковых систем есть специальные роботы которые посещают ваш сайт и скачивают всю информацию о странице и ее данных, а именно заголовок страниц, название статей и других метатегов Их несколько видов и вот самые основные на примере Яндекса:

- YandexBot — основной робот Яндекса, обходит и скачивает всю информацию;

- YandexImages – индексирует картинки для поиска;

- YandexBlogs — робот поиска по блогам исоциальным сетям;

- YandexWebmaster – приходит придобавлении сайта через форуму Веб Мастер;

- YandexPagechecker – проверяет ошибки в разметке сайта;

- YandexFavicons — индексатор фавиконок картинок в браузере

Поисковые роботы ежеминутно и ежедневно проводят обновления своей базы обновляя поисковую выдачу новыми данными и на благодаря им вы получаете более свежую и актуальную информацию, например о свежих новостях. Они сортируют информацию и сохраняют в соответствующий раздел своего сервера по специальным метатегам.

А если там ошибки, то и поисковый робот не может правильно разметить информацию на сайте и понять о чем та или иная страница. Уже исправив ошибки на сайте можно начать получать трафик из поисковой выдачи.

Вот например в рекомендациях от Яндекс написано:

- Необходимо поддерживать четкую внутреннюю ссылочную структуру.

- Использовать карту сайта (sitemap) для роботов.

- Ограничение служебных страниц в robots.txt, а информации в специальные закрывающие от индексации <noindex>.

- Быть внимательнее с движками (CMS) для сайта. Они грузят поиск ненужными техническими страницами и битыми ссылками.

Как найти ошибки на сайте через Яндекс Вебмастер

Чтобы исправить ошибки на сайте их во первых нужно найти =) Для этого добавляем сайт в сервис Яндекс Вебмастер, предварительно зарегистрировав почту на Яндекс .

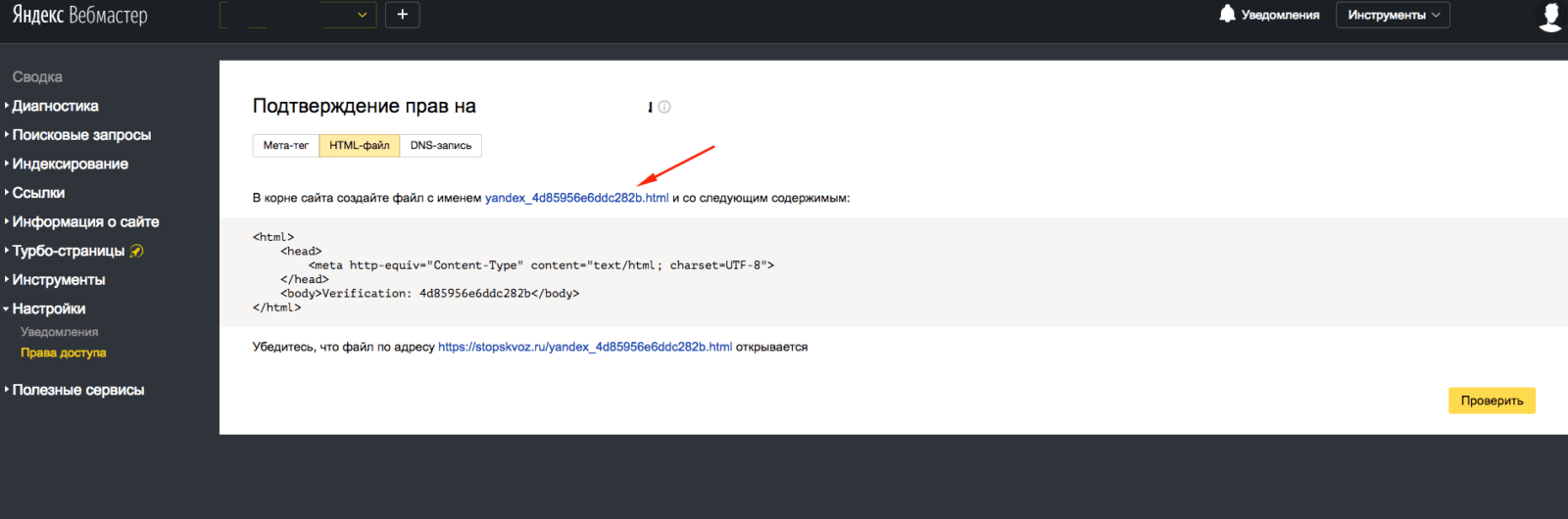

После чего вам предложат подтвердить права на сайт тремя разными способами, то есть доказать сервису что домен принадлежит вам.

Лично мне проще загрузить файл через FTP клиент (скачать можно тут) поэтому я выбираю этот способ.

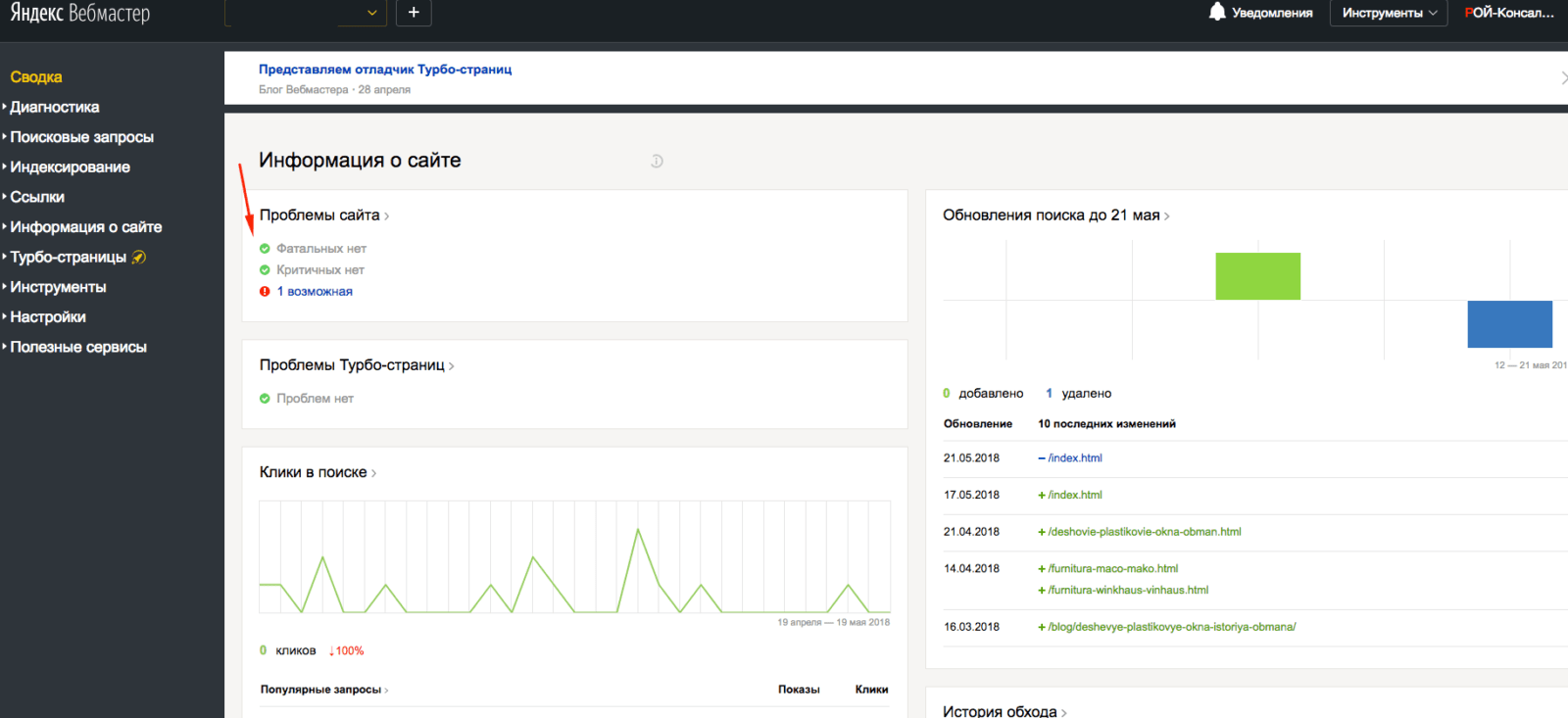

После загрузи этого файла на ваш сервер с сайтом нажмите кнопку подтвердить и подождите пока информация обновиться по вашему сайту. Это происходит как за несколько часов так до нескольких дней.

После чего выполняем рекомендации и например как в моем примере заполняем <description> на те которые сам покажет инструмент Яндекс Вебмастер.

Приоритет обязательно отдавайте Фатальным и Критичным ошибкам ведь они на прямую влияют на ранжирование сайта.

Удобство Яндекс Вебмастер заключается в том, что там понятным языком написано что нуждается в доработке, а также предложено решение по исправлению, ну а если появятся вопросы, то задавайте их в комментариях.

Углубляемся в поиск мусорных страниц и ошибок

В Веб Мастере есть замечательная функция и находится она в разделе Индексирование > Статистика обхода.

Тут мы видим все страницы куда заглядывает поисковый робот и какую информацию он скачал для поисковой системы, ошибки, редиректы и прочую нужную информацию.

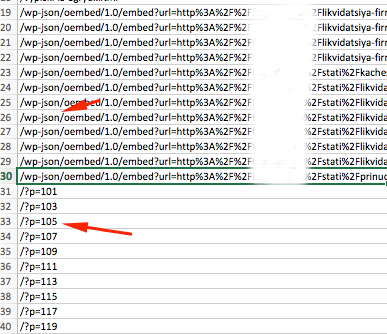

Внизу с права есть функция выгрузки этих данных для удобства работы в Exel. Выгружаем, открываем, сомотрим.

Чтобы нам не просматривать одни и те же страницы, рекомендую воспользоваться функцией удаление дубликатов а колонке A.

Все технические, информационные, мусорные страницы должны быть запрещены к индексации в robots.txt, но сначала выпишите их в отдельный текстовой документ. О настройке файла robots.txt мы будем говорить в следующей статье (Части 3).

Вот например технические страницы движка WordPress. Это папка /wp-json/ и все что с ней связано, а также страницы /?p=. Такие страницы тянут сайт внизу, так как поисковые системы думают что сайт захламлен техническими данными и за ним никто не смотрит, а значит доверия к ним меньше.

Просмотрите все страницы, выпишите «мусорные» страницы и сохраните в текстовом файле, они нам потребуются позднее.

Продолжаем искать ошибки на сайте

Тут нам уже понадобиться определенный софт, например Netpeak Spider. Очень удобная программа причем «условно» бесплатная. В ней есть 14 дней тестового доступа без ограничения функционала. Эти две недели с «головой» хватит для аудита простого сайта. Вот ссылка https://netpeaksoftware.com/ru/spider

Инструмент позволит найти:

Битые ссылки – то есть ссылки на несуществующие страницы сайта и выдающие ошибку 404 (отсутствие страницы). Ссылки на несуществующие страницы тянут сайт вниз, такая как поисковая система думает что сайтом не занимаются и понижают в выдаче.

- Дубликаты страниц и текста – страницы с дублирующимся контентом плохо или вообще не получают трафик (посетителей). Поиск просто не может понять на какую страницу вести пользователя и иногда исключает из выдаче обе страницы.

- Находит страницы без внутренних ссылок – как известно весь интернет это миллиарды ссылок если с вашей страницы невозможно уйти на другую то образуется «тупик» или по-другому «висячий узел», что негативно влияет на получение трафика на страницу.

- Отсутствие заполненных мета тегов – очень важный инструмент для поискового робота. Именно по ним робот получает информацию о чем ваш сайт или конкретная страница. Нет мета тегов – нет трафика.

- Максимальный размер изображения – скорость загрузки сайта напрямую зависит от его оптимизации, а если картинка или фотография загружается по 20-30 секунд это никуда не годится.

- Одинаковые мета теги Title и H1 – Делайте теги с максимальным вхождением ключевого запроса о котором страница, но все хорошее в меру. По умолчанию рекомендуемый максимальный размер тега H1 не более 65 символов, а тега title не более 120.

Исправляем ошибки: дубликаты страниц

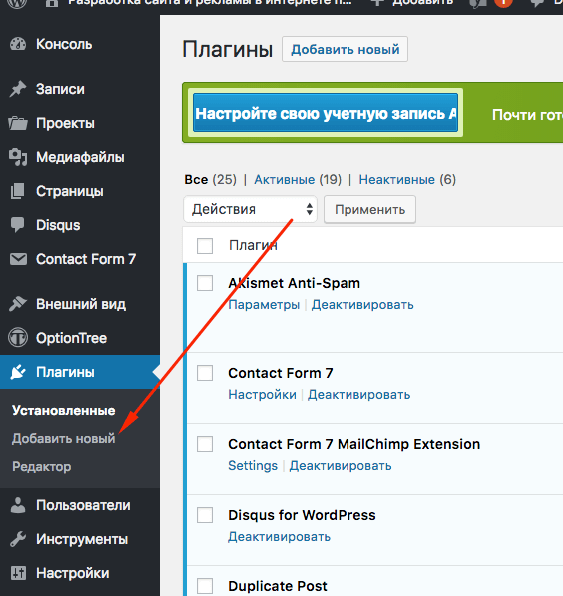

Дубликаты страниц нужно удалить или поставить с них 301 редирект. Если у вас сайт на движке CMS WordPress то вам поможет плагин «Перенаправления». Скачать вы его можете в админ панели во вкладке Плагины > Добавить новый.

Или сделайте через файл .htaccess, просто добавив в него следящий текст

RewriteCond %{REQUEST_URI} ^/test/$RewriteRule ^.*$ http://site.ru/new-test/? [R=301,L]

Где в первой строчке /test/ это с какой страницы, а на второй строчке куда переводить.

Исправляем ошибки: находим и убираем «битые ссылки»

Если вы не видите «битые» то есть ведущие на несуществующие страницы ссылки, то это не значит, что поисковой робот их не видит.

Принцип работы поискового робота как раз заключается в переходе по каждой ссылке и получение информации о следующей странице, а если страница не существует то сервер выдает ошибку.

Вывод: сайтом не занимаются. Итог: понижение в выдаче. Результат: Отсутствие посетителей.

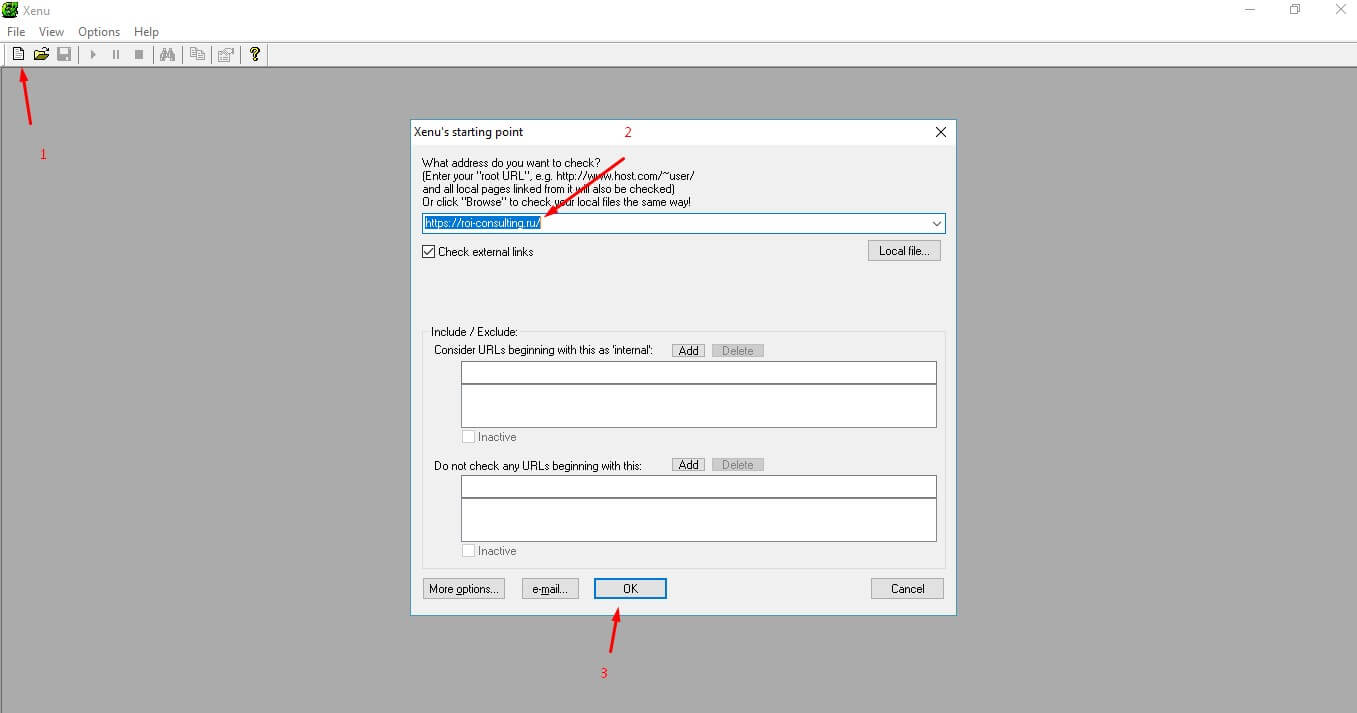

Для поиска битых ссылок также можно использовать бесплатную программу Xenu. Она проста в использовании и понятна.

Убираем ссылки на несуществующие страницы. При использовании «дивижка» сайта убрать ссылку не составит труда. Заходим в редактирование страницы с битой ссылкой и убираем ссылку.

Если движок отсутствует, то заходим через FTP доступ на сервер и редактируем страницу вручную. Нам необходимо найти ссылку в коде страницы.

Ссылка имеет вот такой HTML код:

<a href=»ссылка на страницу»>ТЕКСТ ССЫЛКИ</a>

Убираем весть HTML код кроме «ТЕКСТ ССЫЛКИ», тем самым мы уберем ссылку и избавимся от ошибки.

Исправляем ошибки: Оптимизация картинок

Чем быстрее грузится сайт, тем лучше. Для этой проверки есть специальные сервисы, например бесплатные от Google Page Speed Insights. Он не только покажет скорость сайта, но и каждой страницы в отдельности.

В 70% случаев причина медленной загрузки страницы это неоптимизированные картинки, а остальные 30% это скрипты, сервер и само программирование.

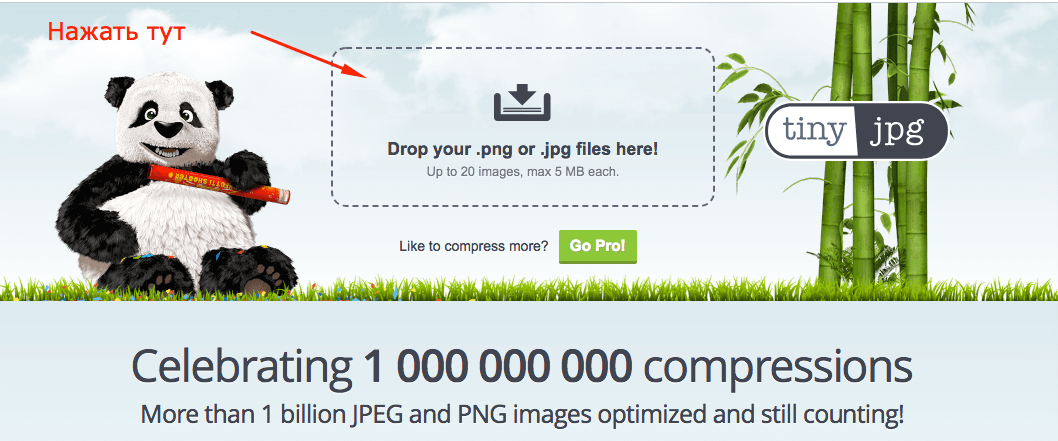

Каждую картинку необходимо сделать меньшим объемом и без потеря качества. Для оптимизации можно воспользоваться сервисом https://tinyjpg.com/.

Необходимо загрузить картинку на сервис, а потом скачать оптимизированную картинку и заменить ее на самом сайте.

Готово! И так должно быть с каждой картинкой.

Исправляем ошибки: Два заголовка H1

Этот мета тег на должен быть на странице только один, то есть в коде он должен встречать один раз. Найти его можно открыв HTML код страницы. Если вы используете браузер Chrome делается это комбинациями клавиш Ctrl + U.

Дальше проверяем саму страницу. Ищем мета тег H1. Нажимаем сочетание клавиш Ctrl+F и вводит в поиск h1 или <h1 если тегу присвоен класс.

Если вы находите более одного тега h1 то это ошибка и ее нужно исправлять.

Скажу сразу, если нет навыков в HTML сайта и знания CSS то рекомендую обратиться к программисту для исправления этой ошибки.

Каждый заголовок имеет свой класс, а соответственно и вид отображения на странице, но можно попробовать заменить в коде h1 на h2. Если это повлияло на отображение сайта, то верните все обратно и обратитесь к программисту. Стоимость таких работ от 200 до 500 рублей.

Исправляем ошибки: Отсутствие заполненных мета тегов

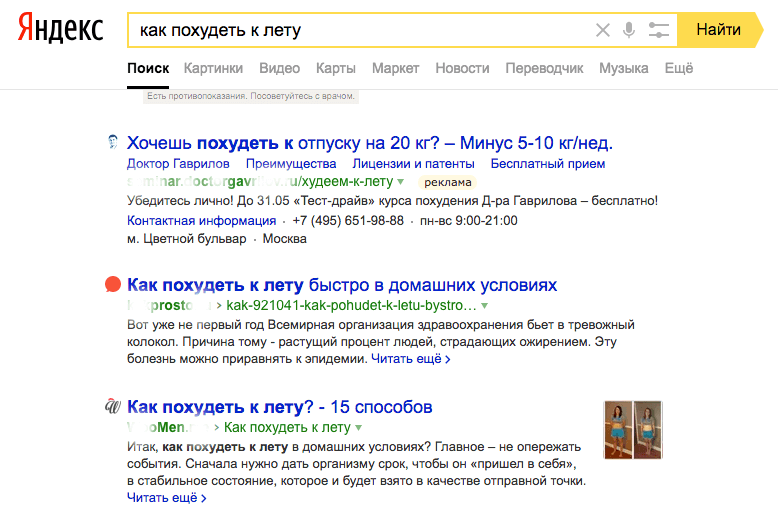

Тут все просто. Заполните данные основываясь на самой информации которую несет страница. Если страница о «как похудеть к лету», то рекомендую делать заголовки и title «цепляющими». Ведь именно title видят пользователи поисковиком.

Чтобы не ломать голову воспользуйтесь контекстной рекламой. Конечно не в прямом смысле, а введите продвигаемый запрос и посмотрите выдачу.

Теперь генерируем например вот так: Как похудеть к лету – 10 килограмм в домашних условиях!

Если у Вас остались вопросы задайте их в комментариях, обязательно отвечу на них, теперь переходим дальше: Продвижение сайта — настройка robots.txt — часть 3

Автор: Аграчев Михаил

Как сообщить о нарушении в Яндекс (поиск)

Яндекс — мощная поисковая система, естественно, что злоупотреблений и нарушений в нём достаточно. От этого ни одно предприятие не застраховано. Если хотите пожаловаться на нарушения в Поиске, то в самом низу страницы мелкими буквами есть ссылка Обратная связь. Там достаточно материалов, несложно разобраться. Постарайтесь максимально обойтись предложенной информацией, что не беспокоить техподдержку Яндекса глупыми вопросами.

- Оставить отзыв об интерфейсе поисковой выдачи в Яндексе можно по этой ссылке.

- Прочитать про сетевое мошенничество в этой статье (фишинг, подмена файла hosts, поддельные сайты, sms развод)

- Пожаловаться на спам или вирусы на сайте, найденном в поиске Яндекса — форма (поисковый спам, фишинг, нежелательное ПО, вирусы). Так что жаловаться на говносайты (дорвеи, клоакинг и другие нарушения рекомендаций Яндекс) нужно здесь.

- Яндекс заблокирован (подозрение на вирус) — форма.

- Общий раздел Помощи по всем продуктам Яндекса — ссылка.