Диагностика сайтов от Яндекс.Вебмастера: возможные проблемы, рекомендации, фатальные и критические ошибки

Яндекс.Вебмастер быстро обнаружит существующие проблемы и подскажет, как предотвратить возможные ошибки на вашем сайте. Оценка состояния и рекомендации по его улучшению доступны в разделе «Диагностика».

Что мешает работе сайта, что поможет ускорить его индексирование, есть ли угрозы безопасности пользователей — Вебмастер автоматически проверяет страницы более чем по 25 параметрам, сортируя проблемы по значимости:

· Фатальные и критичные: могут привести к исключению всего сайта или некоторых его страниц из результатов поиска. Такие ошибки лучше отслеживать и исправлять как можно скорее.

· Возможные: вероятно, из-за внесения этих изменений качество и скорость индексирования страниц сайта улучшатся.

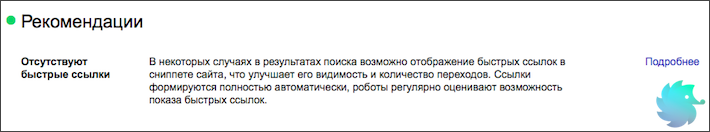

· Рекомендации: в этом разделе появляются не отчеты об ошибках, а советы о поддержке и развитии сайта.

Информация обо всех найденных ошибках хранится в специальном разделе, пока вы их не исправите. Описание проблемы сопровождается подсказкой, как её устранить. Не забудьте сообщить Яндексу об изменениях на сайте, если в Вебмастере появилась кнопка «Я всё исправил».

Чтобы оперативно получать отчеты об ошибках и всегда быть в курсе проблем и рекомендаций, не забудьте настроить уведомления Вебмастера. Доступный для события вид уведомлений (пуши, письма или внутри сервиса) обозначен в соответствующей колонке — нажмите на значок для активации подписки. По умолчанию мы высылаем уведомления только о фатальных и критичных ситуациях.

P. S. Подписывайтесь на наши каналы

Блог Яндекса для Вебмастеров

Канал Яндекса о продвижении сайтов на YouTube

Канал для владельцев сайтов в Яндекс.Дзен

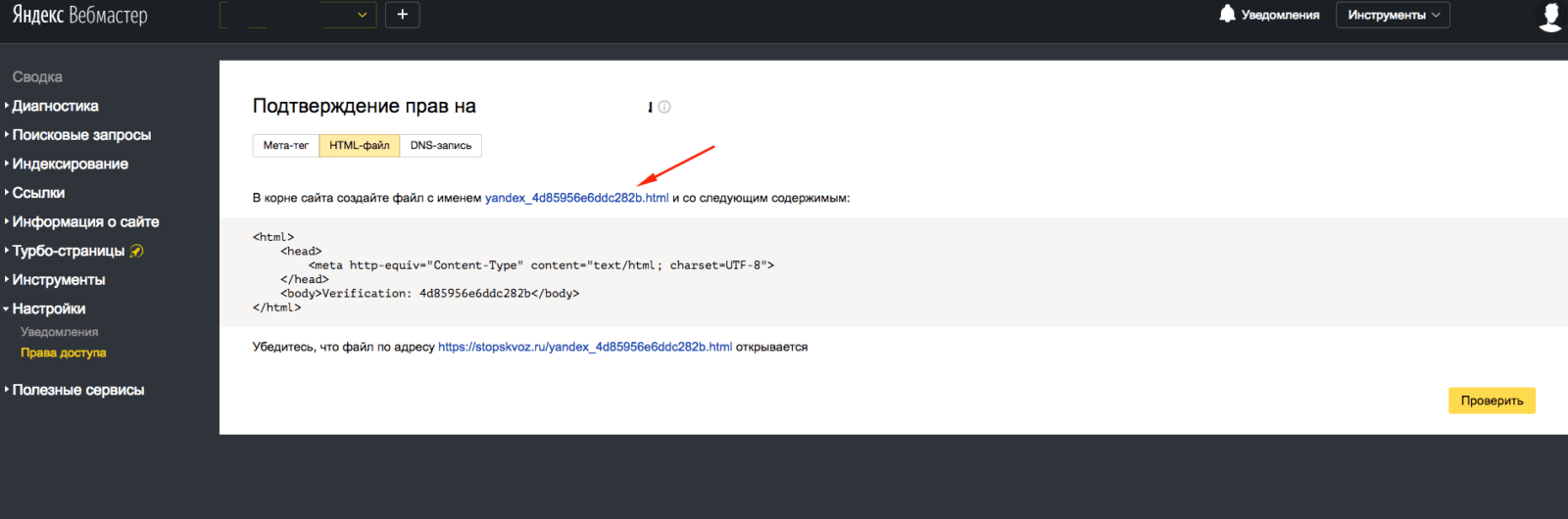

В самом начале SEO-продвижения сайта специалист обязан «уведомить» поисковые системы о наличии сайта в индексе и оценить, какие проблемы отображает Яндекс или Google по своим стандартам. Сайт добавляется в Вебмастер – сервис Яндекса, в котором содержится панель инструментов для оценки качества индексации сайта. Этот инструмент находится по URL-адресу: https://webmaster.yandex.ru/. Верификация осуществляется тремя способами:

- Добавление соответствующего кода в тег «head».

- Размещение файла Вебмастера сайта в корневой папке проекта.

- Добавление TXT-записи верификации в DNS домена сайта.

Если домен новый и ни разу не проверялся Яндексом, необходимо подождать несколько дней, чтобы сформировался предварительный отчет и на панели можно было обнаружить ошибки. Их необходимо устранять в кратчайшие сроки.

В данной статье рассмотрим самые частые ошибки Вебмастера Яндекса и приведём рекомендации по их устранению.

Содержание:

- Категории проблем

- Фатальные ошибки

- Критичные ошибки

- Возможные ошибки

- Рекомендации

- Вывод

Категории проблем

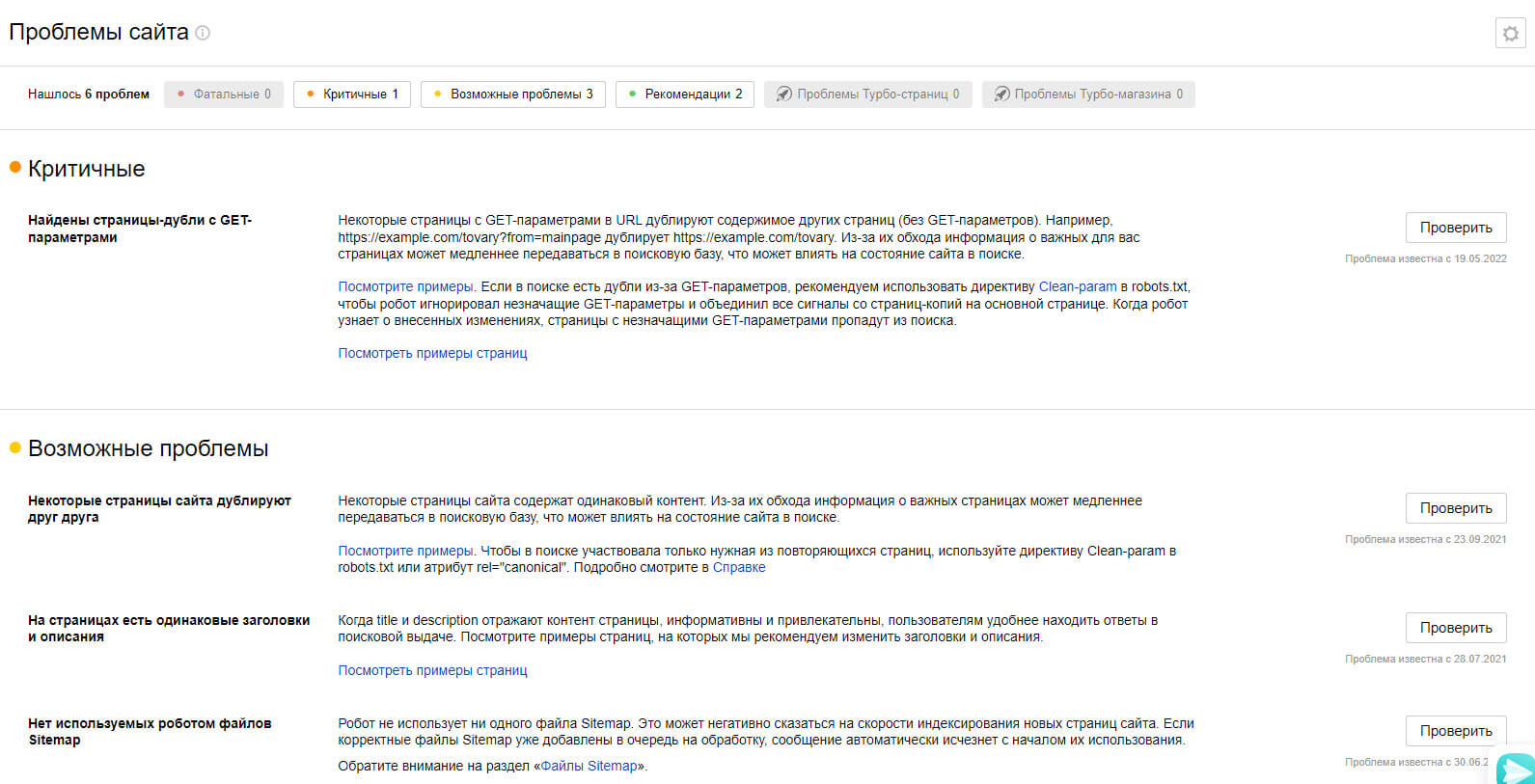

Ошибки проверяемого сайта указаны в разделе «Диагностика сайта». Существует 4 категории ошибок, которые фиксирует Яндекс и сообщает об этом пользователю:

- Фатальные — отображаются возможные проблемы с подключением сайта к серверу, его корректной настройкой, доступностью для последующего индексирования, соблюдением правил безопасности и общих правил поисковой системы.

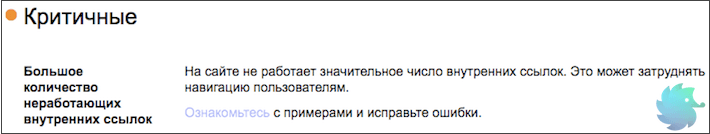

- Критичные — выдаются проблемы с настройкой SSL-сертификата (он отвечает за безопасное HTTPS-соединение, важный фактор в SEO-оптимизации), ссылками с 404-ошибкой и скоростью ответа сервера на запрос.

- Возможные — потенциальные проблемы, которые влияют на общее качество сайта для потенциальных пользователей и скорость обхода отдельных страниц сайта – правильная настройка XML-карты, наличие файла robots.txt, разрешение на обход внутренних страниц через статистику из Метрики (настройка параллельного отслеживания данных со счетчика статистики), наличие дублирующихся страниц.

- Рекомендации — общая информация для улучшения представления сайта в поиске.

Как правило, все ошибки и рекомендации важно закрывать и исправлять, а при выполнении вовремя уведомлять системы через кнопку «Проверить». Также рекомендуется отправить отредактированные страницы на переобход (раздел «Индексирование», далее – «Переобход страниц»).

Рассмотрим подробнее все варианты и пути для исправления.

Фатальные ошибки

Уведомления о наличии такого рода проблем могут появляться в следующих ситуациях:

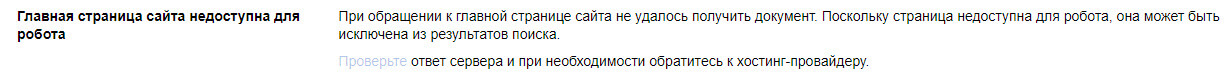

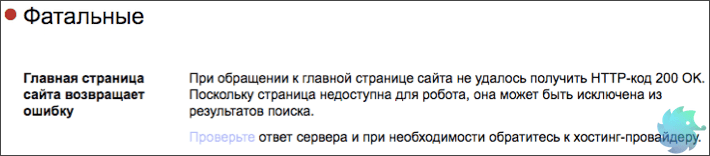

«Главная страница возвращает ошибку»

Проблема отображается, если главная страница не выдает корректный ответ сервера — «200 ОК», это можно проверить в разделе «Инструменты» — «Проверка ответа сервера». Причины могут быть разные — страница закрыта от индексации, произошел сбой в настройке сервера, главная страница перенаправлена на другую страницу (для нее настроен редирект).

Для исправления необходимо проверить файл robots.txt на наличие правила «Disallow» для главной страницы или убрать тег noindex в метатеге robots в коде главной страницы.

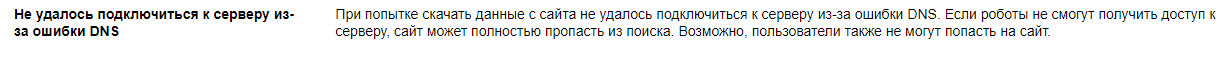

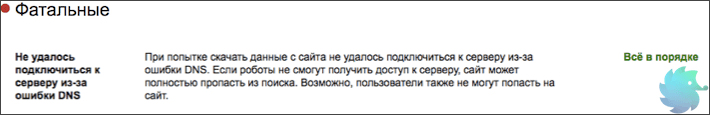

«Не удалось подключиться к серверу из-за ошибки DNS»

Это означает, что при индексировании поисковый робот не смог получить IP-адрес сервера, на котором расположены файлы сайта. Адрес присваивается хостинг-провайдером и указывается в панели управления DNS-записями. При корректной настройке ответ сервера для ресурса – «200 ОК». В случае неполадки следует обращаться к хостинг-провайдеру.

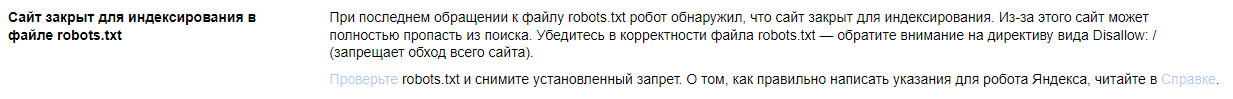

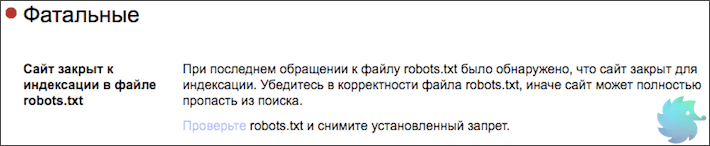

«Сайт закрыт от индексирования в файле robots.txt»

Зачастую такая ошибка возникает после переноса готового проекта с тестового домена (откуда велась разработка) на основной. В файле robots.txt обычно в таких случаях прописывается правило «Disallow: /», означающая закрытие от индексации абсолютно всех страниц сайта. Чтобы устранить эту ошибку, требуется просто удалить эту строку из файла для всех элементов User-Agent.

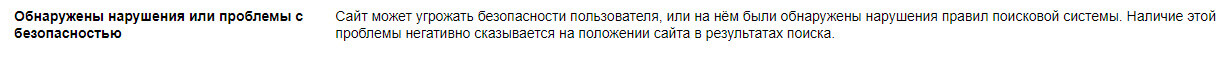

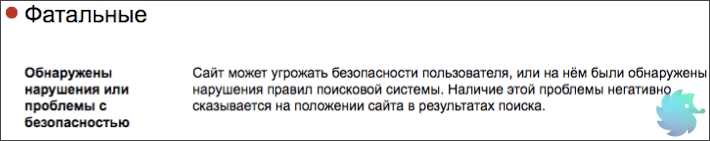

«Обнаружены нарушения или проблемы с безопасностью»

В эту категорию фатальных проблем попадают сайты, замеченные за нарушениями, которые противоречат правилам поисковиков, среди таких нарушений могут быть:

- переспамленные SEO-тексты;

- обман Яндекса с целью манипуляции выдачей в топе поиска;

- чрезмерная закупка SEO-ссылок — наличие большого количества внешних ссылок, закупленных в течение недавнего времени;

- дорвеи — наличие сквозного веб-ресурса, который за счет мощного трафика перенаправляет пользователей на продвигаемый сайт;

- майнинг

- малополезный контент;

- фишинг — сбор конфиденциальной информации, логинов, паролей, данных для связи

- «черные» и «серые» методы продвижения, связанные с манипуляцией поведенческими факторами или большим количеством автоматических переходов (накрутка ботами), применяемая не только некоторыми SEO-оптимизаторами, но и недобросовестными конкурентами.

Чтобы узнать точный ответ, что именно исправлять, необходимо перейти в раздел «Безопасность и нарушения» и нажать на кнопку с вопросительным знаком. Далее от SEO-шника требуется внимательно исправить ошибку, чтобы после устранения проблемы в том же разделе нажать кнопку «Я всё исправил». Проблем должна исчезнуть, в противном случае придется ждать минимум 3 месяца.

Критичные ошибки

Рассматриваемые проблемы могут стать причиной понижения позиций по продвигаемым запросам по отдельным страницам или для всего сайта.

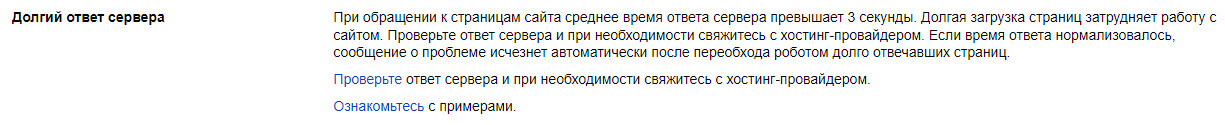

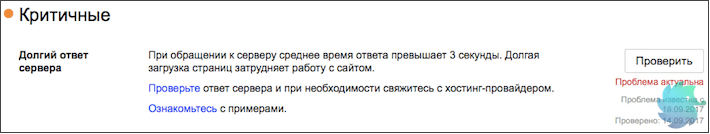

«Долгий ответ сервера»

В данном случае страницы долго отвечают на запросы поискового робота. Для проверки скорости прямо в Вебмастере можно использовать инструмент «Проверка ответа сервера». Оптимальное время для корректной работы — не более 3-х секунд. В противном случае необходимо настроить кэширование ресурса, устранить ошибки и добавить ресурс на хостинге, а также сократить число запросов к базе данных.

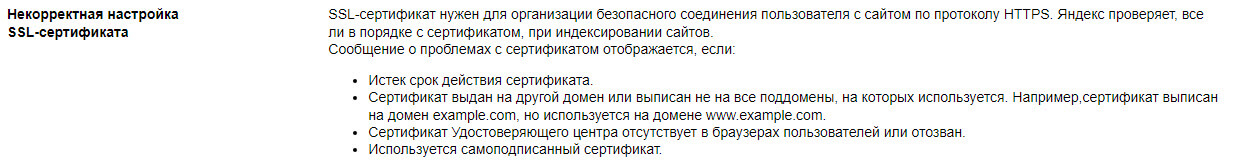

«Некорректная настройка SSL-сертификата»

Для безопасного соединения ресурса с пользователем с возможностью предоставления информации используется SSL-сертификат, обеспечивающий защищенное HTTPS-соединение. Критическая проблема может появиться в следующих случаях:

- Истек срок действия — требуется продление;

- Сертификат был аннулирован по причине проблем в удостоверяющем центре — заменить на корректный и работающий на всех популярных браузерах;

- Сертификат оформлен на дублирующийся домен — заменить на актуальный адрес и заодно настроить перенаправление;

- Использование самописного SSL — заменить на один из популярных и работающих.

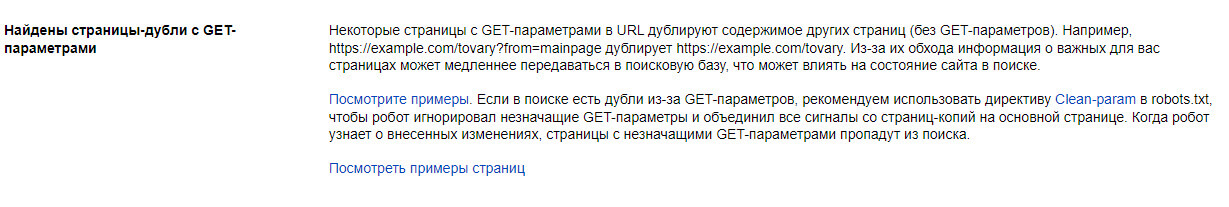

«Найдены страницы-дубли с GET-параметрами»

К проблеме относятся дубли страницы с одинаковым содержимым, но доступные по разным URL-адресам. Это или страницы без перенаправления на правильный адрес или содержащие GET-параметр, связанный с динамической ссылкой для сервера.

Для исправления необходимо добавить правило «Clean-param:» в файл robots.txt или разместить в теге «head» атрибут rel=”canonical” с отображением правильной версии страницы. Проблема «уходит» автоматически через несколько дней.

Возможные ошибки

Самый распространенный вид, к которым относятся небольшие проблемы при SEO-оптимизации.

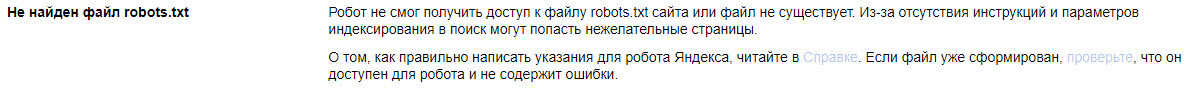

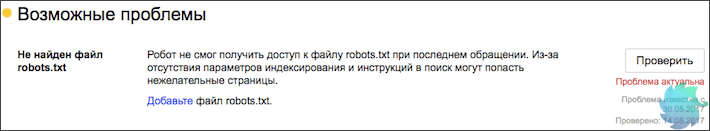

«Не найден файл robots.txt»

Данный файл нужен для определения правил индексирования для поисковых роботов, что можно включать в выдачу, а что — нельзя. Иногда бывает, что Вебмастер может случайно сообщить об ошибке, даже если файл размещен в корневой системе сайта. В таком случае нужно нажать кнопку «Проверить» и в течение 2-3 дней уведомление удалится.

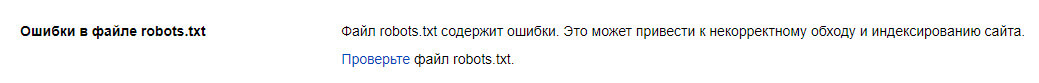

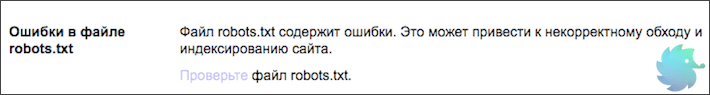

«Обнаружены ошибки в файле robots.txt»

Необходимо через Вебмастер проверить на наличие ошибок файл robots.txt, который закрывает часть страниц от индексирования. Для исправления требуется еще раз проверить документ на правильную настройку директив.

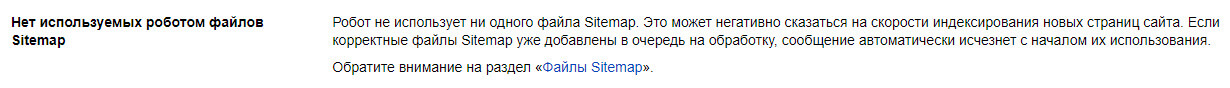

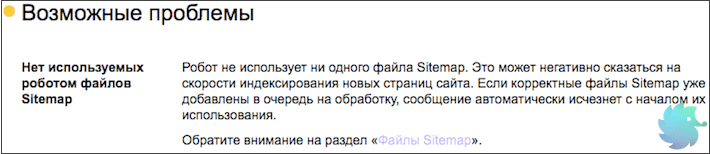

«Нет используемых роботом файлов Sitemap»

Sitemap.xml представляет собой список всех страниц сайта, который считывает поисковая система, загружая в свою базу новые страницы. Для устранения проблемы нужно создать и загрузить на сервере файл (через специальные сервисы, например SiteAnalyzer, а также стандартный SEO-плагин в CMS), указать в панели Вебмастера ссылку на карту («Индексирование» — «Файлы Sitemap»), а также скопировать путь к файлу и отметить в файле robots.txt.

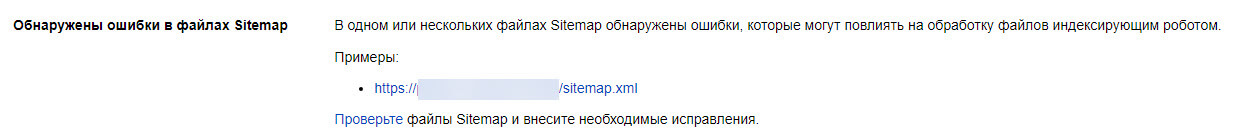

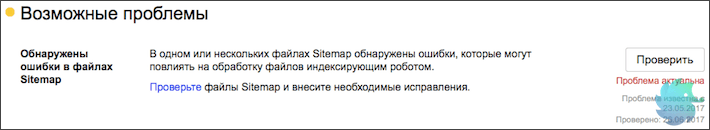

«Обнаружены ошибки в Sitemap»

В Вебмастере есть компонент «Анализ файлов Sitemap», с помощью которого можно проверить все строки файла на ошибки и устранить их. Вносить изменения рекомендуется, даже несмотря на то, что при наличии проблем поисковая система не блокирует весь файл, а игнорирует незнакомые инструкции.

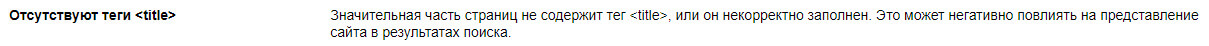

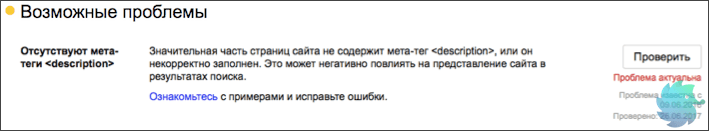

«Отсутствуют элемент title и метатег description»

Теги title и description необходимы для соответствия ресурса запросу пользователя. С их помощью поисковая систем формирует сниппет — краткое описание сайта в выдаче. Метатеги обязательны к заполнению.

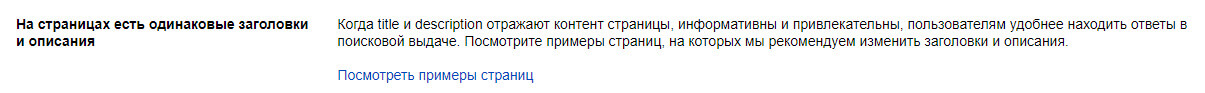

«На страницах имеются одинаковые заголовки и описания»

Метатеги title и description должны быть не только заполнены, но и различимы между собой. Рекомендация исчезнет после изменений и последующей проверки роботом, рекомендуется указать ссылки на измененные страницы в разделе для переобхода.

«Файл favicon недоступен для робота»

В данном случае иконка не всегда показывается в результатах поиска (в зависимости от браузера). Посмотрите причину: ответ сервера не «200 ОК» — проверьте ссылку, причина может быть в неправильном значении данных в параметре type.

Рекомендации

В этой категории отображаются предложения по улучшению позиций сайта.

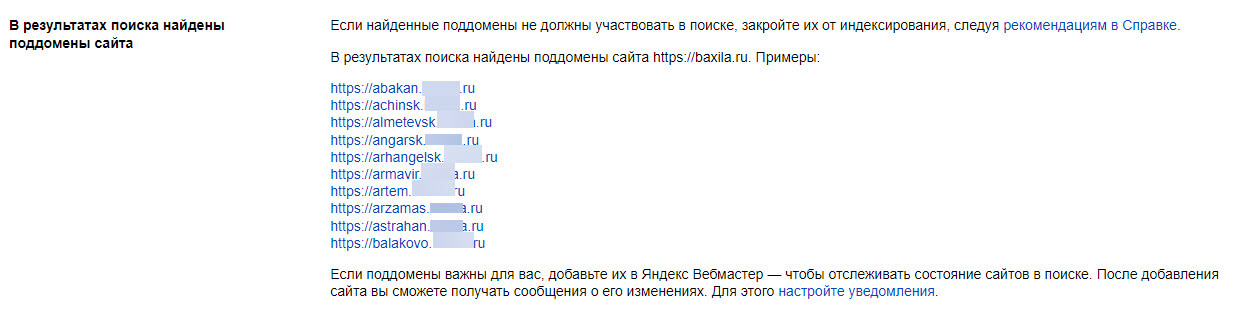

«В результатах поиска найдены поддомены»

Если в проекте имеются региональные поддомены, их также нужно добавлять в Вебмастер в качестве отдельных ресурсов, а в разделе «Региональность» присвоить геопривязку через карточку компании в Яндекс.Бизнес и добавление ссылки на страницу «Контакты», где указан фактический адрес. Для поддоменов дополнительная верификация не требуется – достаточно просто добавить проект на уже подтвержденный аккаунт для основного зеркала сайта.

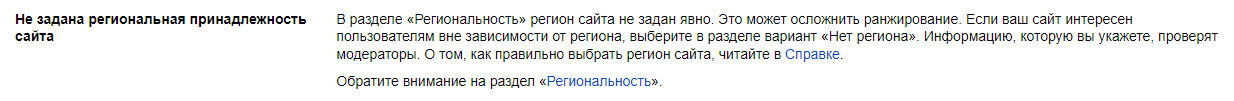

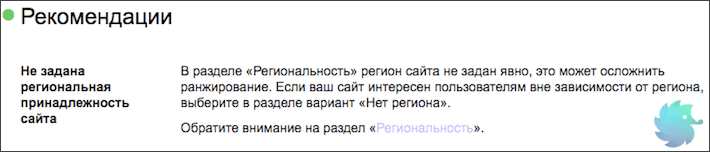

«Не задана региональная принадлежность сайта»

В блоке «Региональность» нужно указать регион (город или субъект), чтобы лучше отображать продвигаемый сайт по геозависимым запросам, когда пользователь ищет товар или услугу, не указывая регион в поисковой строке, а находясь в нем.

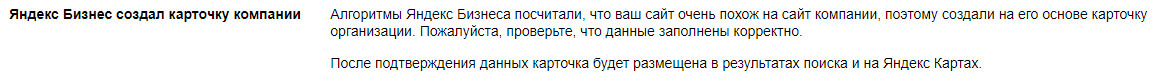

«В Бизнесе подготовлена карточка организации»

Сервис «Яндекс.Бизнес», с помощью которого можно создавать карточки компании для отображения, например, в картах, может автоматически сформировать профиль на основе контента, особенно это относится к новым сайтам. В данном случае необходимо проверить и подтвердить содержимое карточки.

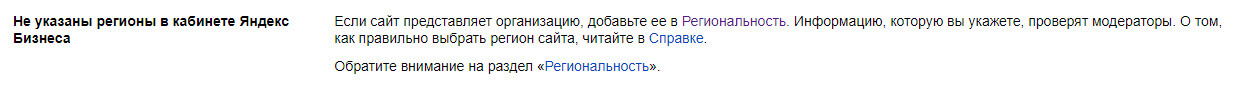

«Не указаны регионы в Яндекс Бизнесе»

Проблема относится к профилю в «Яндекс.Бизнесе». Необходимо выполнить все условия для правильного отображения карточки:

- данные заполнены на 90% и более (получена специальная «галочка» о том, что владелец компании подтвердил все указанные данные);

- указано главное зеркало сайта;

- с момента создания карточки прошло больше 1 недели.

Если все условия выполнены, рекомендация пропадет из раздела диагностики.

«Файл favicon не найден»

В качестве рекомендации может выпасть не только отсутствие favicon, но и его правильный формат – с расширением «.svg» или размером от 120х120 пикселей.

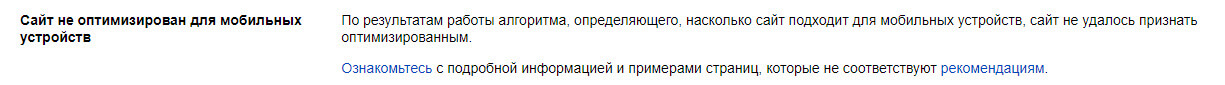

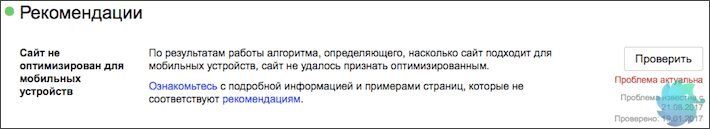

«Сайт не оптимизирован для мобильных устройств»

Чтобы увидеть замечания, необходимо перейти в раздел «Инструменты» — «Проверка мобильных страниц» и ознакомиться с рекомендациями от Яндекса, которые мешают корректному отображению мобильной версии сайта. Если все изменения были сделаны или ошибок не обнаружено, можно нажать кнопку «Проверить» для дополнительного анализа со стороны робота.

Вывод

При обнаружении ошибок в Яндекс.Вебмастере особое внимание уделите фатальным и критическим ошибкам – они напрямую влияют на работоспособность сайта и могут обрушить позиции сайта по продвигаемым запросам на несколько страниц вниз. Для устранения ошибок желательно привлекать технического специалиста (программиста или разработчика). Возможные проблемы относятся больше к компетенции SEO-специалистов и требуют чуть больше времени на исправления — все зависит от размера сайта.

К рекомендациям также следует присматриваться, чтобы успешно конкурировать с сайтами в топе поиска и улучшать коммерческие и поведенческие факторы.

Вкратце о диагностике сайта

Фатальные

- Сайт закрыт к индексации в файле robots.txt

- Не удалось подключиться к серверу из-за ошибки DNS

- Главная страница сайта возвращает ошибку

- Обнаружены нарушения или проблемы с безопасностью

Критичные

- Долгий ответ сервера

- Большое количество неработающих внутренних ссылок

Возможные проблемы

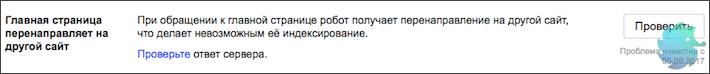

- Главная страница перенаправляет на другой сайт

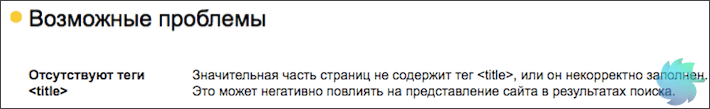

- Отсутствуют теги <title>

- Ошибки в файле robots.txt

- Не найден файл robots.txt

- Отсутствуют мета-теги <description>

- Некорректное отображение несуществующих файлов и страниц

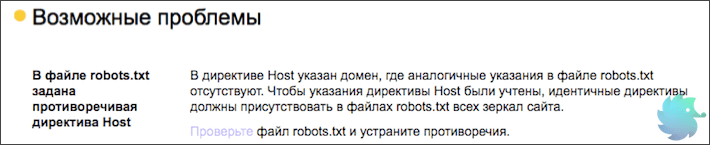

- В файле robots.txt задана противоречивая директива Host

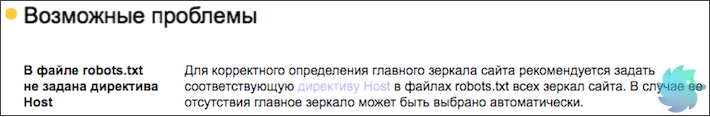

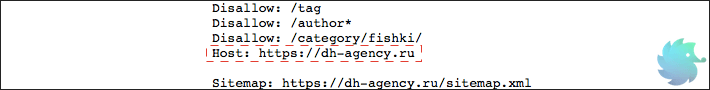

- В файле robots.txt не задана директива Host

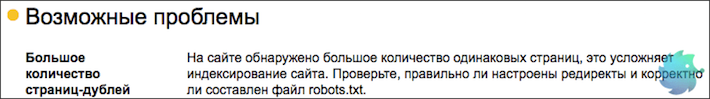

- Большое количество страниц-дублей

- Нет используемых роботом файлов Sitemap

- Обнаружены ошибки в файлах Sitemap

- Файлы Sitemap давно не обновлялись

Рекомендации

- Не задана региональная принадлежность сайта

- Сайт не оптимизирован для мобильных устройств

- Ошибка счётчика Яндекс.Метрики

- Сайт не зарегистрирован в Яндекс.Справочнике

- Отсутствует файл favicon на сайте

- Отсутствуют быстрые ссылки

Вкратце о диагностике сайта

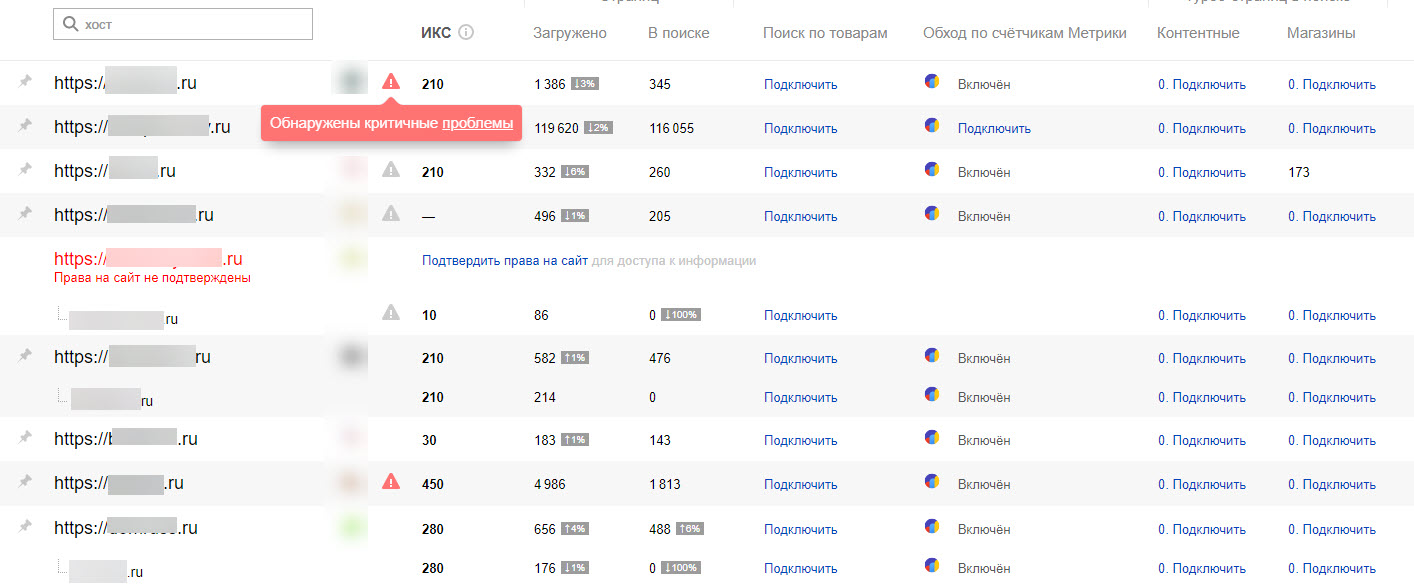

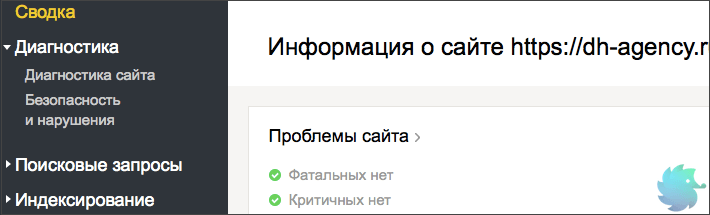

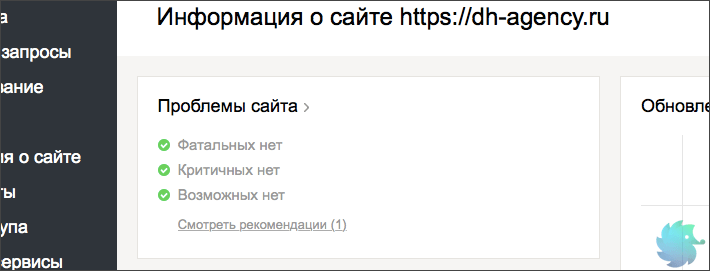

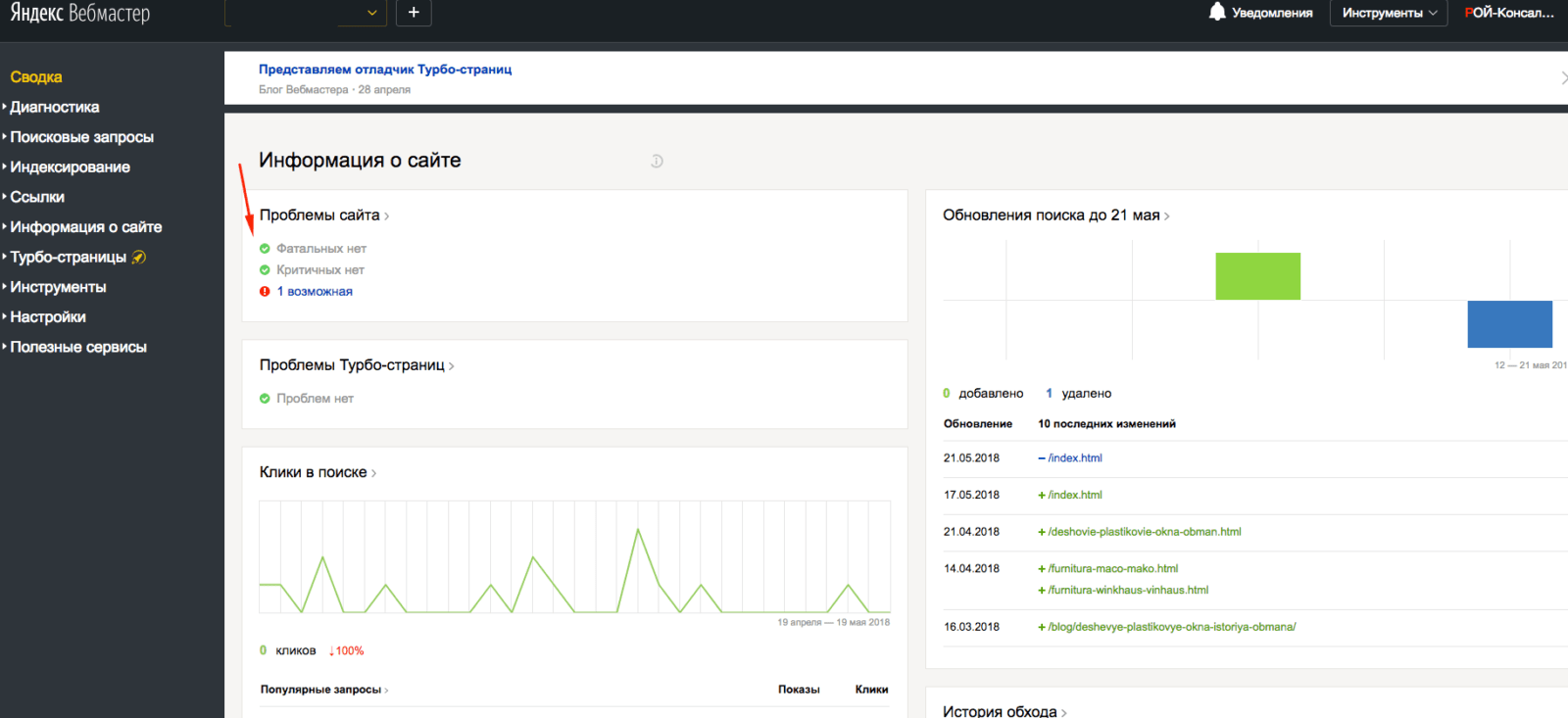

В этой статье мы подробно опишем большинство самых популярных проблем, которые выдает диагностика сайта от Яндекса. Напомним, что раздел диагностики находится в Yandex Webmaster на второй вкладке в левом меню.

Краткую информацию о наличии проблем возможно найти в левом верхнем блоке на главной странице Вебмастера.

Прежде, чем рассказывать о каждой проблеме отдельно, поясним общую информацию. Яндекс разделил все ошибки на 4 вида:

-

Фатальные — то есть, те, которые несовместимы с отображением сайта в поисковой выдаче. Наличие таких ошибок, скорее всего, приведет к полному исключению сайта из поиска. Среди них — запрет индексации, различного рода санкции со стороны поисковиков, серьезное нарушение безопасности или неработоспособность сайта;

-

Критичные — то есть, те, которые серьезно затрудняют удобство пользования сайтом, его корректную работу или индексацию. Наличие таких ошибок вряд ли приведет к исключению ресурса из поисковой выдачи, но может сильно снизить видимость;

-

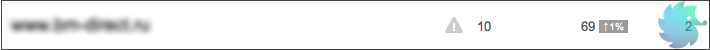

Возможные — то есть, те, которые влияют на удобство пользователей, отображение и корректную индексацию. Подобные ошибки стоит устранить для улучшения сайта и повышения видимости в органической выдаче. В общем списке сайтов Вебмастера возможные проблемы обозначаются серым восклицательным знаком.

-

Рекомендации — носят исключительно рекомендательный характер. Обычно направлены на улучшение сайта или отображения.

Фатальные проблемы

Решать фатальные проблемы нужно немедленно, иначе они приведут к исключению сайта из поисковой выдачи. Подобные ошибки справедливы не только для Яндекса, но и для всех остальных поисковых систем. Ниже мы опишем каждую из них в отдельности, а так же предложим варианты решения.

Сайт закрыт к индексации в файле robots.txt

«При последнем обращении к файлу robots.txt было обнаружено, что сайт закрыт для индексации. Убедитесь в корректности файла robots.txt, иначе сайт может полностью пропасть из поиска.» © Яндекс Вебмастер

Очень серьезная, но легко решаемая проблема. Причиной ее появления может стать банальная ошибка в синтаксисе файла robots.txt или ненамеренный запрет индексации. Зачастую такую ошибку можно увидеть у новых сайтов, так как разработчики обычно закрывают ресурс для индексации и не всега открывают обратно.

Поправить это очень просто. Открываем свой robots.txt по ссылке ваш_домен/robots.txt и проверяем содержимое. Если в нем расположен код следующего содержания:

User-agent: *

Disallow: /

или

User-agent: Yandex

Disallow: /

То, просто заменяем его на шаблонные инструкции для Вашей CMS или прописываем уникальные вручную.

Подробнее о настройке файла robots.txt

Не удалось подключиться к серверу из-за ошибки DNS

«При попытке скачать данные с сайта не удалось подключиться к серверу из-за ошибки DNS. Если роботы не смогут получить доступ к серверу, сайт может полностью пропасть из поиска. Возможно, пользователи также не могут попасть на сайт.» © Яндекс Вебмастер

Данная проблема решается уже не так быстро, как предыдущая. Суть ее проста. Индексирующий робот Яндекса попросту не смог получить доступ к сайту. То есть, корректная индексация уже невозможна. Если краулер, при повторных обращениях, будет продолжать получать ошибку, то сайт рано или поздно исключат из поиска.

В данном конкретном случае, лучше всего будет обратиться к разработчикам сайта или хост-провайдеру (регистратору доменного имени.) Если Вы не профессионал, то можете потерять много драгоценного времени в попытках разобраться в произошедшем. Помните, что фатальные ошибки нужно решать незамедлительно.

Главная страница сайта возвращает ошибку

«При обращении к главной странице сайта не удалось получить HTTP-код 200 OK. Поскольку страница недоступна для робота, она может быть исключена из результатов поиска.» © Яндекс Вебмастер

При обращении к главной странице сайта робот ожидает ответ 200 ОК. Только при его получении продолжается корректная индексация.

Если Вы столкнулись с вышеупомянутой проблемой, то вот несколько причин ее появления.

-

Неверно настроен ответ главной страницы. К примеру, главная может отдавать 404 Not Found или 403. Что для нее не корректно. Определить ответ можно в Яндекс Вебмастере, при помощи инструмента «проверка ответа сервера«;

-

Для главной страницы может быть настроен 301 редирект;

-

Главная страница сайта может технически отсутствовать, что редкость.

Решается проблема путем проверки наличия страницы и ее ответа. Для разработчиков сайта устранить данную ошибку не составит никакого труда.

Обнаружены нарушения или проблемы с безопасностью

«Сайт может угрожать безопасности пользователя, или на нём были обнаружены нарушения правил поисковой системы. Наличие этой проблемы негативно сказывается на положении сайта в результатах поиска.» © Яндекс Вебмастер

Одна из самых сложно решаемых проблем. Причин ее появления может быть множество. Вот основные из них:

-

Сайт был взломан и на нем находится вредоносный код. Это может быть вирусный рекламный баннер, вставки iframe, различного рода трояны, а так же множество другой гадости;

-

Сбор, обработка или передача данных пользователей сделана насколько некорректно, что индексирующий робот заподозрил в этом мошеннические намерения;

-

Сайт не соответствует правилам поисковой системы. То есть, имеет запрещенный контент, обманывает или вводит в заблуждение пользователей, подменяет материал и т.д.;

Стоит сказать, что данная проблема может появляться у очень молодых сайтов из-за темного прошлого доменного имени. Обязательно проверяйте домен перед покупкой.

Однако, не стоит беспокоиться и переделывать сайт, если Вы уверены в его корректной работе. Подобное сообщение может появляться по ошибке. Если это так, то оно автоматически пропадет через несколько обновлений.

Критичные проблемы

На критичные проблемы стоит сразу обратить внимание и начать искать решение. Их появление скорее всего не приведет к исключению из поиска, однако может серьезно повлиять на видимость сайта.

Долгий ответ сервера

«При обращении к серверу среднее время ответа превышает 3 секунды. Долгая загрузка страниц затрудняет работу с сайтом.» © Яндекс Вебмастер

Это одна из основных причин неполной (некорректной) индексации. Робот отводит на каждый сайт определенное количество секунд, после чего переходит к следующем ресурсу. Если ответ сервера слишком долгий, то времени на загрузку страниц может просто не остаться.

Что бы решить эту проблему, необходимо обратиться к администратору сервера или хост-провайдеру. Возможно, Вашему сайту просто не хватает выделенных для работы ресурсов.

Если данное сообщение появилось, а потом пропало без видимых причин, не стоит его игнорировать. Обязательно проверьте скорость ответа сервера, а так же параметры загрузки сайта. Наличие подобной проблемы влияет на индексацию вне зависимости от того, есть сообщение в Вебмастере или его нету.

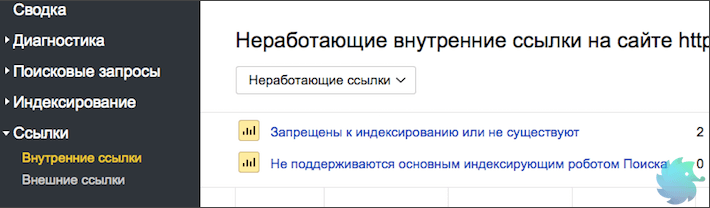

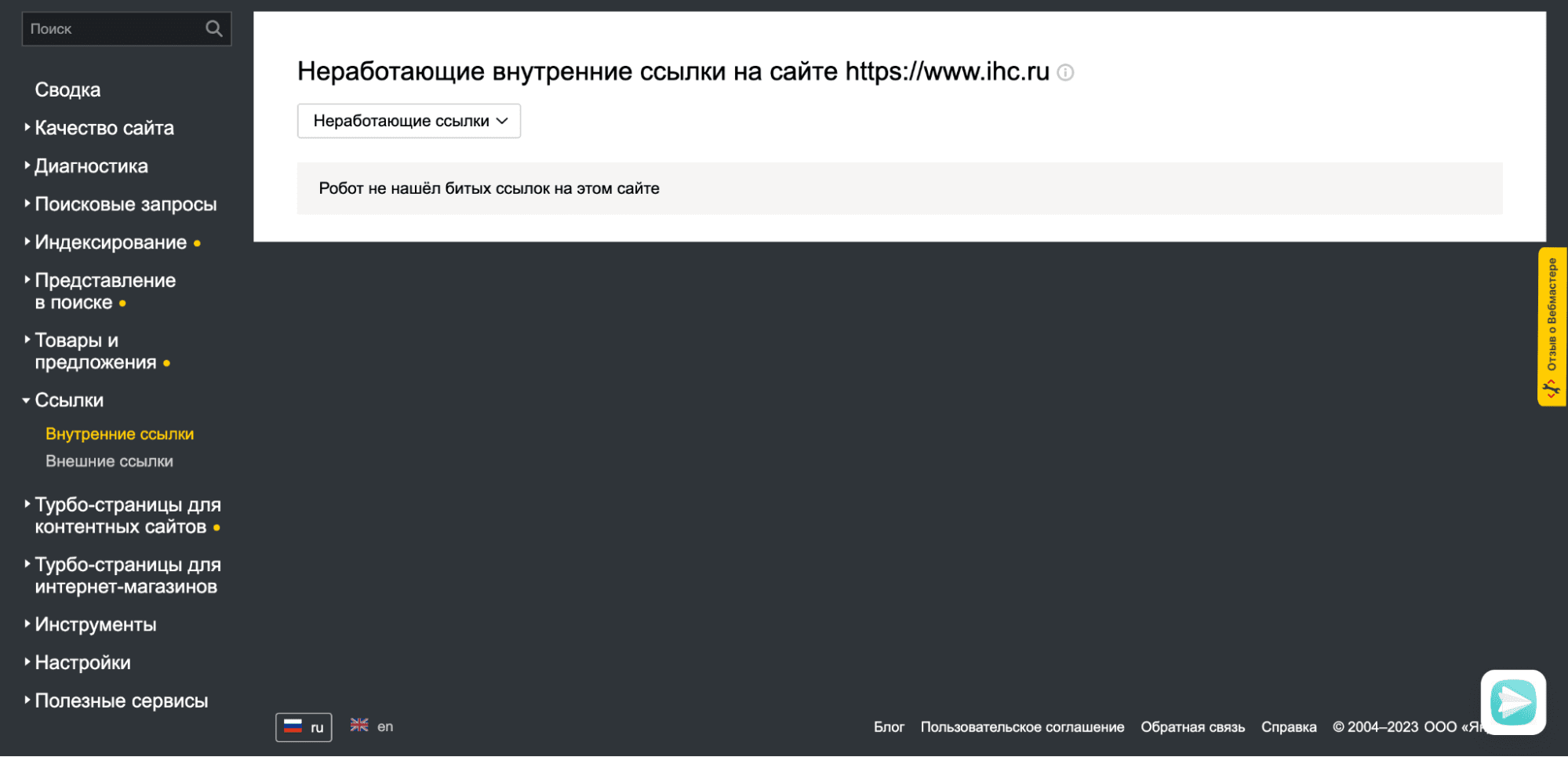

Большое количество неработающих внутренних ссылок

«На сайте не работает значительное число внутренних ссылок. Это может затруднять навигацию пользователям.» © Яндекс Вебмастер

Причиной возникновения подобной проблемы может служить некорректный перенос разделов, страниц или сайта в целом. Так же, к этому может привести сбой в работе каталога, фильтра, пагинации или другого блока связанного со ссылками.

Определить точное количество неработающих ссылок и увидеть детали можно в разделе «Внутренние ссылки» Яндекс Вебмастера.

В этом блоке подробно описываются причины, поэтому Вам останется только устранить проблемы внутри сайта.

Возможные проблемы

Несмотря на название, возможные проблемы все же являются серьезными изъянами с точки зрения SEO. Они не приведут к исключению ресурса из поиска, а так же слабо повлияют на позиции и видимость. Однако их устранение может привести к подъему поискового трафика и более лояльному отношению поисковиков.

Главная страница перенаправляет на другой сайт

«При обращении к главной странице робот получает перенаправление на другой сайт, что делает невозможным её индексирование.» © Яндекс Вебмастер

Данную проблему Яндекс относит к разделу «Возможные», однако с нашей точки зрения это серьезная ошибка. Речь сейчас не идет о перенаправлении на зеркала или «склейку». Только редирект на сторонний сайт.

При корректном обращении к главной странице краулер должен получать ответ 200 ОК, что означает, что страница доступна пользователям и ее можно индексировать. В случае получения 301 Redirect, робот не только отправляется на сторонний ресурс, но и получает тревожный сигнал, что сайт мог быть взломан или вводит пользователей в заблуждение. То есть, Вы уже рискуете попасть под фильтры безопасности.

Сразу проверьте ответ сервера, если это будет не 200 ОК — ищите и устраняйте причину. В случае получения 301 Redirect рекомендуем заглянуть в файл .htaccess и проверить его на наличие редиректа.

Отсутствуют теги <title>

«Значительная часть страниц не содержит тег <title>, или он некорректно заполнен. Это может негативно повлиять на представление сайта в результатах поиска.» © Яндекс Вебмастер

Очень серьезное упущение с точки зрения поискового продвижения. Заголовки <title></title> являются одним из основных факторов внутренней оптимизации, которые влияют на ранжирование страницы.

Ранее этому заголовку мы посвятили полноценную статью. В ней разложено по полочкам все, что нужно знать о данном теге с точки зрения SEO.

Безусловно, Яндекс самостоятельно выберет текст для ссылки при построении поисковой выдачи и без сниппета Вы не останетесь, однако Ваша конкурентоспособность с точки зрения SEO сильно упадет.

Ошибки в файле robots.txt

«Файл robots.txt содержит ошибки. Это может привести к некорректному обходу и индексированию сайта.» © Яндекс Вебмастер

Данный файл представляет из себя список инструкций для индексирующего робота. Именно в нем определяется, что нужно загружать в базу, а что игнорировать. Находится он в корневой папке сайта и доступен по адресу www.ваш_домен.ru/robots.txt.

Большинство ошибок в robots.txt, обычно, связаны с синтаксисом прописываемых в нем инструкций. Лишняя точка, слэш или пробел могут привести к некорректному распознанию команды.

Поэтому, при появлении данной проблемы сразу открывайте свой роботс и начинайте проверять синтаксис. В этом деле Вам может помочь сервис «Анализ robots.txt» находящийся во вкладке «Инструменты» Яндекс Вебмастера.

Подробнее об ошибках и настройке файла robots.txt

Не найден файл robots.txt

«Робот не смог получить доступ к файлу robots.txt при последнем обращении. Из-за отсутствия параметров индексирования и инструкций в поиск могут попасть нежелательные страницы.» © Яндекс Вебмастер

Суть проблемы понятна из названия. Что бы решить ее, необходимо просто добавить robots.txt в корневой каталог Вашего сайта. Сделать это можно через FTP или при помощи различного рода плагинов.

Если Вы используете популярную CMS, то мы готовы предложить шаблонные решения. Однако, обратите внимание, что шаблоны инструкций не гарантируют корректность индексации и отсутствие мусора. У каждого сайта будут свои особенности и подводные камни.

Подробнее о настройке файла robots.txt

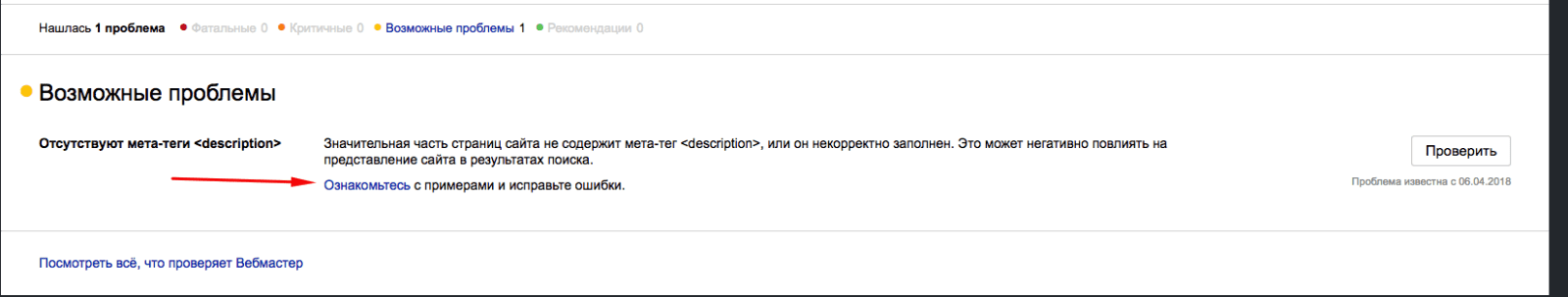

Отсутствуют мета-теги <description>

«Значительная часть страниц сайта не содержит мета-тег <description>, или он некорректно заполнен. Это может негативно повлиять на представление сайта в результатах поиска.» © Яндекс Вебмастер

Это одна из самых распространенных проблем, с которой сталкивается практически каждый SEO специалист. Для ее решения необходимо просто добавить недостающие <description>.

Узнать полный список страниц с отсутствующими тегами Вы можете перейдя по ссылке «Ознакомьтесь» в описании проблемы.

Отсутствие meta тега <description> сильно влияет на корректность отображения сниппетов. Поэтому тянуть с решением проблемы не стоит.

Если подобная ошибка появилась у Интернет-магазина, сайта-каталога или другого крупного ресурса, то для ее решения есть стандартные плагины, которые формируют meta description автоматически. Пользоваться такими плагинами мы советуем в крайнем случае, так как результат работы не всегда удовлетворителен.

Подробнее о description и правилах заполнения

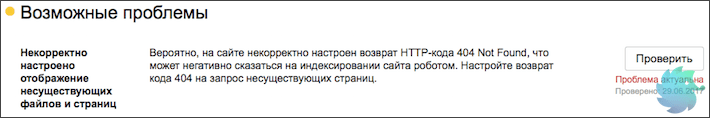

Некорректное отображение несуществующих файлов и страниц

«Вероятно, на сайте некорректно настроен возврат HTTP-кода 404 Not Found, что может негативно сказаться на индексировании сайта роботом. Настройте возврат кода 404 на запрос несуществующих страниц.» © Яндекс Вебмастер

Проще говоря, у Вас попросту отсутствует или некорректно работает страница 404. Что бы разобраться в этом, необходимо перейти на несуществующий раздел. Сделать это можно введя любой некорректный URL, к примеру «ваш_домен.ру/none12345».

Если Вы видите перед собой неизвестную ошибку, белый экран, сообщение хост-провайдера или другую информацию, которая к сайту не относится — у Вас просто нету данной страницы. Шаблон для нее необходимо сделать в CMS сайта. Это напрямую относится к разработке и дизайну сайта, поэтому работы стоит поручить верстальщику.

Если Вы видите оформленную страницу 404 своего сайта, тогда проблема в ответе сервера. Нужно понимать, что надпись «404 — страница не найдена» не означает, что сайт действительно отдает «404 Not Found», скорее всего, результатом будет 200 ОК.

Проверить ответ сервера Вы можете в разделе «Проверка ответов сервера» во вкладке «Инструменты» Яндекс Вебмастера.

Создание страницы 404 Not Found и настройка ответа сервера полностью зависят от конкретного сайта, поэтому сделать пошаговую инструкцию просто невозможно.

Подробнее о странице 404 с точки зрения SEO

В файле robots.txt задана противоречивая директива Host

«В директиве Host указан домен, где аналогичные указания в файле robots.txt отсутствуют. Чтобы указания директивы Host были учтены, идентичные директивы должны присутствовать в файлах robots.txt всех зеркал сайта.» © Яндекс Вебмастер

Суть проблемы в следующем. Есть два зеркала. У обоих есть файл robots.txt, в котором указаны различные параметры инструкции HOST.

Решение очень простое. Необходимо указать во всех HOST одно главное зеркало. Это нужно, что бы у робота не оставалось сомнений, какое из зеркал основное.

Бывает так, что файл robots.txt один и инструкции попросту не могут различаться. В таком случае нужно подождать и сообщение пропадет.

В файле robots.txt не задана директива Host

«Для корректного определения главного зеркала сайта рекомендуется задать соответствующую директиву Host в файлах robots.txt всех зеркал сайта. В случае ее отсутствия главное зеркало может быть выбрано автоматически.» © Яндекс Вебмастер

Помимо прочих инструкций в файле robots.txt для агента Яндекса необходимо указывать директиву host. Пример директивы приведен на рисунке ниже.

Синтаксис ее крайне прост. Сначала пишется служебное слово «Host:», далее через пробел вставляется главное зеркало сайта. При этом нужно учесть, что протокол http не пишется. Добавляется только https при его наличии. Убедитесь, что зеркало выставленное в Яндекс Вебмастере и других host (у сайтов-зеркал) соответствует указываемому в robots.txt. В противном случае Вы получите ошибку, о которой говорится выше.

Подробнее о директиве host

Большое количество страниц дублей

«На сайте обнаружено большое количество одинаковых страниц, это усложняет индексирование сайта. Проверьте, правильно ли настроены редиректы и корректно ли составлен файл robots.txt.» © Яндекс Вебмастер

Достаточно серьезная проблема, которая для решения, зачастую, требует квалифицированной помощи программиста. Страницы-дубли, по сути, представляют собой различные URL, которые ведут на одну и ту же страницу. (Реже, это несколько абсолютно одинаковых html файлов с разными URL)

Когда индексирующий робот попадает на сайт, он старается обойти все доступные URL адреса и загрузить по ним уникальный контент. Если робот переходит по адресу и «видит» уже загруженную ранее страницу, то он исключает ее из поиска как дубликат, при этом теряя драгоценное время обхода.

Определить наличие дублей возможно в Яндекс Вебмастере. Необходимо зайти в раздел «Индексирование» -> «Страницы в поиске» -> «Исключенные страницы». Тут будут представлены все исключенные из поиска разделы, в том числе и по причине дублирования. Для того, что бы долго не искать, можно настроить фильтр по статусу. (нажать на значок воронки рядом с заголовком)

После того, как все страницы будут отсортированы, Вы сможете увидеть имеющиеся дубликаты, о которых знает Яндекс.

Для решения данной проблемы необходимо, в первую очередь, определить причину появления дублей. Их может быть несколько.

-

При создании страницы, в CMS генерируется технический адрес, который обычно имеет вид «post=3333&action=edit» или любой другой не ЧПУ. Вы не хотите видеть подобный URL и создаете для страницы человекочитаемый адрес. Таким образом статья становится доступна по 2 адресам. В этом случае необходимо скрыть все технические адреса в robots.txt при помощи маски;

-

На сайте имеются динамические URL, которые дополняются различными префиксами в зависимости от выбранных параметров, поиска, сортировки и т.д. Их так же необходимо скрывать при помощи маски в robots или отказаться от динамических URL;

-

Во время настройки рекламы, для получения данных о клиенте и источнике, часто используются дублирующие ссылки с параметрами. Такие URL нужно сразу закрывать в robots.txt во избежание попадания в индекс;

-

Некоторые системы управления могут отображать страницу по нескольким человекочитаемым URL. К примеру, страница может быть доступна по всем 3-м адресам: «/page1/», «/page1.php», «/page1.html». Исключаются подобные дубли так же при помощи маски.

После того, как дубли будут закрыты для индексации, предупреждение пропадет автоматически. Но, не стоит думать, что это произойдет в первую неделю. Подобное сообщение может держаться месяцами.

Нет используемых роботом файлов Sitemap

«Робот не использует ни одного файла Sitemap. Это может негативно сказаться на скорости индексирования новых страниц сайта. Если корректные файлы Sitemap уже добавлены в очередь на обработку, сообщение автоматически исчезнет с началом их использования.» © Яндекс Вебмастер

Это длинное сообщение описывает всего лишь отсутствие sitemap.xml. Что бы поправить ситуацию нужно просто создать данный файл и разместить его в корневом каталоге Вашего сайта. Ранее мы подробно рассказывали, как это сделать.

После создания необходимо зайти в Яндекс Вебмастер -> «Индексирование» — > «Файлы Sitemap» -> «Добавить карту». В этом же разделе возможно отследить корректность индексации и в случае необходимости обновить.

После того, как робот увидит sitemap сообщение о проблеме пропадет автоматически.

Обнаружены ошибки в файлах Sitemap

«В одном или нескольких файлах Sitemap обнаружены ошибки, которые могут повлиять на обработку файлов индексирующим роботом.» © Яндекс Вебмастер

В случае возникновения данной проблемы воспользуйтесь сервисом анализа sitemap.xml, который находится прямо в Яндекс Вебмастере. («Инструменты»-> «Анализ файлов Sitemap»).

Если ошибку не удается выявить, проще всего создать новую карту сайта. Как это сделать, подробно описывали ранее.

Если sitemap генерируется при помощи плагинов, обратите внимание на поля, которые находятся в итоговом файле. В отличии от Google, Яндекс не воспринимает инструкцию <image:image> и может сообщать об ошибке.

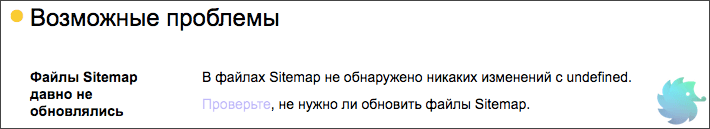

Файлы Sitemap давно не обновлялись

«В файлах Sitemap не обнаружено никаких изменений с undefined. Проверьте, не нужно ли обновить файлы Sitemap.»© Яндекс Вебмастер

Тут все просто. Необходимо обновить все имеющиеся на сайте файлы sitemap.xml. Причем сделать это нужно корректно. Вот лишь несколько ошибок, которые допускают при обновлении карты сайта.

-

Даты изменения страниц не соответствуют реальному обновлению страниц. Подобная ошибка происходит в тот момент, когда Вы используете online сервис. В таком случае все даты изменения могут быть одинаковыми и не соответствовать фактическим. Это заставляет поисковую систему повторно загружать один и тот же материал, что приводит к пустой трате времени;

-

Все страницы имеют один и тот же приоритет. В таком случае данный параметр sitemap.xml просто перестает иметь какой-либо смысл;

-

Вероятная частота изменения не соответствует действительной. Не стоит писать, что Ваши страницы обновляются каждый час. Обмануть поисковую систему не удастся и преимущества Вы не получите, но вот возможность корректного указания частоты обновления утратите.

Подробнее о создании sitemap.xml

Рекомендации

Этот раздел носит исключительно информационный характер, однако мы советуем соблюсти все его требования.

Не задана региональная принадлежность сайта

«В разделе «Региональность» регион сайта не задан явно, это может осложнить ранжирование. Если ваш сайт интересен пользователям вне зависимости от региона, выберите в разделе вариант «Нет региона».» © Яндекс Вебмастер

У данной проблемы есть две стороны медали. С одной — присвоение региона не является обязательной процедурой и Яндекс сам может определить его. С другой — если регион определен некорректно, то Вы можете получить нерелевантный трафик или же вообще лишиться его.

Поэтому мы настоятельно рекомендуем присваивать регион каждому сайту. Стоит отметить, что есть ряд ресурсов, которые не имеют региональной привязки. В таком случае необходимо сообщить Яндексу, что региона Вы не имеете.

Подробнее о том, как выбрать и присвоить регион.

Сайт не оптимизирован для мобильных

«По результатам работы алгоритма, определяющего, насколько сайт подходит для мобильных устройств, сайт не удалось признать оптимизированным.» © Яндекс Вебмастер

Сегодня эта проблема должна находиться уже среди критичных. Поисковые системы не раз говорили о том, что будут занижать сайты не имеющие мобильной версии. С каждым годом процентное соотношение трафика с мобильных устройств растет, поэтому мобильная адаптация должна быть у всех.

Насколько корректно Ваш сайт адаптирован под мобильные телефоны и планшеты Вы можете определить с помощью официального сервиса Яндекса — «Проверка мобильных страниц» . Располагается он в разделе «Инструменты» Яндекс Вебмастера.

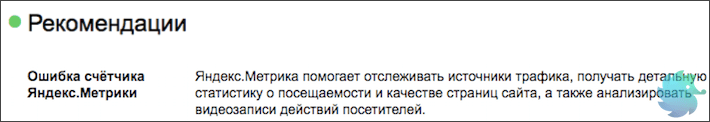

Ошибка счётчика Яндекс.Метрики

«Яндекс.Метрика помогает отслеживать источники трафика, получать детальную статистику о посещаемости и качестве страниц сайта, а также анализировать видеозаписи действий посетителей.» © Яндекс Вебмастер

Тут все просто. Скорее всего код Яндекс Метрики был установлен некорректно или не на все страницы.

Если Вы зайдете в счетчики и увидите красный значок слева от сайта — данные в Метрику не поступают. Нажмите на него.

Если он не станет зеленым, то просто переустановите счетчик. Для этого нужно:

-

Перейти в настройки нажав на значок шестеренки в правой части экрана;

-

Переходим на вкладку «Код счетчика» и копируем его;

-

Открываем шаблон, который формирует страницы сайта и вставляем в него код;

-

Переходим в метрику и нажимаем на красный кружок со стрелочкой. Он должен стать зеленым.

В случае, если Вы уверены, что код размещен правильно, но данные так и не поступают — обратитесь в службу поддержки или подробно ознакомьтесь с процессом установки счетчика.

Сайт не зарегистрирован в Яндекс.Справочнике

«Сайт не добавлен в Яндекс.Справочник. Если у вас есть офисы или филиалы, добавьте их в справочник, чтобы улучшить внешний вид сайта в поиске и региональное ранжирование. Если офисов и филиалов нет, явно укажите «Нет региона» в подразделе «Вебмастер» раздела настройки региональности.» © Яндекс Вебмастер

С точки зрения SEO, регистрация сайта в Яндекс Справочнике может дополнить сниппет такой полезной информацией, как телефон, адрес и режим работы. По брендовым запросам справа от сниппета начнет появляться карта с адресом и подробной информацией о фирме. Такие сниппеты любят пользователи, поэтому стоить уделить 15 минут на регистрацию.

Зарегистрироваться проще некуда. Это совершенно бесплатно.

-

Заходим в Яндекс Аккаунт и переходим по ссылке: https://yandex.ru/sprav/add/;

-

Вводим информацию о компании и нажимаем «Добавить организацию»;

-

Ожидаем одобрения модераторов. (Обычно проблем с этим не возникает)

После успешной модерации информация появится в выдаче через несколько обновлений.

Отсутствует файл favicon на сайте

«Не найден файл с изображением, которое должно отображаться во вкладке браузера и может быть показано возле названия сайта в поиске.» © Яндекс Вебмастер

Файл favicon.ico это небольшая картинка, которая отображается во вкладке браузера.

Favicon имеет расширение .ico и располагается в корневой папке сайта или шаблона.

Кроме отображения во вкладке, данное изображение присутствует в поисковой выдаче рядом со ссылкой на сайт. Именно поэтому о нем сообщает Яндекс.

Сделать favicon очень просто. Для этого нужно создать рисунок квадратной формы, после чего воспользоваться одним из множество online генераторов. Примеры таких сервисов:

-

http://pr-cy.ru/favicon/

-

http://www.favicon.ru

-

http://www.favicon.by

-

Множество других.

Скачайте получившийся файл, назовите его favicon.ico и разместите в корневой папке сайта. Несколько раз обновите браузер и Ваше изображение появится во вкладке рядом с доменом. В поисковой выдаче favicon обновится в течение 2-3 недель.

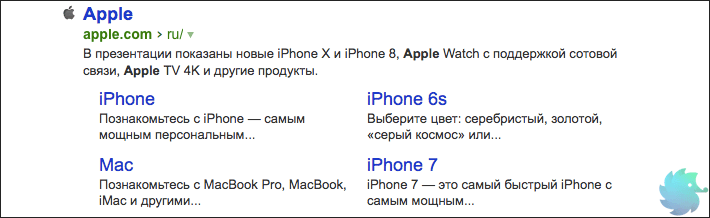

Отсутствуют быстрые ссылки

«В некоторых случаях в результатах поиска возможно отображение быстрых ссылок в сниппете сайта, что улучшает его видимость и количество переходов. Ссылки формируются полностью автоматически, роботы регулярно оценивают возможность показа быстрых ссылок.» © Яндекс Вебмастер

Это исключительно информационное сообщение, так как напрямую повлиять на вывод быстрых ссылок Вы не можете. Напомним, что последние располагаются под основным сниппетом сайта в органической выдаче. На рисунке ниже приведен пример быстрых ссылок для сайта компании Apple.

Но, несмотря на то, что напрямую влияния Вы не имеете, возможно «помочь» роботу определить быстрые ссылки. Делается это путем создания корректной древовидной структуры сайта. То есть, выделить основные разделы, сгруппировать в них подразделы и корректно связать все перелинковкой.

В этом случае Яндекс сможет с большей вероятностью определить основные разделы и сформировать блок быстрых ссылок.

Как проверить сайт на ошибки и их исправить

21.05.2018

Шутки ради: Тебе не нужно исправлять ошибки на сайте – если у тебя нет сайта.

Содержание:

- Как найти ошибки на сайте через Яндекс Вебмастер

- Поиск мусорных страниц и ошибок

- Продолжаем искать ошибки на сайте

- Исправляем ошибки: дубликаты страниц

- Исправляем ошибки: находим и убираем «битые ссылки»

- Исправляем ошибки: Оптимизация картинок

- Исправляем ошибки: Два заголовка H1

- Исправляем ошибки: Отсутствие заполненных мета тегов

Сайты без ошибок и с быстрой скоростью загрузки могут получить ТОП даже без ссылок. Конечно поисковые системы отдают предпочтения сайтам которые хорошо оптимизированы имеют четкую и понятную структуру для поисковых роботов.

О поисковых роботах

У поисковых систем есть специальные роботы которые посещают ваш сайт и скачивают всю информацию о странице и ее данных, а именно заголовок страниц, название статей и других метатегов Их несколько видов и вот самые основные на примере Яндекса:

- YandexBot — основной робот Яндекса, обходит и скачивает всю информацию;

- YandexImages – индексирует картинки для поиска;

- YandexBlogs — робот поиска по блогам исоциальным сетям;

- YandexWebmaster – приходит придобавлении сайта через форуму Веб Мастер;

- YandexPagechecker – проверяет ошибки в разметке сайта;

- YandexFavicons — индексатор фавиконок картинок в браузере

Поисковые роботы ежеминутно и ежедневно проводят обновления своей базы обновляя поисковую выдачу новыми данными и на благодаря им вы получаете более свежую и актуальную информацию, например о свежих новостях. Они сортируют информацию и сохраняют в соответствующий раздел своего сервера по специальным метатегам.

А если там ошибки, то и поисковый робот не может правильно разметить информацию на сайте и понять о чем та или иная страница. Уже исправив ошибки на сайте можно начать получать трафик из поисковой выдачи.

Вот например в рекомендациях от Яндекс написано:

- Необходимо поддерживать четкую внутреннюю ссылочную структуру.

- Использовать карту сайта (sitemap) для роботов.

- Ограничение служебных страниц в robots.txt, а информации в специальные закрывающие от индексации <noindex>.

- Быть внимательнее с движками (CMS) для сайта. Они грузят поиск ненужными техническими страницами и битыми ссылками.

Как найти ошибки на сайте через Яндекс Вебмастер

Чтобы исправить ошибки на сайте их во первых нужно найти =) Для этого добавляем сайт в сервис Яндекс Вебмастер, предварительно зарегистрировав почту на Яндекс .

После чего вам предложат подтвердить права на сайт тремя разными способами, то есть доказать сервису что домен принадлежит вам.

Лично мне проще загрузить файл через FTP клиент (скачать можно тут) поэтому я выбираю этот способ.

После загрузи этого файла на ваш сервер с сайтом нажмите кнопку подтвердить и подождите пока информация обновиться по вашему сайту. Это происходит как за несколько часов так до нескольких дней.

После чего выполняем рекомендации и например как в моем примере заполняем <description> на те которые сам покажет инструмент Яндекс Вебмастер.

Приоритет обязательно отдавайте Фатальным и Критичным ошибкам ведь они на прямую влияют на ранжирование сайта.

Удобство Яндекс Вебмастер заключается в том, что там понятным языком написано что нуждается в доработке, а также предложено решение по исправлению, ну а если появятся вопросы, то задавайте их в комментариях.

Углубляемся в поиск мусорных страниц и ошибок

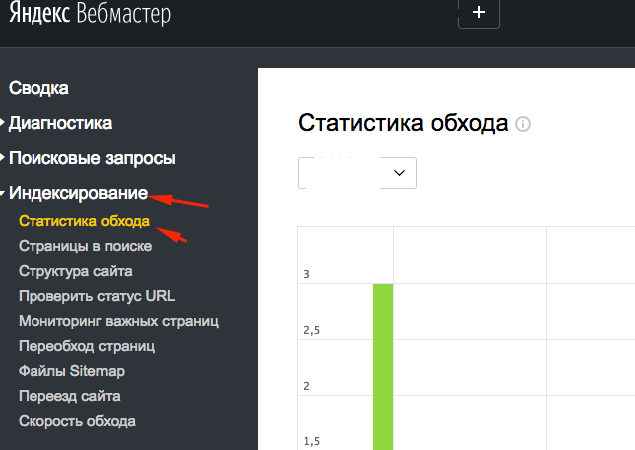

В Веб Мастере есть замечательная функция и находится она в разделе Индексирование > Статистика обхода.

Тут мы видим все страницы куда заглядывает поисковый робот и какую информацию он скачал для поисковой системы, ошибки, редиректы и прочую нужную информацию.

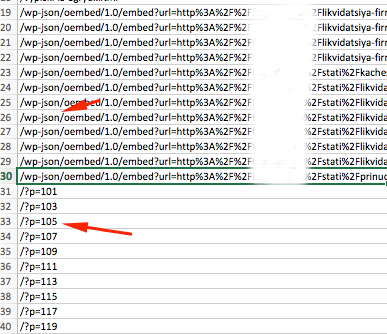

Внизу с права есть функция выгрузки этих данных для удобства работы в Exel. Выгружаем, открываем, сомотрим.

Чтобы нам не просматривать одни и те же страницы, рекомендую воспользоваться функцией удаление дубликатов а колонке A.

Все технические, информационные, мусорные страницы должны быть запрещены к индексации в robots.txt, но сначала выпишите их в отдельный текстовой документ. О настройке файла robots.txt мы будем говорить в следующей статье (Части 3).

Вот например технические страницы движка WordPress. Это папка /wp-json/ и все что с ней связано, а также страницы /?p=. Такие страницы тянут сайт внизу, так как поисковые системы думают что сайт захламлен техническими данными и за ним никто не смотрит, а значит доверия к ним меньше.

Просмотрите все страницы, выпишите «мусорные» страницы и сохраните в текстовом файле, они нам потребуются позднее.

Продолжаем искать ошибки на сайте

Тут нам уже понадобиться определенный софт, например Netpeak Spider. Очень удобная программа причем «условно» бесплатная. В ней есть 14 дней тестового доступа без ограничения функционала. Эти две недели с «головой» хватит для аудита простого сайта. Вот ссылка https://netpeaksoftware.com/ru/spider

Инструмент позволит найти:

Битые ссылки – то есть ссылки на несуществующие страницы сайта и выдающие ошибку 404 (отсутствие страницы). Ссылки на несуществующие страницы тянут сайт вниз, такая как поисковая система думает что сайтом не занимаются и понижают в выдаче.

- Дубликаты страниц и текста – страницы с дублирующимся контентом плохо или вообще не получают трафик (посетителей). Поиск просто не может понять на какую страницу вести пользователя и иногда исключает из выдаче обе страницы.

- Находит страницы без внутренних ссылок – как известно весь интернет это миллиарды ссылок если с вашей страницы невозможно уйти на другую то образуется «тупик» или по-другому «висячий узел», что негативно влияет на получение трафика на страницу.

- Отсутствие заполненных мета тегов – очень важный инструмент для поискового робота. Именно по ним робот получает информацию о чем ваш сайт или конкретная страница. Нет мета тегов – нет трафика.

- Максимальный размер изображения – скорость загрузки сайта напрямую зависит от его оптимизации, а если картинка или фотография загружается по 20-30 секунд это никуда не годится.

- Одинаковые мета теги Title и H1 – Делайте теги с максимальным вхождением ключевого запроса о котором страница, но все хорошее в меру. По умолчанию рекомендуемый максимальный размер тега H1 не более 65 символов, а тега title не более 120.

Исправляем ошибки: дубликаты страниц

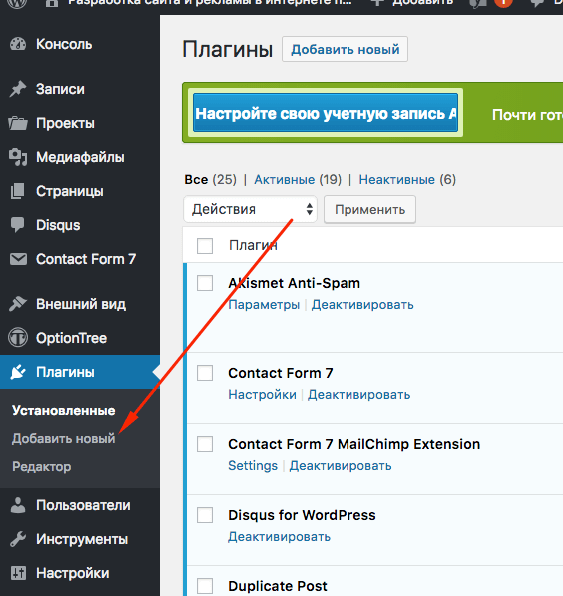

Дубликаты страниц нужно удалить или поставить с них 301 редирект. Если у вас сайт на движке CMS WordPress то вам поможет плагин «Перенаправления». Скачать вы его можете в админ панели во вкладке Плагины > Добавить новый.

Или сделайте через файл .htaccess, просто добавив в него следящий текст

RewriteCond %{REQUEST_URI} ^/test/$RewriteRule ^.*$ http://site.ru/new-test/? [R=301,L]

Где в первой строчке /test/ это с какой страницы, а на второй строчке куда переводить.

Исправляем ошибки: находим и убираем «битые ссылки»

Если вы не видите «битые» то есть ведущие на несуществующие страницы ссылки, то это не значит, что поисковой робот их не видит.

Принцип работы поискового робота как раз заключается в переходе по каждой ссылке и получение информации о следующей странице, а если страница не существует то сервер выдает ошибку.

Вывод: сайтом не занимаются. Итог: понижение в выдаче. Результат: Отсутствие посетителей.

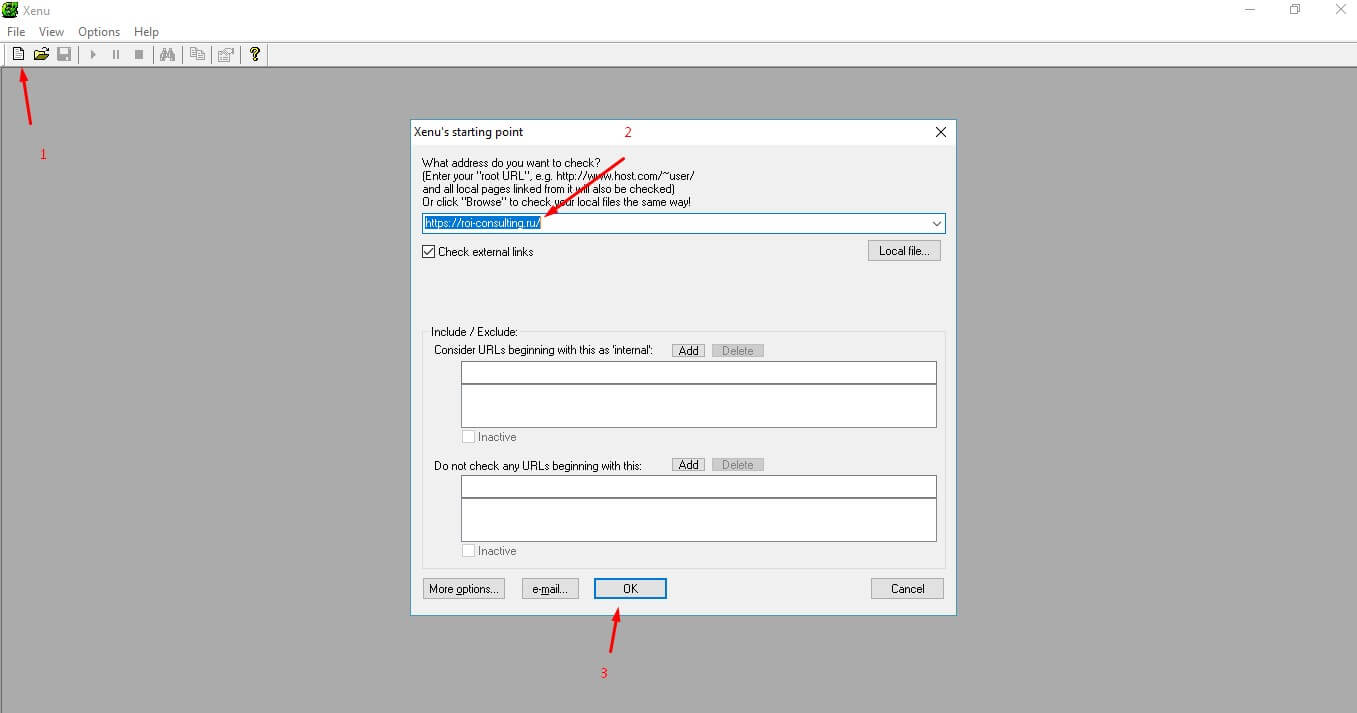

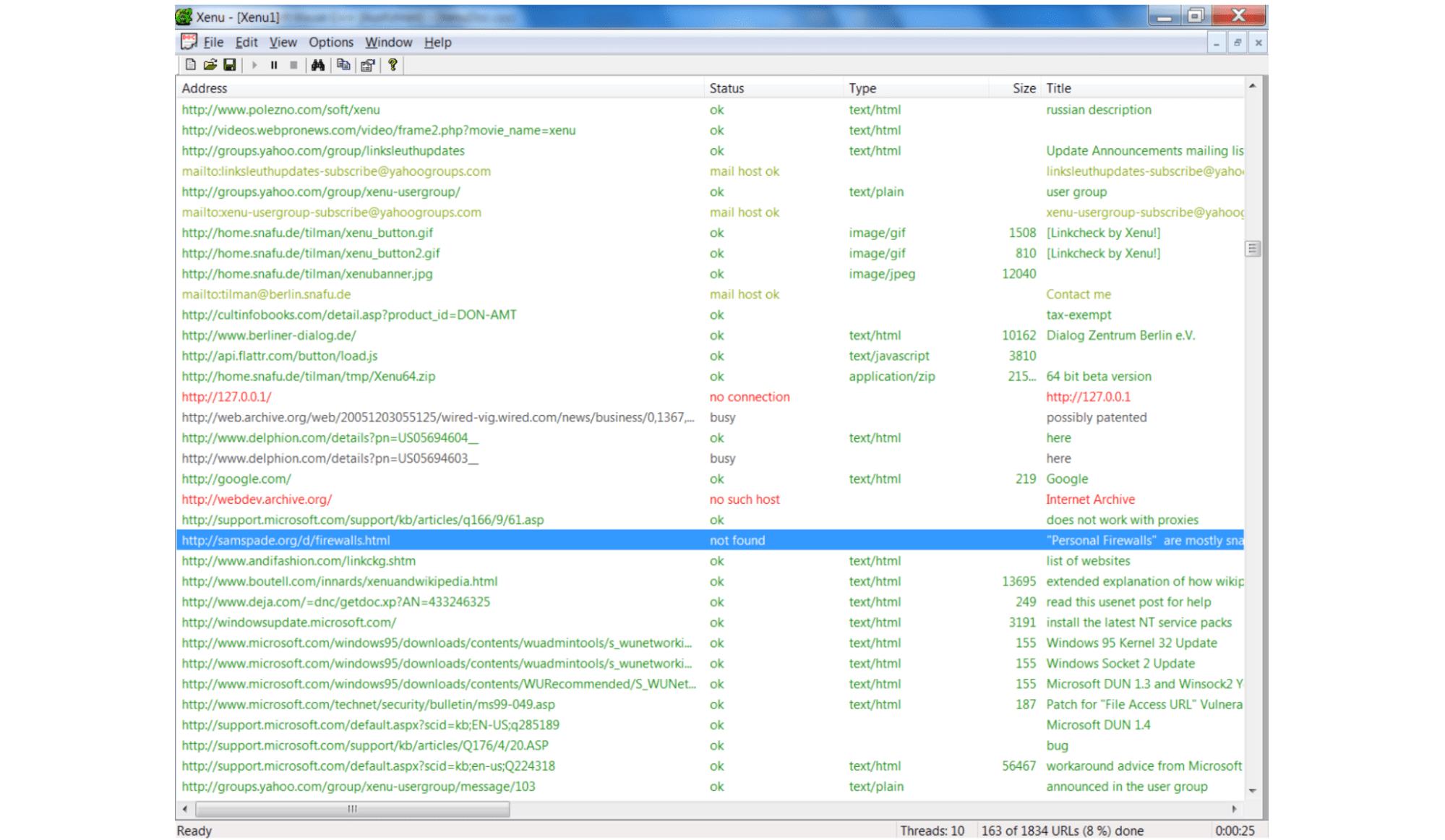

Для поиска битых ссылок также можно использовать бесплатную программу Xenu. Она проста в использовании и понятна.

Убираем ссылки на несуществующие страницы. При использовании «дивижка» сайта убрать ссылку не составит труда. Заходим в редактирование страницы с битой ссылкой и убираем ссылку.

Если движок отсутствует, то заходим через FTP доступ на сервер и редактируем страницу вручную. Нам необходимо найти ссылку в коде страницы.

Ссылка имеет вот такой HTML код:

<a href=»ссылка на страницу»>ТЕКСТ ССЫЛКИ</a>

Убираем весть HTML код кроме «ТЕКСТ ССЫЛКИ», тем самым мы уберем ссылку и избавимся от ошибки.

Исправляем ошибки: Оптимизация картинок

Чем быстрее грузится сайт, тем лучше. Для этой проверки есть специальные сервисы, например бесплатные от Google Page Speed Insights. Он не только покажет скорость сайта, но и каждой страницы в отдельности.

В 70% случаев причина медленной загрузки страницы это неоптимизированные картинки, а остальные 30% это скрипты, сервер и само программирование.

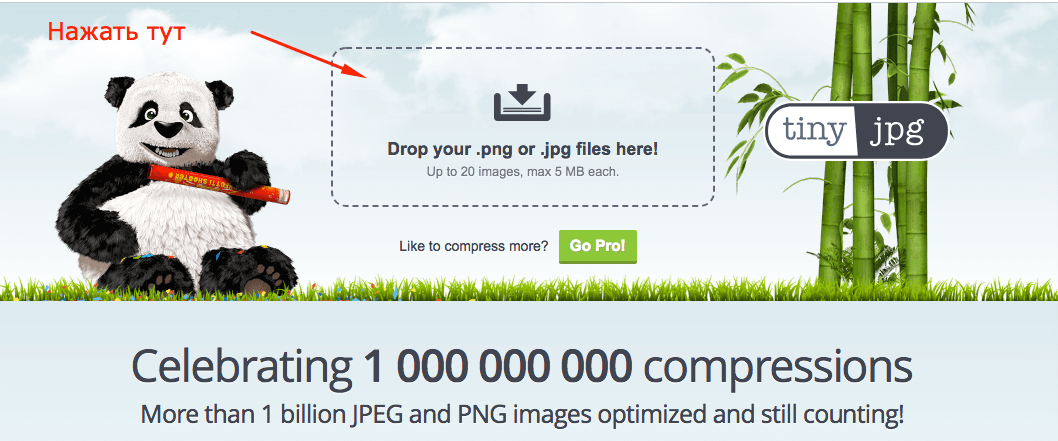

Каждую картинку необходимо сделать меньшим объемом и без потеря качества. Для оптимизации можно воспользоваться сервисом https://tinyjpg.com/.

Необходимо загрузить картинку на сервис, а потом скачать оптимизированную картинку и заменить ее на самом сайте.

Готово! И так должно быть с каждой картинкой.

Исправляем ошибки: Два заголовка H1

Этот мета тег на должен быть на странице только один, то есть в коде он должен встречать один раз. Найти его можно открыв HTML код страницы. Если вы используете браузер Chrome делается это комбинациями клавиш Ctrl + U.

Дальше проверяем саму страницу. Ищем мета тег H1. Нажимаем сочетание клавиш Ctrl+F и вводит в поиск h1 или <h1 если тегу присвоен класс.

Если вы находите более одного тега h1 то это ошибка и ее нужно исправлять.

Скажу сразу, если нет навыков в HTML сайта и знания CSS то рекомендую обратиться к программисту для исправления этой ошибки.

Каждый заголовок имеет свой класс, а соответственно и вид отображения на странице, но можно попробовать заменить в коде h1 на h2. Если это повлияло на отображение сайта, то верните все обратно и обратитесь к программисту. Стоимость таких работ от 200 до 500 рублей.

Исправляем ошибки: Отсутствие заполненных мета тегов

Тут все просто. Заполните данные основываясь на самой информации которую несет страница. Если страница о «как похудеть к лету», то рекомендую делать заголовки и title «цепляющими». Ведь именно title видят пользователи поисковиком.

Чтобы не ломать голову воспользуйтесь контекстной рекламой. Конечно не в прямом смысле, а введите продвигаемый запрос и посмотрите выдачу.

Теперь генерируем например вот так: Как похудеть к лету – 10 килограмм в домашних условиях!

Если у Вас остались вопросы задайте их в комментариях, обязательно отвечу на них, теперь переходим дальше: Продвижение сайта — настройка robots.txt — часть 3

Автор: Аграчев Михаил

Как найти битые ссылки на сайте бесплатно

Битые ссылки (broken links) — это ссылки на сайте, которые не работают: например, ведут на несуществующие страницы с кодом ошибки 404 (Page Not Found). Большое количество битых ссылок ухудшает позиции сайта в поисковых системах, а также негативно сказывается на удобстве для пользователей. В нашей статье мы расскажем, как проверить сайт на битые ссылки с помощью бесплатных онлайн-инструментов.

ТОП-5 бесплатных инструментов для поиска битых ссылок на сайте

- Яндекс.Вебмастер.

- Google Search Console.

- Screaming Frog Seo Spider.

- Xenu.

- Broken Link Checker.

Ниже мы подробнее расскажем о каждом сервисе и покажем, как с ним работать.

№1. Яндекс.Вебмастер

Яндекс.Вебмастер (Yandex.Webmaster) — это бесплатный инструмент для веб-мастеров и владельцев сайтов, позволяющий им контролировать индексацию сайта в поисковой системе Яндекс, а также отслеживать состояние сайта и предупреждать о возможных проблемах. С помощью Яндекс.Вебмастера вы можете проверять качество индексирования, искать и устранять ошибки, оптимизировать сайт для поисковых систем, а также получать информацию о запросах пользователей и посещаемости сайта.

Чтобы найти битые ссылки в интерфейсе Яндекс.Вебмастера, необходимо перейти в раздел «Ссылки» → «Внутренние ссылки» и выбрать ответ по неработающим ссылкам. По данным Вебмастера на сайте «Интернет Хостинг Центр» таких линков нет.

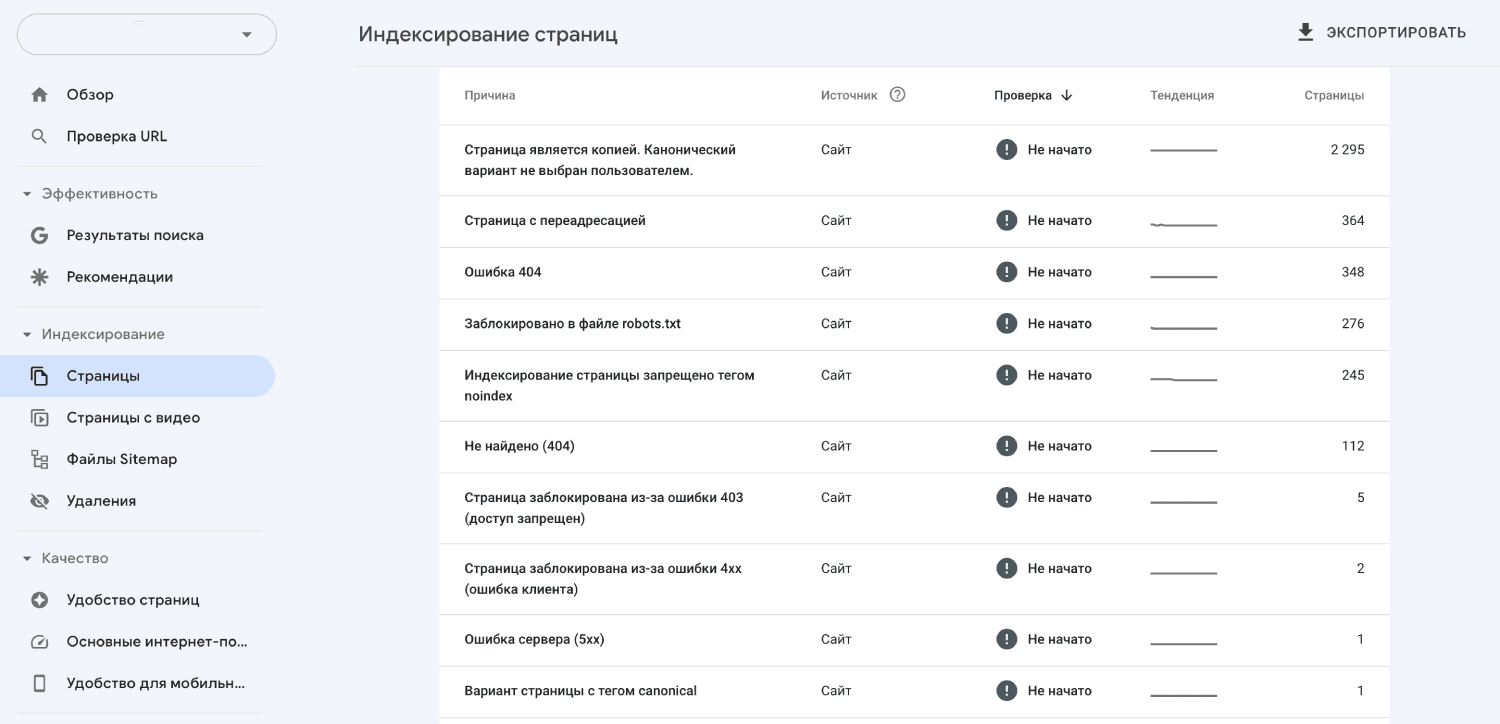

№2. Google Search Console

Google Search Console (ранее известный как Google Webmaster Tools) — это бесплатный инструмент для владельцев веб-сайтов, который позволяет контролировать индексацию сайта в поисковой системе Google и получать отчеты о его производительности. С помощью Гугл.Вебмастера вы можете проверять исключения, ошибки индексации, анализировать выдачу поисковых запросов, мониторить состояние сайта и предотвращать возможные проблемы. Инструмент предоставляет важную информацию для оптимизации сайта и улучшения его выдачи в поисковых результатах.

Чтобы найти неработающие линки через Google Search Console, необходимо перейти в раздел «Страницы» и найти причины, по которым не проиндексированы некоторые страницы веб-сайта: здесь вы найдете адреса битых ссылок, например, с ошибками 404 и 5хх.

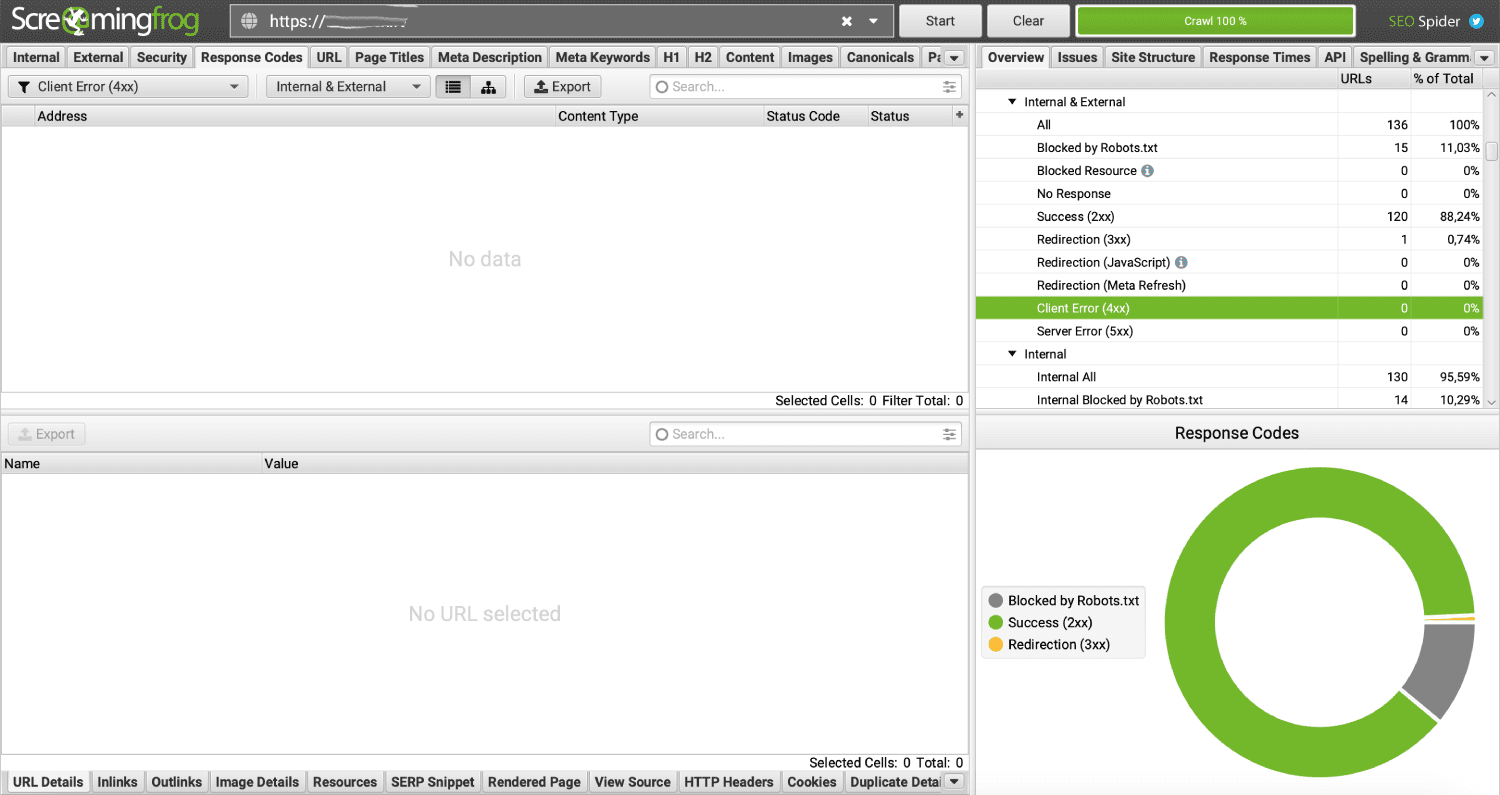

№3. Screaming Frog Seo Spider

Screaming Frog SEO Spider — это программа для анализа веб-сайтов, которая позволяет сканировать сайты и анализировать их в поисках ошибок и проблем, связанных с поисковой оптимизацией. Screaming Frog SEO Spider (в народе ее называют «лягушка») может проверять мета-теги, заголовки, линки, изображения, структуру и другую важную информацию, необходимую для оптимизации SEO. Результаты анализа можно экспортировать в файлы Excel или CSV для дальнейшей обработки. Программа позволяет бесплатно проверять до 500 страниц сайта.

Алгоритм поиска битых ссылок в Screaming Frog:

- Скачайте программу с официального сайта и установите у себя на компьютере.

- Запустите «лягушку» и просканируйте сайт.

- В меню справа отобразятся все отчеты, по которым Скриминг Фрог проверяет веб-ресурс.

- Найдите отчеты с названиями Client Error (4xx) и Server Error (5xx) и убедитесь, что такие страницы не найдены. В противном случае на сайте обнаружились неработающие линки.

№4. Xenu

Xenu’s Link Sleuth — это бесплатный инструмент для анализа ссылок, разработанный для проверки сайтов на наличие битых ссылок. Он сканирует веб-ресурс и анализирует все линки на ошибки, например, на 404 (Page Not Found). Xenu помогает веб-мастерам идентифицировать проблемы со ссылками и улучшать поведенческие факторы и юзабилити. Просто просканируйте сайт через эту программу и получите список всех страниц сайта с соответствующим кодом ответа сервера.

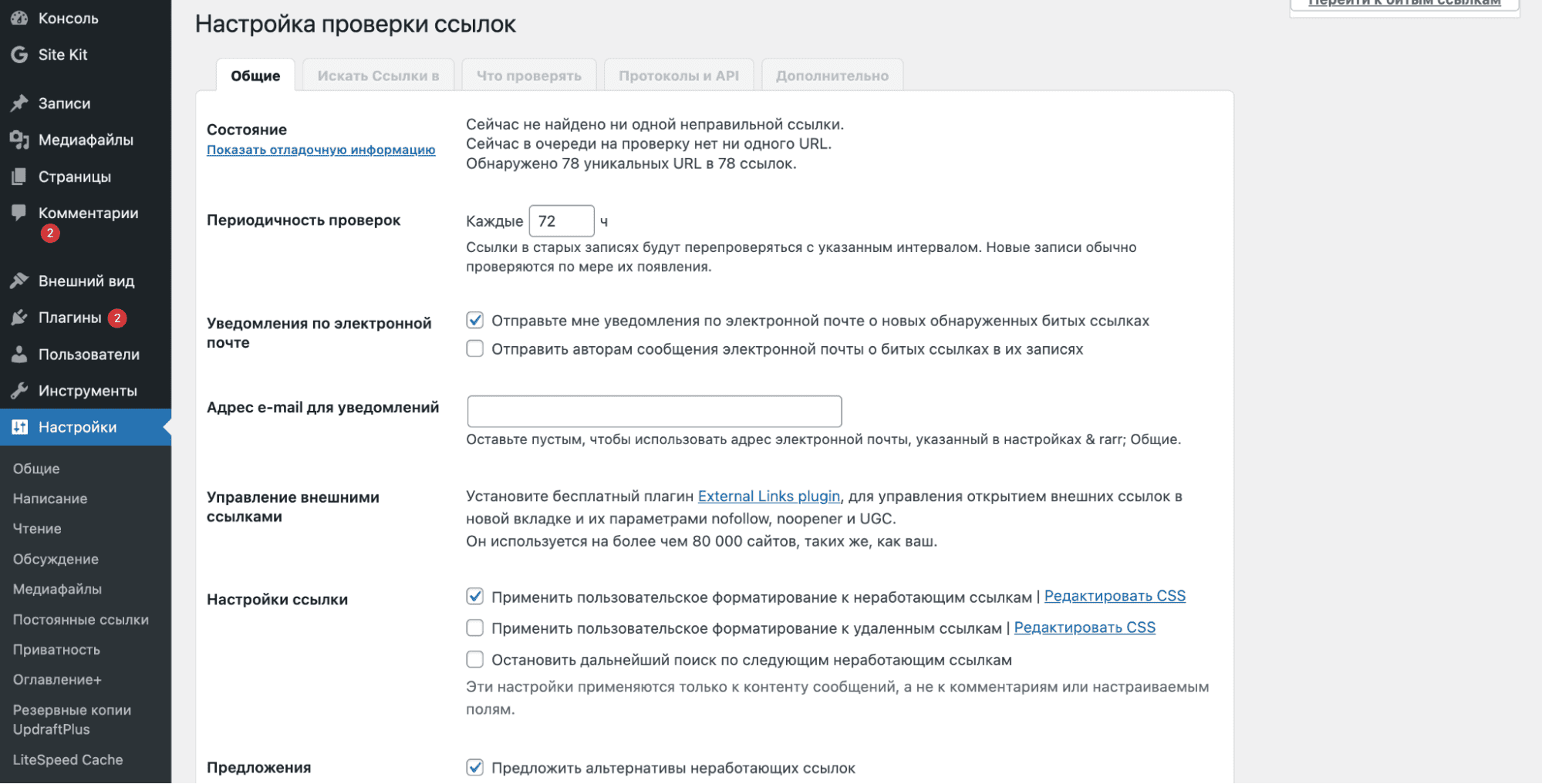

№5. Broken Link Checker

Если ваш веб-ресурс работает на CMS WordPress, то найти битые ссылки на сайте можно с помощью плагина «Broken Link Checker». Broken Link Checker — это плагин для ВордПресс, который помогает обнаружить и исправить битые линки на вашем сайте. Он сканирует сайт и проверяет все гиперссылки в постах, страницах, комментариях и других местах. Если он находит неработающую ссылку, то отображает ее в панели администратора и предлагает варианты для ее исправления.

Как исправить битые ссылки на сайте

Если ссылка устарела и больше не работает, просто обновите ее (замените на существующий линк) или удалите. Чтобы исправить «broken links», вы можете:

- Найти альтернативную рабочую ссылку, которую можно использовать вместо битой.

- Настроить 301 редирект на существующую страницу, близкую по содержанию.

- Просто удалите ссылку.

Мы позаботились о своих клиентах и заранее составили цикл статей о различных ошибках на сайте. Специальная подборка:

Если вы столкнулись с одной из этих проблем, обязательно прочитайте наши инструкции.

Заключение

Своевременное обновление устаревших ссылок важно, чтобы улучшить пользовательский опыт и повысить репутацию сайта. Когда пользователь переходит на несуществующую страницу, он получает ошибку 404, что может привести к ухудшению впечатления о сайте. В статье мы рассказали о нескольких бесплатных сервисах, которые помогут избежать этих проблем. Являетесь нашим клиентом и остались вопросы? Задавайте их тикет-системе, наши специалисты обязательно помогут!

Похожие статьи

-

Капчей (captcha) называется автоматизированный тест для различения человека и робота, который используется в качестве защиты от спама на сайтах и в приложениях. За время своего развития этот инструмент претерпевал немало изменений. Если раньше капча представляла собой проверку в виде изображения с искаженными символами, которые требовалось ввести перед отправкой данных на сервер, то сейчас для ее прохождения пользователям даже не нужно предпринимать никаких дополнительных действий. Добавление капчи на веб-сайт поможет вам защититься от ботов. В статье мы расскажем об известных сервисах, позволяющих это сделать, и объясним, как установить капчу на сайт, используя самый популярный из них.

-

SSL-сертификат — это цифровой сертификат, удостоверяющий подлинность веб-сайта и позволяющий использовать зашифрованное соединение. Без защищенного соединения сайту будет проблематично продвинуться в поисковых системах и завоевать доверие клиентов. Для небольших веб-проектов, лендингов и блогов отлично подойдет бесплатный SSL-сертификат Let’s Encrypt. В нашей статье мы подробно расскажем, как получить его на виртуальном хостинге и VPS/VDS сервере.

-

Сегодня, чтобы создать полноценный работающий сайт, вовсе не обязательно владеть языками программирования и другими специальными знаниями. Для этого давно существуют программные продукты, которые делают всю техническую работу за вас. Конструкторы сайтов и системы управления контентом (CMS) являются простыми и удобными инструментами, позволяющими запустить собственный веб-проект. Их часто сравнивают, но на самом деле оба этих решения эффективны — в разных обстоятельствах. Мы расскажем, чем CMS отличаются от конструкторов сайтов, и перечислим особенности каждого метода.