О степенях свободы в статистике

Время на прочтение

8 мин

Количество просмотров 198K

В одном из предыдущих постов мы обсудили, пожалуй, центральное понятие в анализе данных и проверке гипотез — p-уровень значимости. Если мы не применяем байесовский подход, то именно значение p-value мы используем для принятия решения о том, достаточно ли у нас оснований отклонить нулевую гипотезу нашего исследования, т.е. гордо заявить миру, что у нас были получены статистически значимые различия.

Однако в большинстве статистических тестов, используемых для проверки гипотез, (например, t-тест, регрессионный анализ, дисперсионный анализ) рядом с p-value всегда соседствует такой показатель как число степеней свободы, он же degrees of freedom или просто сокращенно df, о нем мы сегодня и поговорим.

Степени свободы, о чем речь?

По моему мнению, понятие степеней свободы в статистике примечательно тем, что оно одновременно является и одним из самым важных в прикладной статистике (нам необходимо знать df для расчета p-value в озвученных тестах), но вместе с тем и одним из самых сложных для понимания определений для студентов-нематематиков, изучающих статистику.

Давайте рассмотрим пример небольшого статистического исследования, чтобы понять, зачем нам нужен показатель df, и в чем же с ним такая проблема. Допустим, мы решили проверить гипотезу о том, что средний рост жителей Санкт-Петербурга равняется 170 сантиметрам. Для этих целей мы набрали выборку из 16 человек и получили следующие результаты: средний рост по выборке оказался равен 173 при стандартном отклонении равном 4. Для проверки нашей гипотезы можно использовать одновыборочный t-критерий Стьюдента, позволяющий оценить, как сильно выборочное среднее отклонилось от предполагаемого среднего в генеральной совокупности в единицах стандартной ошибки:

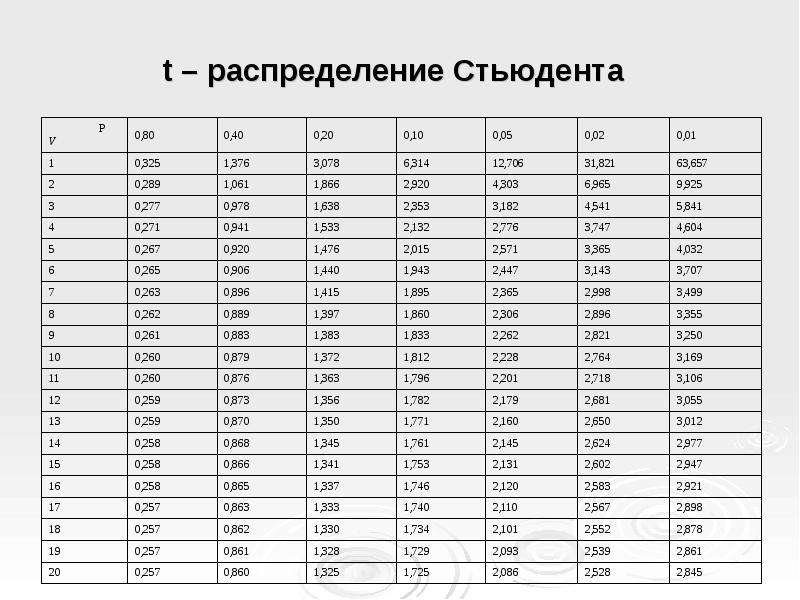

Проведем необходимые расчеты и получим, что значение t-критерия равняется 3, отлично, осталось рассчитать p-value и задача решена. Однако, ознакомившись с особенностями t-распределения мы выясним, что его форма различается в зависимости от числа степеней свобод, рассчитываемых по формуле n-1, где n — это число наблюдений в выборке:

Сама по себе формула для расчета df выглядит весьма дружелюбной, подставили число наблюдений, вычли единичку и ответ готов: осталось рассчитать значение p-value, которое в нашем случае равняется 0.004.

Но почему n минус один?

Когда я впервые в жизни на лекции по статистике столкнулся с этой процедурой, у меня как и у многих студентов возник законный вопрос: а почему мы вычитаем единицу? Почему мы не вычитаем двойку, например? И почему мы вообще должны что-то вычитать из числа наблюдений в нашей выборке?

В учебнике я прочитал следующее объяснение, которое еще не раз в дальнейшем встречал в качестве ответа на данный вопрос:

“Допустим мы знаем, чему равняется выборочное среднее, тогда нам необходимо знать только n-1 элементов выборки, чтобы безошибочно определить чему равняется оставшейся n элемент”. Звучит разумно, однако такое объяснение скорее описывает некоторый математический прием, чем объясняет зачем нам понадобилось его применять при расчете t-критерия. Следующее распространенное объяснение звучит следующим образом: число степеней свободы — это разность числа наблюдений и числа оцененных параметров. При использовании одновыборочного t-критерия мы оценили один параметр — среднее значение в генеральной совокупности, используя n элементов выборки, значит df = n-1.

Однако ни первое, ни второе объяснение так и не помогает понять, зачем же именно нам потребовалось вычитать число оцененных параметров из числа наблюдений?

Причем тут распределение Хи-квадрат Пирсона?

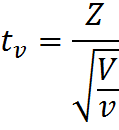

Давайте двинемся чуть дальше в поисках ответа. Сначала обратимся к определению t-распределения, очевидно, что все ответы скрыты именно в нем. Итак случайная величина:

имеет t-распределение с df = ν, при условии, что Z – случайная величина со стандартным нормальным распределением N(0; 1), V – случайная величина с распределением Хи-квадрат, с ν числом степеней свобод, случайные величины Z и V независимы. Это уже серьезный шаг вперед, оказывается, за число степеней свободы ответственна случайная величина с распределением Хи-квадрат в знаменателе нашей формулы.

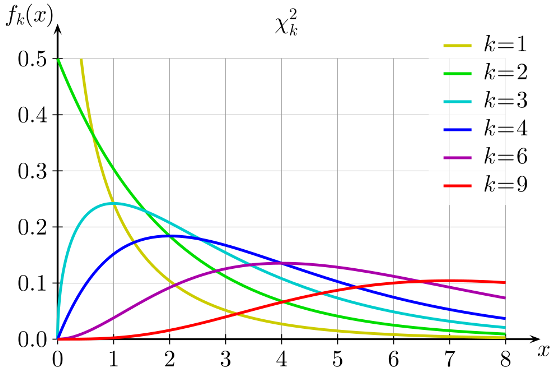

Давайте тогда изучим определение распределения Хи-квадрат. Распределение Хи-квадрат с k степенями свободы — это распределение суммы квадратов k независимых стандартных нормальных случайных величин.

Кажется, мы уже совсем у цели, по крайней мере, теперь мы точно знаем, что такое число степеней свободы у распределения Хи-квадрат — это просто число независимых случайных величин с нормальным стандартным распределением, которые мы суммируем. Но все еще остается неясным, на каком этапе и зачем нам потребовалось вычитать единицу из этого значения?

Давайте рассмотрим небольшой пример, который наглядно иллюстрирует данную необходимость. Допустим, мы очень любим принимать важные жизненные решения, основываясь на результате подбрасывания монетки. Однако, последнее время, мы заподозрили нашу монетку в том, что у нее слишком часто выпадает орел. Чтобы попытаться отклонить гипотезу о том, что наша монетка на самом деле является честной, мы зафиксировали результаты 100 бросков и получили следующий результат: 60 раз выпал орел и только 40 раз выпала решка. Достаточно ли у нас оснований отклонить гипотезу о том, что монетка честная? В этом нам и поможет распределение Хи-квадрат Пирсона. Ведь если бы монетка была по настоящему честной, то ожидаемые, теоретические частоты выпадания орла и решки были бы одинаковыми, то есть 50 и 50. Легко рассчитать насколько сильно наблюдаемые частоты отклоняются от ожидаемых. Для этого рассчитаем расстояние Хи-квадрат Пирсона по, я думаю, знакомой большинству читателей формуле:

Где O — наблюдаемые, E — ожидаемые частоты.

Дело в том, что если верна нулевая гипотеза, то при многократном повторении нашего эксперимента распределение разности наблюдаемых и ожидаемых частот, деленная на корень из наблюдаемой частоты, может быть описано при помощи нормального стандартного распределения, а сумма квадратов k таких случайных нормальных величин это и будет по определению случайная величина, имеющая распределение Хи-квадрат.

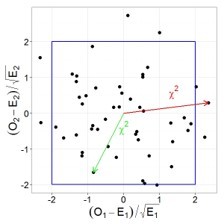

Давайте проиллюстрируем этот тезис графически, допустим у нас есть две случайные, независимые величины, имеющих стандартное нормальное распределение. Тогда их совместное распределение будет выглядеть следующим образом:

При этом квадрат расстояния от нуля до каждой точки это и будет случайная величина, имеющая распределение Хи-квадрат с двумя степенями свободы. Вспомнив теорему Пифагора, легко убедиться, что данное расстояние и есть сумма квадратов значений обеих величин.

Пришло время вычесть единичку!

Ну а теперь кульминация нашего повествования. Возвращаемся к нашей формуле расчета расстояния Хи-квадрат для проверки честности монетки, подставим имеющиеся данные в формулу и получим, что расстояние Хи-квадрат Пирсона равняется 4. Однако для определения p-value нам необходимо знать число степеней свободы, ведь форма распределения Хи-квадрат зависит от этого параметра, соответственно и критическое значение также будет различаться в зависимости от этого параметра.

Теперь самое интересное. Предположим, что мы решили многократно повторять 100 бросков, и каждый раз мы записывали наблюдаемые частоты орлов и решек, рассчитывали требуемые показатели (разность наблюдаемых и ожидаемых частот, деленная на корень из ожидаемой частоты) и как и в предыдущем примере наносили их на график.

Легко заметить, что теперь все точки выстраиваются в одну линию. Все дело в том, что в случае с монеткой наши слагаемые не являются независимыми, зная общее число бросков и число решек, мы всегда можем точно определить выпавшее число орлов и наоборот, поэтому мы не можем сказать, что два наших слагаемых — это две независимые случайные величины. Также вы можете убедиться, что все точки действительно всегда будут лежать на одной прямой: если у нас выпало 30 орлов, значит решек было 70, если орлов 70, то решек 30 и т.д. Таким образом, несмотря на то, что в нашей формуле было два слагаемых, для расчета p-value мы будем использовать распределение Хи-квадрат с одной степенью свободы! Вот мы наконец-то добрались до момента, когда нам потребовалось вычесть единицу. Если бы мы проверяли гипотезу о том, что наша игральная кость с шестью гранями является честной, то мы бы использовали распределение Хи-квадрат с 5 степенями свободы. Ведь зная общее число бросков и наблюдаемые частоты выпадения любых пяти граней, мы всегда можем точно определить, чему равняется число выпадений шестой грани.

Все становится на свои места

Теперь, вооружившись этими знаниями, вернемся к t-тесту:

в знаменателе у нас находится стандартная ошибка, которая представляет собой выборочное стандартное отклонение, делённое на корень из объёма выборки. В расчет стандартного отклонения входит сумма квадратов отклонений наблюдаемых значений от их среднего значения — то есть сумма нескольких случайных положительных величин. А мы уже знаем, что сумма квадратов n случайных величин может быть описана при помощи распределения хи-квадрат. Однако, несмотря на то, что у нас n слагаемых, у данного распределения будет n-1 степень свободы, так как зная выборочное среднее и n-1 элементов выборки, мы всегда можем точно задать последний элемент (отсюда и берется это объяснение про среднее и n-1 элементов необходимых для однозначного определения n элемента)! Получается, в знаменателе t-статистики у нас спрятано распределение хи-квадрат c n-1 степенями свободы, которое используется для описания распределения выборочного стандартного отклонения! Таким образом, степени свободы в t-распределении на самом деле берутся из распределения хи-квадрат, которое спрятано в формуле t-статистики. Кстати, важно отметить, что все приведенные выше рассуждения справедливы, если исследуемый признак имеет нормальное распределение в генеральной совокупности (или размер выборки достаточно велик), и если бы у нас действительно стояла цель проверить гипотезу о среднем значении роста в популяции, возможно, было бы разумнее использовать непараметрический критерий.

Схожая логика расчета числа степеней свободы сохраняется и при работе с другими тестами, например, в регрессионном или дисперсионном анализе, все дело в случайных величинах с распределением Хи-квадрат, которые присутствуют в формулах для расчета соответствующих критериев.

Таким образом, чтобы правильно интерпретировать результаты статистических исследований и разбираться, откуда возникают все показатели, которые мы получаем при использовании даже такого простого критерия как одновыборочный t-тест, любому исследователю необходимо хорошо понимать, какие математические идеи лежат в основании статистических методов.

Онлайн курсы по статистике: объясняем сложные темы простым языком

Основываясь на опыте преподавания статистики в Институте биоинформатики , у нас возникла идея создать серию онлайн курсов, посвященных анализу данных, в которых в доступной для каждого форме будут объясняться наиболее важные темы, понимание которых необходимо для уверенного использования методов статистики при решении различного рода задача. В 2015 году мы запустили курс Основы статистики, на который к сегодняшнему дню записалось около 17 тысяч человек, три тысячи слушателей уже получили сертификат о его успешном завершении, а сам курс был награждён премией EdCrunch Awards и признан лучшим техническим курсом. В этом году на платформе stepik.org стартовало продолжение курса Основы статистики. Часть два, в котором мы продолжаем знакомство с основными методами статистики и разбираем наиболее сложные теоретические вопросы. Кстати, одной из главных тем курса является роль распределения Хи-квадрат Пирсона при проверке статистических гипотез. Так что если у вас все еще остались вопросы о том, зачем мы вычитаем единицу из общего числа наблюдений, ждем вас на курсе!

Стоит также отметить, что теоретические знания в области статистики будут определенно полезны не только тем, кто применяет статистику в академических целях, но и для тех, кто использует анализ данных в прикладных областях. Базовые знания в области статистики просто необходимы для освоения более сложных методов и подходов, которые используются в области машинного обучения и Data Mining. Таким образом, успешное прохождение наших курсов по введению в статистику — хороший старт в области анализа данных. Ну а если вы всерьез задумались о приобретении навыков работы с данными, думаем, вас может заинтересовать наша онлайн — программа по анализу данных, о которой мы подробнее писали здесь. Упомянутые курсы по статистике являются частью этой программы и позволят вам плавно погрузиться в мир статистики и машинного обучения. Однако пройти эти курсы без дедлайнов могут все желающие и вне контекста программы по анализу данных.

Степени свободы (Df, C) – это количество параметров (точек контроля) Модели (Model). Они указывают количество независимых значений, которые могут изменяться в ходе анализа без нарушения каких-либо ограничений.

Пример.

- Рассмотрим Выборку (Sample) данных, состоящую для простоты из пяти положительных целых чисел. Значения могут быть любыми числами без известной связи между ними. Эта выборка данных теоретически должна иметь пять степеней свободы.

- Четыре числа в выборке — это {3, 8, 5 и 4}, а среднее значение всей выборки данных равно 6.

- Это должно означать, что пятое число равно 10. Иначе быть не может. У пятого значения нет свободы варьироваться.

- Таким образом, степень свободы для этой выборки данных равна 4.

Формула степени свободы выглядит следующим образом:

$$D_f = N — 1$$

где

D_f – степень свободы

N – количество значений

Математически степени свободы часто представляют, используя греческую букву «ню», которая выглядит так: ν. Вы наверняка встретите и такие сокращения: ‘d.o.f.’, ‘dof’, ‘d.f.’ или просто ‘df’.

Степени свободы в статистике

Степени свободы в статистике – это количество значений, используемых при вычислении переменной.

Степени свободы = Количество независимых значений — Количество статистик

Пример. У нас есть 50 независимых значений, и мы хотим вычислить одну-единственную статистику «среднее». Согласно формуле, степеней свободы будет 50 — 1 = 49.

Степени свободы в Машинном обучении

В прогностическом моделировании, степени свободы часто относятся к количеству параметров, включая данные, используемые при вычислении ошибки модели. Наилучший способ понять это – рассмотреть модель линейной регрессии.

Рассмотрим модель линейной регрессии для Датасета (Dataset) с двумя входными переменными. Нам потребуется один коэффициент в модели для каждой входной переменной, то есть модель будет иметь еще и два параметра.

$$hat{y} = x_1 * β_1 + x_2 * β_2$$

где

y – целевая переменная

x_1, x_2 – входные переменные

β_1, β_2 – параметры модели

Эта модель линейной регрессии имеет две степени свободы, потому что есть два параметра модели, которые должны быть оценены на основе обучающего датасета. Добавление еще одного столбца к данным (еще одной входной переменной) добавит модели еще одну степень свободы. Сложность обучения модели линейной регрессии описывается степенью свободы, например, «модель четвертой степени сложности» означает наличие четырех входных переменных, а также степень свободы, равную четырем.

Степени свободы для ошибки линейной регрессии

Количество обучающих примеров имеет значение и влияет на количество степеней свободы регрессионной модели. Представьте, что мы создаем модель линейной регрессии на базе датасета, состоящего из ста строк.

Сравнивая предсказания модели с реальными выходными значениями, мы минимизируем ошибку. Итоговая ошибка модели имеет одну степень свободы для каждого ряда за вычетом количества параметров. В нашем случае ошибка модели 98 степеней свободы (100 рядов — 2 параметра).

Итоговые степени свободы для линейной регрессии

Конечные степени свободы для модели линейной регрессии рассчитываются как сумма степеней свободы модели плюс степени свободы ошибки модели. В нашем примере это 100 (2 степени свободы модели + 98 степеней свободы ошибки). Как вы уже заметили, степеней свободы столько, сколько рядов в датасете.

Теперь рассмотрим набор данных из 100 строк, но теперь у нас есть 70 входных переменных. Это означает, что модель имеет еще и 70 коэффициентов, что дает нам d.o.f. ошибки, равной 30 (100 строк — 70 коэффициентов). d.o.f. самой модели по-прежнему равен ста.

Отрицательные степени свободы

Что происходит, когда у нас больше столбцов, чем строк данных? Отрицательные значения вполне допустимы здесь. Например, у нас может быть 100 строк данных и 10 000 переменных, к примеру, маркеры генов для 100 пациентов. Следовательно, модель линейной регрессии будет иметь 10 000 параметров, то есть модель будет иметь 10 000 степеней свободы.

Тогда степени свободы рассчитываются следующим образом:

Степень свободы модели = Количество независимых значение — Количество параметров = 100 — 10 000 = -9 900

В свою очередь, степени свободы модели линейной регрессии будут следующими:

Степени свободы модели линейной регрессии = Степени свободы модели — Степени свободы ошибки модели = 10 000 — 9 900 = 100

Фото: @mickeyoneil

Число степеней свободы

Прежде чем обратиться

к таблице, необходимо определить число

степенейсвободы(f).

Этим термином обозначается число

независимых величин, участвующих в

образовании того или иного параметра:

при вычислении

средней арифметической число степеней

свободы равно общему числу вариант (N)и поэтомуf=N.

при вычислении

дисперсии должно выполняться условие

о том, чтобы сумма всех вариант отклонений

от средней арифметической должна быть

равна нулю

(8)

Поэтому число

степеней свободы в этом случае будет

равно общему числу величин, по которым

вычисляется параметр, минус число

условий, связывающих эти величины, то

есть f=N-1. Именно поэтому, при вычислении

среднего квадратического отклонения,

сумму квадратов отклонений от средней

арифметической делят на N-1.

в формулу для

вычисления критерия tвходят квадраты ошибок средней

арифметической (m12,

m22),

при вычислении которых число степеней

свободы определяется как N-1 для каждого

параметра. Отсюда общее число степеней

свободы будет равноN1+N2-2.

Возвратимся к

рассматриваемому примеру. После

определения числа степеней свободы

(f=10+10-2=18) по таблице 1

Приложений находим, что критическое

значениеtпри

5-процентном уровне значимости (р=0,05)

дляf=18 составляет 2,10. Так

как полученноеt=2,28

и оно больше критического значенияt-критерия

Стьюдента (t=2,10)

для f=18, то можно

утверждать, что различия между средними

результатами изучаемых групп неслучайны.

Такое заключение, в свою очередь, даёт

основание сделать вывод о более

совершенной методике построения

тренировочных занятий в первой группе.

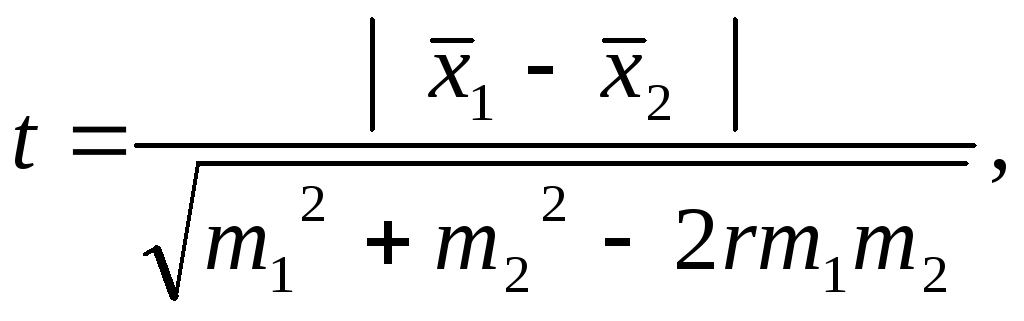

Коррелированные выборки

В педагогических

исследованиях, довольно часто, необходимо

определить достоверность различий

между средними показателями одной и

той же группы испытуемых, полученных в

различное время (например, до и после

педагогического эксперимента). Применять

критерий Стьюдента, использовав его

формульное выражение (7) для случая

независимых выборок, нельзя, так как в

обеих выборках участвуют одни и те же

испытуемые и результаты исследований

по окончании эксперимента сильно зависят

от результатов исходных данных

исследований. Такие выборки называют

коррелированными. Критерий Стьюдента

в случае коррелированных выборок

вычисляется по формуле

где r– коэффициент корреляции между

сравниваемыми группами по изучаемому

признаку.

Для того чтобы не

вычислять коэффициента корреляции и

упростить вычисления можно использовать

методику вычислений, предложенную в

работе [1], основанную на

определении разности между значениями

признаков для каждой пары. По существу

речь идет об определении статистически

значимой достоверности в приросте

результатов, определяемых как разность

значений признака для каждой варианты

(и в целом для всей выборки испытуемых)

до и после педагогического эксперимента.

Рассмотрим

последовательность выполнения необходимых

операций на следующем примере.

Предварительно введем обозначения для

статистических параметров распределения:

—

результат i-го

испытуемого до начала эксперимента;

—

результат i-го

испытуемого после эксперимента;

—

разность результатов у i-го

испытуемого, определяемая по значениям,

показанным после и до проведения

эксперимента;

—

средняя арифметическая разности

(прироста) результатов педагогического

эксперимента.

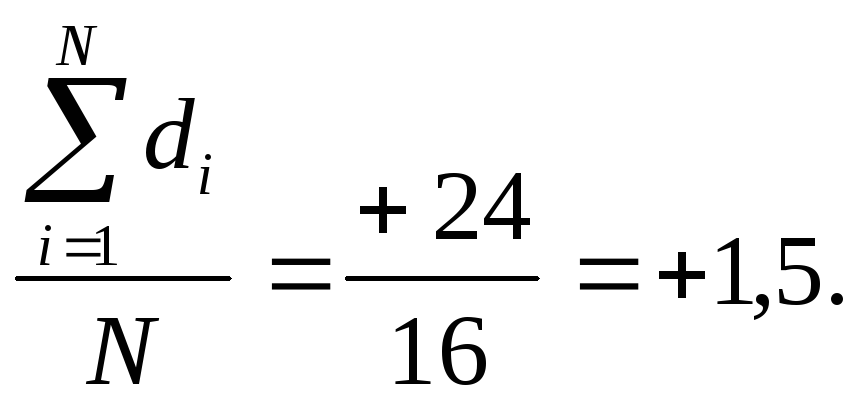

На группе из 16

студентов (N=16)

была проверена эффективность новой

методики развития силы и силовой

выносливости с применением специальной

аппаратуры (вибротренажёр). О результатах

эксперимента судили по числу подтягиваний

в висе на перекладине до начала и после

окончания тренировочного периода (табл.

13).

Средняя разность

()

в нашем примере вычисляется следующим

образом:

=

Таблица 13.

|

Испытуе- |

И |

т |

Р |

з |

ь |

|

мые |

|

|

|

|

|

|

1 |

10 |

12 |

+2 |

+0,5 |

0,25 |

|

2 |

6 |

10 |

+4 |

+2,5 |

6,25 |

|

3 |

12 |

16 |

+4 |

+2,5 |

6,25 |

|

4 |

15 |

16 |

+1 |

-0,5 |

0,25 |

|

5 |

7 |

10 |

+3 |

+1,5 |

2,25 |

|

6 |

14 |

16 |

+2 |

+0,5 |

0,25 |

|

7 |

12 |

15 |

+3 |

+1,5 |

2,25 |

|

8 |

16 |

15 |

-1 |

-2,5 |

6,25 |

|

9 |

14 |

13 |

-1 |

-2,5 |

6,25 |

|

10 |

8 |

10 |

+2 |

+0,5 |

0,25 |

|

11 |

10 |

9 |

-1 |

-2,5 |

6,25 |

|

12 |

4 |

7 |

+3 |

+1,5 |

2,25 |

|

13 |

12 |

12 |

0 |

-1,5 |

2,25 |

|

14 |

10 |

13 |

+3 |

+1,5 |

2,25 |

|

15 |

5 |

8 |

+3 |

+1,5 |

2,25 |

|

16 |

17 |

14 |

-3 |

-4,5 |

20,25 |

|

N=16 |

= |

= |

= |

= |

= |

|

1 |

2 |

3 |

4 |

5 |

6 |

В первой колонке

таблицы 13 приведены порядковые номера

испытуемых и их общее число (N=16).

Во второй и третьей

колонках приведены результаты в

подтягивании у испытуемых до эксперимента

(колонка 2) и после эксперимента (колонка

3).

Результаты

вычислений разности по каждой варианте

до и после эксперимента, их суммы и

средней арифметической разности

(прироста) приведены в колонке 4.

В колонке 5 приведены

отклонения каждой варианты (di)

от средней разностью ().

И в колонке 6 дана

сумма квадратов отклонений от средней

разности.

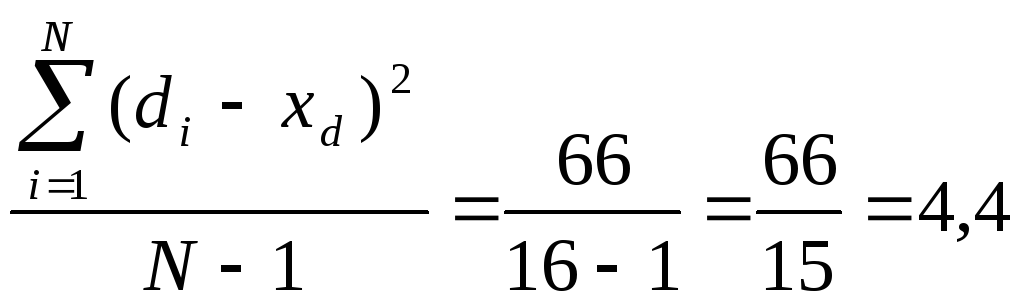

Средний квадрат

отклонений будет равен

Среднее квадратическое

отклонение соответственно равно

(12)

Определяем среднюю

ошибку разности

(13)

Отсюда следует,

что

(14)

По таблице 1

Приложений критическое значение tдля уровня значимости 0,05 при f=N-1=15, будет

равняться 2,13, аt01=2,95. Поэтому

с вероятностью более чем в 95% можно

утверждать, что изменения в количестве

подтягиваний на перекладине являются

неслучайными.

Соседние файлы в предмете [НЕСОРТИРОВАННОЕ]

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

Автор статьи: Артем Михайлов

Статистический анализ играет важную роль в научных исследованиях, коммерческих деятельностях и в других областях. Однако, его результаты могут быть неточными, если не учитывать имеющиеся степени свободы. Степени свободы – это концепция, которая широко используется в статистике, и она позволяет более точно определить, насколько можно доверять полученным результатам.

В данной статье мы рассмотрим понятие степеней свободы, их роль в статистических расчетах, а также примеры их использования. Мы узнаем, как степени свободы помогают улучшить точность статистических выводов и в каких случаях их использование особенно важно.

Что такое степень свободы?

Степень свободы (Degree of Freedom, df) в статистике — это количество значений или наблюдений в выборке, которые могут быть изменены независимо друг от друга без изменения ее структуры. Можно сказать, что это количество переменных, которые оставляются свободными для варьирования после того, как структура выборки была определена.

Например, рассмотрим тест Стьюдента (t-Test), который используется для проверки гипотезы о равенстве средних значений двух выборок. В этом тесте степень свободы определяется как сумма степеней свободы двух выборок минус два (df = n1 + n2 — 2), где n1 и n2 — размеры выборок.

Чем больше степень свободы, тем меньше вероятность ложных выводов и тем более точными будут результаты теста. В случае же, если степень свободы будет низкой, то мы можем получить ложные результаты, так как мы не имеем достаточно информации для адекватной оценки статистических характеристик выборки.

Одним из важных факторов, влияющих на степень свободы, является размер выборки. Чем больше выборка, тем больше степень свободы, значит, чем больше выборка, тем менее вероятно получение ошибочных результатов в статистических тестах.

Также степень свободы важна при выборе статистической модели. К примеру, при построении линейной регрессии, степень свободы может использоваться для определения того, сколько переменных необходимо использовать в модели. Выбор модели слишком сложной или, наоборот, слишком простой (т.е. с недостаточной степенью свободы) может привести к неправильным выводам.

Таблица степеней свободы

Таблица степеней свободы – это таблица, которая заполняется в соответствии с типом и количеством переменных, которые используются в анализе статистических данных. Она используется для определения правильной формулы для расчета критических значений при проведении статистических тестов, таких как t-критерий, F-критерий и хи-квадрат тест.

В таблице степеней свободы могут быть два типа переменных: независимые (IV) и зависимые (DV). Количество степеней свободы для каждой переменной определяется путем вычитания единицы от общего количества наблюдений.

Для каждого теста, количество степеней свободы может быть разным в зависимости от характеристик выборки и типа теста. Например:

-

В t-критерии Стьюдента, количество степеней свободы зависит от размера выборки и количества групп, участвующих в сравнении. Если у нас есть две группы, количество степеней свободы будет равно n1+n2-2 (где n1 и n2 – это размер первой и второй групп соответственно).

-

В анализе дисперсии (ANOVA), количество степеней свободы будет зависеть от количества групп и количества элементов в каждой группе. Если есть количество групп (k) и общее количество элементов (N), то количество степеней свободы для межгрупповой дисперсии будет равно k-1, а для остаточной дисперсии будет равно N-k.

-

В хи-квадрат тесте, количество степеней свободы зависит от размера матрицы сопряженности. Если у нас есть матрица 2×2, то количество степеней свободы будет равно 1.

Таблица степеней свободы помогает убедиться, что мы используем правильные статистические формулы для расчетов, что позволяет получать более точные и надежные результаты при анализе статистических данных.

Примеры использования степеней свободы

Рассмотрим несколько практических примеров использования степеней свободы в статистике:

-

t-критерий Стьюдента. Это статистический тест, который используется для проверки значимости различия между средними двух независимых выборок. Для расчета t-критерия Стьюдента используется формула, которая включает в себя показатели меры центральной тенденции (среднее значение) и меры разброса (стандартное отклонение) для каждой выборки, а также степени свободы. В частности, степени свободы в расчете t-критерия Стьюдента определяются как сумма степеней свободы выборок, возведенная в степень двух, деленная на сумму квадратов степеней свободы выборок. Этот тест дает возможность оценить значимость различий между двумя выборками и узнать, велика ли вероятность случайного различия.

Предположим, что вы хотите определить, отличаются ли средние зарплаты мужчин и женщин в вашей компании. Вы можете использовать t-критерий для проверки этой гипотезы. Для этого вам нужно знать выборочные средние и стандартные отклонения для мужчин и женщин, а также общее число человек в каждой группе. После этого можно использовать формулу для расчета t-критерия, учитывая количество степеней свободы (количество людей в каждой группе минус 1).

-

Анализ дисперсии (ANOVA). Это статистический тест, который используется для сравнения средних значений нескольких групп. ANOVA расчитывается разнесением общего отклонения между группами на внутреннюю дисперсию (внутригрупповое отклонение) и межгрупповую дисперсию. Степени свободы в расчете ANOVA определяются как разность между общим числом наблюдений и числом использованных для расчета средних значений степеней свободы (то есть на 1 меньше числа групп). Внутригрупповые и межгрупповые степени свободы могут быть вычислены отдельно.

Предположим, что у вас есть несколько групп людей, проходящих тренировку для улучшения своего здоровья. Вы хотите определить, есть ли значимые различия в потере веса между этими группами. Для решения этого вопроса можно использовать ANOVA, для этого вам нужно знать выборочные средние и стандартные отклонения для каждой группы, а также общее количество участников в каждой группе. Затем используйте формулу для расчета F-критерия, учитывая количество степеней свободы, которое будет различаться в зависимости от количества групп и количества участников в каждой группе.

-

Хи-квадрат тест. Это статистический тест, в котором измеряется отклонение между фактическим и ожидаемым количеством наблюдений в наборе данных. Хи-квадрат тест может использоваться для проверки независимости двух переменных в категориальных данных, таких как таблицы сопряженности. Степени свободы в расчете Хи-квадрат теста определяются как разность между общим количеством наблюдений в таблице и количеством ограничений (то есть размерность таблицы минус 1, по каждому измерению). Если степени свободы достаточно высоки, то можно считать, что тест говорит о статистически значимых различиях между переменными.

Предположим, что у вас есть две переменных — пол (мужчина или женщина) и предпочитаемый вид спорта (баскетбол, футбол, хоккей и т.д.), и вы хотите проверить, есть ли статистически значимая связь между этими переменными. Для этого вы можете использовать хи-квадрат тест, для которого нужно разбить каждую категориальную переменную на несколько групп, затем измерить общее количество наблюдений в каждой ячейке таблицы. После того как вы подсчитаете значения статистики хи-квадрат, вы можете использовать таблицу степеней свободы, чтобы определить, является ли полученный результат значимым для определенного уровня доверия.

-

В корреляционном анализе, степени свободы используются для вычисления коэффициента корреляции между двумя переменными и определения статистической значимости этой связи. Обычно, чем больше степеней свободы, тем точнее оценки корреляции. Количество степеней свободы определяется как общее число наблюдений минус число неизвестных параметров.

Например, если мы исследуем связь между уровнем образования и доходом, то количество степеней свободы будет равно количеству наблюдений минус два, так как два параметра (уровень образования и доход) неизвестны.

Преимущества и недостатки

Преимущества использования степеней свободы в статистике включают следующее:

-

Корректность статистических тестов: использование степеней свободы позволяет правильно оценивать дисперсию и скорректировать стандартные ошибки. Это обеспечивает более точные тесты на статистическую значимость.

-

Увеличение мощности тестов: использование правильных степеней свободы может увеличить мощность статистических тестов. Это позволяет увидеть статистически значимые различия там, где их может не быть при использовании неправильных степеней свободы.

-

Более надежные выводы: правильное использование степеней свободы позволяет избежать ошибок первого и второго рода. Это позволяет давать более точные и надежные научные выводы.

Однако, использование степеней свободы также имеет некоторые ограничения:

-

Количество данных: необходимо иметь достаточно большое количество данных, чтобы определить степени свободы. В противном случае могут возникнуть ошибки в статистических тестах.

-

Некоторые статистические тесты зависят от предположений: некоторые статистические тесты, такие как t-тесты, предполагают нормальность распределения данных. Если данные не соответствуют этим предположениям, использование степеней свободы может привести к ошибкам.

-

Ошибки вязкости: иногда степени свободы могут быть неверными из-за ошибок в вычислениях. Это может привести к неправильным выводам из статистических тестов.

Заключение

Таким образом, степени свободы являются одним из ключевых параметров в статистических расчетах и оказывают большое влияние на результаты анализа данных. При этом, важно понимать, что оптимальное количество степеней свободы зависит от многих факторов, включая размер выборки и число независимых переменных. Поэтому, для правильного выбора количества степеней свободы, необходим обширный опыт в анализе данных и статистике.

Также следует отметить, что степени свободы являются только одним из аспектов статистического анализа, и их применение требует определенных знаний в области статистики.

Полезные рекомендации

Напоследок хочу порекомендовать несколько полезных бесплатных вебинаров от OTUS. Регистрация доступна по ссылкам ниже:

-

Построение архитектуры с иcпользованием облачных сервисов AWS

-

Профессия Системный Аналитик. Путь с нуля до Middle

-

Бережливое управление требованиями

In statistics, the number of degrees of freedom is the number of values in the final calculation of a statistic that are free to vary.[1]

Estimates of statistical parameters can be based upon different amounts of information or data. The number of independent pieces of information that go into the estimate of a parameter is called the degrees of freedom. In general, the degrees of freedom of an estimate of a parameter are equal to the number of independent scores that go into the estimate minus the number of parameters used as intermediate steps in the estimation of the parameter itself. For example, if the variance is to be estimated from a random sample of N independent scores, then the degrees of freedom is equal to the number of independent scores (N) minus the number of parameters estimated as intermediate steps (one, namely, the sample mean) and is therefore equal to N − 1.[2]

Mathematically, degrees of freedom is the number of dimensions of the domain of a random vector, or essentially the number of «free» components (how many components need to be known before the vector is fully determined).

The term is most often used in the context of linear models (linear regression, analysis of variance), where certain random vectors are constrained to lie in linear subspaces, and the number of degrees of freedom is the dimension of the subspace. The degrees of freedom are also commonly associated with the squared lengths (or «sum of squares» of the coordinates) of such vectors, and the parameters of chi-squared and other distributions that arise in associated statistical testing problems.

While introductory textbooks may introduce degrees of freedom as distribution parameters or through hypothesis testing, it is the underlying geometry that defines degrees of freedom, and is critical to a proper understanding of the concept.

History[edit]

Although the basic concept of degrees of freedom was recognized as early as 1821 in the work of German astronomer and mathematician Carl Friedrich Gauss,[3] its modern definition and usage was first elaborated by English statistician William Sealy Gosset in his 1908 Biometrika article «The Probable Error of a Mean», published under the pen name «Student».[4] While Gosset did not actually use the term ‘degrees of freedom’, he explained the concept in the course of developing what became known as Student’s t-distribution. The term itself was popularized by English statistician and biologist Ronald Fisher, beginning with his 1922 work on chi squares.[5]

Notation[edit]

In equations, the typical symbol for degrees of freedom is ν (lowercase Greek letter nu). In text and tables, the abbreviation «d.f.» is commonly used. R. A. Fisher used n to symbolize degrees of freedom but modern usage typically reserves n for sample size.

Of random vectors[edit]

Geometrically, the degrees of freedom can be interpreted as the dimension of certain vector subspaces. As a starting point, suppose that we have a sample of independent normally distributed observations,

This can be represented as an n-dimensional random vector:

Since this random vector can lie anywhere in n-dimensional space, it has n degrees of freedom.

Now, let

The first vector on the right-hand side is constrained to be a multiple of the vector of 1’s, and the only free quantity is

The second vector is constrained by the relation

Mathematically, the first vector is the Oblique projection of the data vector onto the subspace spanned by the vector of 1’s. The 1 degree of freedom is the dimension of this subspace. The second residual vector is the least-squares projection onto the (n − 1)-dimensional orthogonal complement of this subspace, and has n − 1 degrees of freedom.

In statistical testing applications, often one is not directly interested in the component vectors, but rather in their squared lengths. In the example above, the residual sum-of-squares is

If the data points

Likewise, the one-sample t-test statistic,

follows a Student’s t distribution with n − 1 degrees of freedom when the hypothesized mean

In structural equation models[edit]

When the results of structural equation models (SEM) are presented, they generally include one or more indices of overall model fit, the most common of which is a χ2 statistic. This forms the basis for other indices that are commonly reported. Although it is these other statistics that are most commonly interpreted, the degrees of freedom of the χ2 are essential to understanding model fit as well as the nature of the model itself.

Degrees of freedom in SEM are computed as a difference between the number of unique pieces of information that are used as input into the analysis, sometimes called knowns, and the number of parameters that are uniquely estimated, sometimes called unknowns. For example, in a one-factor confirmatory factor analysis with 4 items, there are 10 knowns (the six unique covariances among the four items and the four item variances) and 8 unknowns (4 factor loadings and 4 error variances) for 2 degrees of freedom. Degrees of freedom are important to the understanding of model fit if for no other reason than that, all else being equal, the fewer degrees of freedom, the better indices such as χ2 will be.

It has been shown that degrees of freedom can be used by readers of papers that contain SEMs to determine if the authors of those papers are in fact reporting the correct model fit statistics. In the organizational sciences, for example, nearly half of papers published in top journals report degrees of freedom that are inconsistent with the models described in those papers, leaving the reader to wonder which models were actually tested.[6]

Of residuals[edit]

A common way to think of degrees of freedom is as the number of independent pieces of information available to estimate another piece of information. More concretely, the number of degrees of freedom is the number of independent observations in a sample of data that are available to estimate a parameter of the population from which that sample is drawn. For example, if we have two observations, when calculating the mean we have two independent observations; however, when calculating the variance, we have only one independent observation, since the two observations are equally distant from the sample mean.

In fitting statistical models to data, the vectors of residuals are constrained to lie in a space of smaller dimension than the number of components in the vector. That smaller dimension is the number of degrees of freedom for error, also called residual degrees of freedom.

Example[edit]

Perhaps the simplest example is this. Suppose

are random variables each with expected value μ, and let

be the «sample mean.» Then the quantities

are residuals that may be considered estimates of the errors Xi − μ. The sum of the residuals (unlike the sum of the errors) is necessarily 0. If one knows the values of any n − 1 of the residuals, one can thus find the last one. That means they are constrained to lie in a space of dimension n − 1. One says that there are n − 1 degrees of freedom for errors.

An example which is only slightly less simple is that of least squares estimation of a and b in the model

where xi is given, but ei and hence Yi are random. Let

are constrained to lie within the space defined by the two equations

One says that there are n − 2 degrees of freedom for error.

Notationally, the capital letter Y is used in specifying the model, while lower-case y in the definition of the residuals; that is because the former are hypothesized random variables and the latter are actual data.

We can generalise this to multiple regression involving p parameters and covariates (e.g. p − 1 predictors and one mean (=intercept in the regression)), in which case the cost in degrees of freedom of the fit is p, leaving n — p degrees of freedom for errors

In linear models[edit]

The demonstration of the t and chi-squared distributions for one-sample problems above is the simplest example where degrees-of-freedom arise. However, similar geometry and vector decompositions underlie much of the theory of linear models, including linear regression and analysis of variance. An explicit example based on comparison of three means is presented here; the geometry of linear models is discussed in more complete detail by Christensen (2002).[7]

Suppose independent observations are made for three populations,

The observations can be decomposed as

where

The observation vector, on the left-hand side, has 3n degrees of freedom. On the right-hand side, the first vector has one degree of freedom (or dimension) for the overall mean. The second vector depends on three random variables,

In analysis of variance (ANOVA)[edit]

In statistical testing problems, one usually is not interested in the component vectors themselves, but rather in their squared lengths, or Sum of Squares. The degrees of freedom associated with a sum-of-squares is the degrees-of-freedom of the corresponding component vectors.

The three-population example above is an example of one-way Analysis of Variance. The model, or treatment, sum-of-squares is the squared length of the second vector,

with 2 degrees of freedom. The residual, or error, sum-of-squares is

with 3(n−1) degrees of freedom. Of course, introductory books on ANOVA usually state formulae without showing the vectors, but it is this underlying geometry that gives rise to SS formulae, and shows how to unambiguously determine the degrees of freedom in any given situation.

Under the null hypothesis of no difference between population means (and assuming that standard ANOVA regularity assumptions are satisfied) the sums of squares have scaled chi-squared distributions, with the corresponding degrees of freedom. The F-test statistic is the ratio, after scaling by the degrees of freedom. If there is no difference between population means this ratio follows an F-distribution with 2 and 3n − 3 degrees of freedom.

In some complicated settings, such as unbalanced split-plot designs, the sums-of-squares no longer have scaled chi-squared distributions. Comparison of sum-of-squares with degrees-of-freedom is no longer meaningful, and software may report certain fractional ‘degrees of freedom’ in these cases. Such numbers have no genuine degrees-of-freedom interpretation, but are simply providing an approximate chi-squared distribution for the corresponding sum-of-squares. The details of such approximations are beyond the scope of this page.

In probability distributions[edit]

Several commonly encountered statistical distributions (Student’s t, chi-squared, F) have parameters that are commonly referred to as degrees of freedom. This terminology simply reflects that in many applications where these distributions occur, the parameter corresponds to the degrees of freedom of an underlying random vector, as in the preceding ANOVA example. Another simple example is: if

follows a chi-squared distribution with n − 1 degrees of freedom. Here, the degrees of freedom arises from the residual sum-of-squares in the numerator, and in turn the n − 1 degrees of freedom of the underlying residual vector

In the application of these distributions to linear models, the degrees of freedom parameters can take only integer values. The underlying families of distributions allow fractional values for the degrees-of-freedom parameters, which can arise in more sophisticated uses. One set of examples is problems where chi-squared approximations based on effective degrees of freedom are used. In other applications, such as modelling heavy-tailed data, a t or F-distribution may be used as an empirical model. In these cases, there is no particular degrees of freedom interpretation to the distribution parameters, even though the terminology may continue to be used.

In non-standard regression[edit]

Many non-standard regression methods, including regularized least squares (e.g., ridge regression), linear smoothers, smoothing splines, and semiparametric regression are not based on ordinary least squares projections, but rather on regularized (generalized and/or penalized) least-squares, and so degrees of freedom defined in terms of dimensionality is generally not useful for these procedures. However, these procedures are still linear in the observations, and the fitted values of the regression can be expressed in the form

where

For statistical inference, sums-of-squares can still be formed: the model sum-of-squares is

The effective degrees of freedom of the fit can be defined in various ways to implement goodness-of-fit tests, cross-validation, and other statistical inference procedures. Here one can distinguish between regression effective degrees of freedom and residual effective degrees of freedom.

Regression effective degrees of freedom[edit]

For the regression effective degrees of freedom, appropriate definitions can include the trace of the hat matrix,[8] tr(H), the trace of the quadratic form of the hat matrix, tr(H’H), the form tr(2H – H H’), or the Satterthwaite approximation, tr(H’H)2/tr(H’HH’H).[9]

In the case of linear regression, the hat matrix H is X(X ‘X)−1X ‘, and all these definitions reduce to the usual degrees of freedom. Notice that

the regression (not residual) degrees of freedom in linear models are «the sum of the sensitivities of the fitted values with respect to the observed response values»,[10] i.e. the sum of leverage scores.

One way to help to conceptualize this is to consider a simple smoothing matrix like a Gaussian blur, used to mitigate data noise. In contrast to a simple linear or polynomial fit, computing the effective degrees of freedom of the smoothing function is not straight-forward. In these cases, it is important to estimate the Degrees of Freedom permitted by the

Residual effective degrees of freedom[edit]

There are corresponding definitions of residual effective degrees-of-freedom (redf), with H replaced by I − H. For example, if the goal is to estimate error variance, the redf would be defined as tr((I − H)'(I − H)), and the unbiased estimate is (with

or:[11][12][13][14]

The last approximation above[12] reduces the computational cost from O(n2) to only O(n). In general the numerator would be the objective function being minimized; e.g., if the hat matrix includes an observation covariance matrix, Σ, then

General[edit]

Note that unlike in the original case, non-integer degrees of freedom are allowed, though the value must usually still be constrained between 0 and n.[15]

Consider, as an example, the k-nearest neighbour smoother, which is the average of the k nearest measured values to the given point. Then, at each of the n measured points, the weight of the original value on the linear combination that makes up the predicted value is just 1/k. Thus, the trace of the hat matrix is n/k. Thus the smooth costs n/k effective degrees of freedom.

As another example, consider the existence of nearly duplicated observations. Naive application of classical formula, n − p, would lead to over-estimation of the residuals degree of freedom, as if each observation were independent. More realistically, though, the hat matrix H = X(X ‘ Σ−1 X)−1X ‘ Σ−1 would involve an observation covariance matrix Σ indicating the non-zero correlation among observations.

The more general formulation of effective degree of freedom would result in a more realistic estimate for, e.g., the error variance σ2, which in its turn scales the unknown parameters’ a posteriori standard deviation; the degree of freedom will also affect the expansion factor necessary to produce an error ellipse for a given confidence level.

Other formulations[edit]

Similar concepts are the equivalent degrees of freedom in non-parametric regression,[16] the degree of freedom of signal in atmospheric studies,[17][18] and the non-integer degree of freedom in geodesy.[19][20]

The residual sum-of-squares

See also[edit]

- Bessel’s correction

- Chi-squared per degree of freedom

- Pooled degrees of freedom

- Replication (statistics)

- Sample size

- Statistical model

- Variance

References[edit]

- ^ «Degrees of Freedom». Glossary of Statistical Terms. Animated Software. Retrieved 2008-08-21.

- ^ Lane, David M. «Degrees of Freedom». HyperStat Online. Statistics Solutions. Retrieved 2008-08-21.

- ^ Walker, H. M. (April 1940). «Degrees of Freedom» (PDF). Journal of Educational Psychology. 31 (4): 253–269. doi:10.1037/h0054588.

- ^ Student (March 1908). «The Probable Error of a Mean». Biometrika. 6 (1): 1–25. doi:10.2307/2331554. JSTOR 2331554.

- ^ Fisher, R. A. (January 1922). «On the Interpretation of χ2 from Contingency Tables, and the Calculation of P». Journal of the Royal Statistical Society. 85 (1): 87–94. doi:10.2307/2340521. JSTOR 2340521.

- ^ Cortina, J. M., Green, J. P., Keeler, K. R., & Vandenberg, R. J. (2017). Degrees of freedom in SEM: Are we testing the models that we claim to test?. Organizational Research Methods, 20(3), 350-378.

- ^ Christensen, Ronald (2002). Plane Answers to Complex Questions: The Theory of Linear Models (Third ed.). New York: Springer. ISBN 0-387-95361-2.

- ^ Trevor Hastie, Robert Tibshirani, Jerome H. Friedman (2009), The elements of statistical learning: data mining, inference, and prediction, 2nd ed., 746 p. ISBN 978-0-387-84857-0, doi:10.1007/978-0-387-84858-7, [1] (eq.(5.16))

- ^ Fox, J.; Sage Publications, inc; SAGE. (2000). Nonparametric Simple Regression: Smoothing Scatterplots. Nonparametric Simple Regression: Smoothing Scatterplots. SAGE Publications. p. 58. ISBN 978-0-7619-1585-0. Retrieved 2020-08-28.

- ^ Ye, J. (1998), «On Measuring and Correcting the Effects of Data Mining and Model Selection», Journal of the American Statistical Association, 93 (441), 120–131. JSTOR 2669609 (eq.(7))

- ^ Clive Loader (1999), Local regression and likelihood, ISBN 978-0-387-98775-0, doi:10.1007/b98858, (eq.(2.18), p. 30)

- ^ a b Trevor Hastie, Robert Tibshirani (1990), Generalized additive models, CRC Press, (p. 54) and (eq.(B.1), p. 305))

- ^ Simon N. Wood (2006), Generalized additive models: an introduction with R, CRC Press, (eq.(4,14), p. 172)

- ^ David Ruppert, M. P. Wand, R. J. Carroll (2003), Semiparametric Regression, Cambridge University Press (eq.(3.28), p. 82)

- ^ James S. Hodges (2014) Richly Parameterized Linear Models, CRC Press. [2]

- ^ Peter J. Green, B. W. Silverman (1994), Nonparametric regression and generalized linear models: a roughness penalty approach, CRC Press (eq.(3.15), p. 37)

- ^ Clive D. Rodgers (2000), Inverse methods for atmospheric sounding: theory and practice, World Scientific (eq.(2.56), p. 31)

- ^ Adrian Doicu, Thomas Trautmann, Franz Schreier (2010), Numerical Regularization for Atmospheric Inverse Problems, Springer (eq.(4.26), p. 114)

- ^ D. Dong, T. A. Herring and R. W. King (1997), Estimating regional deformation from a combination of space and terrestrial geodetic data, J. Geodesy, 72 (4), 200–214, doi:10.1007/s001900050161 (eq.(27), p. 205)

- ^ H. Theil (1963), «On the Use of Incomplete Prior Information in Regression Analysis», Journal of the American Statistical Association, 58 (302), 401–414 JSTOR 2283275 (eq.(5.19)–(5.20))

- ^ Jones, D.A. (1983) «Statistical analysis of empirical models fitted by optimisation», Biometrika, 70 (1), 67–88

Further reading[edit]

- Bowers, David (1982). Statistics for Economists. London: Macmillan. pp. 175–178. ISBN 0-333-30110-2.

- Eisenhauer, J. G. (2008). «Degrees of Freedom». Teaching Statistics. 30 (3): 75–78. doi:10.1111/j.1467-9639.2008.00324.x. S2CID 121982952.

- Good, I. J. (1973). «What Are Degrees of Freedom?». The American Statistician. 27 (5): 227–228. doi:10.1080/00031305.1973.10479042. JSTOR 3087407.

- Walker, H. W. (1940). «Degrees of Freedom». Journal of Educational Psychology. 31 (4): 253–269. doi:10.1037/h0054588. Transcription by C Olsen with errata

External links[edit]

- Yu, Chong-ho (1997) Illustrating degrees of freedom in terms of sample size and dimensionality

- Dallal, GE. (2003) Degrees of Freedom